本文主要是介绍P21 类神经网络训练不起来怎么办- 自动调整学习率 Adapative learning rate,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

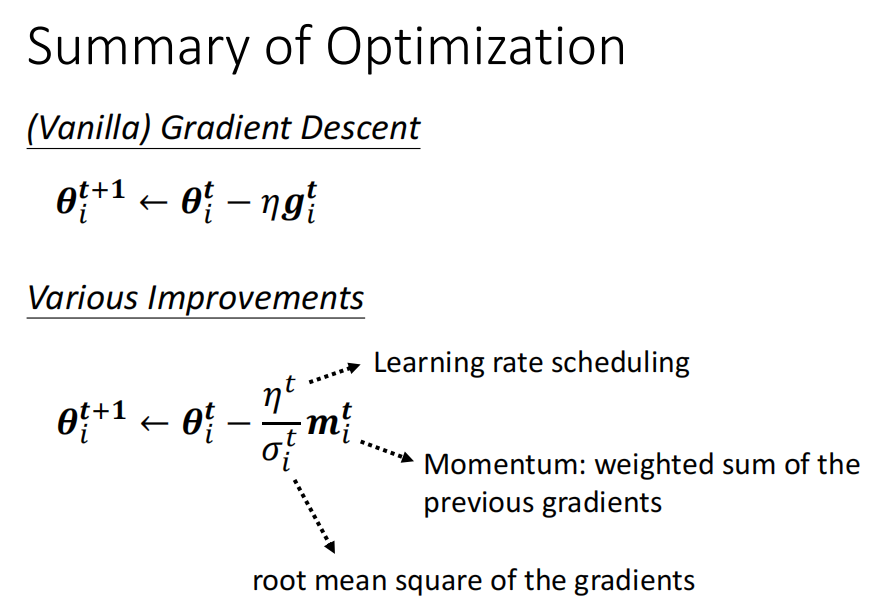

- 梯度大,学习率减小

- 梯度小,学习率变大

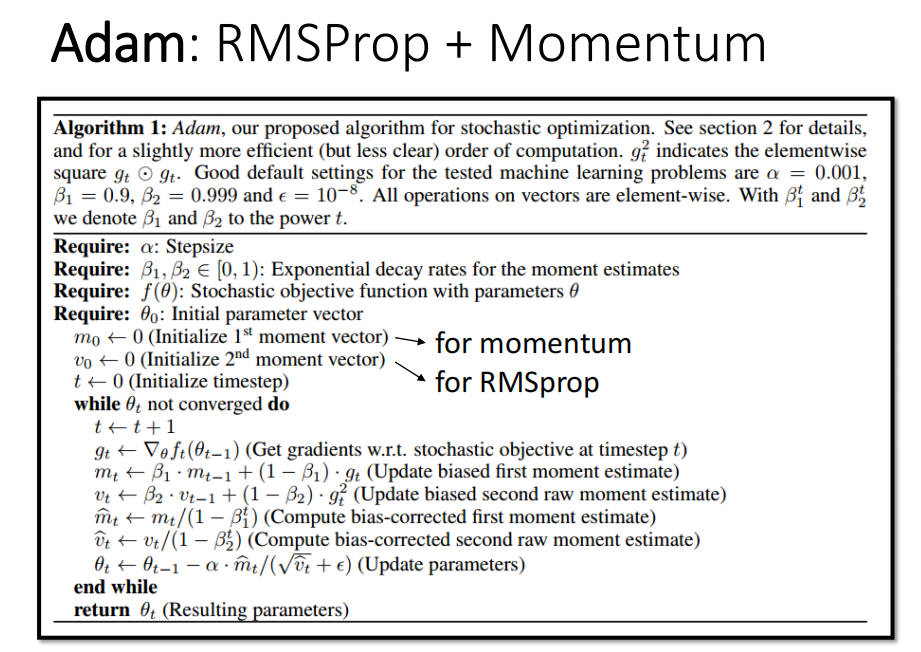

- adam

- 随时间变化 , decay / warm up

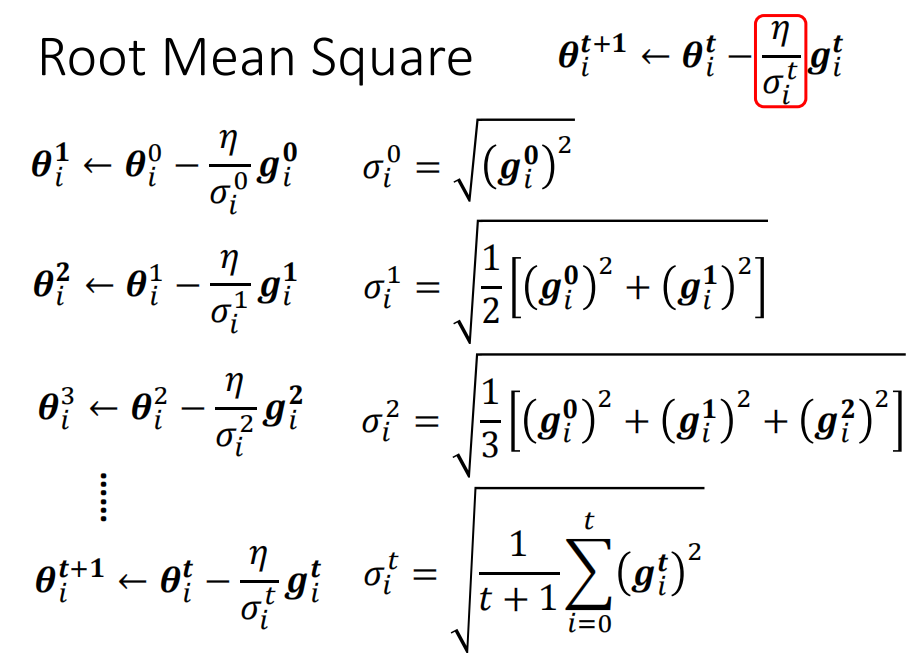

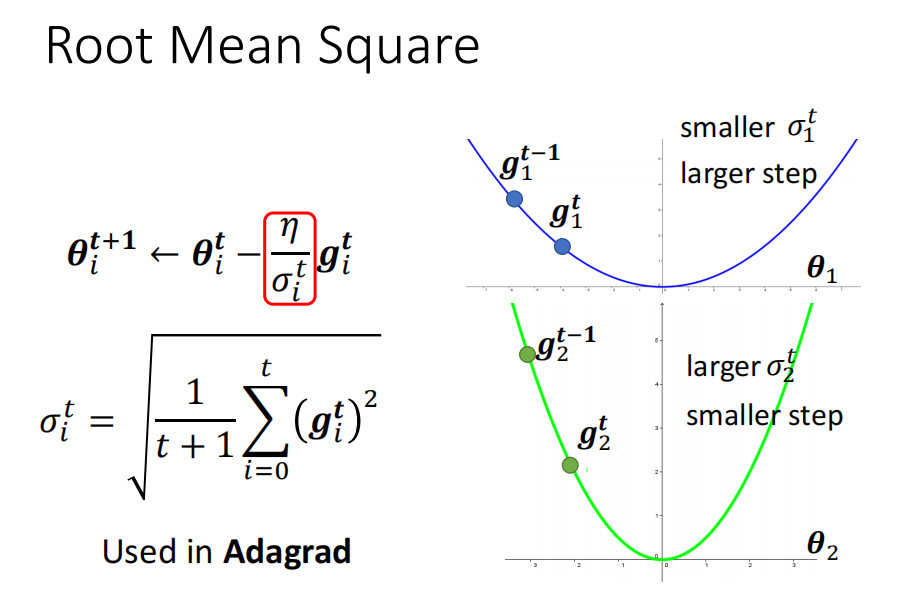

调整学习率方法一 adagrad

学习率除以 梯度的方差

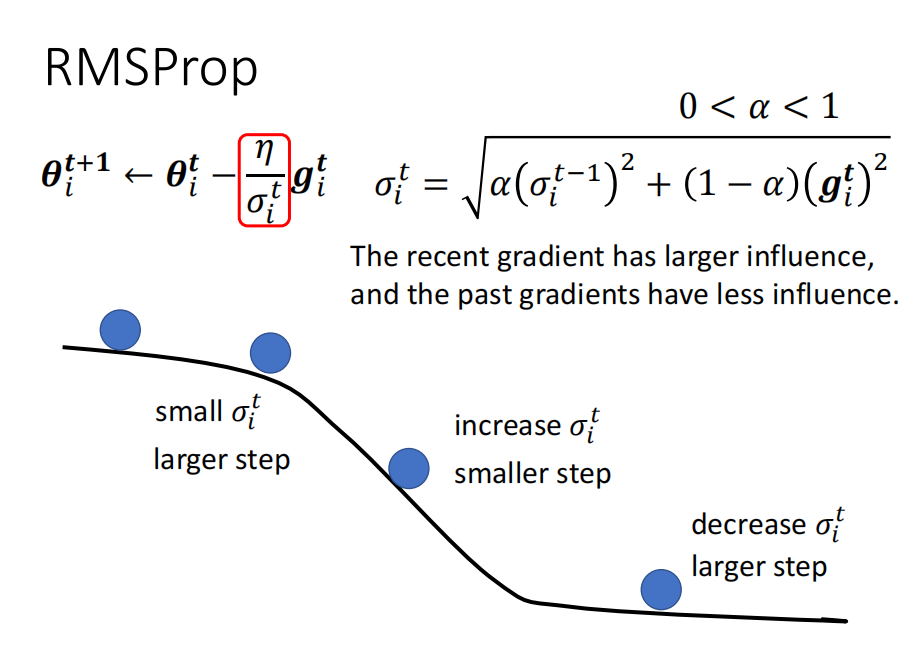

方法二 RMSProp

目前最常用的: Adam: RMSProp + Moment

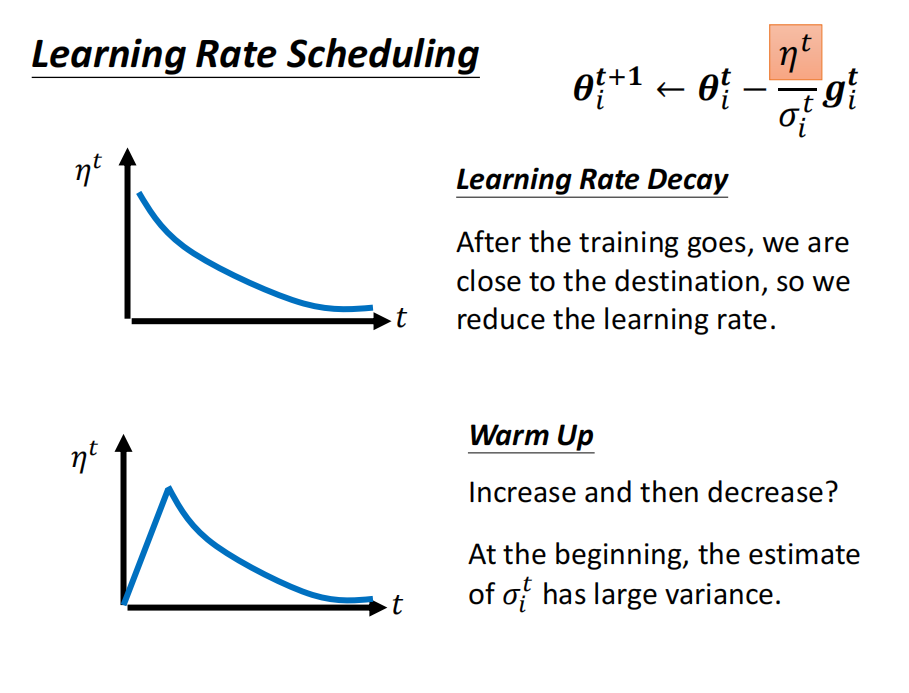

Learning rate schedule : decay/ warm up

learnign rate 随时间的变化情况

这篇关于P21 类神经网络训练不起来怎么办- 自动调整学习率 Adapative learning rate的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!