adapative专题

P21 类神经网络训练不起来怎么办- 自动调整学习率 Adapative learning rate

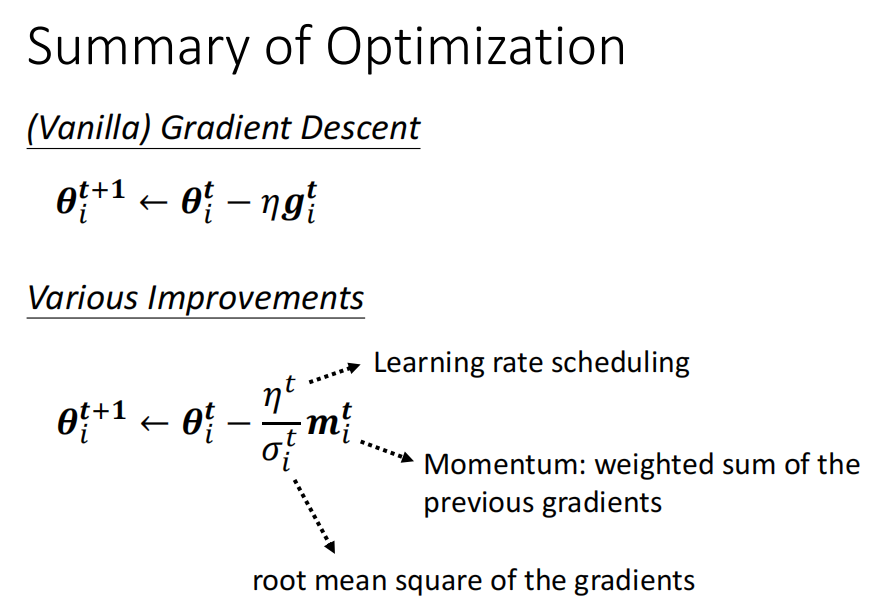

梯度大,学习率减小梯度小,学习率变大adam随时间变化 , decay / warm up 调整学习率方法一 adagrad 学习率除以 梯度的方差 方法二 RMSProp 目前最常用的: Adam: RMSProp + Moment Learning rate schedule : decay/ warm up learnign rate 随时间的变化情况