本文主要是介绍【半监督图像分割 2022 NeurIPS】GTA-Seg,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 【半监督图像分割 2022 NeurIPS】GTA-Seg

- 摘要

- 1. 简介

- 2. 相关工作

- 2.1 语义分割

- 2.2 半监督

- 2.3 半监督分割

- 3. 方法

- 3.1 准备工作

- 3.2 温文尔雅的助教

- 4. 实验

- 4.1 数据集

- 4.2 实现细节

- 4.3 实验结果

- 4.4 分析

- 5. 总结

【半监督图像分割 2022 NeurIPS】GTA-Seg

论文题目:Semi-Supervised Semantic Segmentation via Gentle Teaching Assistant

中文题目:基于温和教学助手的半监督语义分割

论文链接: https://arxiv.org/abs/2301.07340

论文代码:https://github.com/jin-ying/gta-seg

论文团队:香港中文大学&上海人工智能实验室

发表时间:

DOI:

引用:

引用数:

摘要

半监督语义切分旨在利用有限的标记数据和大量的未标记数据训练切分模型。 为了有效地利用未标记数据,伪标记和师生框架被广泛地应用于半监督语义分割。 尽管该范式被证明是有效的,但它不可避免地存在错误的伪标签,并被用作辅助训练数据。 为了缓解不正确的伪标签带来的负面影响,我们深入研究了现有的半监督语义分割框架。 我们认为,带有伪标签的未标记数据可以促进特征提取器中代表性特征的学习,但监督掩码预测器是不可靠的。 基于这种考虑,我们提出了一个新的框架–温和教学助理(GTA-SEG)来解决伪标签对学生模型特征提取器和掩码预测器的影响。 具体来说,除了原有的师生框架外,我们的方法引入了一个直接从教师网络生成的伪标签中学习的助教网络。 温和教学助理(GTA)之所以被称为温和,是因为它只将特征提取器中有益的特征表示知识以指数移动平均(EMA)的方式传递给学生模型,保护学生模型免受掩码预测器中不可靠的伪标签带来的负面影响。 学生模型还由可靠的标记数据监督,以训练准确的掩码预测器,进一步促进特征表示。 在基准数据集上进行的大量实验结果表明,该方法具有较好的性能。

1. 简介

深度学习的迅速发展为计算机视觉中最基本的任务之一–语义分割带来了巨大的进步[29,5,52]。 现有的方法往往严重依赖于大量按像素标注的数据,这既费力又昂贵。 面对这种负担,半监督语义分割引起了人们的极大兴趣,它试图用有限的标记数据和大量的未标记数据来训练语义分割模型。

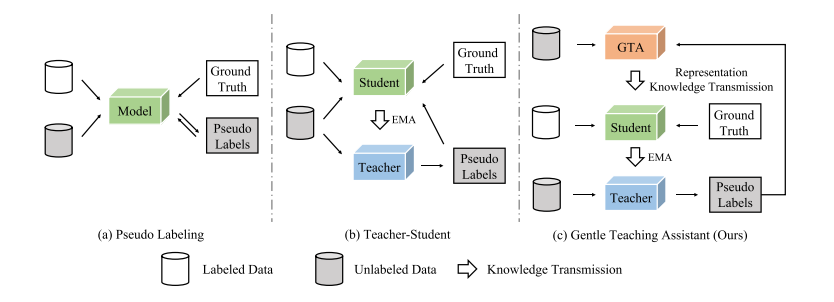

半监督学习的关键挑战是如何有效利用大量的未标记数据。一种被广泛采用的策略是伪标记[27]。如图1所示,该模型根据动态模型预测,将伪标签分配给未标记的数据。这些带有伪标签的数据将在训练过程中作为辅助监督,以提高性能。为了进一步促进半监督式学习,引入了师生框架[42,46,43]。教师模型是学生模型的指数移动平均(EMA),负责生成平滑更新的伪标签。通过有限的具有ground-truth标签的数据和丰富的具有pseudo标签的数据的共同监督,学生模型可以学习到更多具有代表性的特征,从而获得显著的性能收益。

尽管被证明是有效的,但伪标签范式受到不可靠的伪标签的影响,导致不准确的掩码预测。以前的研究工作通过过滤掉低于分类分数阈值的预测来缓解这个问题[3, 39, 50]。然而,这种机制不能完美地过滤掉错误的预测,因为一些错误的预测可能具有很高的分类分数,被命名为过度自信或错误校准[17]现象。此外,高阈值将严重减少生成的伪标签的数量,限制了半监督学习的有效性。

针对上述挑战,有必要提出一种新的伪标记范式,既能从未标记数据中学习具有代表性的特征,又能避免不可靠的伪标记所带来的负面影响。 深入研究语义分割框架,该框架由特征提取器和掩码预测器组成。 以往的研究要求特征提取器和掩码预测器同时从基本真值标签和伪标签中学习。 结果,模型的准确性受到不正确的伪标签的损害。 为了更好地利用带有伪标签的未标记数据,一个可行的解决方案是让特征提取器从基础真值标签和伪标签中学习特征表示,而掩码预测器只从基础真值标签中学习以预测准确的分割结果。

因此,我们提出了一个新的框架,半监督语义分割通过温和教学辅助(GTA-SEG),该框架在原有的师生框架的基础上增加了一个温和教学辅助(GTA)模块。 图1将我们的方法与以前的框架进行了比较。 在我们的方法中,教师模型为未标记的数据生成伪标记,温和的教学助理(GTA)从这些未标记的数据中学习。 只有GTA中的特征提取器的知识通过指数移动平均(EMA)传递给学生模型的特征提取器。 我们将这一过程称为表征知识传递。 同时,学生模型还从可靠的地面真值标签中学习,以优化特征提取器和掩码预测器。 温和教学助理(GTA)之所以被称为温和,是因为它不仅将有益的特征表示知识传递给学生模型,而且保护学生模型免受掩码预测器中不可靠的伪标签带来的负面影响。 此外,对伪标签进一步采用重新加权机制来抑制不可靠像素。

大量的实验验证了该方法在主流基准上的竞争力,证明了该方法能够更好地利用未标记数据。 另外,从可视化结果可以看出,该方法轮廓清晰,目标分类准确,具有较好的分割效果。

图1:与以前的框架比较。(a) 虚构的伪标签框架。该模型自己生成伪标签,反过来,从这些标签中学习。(b) 教师-学生框架的伪标签。教师模型负责生成伪标签,而学生模型同时从伪标签和地面真实标签中学习。知识传输是通过所有参数的指数移动平均(EMA)在两个模型之间进行的。© 我们的方法在师生框架中附加了一个温和的教学助理(GTA)模块。与(b)中的原始模块不同,温和的教学助理(GTA)从伪标签中学习,而学生模型只从地面真实标签中学习。我们设计了GTA和学生之间的表征知识传输,以减轻不可靠的伪标签所带来的负面影响。

2. 相关工作

2.1 语义分割

语义分割是计算机视觉中最基本的任务之一,目的是预测图像中每个像素的标记。 为了获得密集预测,FCN[29]用卷积层代替了分类模型中原有的全连通层。 借用著名的编码器-解码器结构来进一步细化像素级输出[34,2]。 同时,为了设计适合于语义分割的网络构件,也进行了大量的研究。 其中,扩张卷积[48]被提出来增强感受野,全局和金字塔池[28,5,52]被证明在建模上下文信息方面是有效的,各种注意力模块[51,53,14,21,41]被采用来捕捉图像中的像素关系。 这些工作标志着这一重要计算机视觉任务的里程碑,但他们很少关注数据稀缺的场景。

2.2 半监督

半监督学习中的主流方法分为两条线:自我训练[16,27]和一致性回归[26,38,33,45,42]。 自我训练的核心精神是利用模型预测从未标记的数据中学习。 伪标记[27]是半监督学习中一种广泛使用的技术[3,39,50],它将未标记数据上的模型预测转换为一个热标记。 自我训练的另一种变体,熵最小化[37]也被证明在理论上[44]和经验上[16]都是有效的。 一致性正则化[38,45]迫使模型在未标记数据上施加扰动时获得一致的预测。 最近的一些研究表明,自我训练和一致性正则化可以和谐地合作。 MIXMATCH[3]是一种开创性的整体方法,具有显著的性能。 FixMatch[39]在MixMatch的基础上进一步简化了学习过程,而FlexMatch[50]引入了类置信阈值来提高模型性能。

2.3 半监督分割

半监督语义分割半监督语义分割以像素级分类为目标。 借用半监督学习的精神,自我训练和一致性正则化催生了各种方法。 一个工作领域[56,7,20,43]在自我训练中应用伪标记来获得辅助监督,而基于一致性的方法[32]追求特征[25,54]和预测水平[36]的稳定输出。 除此之外,在相对早期的方法中,生成对抗网络[15]或对抗学习经常被用来提供额外的监督[40,22,31,24]。 最近的各种方法从其他角度解决了这个问题,如自校正网络[23]和对比学习[1]。 其中,一些著作[49]揭示了另一个有趣的现象,即最基本的训练范式,配备了强大的数据增强,可以作为一个简单而有效的基线。 本文对基于伪标签的半监督语义分割进行了研究,旨在缓解伪标签噪声对半监督语义分割的负面影响。

3. 方法

3.1 准备工作

半监督语义分割在半监督语义分割中,我们训练了一个具有有限标记数据 D l = { x i l , y i l } i = 1 N l D_{l}=\{x_{i}^{l},y_{i}^{l}\}_{i=1}^{N^{l}} Dl={xil,yil}i=1Nl和大量未标记数据 D u = { x i u } i = 1 N u D_{u}=\{x_{i}^{u}\}_{i=1}^{N^{u}} Du={xiu}i=1Nu的模型,其中 N u N^u Nu往往远大于 N l N^l Nl。 语义分割网络由特征提取器 f f f和掩码预测器 g g g组成。 半监督语义分割的关键挑战是如何充分利用大量的未标记数据。 一个常见的解决方案是伪标记[27,47]。

伪标记伪标记是一种广泛采用的半监督分割技术,它根据动态模型预测为未标记数据分配伪标记。 假设有 K \mathcal K K个类别,考虑第 i i i幅图像上的第 j j j个像素,模型预测 p i j u p_{i j}^{u} piju和相应的置信度 c i j u c_{i j}^{u} ciju为

p i j u = g ( f ( x i j u ) ) , c i j u = max k p i j u , with k ∈ K , p_{ij}^u=g(f(x_{ij}^u)),c_{ij}^u=\max\limits_k p_{ij}^u,\textrm{with}k\in\mathcal K, piju=g(f(xiju)),ciju=kmaxpiju,withk∈K,

其中 k k k表示第k个类别,较大的 c i j u c_{i j}^{u} ciju表示该模型在该像素上更加确定,因此更适合于生成伪标记。 具体来说,我们经常保留置信度值大于一个阈值的像素,生成伪标签为

y ^ i j u = { arg max k p i j u , c i j u > γ t ignore, otherwise , \hat{y}_{ij}^u=\begin{cases}\arg\max_k p_{ij}^u,&c_{ij}^u>\gamma_t\\ \text{ignore,}&\text{otherwise}\end{cases}, y^iju={argmaxkpiju,ignore,ciju>γtotherwise,

其中 γ t \gamma_t γt是t迭代时的置信度阈值。 我们注意到, γ t \gamma_t γt可以是一个常数,也可以是一个在训练过程中变化的值。 对于置信度大于 γ t \gamma_t γt的第i幅图像上的第 j j j个像素,将分配伪标记 y ^ i j u \hat{y}_{ij}^u y^iju。 将未标记的数据作为辅助训练数据,而其他未标记的数据将被忽略。

教师-学生框架教师-学生[9,42,43]框架是目前在半监督分割中广泛应用的一种范式,它由一个教师模型和一个学生模型组成。 教师模型负责生成伪标签,而学生模型从基础真值标签和伪标签中学习。 因此,学生模型的损失是

L = L l + μ L u , L u = ∑ i ∑ j L c e ( p i j u , y ^ i j u ) L=L_l+\mu L_u,L_u=\sum_i\sum_j L_{ce}(p_{ij}^u,\hat{y}_{ij}^u) L=Ll+μLu,Lu=i∑j∑Lce(piju,y^iju)

在半监督语义分割中, L l L_{l} Ll和 L u L_{u} Lu分别是带有伪标签的标记数据和未标记数据上的交叉熵损失[43],μ是调整二者权衡的损失权重。 学生模型的优化可表述为

θ s t u d e n t : = θ s t u d e n t − λ ∂ L ∂ θ s t u d e n t , \theta^{s t u d e n t}:=\theta^{s t u d e n t}-\lambda\frac{\partial L}{\partial\theta s t u d e n t}, θstudent:=θstudent−λ∂θstudent∂L,

其中 λ \lambda λ表示学习速率。 在师生框架中,学生模型参数更新后,教师模型参数将以指数移动平均(EMA)方式由学生参数更新。

θ t e a c h e r ( t ) = α θ t e a c h e r ( t − 1 ) + ( 1 − α ) θ s t u d e n t ( t ) , \theta^{teacher}(t)=\alpha\theta^{teacher}(t-1)+(1-\alpha)\theta^{student}(t), θteacher(t)=αθteacher(t−1)+(1−α)θstudent(t),

其中 θ t e a c h e r ( t ) \theta^{teacher}(t) θteacher(t)和 θ s t u d e n t ( t ) \theta^{student}(t) θstudent(t)分别表示教师和学生模型在第t次迭代时的参数。 α是EMA中的超参数,其中 α ∈ [ 0 , 1 ] \alpha\in[0,1] α∈[0,1]。

3.2 温文尔雅的助教

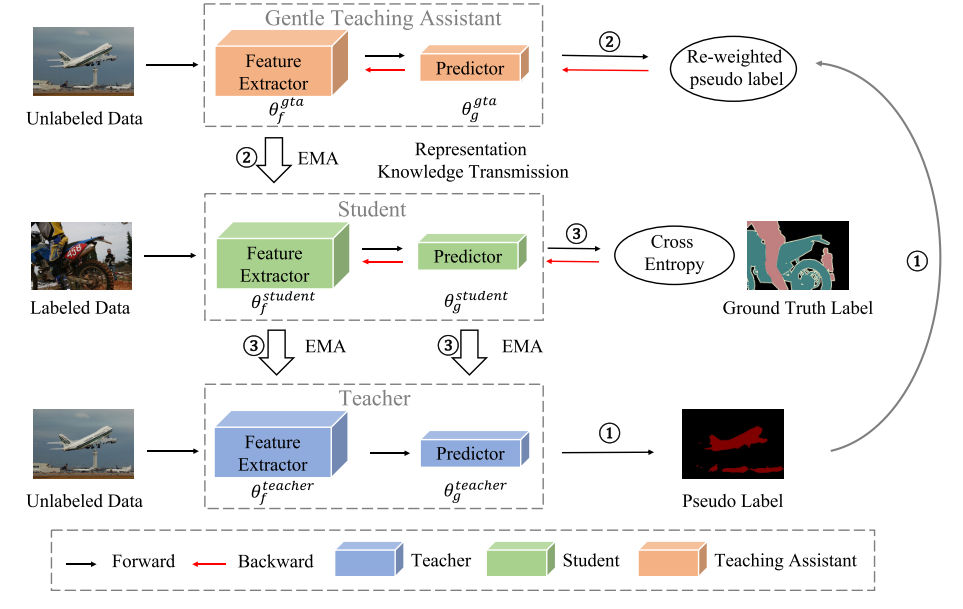

在本节中,我们将介绍我们的用于半监督语义分割的温和助教框架(GTA-SEG),如图2所示,它由以下三个步骤组成。

图2:方法概述。 我们的温和助教(GTA)框架可以分为三个步骤。 第一步:教师模型生成伪标签,然后温柔的助教可以从中学习。 结合一个重新加权策略来为生成的伪标签分配重要性权重。 第二步:温和的助教模型从伪标签中学习并进行表示知识传输,仅将特征提取器中学习到的知识通过指数移动平均(EMA)传递给学生模型。 第三步:从我们温和的助教那里吸取知识后,学生模型从GroundTruth标签中学习并优化所有参数。 最后,在每次训练迭代结束时,教师模型的参数也会根据学生模型通过EMA更新。

第1步:伪标签生成和重新加权。 与以前的工作[43]类似,教师模型负责生成伪标签。 还采用置信度阈值滤除置信度低的伪标签。 对于保留的像素,我们不是对所有像素一视同仁,而是根据每个像素的置信度提出了如下的重新加权机制,

w i j u = ( c i j u + τ ) ⋅ 1 ( c i j u > γ t ) ∑ i ∑ j ( c i j u + τ ) ⋅ 1 ( c i j u > γ t ) ⋅ ∑ i ∑ j 1 ( c i j u > γ t ) . w_{ij}^u=\frac{(c_{ij}^u+\tau)\cdot1(c_{ij}^u>\gamma_t)}{\sum_i\sum_j(c_{ij}^u+\tau)\cdot1(c_{ij}^u>\gamma_t)}\cdot\sum_i\sum_j1(c_{ij}^u>\gamma_t). wiju=∑i∑j(ciju+τ)⋅1(ciju>γt)(ciju+τ)⋅1(ciju>γt)⋅i∑j∑1(ciju>γt).

在我们的重新加权策略中,具有较高置信度的像素将被突出显示,而另一个将被抑制。 由此,不可靠的伪标签所造成的负面影响可以得到进一步缓解。 我们采用拉普拉斯平滑[30]来避免过度惩罚,其中τ是一个预定义的系数。 通过这种重新加权机制,在未标记数据上的无监督损失变成

L u = ∑ i ∑ j w i j u L c e ( p i j u , y ^ i j u ) . L_{u}=\sum_{i}\sum_{j}w_{ij}^{u}L_{ce}(p_{ij}^{u},\hat{y}_{ij}^{u}). Lu=i∑j∑wijuLce(piju,y^iju).

第二步:通过温和助教(GTA)进行表征性知识传递。 温和助教(GTA)在我们的框架中起着至关重要的作用。 以前的工作迫使学生模型同时从标记和未标记的数据中学习。 我们认为,将真实标签和伪标签等同对待是危险的,因为不正确的伪标签会误导掩码预测。 因此,我们想要解开伪标签对学生模型的特征提取器和掩码预测器的影响。 具体来说,我们的解决方案是增加一个温和的助教,它从未标记的数据中学习,只将有益的特征表示知识传递给学生模型,保护学生模型免受不可靠的伪标记带来的负面影响。

在对带有伪标签的无标签数据进行优化后,如公式8所示,温柔的助教模型需要通过指数移动平均法(EMA)将特征提取器中学习到的表示知识传达给学生模型,如公式9所示、

θ g t a : = θ g t a − λ ∂ L u ∂ θ g t a . θ f s t u d e n t ( t ) = α θ f s t u d e n t ( t − 1 ) + ( 1 − α ) θ f g t a ( t ) , \begin{gathered} \theta^{g t a}:=\theta^{g t a}-\lambda\frac{\partial L_{u}}{\partial\theta^{g t a}}. \\ \theta_{f}^{s t u d e n t}(t)=\alpha\theta_{f}^{s t u d e n t}(t-1)+(1-\alpha)\theta_{f}^{g t a}(t), \end{gathered} θgta:=θgta−λ∂θgta∂Lu.θfstudent(t)=αθfstudent(t−1)+(1−α)θfgta(t),

其中, θ g t a ( t ) \theta^{gta}(t) θgta(t)是温和助教模型在第t次迭代时的参数, θ s t u d e n t ( t ) \theta^{student}(t) θstudent(t)是学生模型在第t次迭代时的参数,θf表示特征提取器的参数。通过我们的表征知识传递,未标记的数据被利用来促进学生模型的特征表示,但它不会训练面具预测器。

第三步:用地面真值标签优化学生模型,更新教师模型。 有了温柔的助教模块,我们框架中的学生模型只需要从标注的数据中学习,

L l = ∑ i ∑ j L c e ( p i j l , y i j l ) , θ s t u d e n t : = θ s t u d e n t − λ ∂ L l ∂ θ s t u d e n t . \begin{gathered} L_{l}=\sum_{i}\sum_{j}L_{c e}(p_{i j}^{l},y_{i j}^{l}), \\ \theta^{s t u d e n t}:=\theta^{s t u d e n t}-\lambda\frac{\partial L_{l}}{\partial\theta^{s t u d e n t}}. \end{gathered} Ll=i∑j∑Lce(pijl,yijl),θstudent:=θstudent−λ∂θstudent∂Ll.

在此,整个模型包括特征提取器和掩码预测器,根据标记数据的地面真值标签计算出的监督损失进行更新。 然后,根据传统的师生框架范式,采用学生模型的EMA对教师模型进行更新。

θ f t e a c h e r ( t ) = α θ f t e a c h e r ( t − 1 ) + ( 1 − α ) θ f s t u d e n t ( t ) , θ g t e a c h e r ( t ) = α θ g t e a c h e r ( t − 1 ) + ( 1 − α ) θ g s t u d e n t ( t ) . \begin{gathered} \theta_{f}^{t e a c h e r}(t) =\alpha\theta_{f}^{t e a c h e r}(t-1)+(1-\alpha)\theta_{f}^{s t u d e n t}(t), \\ \theta_{g}^{t e a c h e r}(t) =\alpha\theta_g^{teacher}(t-1)+(1-\alpha)\theta_g^{student}(t). \end{gathered} θfteacher(t)=αθfteacher(t−1)+(1−α)θfstudent(t),θgteacher(t)=αθgteacher(t−1)+(1−α)θgstudent(t).

最后,教师模型将从学生模型中吸收标记和未标记数据的知识,作为最终的推理模型。

4. 实验

4.1 数据集

我们在1)Pascal VOC2012[11]:一个广泛用于语义分割的基准数据集上对我们的方法进行了评估,其中1464幅图像用于训练,1449幅图像用于验证。 有的研究[7,47]将SBD[18]中的9118幅粗标注图像加入到原始训练集中,得到10582幅有标记的训练图像,称为增广训练集。 在我们的实验中,我们同时考虑了原始训练集和增强训练集,分别从原始训练集中的1464幅标记图像中提取了92、183、366、732和1464幅图像,从增强训练集中的10582幅标记训练图像中提取了662、1323和2645幅图像。 2)Cityscapes[8],一个城市场景数据集,2975幅图像用于训练,500幅图像用于验证。 我们从训练集中的2975幅标记图像中抽取了100,186,372,744幅图像。 我们在[56]中接受分裂,并在公平的比较中报告所有的表现。

4.2 实现细节

我们以ImageNet[10]上预训练的Resnet-101[19]为网络骨干,DeepLabv3+[6]为解码器。 分割头将512-dim特征映射到像素类预测中。 我们以SGD作为优化器,对Pascal VOC的初始学习率为0.001,权值衰减为0.0001。 解码器的学习速率是网络骨干的10倍。 在城市景观上,初始学习率为0.01,权值衰减为0.0005。 在学习速率Lr=Lrinit·(1-t)0.9的情况下,采用多聚调度,其中Lrinit为初始学习速率,t为当前迭代,t为总迭代。 我们在Pascal VOC上用4个GPU训练模型,在Cityscapes上用8个GPU训练模型。 在我们所有的实验中,我们设置了标记和未标记数据损失之间的折衷关系μ=1.0,在我们的重新加权策略中的超参数τ=1.0,以及在我们的所有实验中的EMA超参数α=0.99。 在训练开始时,我们对所有三个组成部分(温和的助教、学生和教师)进行一个时代的标记数据训练,作为遵循惯例的热身[42],这使得与以前的方法能够进行公平的比较。 然后我们继续用我们的方法训练模型。 对于伪标签,我们抛弃了置信度较低的20%数据。 我们在随机种子=0,1,2的情况下运行每个实验3次,并报告平均结果。 在评估过程中,采用Pascal VOC对输入图像进行中心裁剪,而在城市景观中采用滑动窗口评估。 在验证集上度量的并上交的平均值(MIOU)作为评价指标。

4.3 实验结果

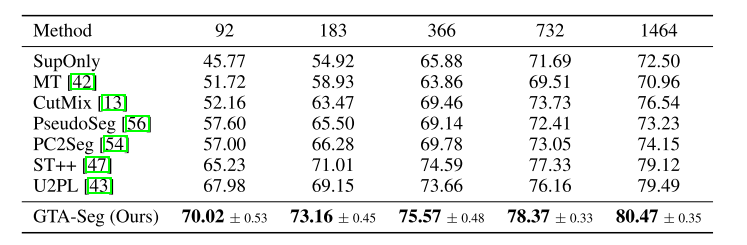

我们首先在Pascal VOC 2012的原始训练集上评估我们的方法。 表1中的结果验证了我们的方法在很大程度上超过了以前的方法。 具体而言,当数据标记率为0.9%、1.7%、3.4%、7.0%、13.9%时,该方法在MIOU中分别提高了24.25、18.24、9.69、6.68、7.97. 与强半监督语义分割方法相比,该方法仍分别比强半监督语义分割方法提高了13.02、6.88、5.79、5.32、6.32。 我们注意到在原始训练集中,标记数据的比率相对较低(0.9%到13.9%)。 因此,实验结果验证了该方法在半监督语义分割中利用未标记数据是有效的。

表1:Pascal VOC 2012的结果,原始训练集。 我们总共有1464幅标记图像,并抽取不同比例的图像作为标记训练样本。 SUPONLY意味着只在标记数据上训练模型,而放弃所有其他未标记的数据。 训练集中的所有其他图像(包括增强训练集中的图像)都被用作未标记数据。 我们使用Resnet-101作为主干,DeepLabv3+作为解码器。

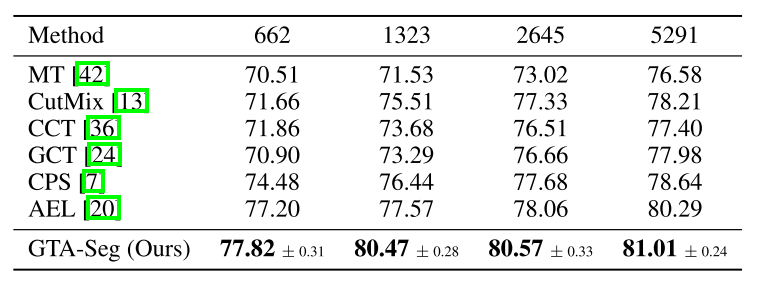

在Pascal VOC 2012的增强训练集上,我们进一步将我们的方法与以前的方法进行了比较,在Pascal VOC 2012的增强训练集上,由于一些标记图像来自SBD[18]数据集,注释质量相对较低。 我们可以从表2中观察到,在公平的比较中,我们的方法始终优于以前的方法。

Pascal VOC 2012的结果,增强的训练集。 我们总共有10582幅有标记的图像,并抽取不同比例的图像作为标记训练样本。 训练集中的所有其他图像都被用作未标记数据。 表示法和网络体系结构与表1中相同。

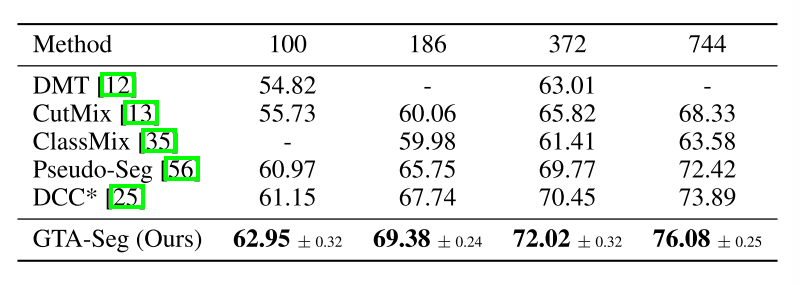

Cityscapes对于Cityscapes,如表3所示,我们的方法在MIOU中仍然显示出竞争性能,在3.3%、6.25%、12.5%、25.0%的数据标记时,我们的方法比现有的方法提高了1.80、1.64、1.57、2.19。

表3:Cityscapes数据集的结果。 我们总共有2975幅标记图像,并抽取不同比例的图像作为标记训练样本。 表示法和网络体系结构与表1中相同。 *意味着我们使用Resnet-101主干重新实现该方法,以便进行公平的比较。

4.4 分析

成分分析

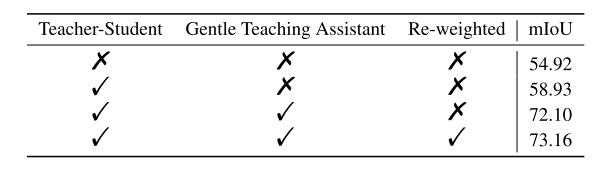

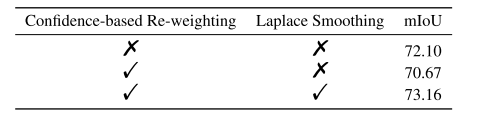

我们分析了我们方法中不同成分的有效性,即原始的师生框架、温和的助教和重新加权的伪标记,如表4所示。 根据表4的结果,精心设计的温和助教机制(第三行)帮助我们的方法优于以前的方法,推动性能比原始师生模型(第二行)高出约13.1。 此外,重新加权的伪标记带来了1.1的性能改进。 在MIOU环境下,我们的方法比教师-学生模型的性能好14.0以上,比教师-学生模型的性能好18.0以上。

表4:对我们方法中成分的消融研究,在Pascal VOC 2012的原始训练集上,有183个标记样本。

温和助教

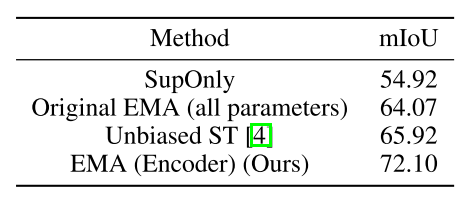

如表4所示,我们提出的温和助教框架带来了显著的性能收益。 受此启发,我们对我们框架中的温和助教模型进行了更深入的钻研。 我们首先考虑表示知识传递机制。 在表5中,我们将我们的机制与其他方法进行了比较,例如原始的EMA[42]通过EMA更新所有参数,以及无偏的ST[4]引入了一个额外的代理来传递表示知识。 我们可以观察到,所有这些机制都有显著的促进作用,而我们的机制优于其他方法。

表5:知识传递机制比较。 实验设置如下表4所示。

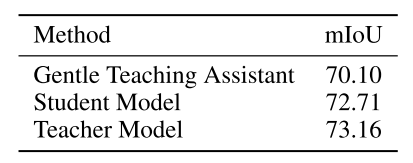

接下来我们将关注我们框架中的三种模式,即温和的助教模式、学生模式和教师模式。 表6报告了对它们的评价业绩。 它们都表现出相对有竞争力的表现。 对于教师助理模式来说,它不如学生模式。 这是合理的,因为它只在伪标签上训练,而学生模型继承了温文尔雅助教对未标记数据的表示知识,并在标记数据上训练。 此外,教师模型表现最好,这与前人的作品一致[42]。

表6:三个模型对原Pascal VOC 2012的结果。 实验设置如下表4所示。

方法设计在我们的方法中,我们用伪标签训练GTA,用标签数据训练学生模型。 探索其他设计的模型性能是很有趣的。 表9表明:1)用伪标签训练学生模型会导致显著的性能下降,这与我们的说法是一致的,即学生模型不能直接从伪标签中学习。 2)在GTA训练中加入标记数据不利于模型性能。 我们推测,当我们将标记数据的知识从GTA传递到学生模型,以及用标记数据监督学生模型时,有限的标记压倒了学生模型的更新,这可能导致过拟合,损害学生模型的性能。 由于教师模型纯粹是由学生模型通过EMA更新的,教师模型的性能也受到损害。 考虑到最终目标是提高教师模型的性能,我们选择单独使用伪标签来训练GTA。

表9:消融研究,我们的重新加权策略伪标记的原始帕斯卡VOC 2012。 实验设置如下表4所示。

重权重策略在我们的方法中,我们将伪标签的重权重策略设计为EQ。 6,包括1)基于置信度的重加权,2)拉普拉斯平滑。 在这里,我们对我们的设计进行了进一步的烧蚀研究。 表9显示,虽然在其他任务中有效,如半监督目标检测[46],但在我们的框架中,采用置信基重权重是有害的,性能从72.10下降到70.67。 相反,我们的策略,在拉普拉斯平滑[30]的帮助下,减轻了过度的惩罚,将容易强大的表现推向了一个更高的水平。

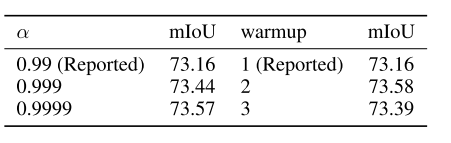

在超参数灵敏度方面,我们评估了该方法在不同EMA超参数和不同预热期下的性能。 表8中的结果表明,我们的方法在不同的超参数下稳定地执行。 此外,如果仔细调整超参数,性能仍然可以稍微提高。

表8:不同均线超参数和预热期下的性能。 实验设置如下表4所示。

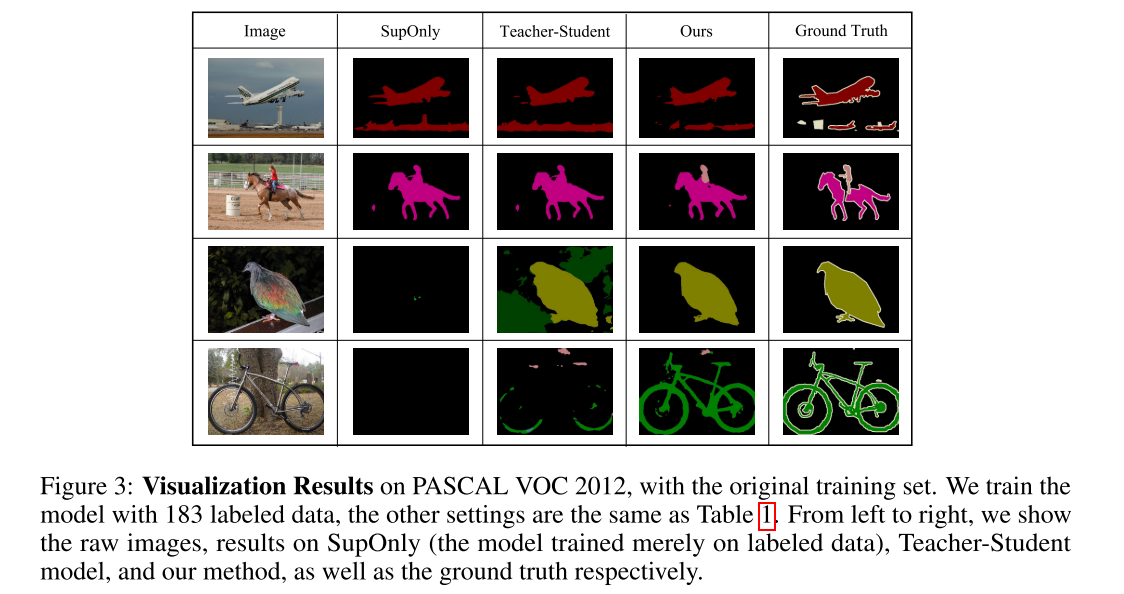

除了定量结果外,我们给出了可视化结果来进一步分析我们的方法。 我们注意到,该模型仅在183个标记样本和约10400个未标记样本上训练。 如图3所示,面对如此有限的标记数据,仅仅以监督的方式(suponly)训练模型似乎是易受攻击的。 在某些情况下,模型甚至不知道给定的图像(第三行和第四行)。 而利用未标记数据的方法(师生模型和我们的方法)则表现出更强的性能。 此外,与原始师生模型相比,我们的方法在确定物体的清晰轮廓(第一行)和识别相应类别(第二行)方面表现出更强的能力。 在区分物体和背景(第三和第四行)方面,我们的方法也优于以前的方法。

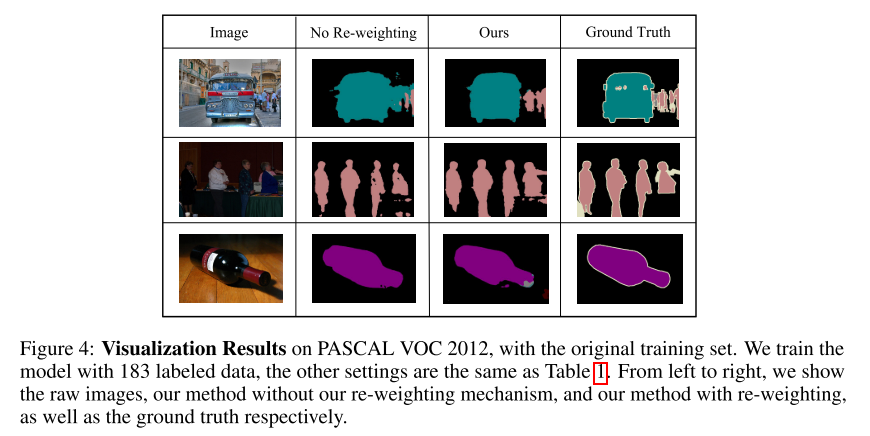

此外,我们给出了更多关于我们设计的重权重策略的可视化结果。 我们可以从图4中观察到,将重新加权策略合并到我们的方法中可以在轮廓或模糊区域上获得更好的性能。

局限性我们的方法的一个局限性是,它带来了更多的培训成本,因为它纳入了一个额外温和的助教模式。 幸运的是,由于只采用教师模型进行推理,因此不影响推理效率。 另一方面,我们的方法只试图更好地利用未标记的数据,而很少关注标记的数据。 我们认为在半监督语义分割中如何更好地利用标记数据是很有希望的。

5. 总结

在本文中,我们为半监督语义分割(GTA-Seg)提出了一个新颖的框架–温和教学助理。具体来说,我们附加了一个额外的教学助理模块,以分离伪标签对特征提取器和掩码预测器的影响。GTA从无标签的数据中学习表征知识,并通过我们精心设计的表征知识传输将其传达给学生模型。通过这个框架,该模型用未标记的数据优化了表征,同时也防止了它在有限的标记数据上过度拟合。一个基于置信度的伪标签再加权机制被用于进一步提高性能。广泛的实验结果证明了我们方法的有效性。

这篇关于【半监督图像分割 2022 NeurIPS】GTA-Seg的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!