本文主要是介绍神经网络0——convolution+ReLu、maxpooling、fully connected、softmax各部分作用,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 一、convolution——提取特征

- 二、ReLu——激活函数

- 1.什么是激活函数

- 2.在Pytorch中常用的几个激活函数

- 三、pooling——降维(减小feature map的尺寸),减小计算量和参数量、增大感受野

- 1.max Pooling

- 2.Avg Pooling

- 四、fully nected——作用主要就是实现分类(Classification)

- 五、softmax()——后续更新

- 参考

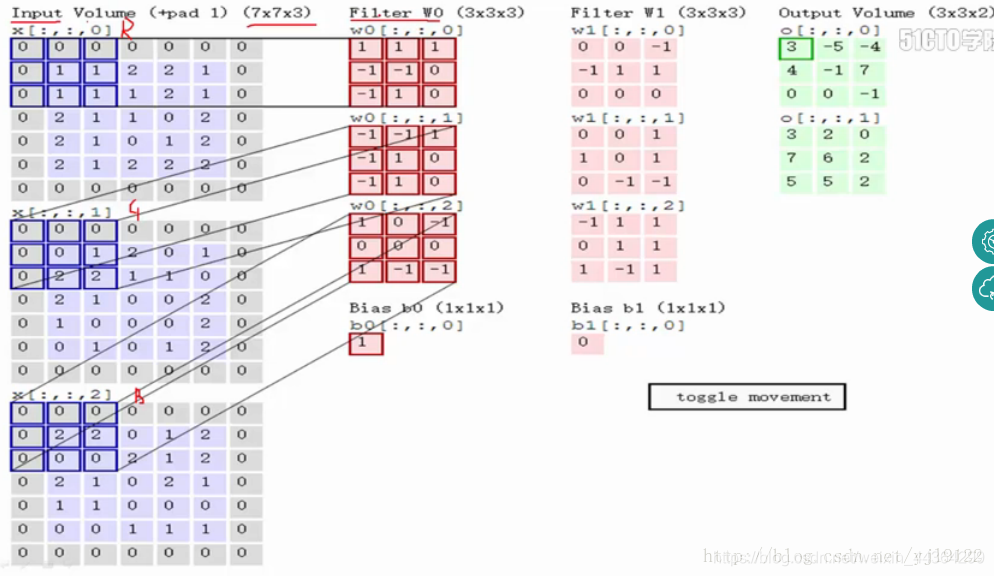

一、convolution——提取特征

二、ReLu——激活函数

1.什么是激活函数

定义:用于对上一层的所有输入求加权和,然后生成一个输出值(通常为非线性值),并将其传递给下一层。在神经网络中,激活函数是一个非线性函数。

作用:解决不能用线性方程所概况的问题

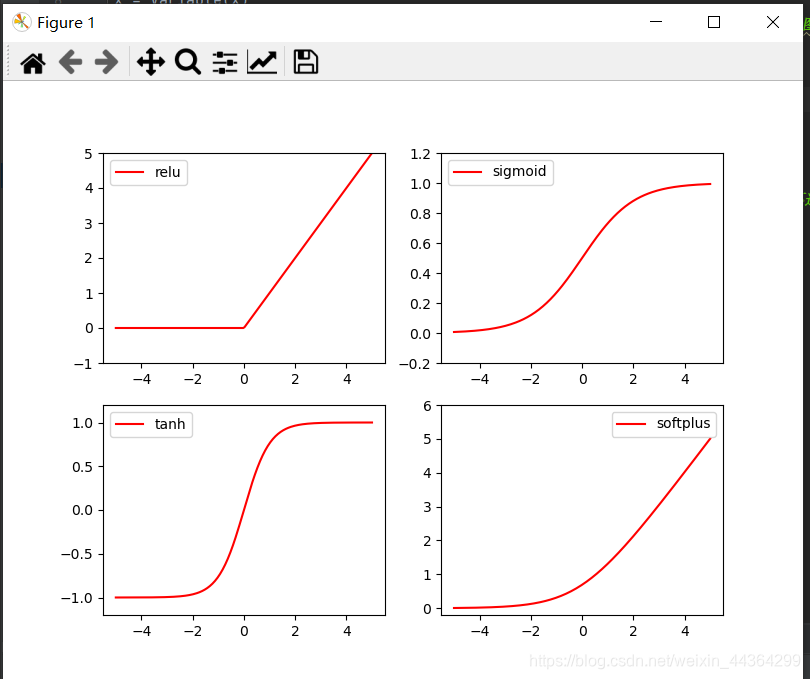

2.在Pytorch中常用的几个激活函数

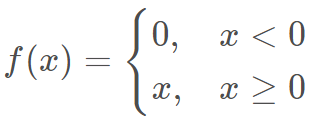

ReLU

注:relu6:表示最大值是6

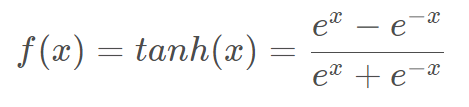

Tanh

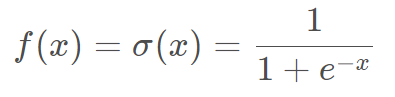

Sigmoid

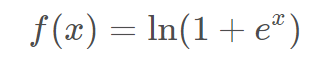

Softplus

import torch

import torch.nn.functional as A # 用来实现各种非线性化的功能:nn是神经网络模块

from torch.autograd import Variable #Variable来签到激励函数

import matplotlib.pyplot as plt # python 的可视化模块, 我有教程 (https://mofanpy.com/tutorials/data-manipulation/plt/)# 做一些假数据来观看图像fake data

x = torch.linspace(-5, 5, 200) # 从-5~5取500个数据。x data (tensor), shape=(100, 1)

x = Variable(x)

x_np = x.data.numpy() #torch数据不能被plt matplotlib识别,换成 numpy array, 出图时用# 几种常用的 激励函数

y_relu = A.relu(x).data.numpy()

y_sigmoid = A.sigmoid(x).data.numpy()

y_tanh = A.tanh(x).data.numpy()

y_softplus = A.softplus(x).data.numpy()

# y_softmax = A.softmax(x) softmax 比较特殊, 不能够通过线图来呈现,不能直接显示, 不过他是关于概率的, 用于分类plt.figure(1, figsize=(8, 6))

plt.subplot(221)

plt.plot(x_np, y_relu, c='red', label='relu')

plt.ylim((-1, 5))

plt.legend(loc='best')plt.subplot(222)

plt.plot(x_np, y_sigmoid, c='red', label='sigmoid')

plt.ylim((-0.2, 1.2))

plt.legend(loc='best')plt.subplot(223)

plt.plot(x_np, y_tanh, c='red', label='tanh')

plt.ylim((-1.2, 1.2))

plt.legend(loc='best')plt.subplot(224)

plt.plot(x_np, y_softplus, c='red', label='softplus')

plt.ylim((-0.2, 6))

plt.legend(loc='best')plt.show()

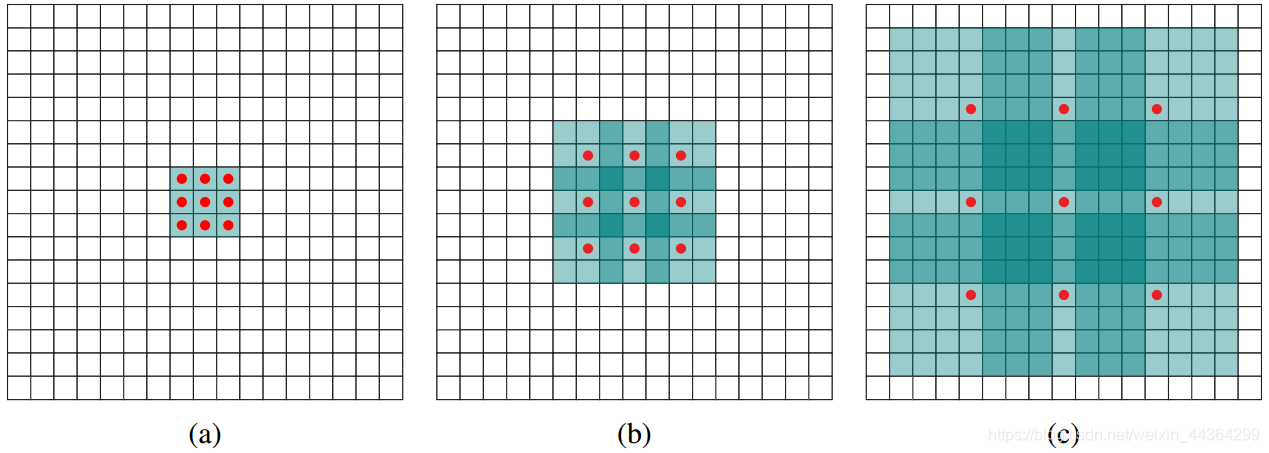

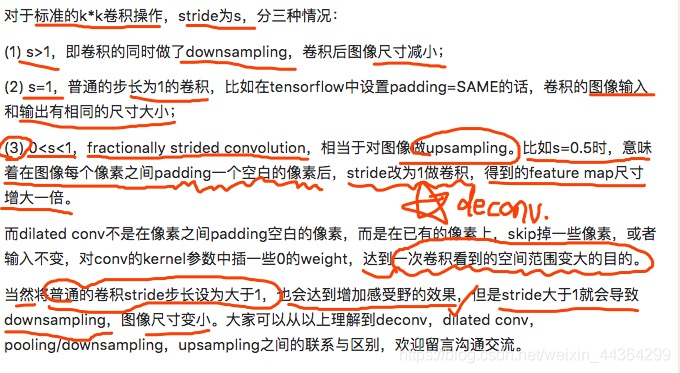

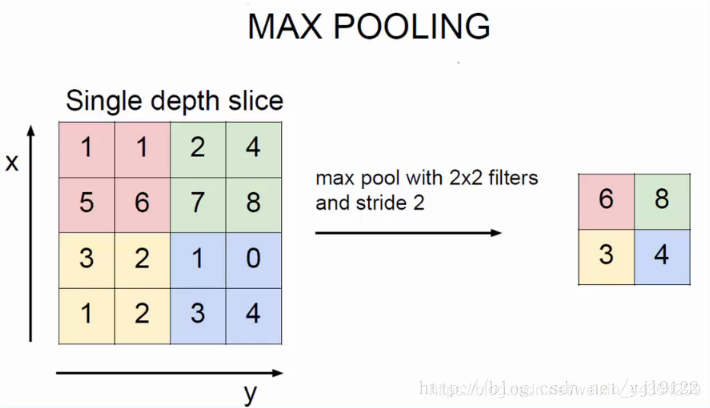

三、pooling——降维(减小feature map的尺寸),减小计算量和参数量、增大感受野

相当于带步长s>1的卷积

1.max Pooling

2.Avg Pooling

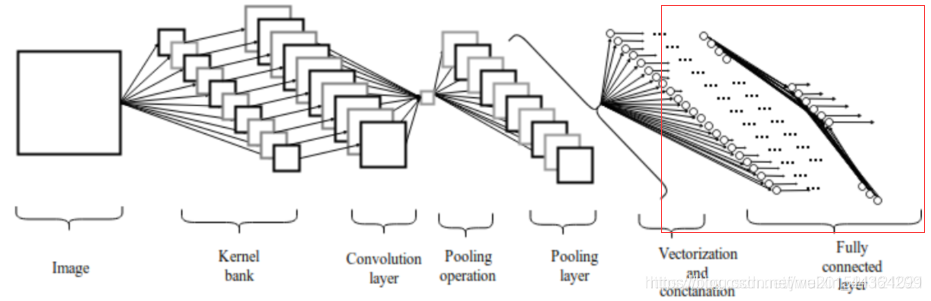

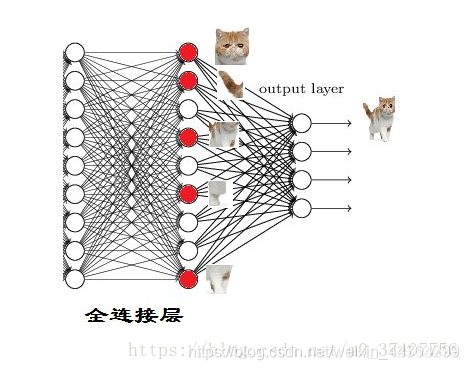

四、fully nected——作用主要就是实现分类(Classification)

卷积取的是局部特征,全连接就是把以前的局部特征重新通过权值矩阵组装成完整的图。

因为用到了所有的局部特征,所以叫全连接。

五、softmax()——后续更新

参考

1.https://blog.csdn.net/jiachen0212/article/details/78548667 2.https://blog.csdn.net/weixin_41513917/article/details/102514739?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522161691768416780357257191%2522%252C%2522scm%2522%253A%252220140713.130102334..%2522%257D&request_id=161691768416780357257191&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~all~top_click~default-1-102514739.first_rank_v2_pc_rank_v29&utm_term=maxpooling 3. https://blog.csdn.net/m0_37407756/article/details/80904580这篇关于神经网络0——convolution+ReLu、maxpooling、fully connected、softmax各部分作用的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!