本文主要是介绍【阅读笔记】Bringing Your Own View: Graph Contrastive Learning without Prefabricated Data Augmentations,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

【阅读笔记】WSDM 2022 - Bringing Your Own View: Graph Contrastive Learning without Prefabricated Data Augmentations

- 1 引言

- 2 相关工作

- 2.1 Graph contrastive learning.

- 2.2 Learnable prior.

- 2.3 Graph generative model.

- 3 方法

- 3.1 可学习先验的图生成模型

- 3.2 对比学习先验的原则

- 4 实验

- 4.1 与最先进水平的比较

- 4.1.1 半监督学习

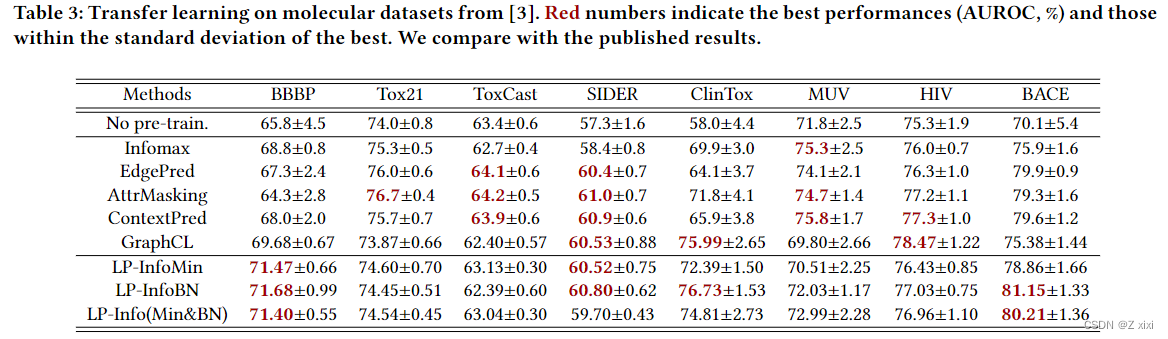

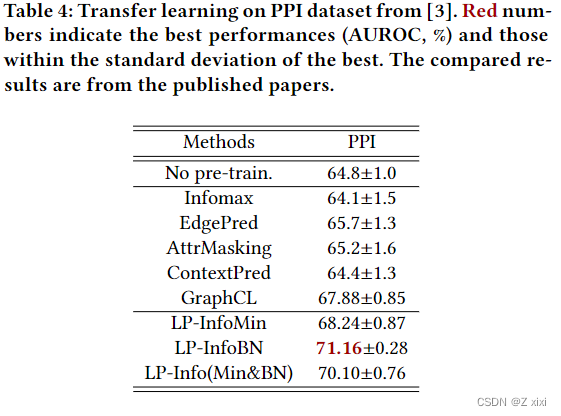

- 4.1.2 迁移学习

- 4.2 进一步分析

- 4.2.1图形生成质量通常与下游性能保持一致

- 4.2.2 单独使用分子特异性生成器对分子数据集没有显著的好处。

- 4.2.3 调整原则性奖励超参数可以进一步增强竞争性能。

- 4.2.4 生成图连接稀疏,以捕捉模式。

- 5 总结

1 引言

非欧几里德结构化数据的自监督学习最近引起了广泛的兴趣,它能够从未标记的图数据中学习可推广、可转移和鲁棒性的表示。与图像、语音或自然语言不同,图形结构数据不是单态的,而是各种性质的抽象(例如社交网络、聚合物或电网)。然而,这种独特的异质性挑战在以前的自监督工作中没有得到充分解决。

现有方法的成功依赖于精心设计的具有领域专业知识的预测性借口任务(例如,上下文预测、元路径提取、图完成等),前提是指定的任务是所有数据集中通常有效的先验,而它并不总是得到保证,尤其是在提到的多样性上下文中。

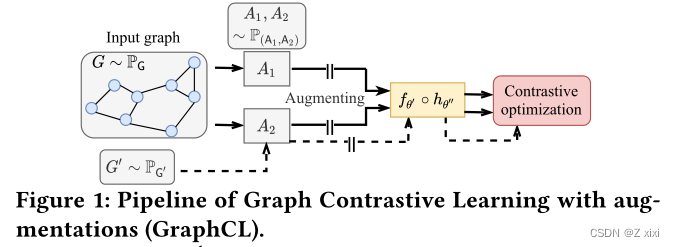

最近出现的对比方法似乎没有设置借口,而借口以伪装的形式存在:需要构建适当的手工对比视图(例如全局-局部表示、扩散矩阵,γ-ego网络等),否则会导致性能下降。最先进的(SOTA)代表图对比学习(GraphCL),甚至通过额外的人工工作来应对这一挑战:它通过经验法则或试错法,通过手动选择和应用每个数据集的预制增强操作在增强图上进行对比。因此,它根据不同的图数据集更加灵活,尽管成本更高,因为规则是通过使用下游标签进行冗长的调优得到的,并且构建在预制先验池(即现成的增强)之上。

我们帮助缩小差距的观点是将预制的自我监督先验转化为可学习的先验。直观地说,与坚持不变的先验相比,遵循数据驱动理念的可学习先验更具通用性,与手工从现成的先验中挑选相比,要求资源更少。在视频生成、压缩感知和贝叶斯深度学习中探索了学习先验。然而,据我们所知,在离散和不规则的图形数据结构中尚未探讨这一观点。

- 定义和追求可学习的自监督先验可以依赖的空间、原则和框架是什么?

- 利用SOTA-GraphCL框架作为基础模型,我们创新性地将增强集中预制的离散先验扩展为可学习的连续先验,该先验由神经网络参数化,在对比训练期间自适应地动态地从数据中学习。

(i) 先验空间由神经网络的参数空间决定,我们利用图生成模型进行参数化。

(ii)采用信息最小化(InfoMin)和信息瓶颈(InfoBN)作为原则来正则化生成器优化。

(iii)新方法为一个双层优化(框架)

- 利用SOTA-GraphCL框架作为基础模型,我们创新性地将增强集中预制的离散先验扩展为可学习的连续先验,该先验由神经网络参数化,在对比训练期间自适应地动态地从数据中学习。

- 拟议的组件简要总结如下:

- 由图生成模型参数化的可学习先验函数,该模型可能能够很好地从数据中捕获图先验(见第3.1节);

- InfoMin和InfoBN的原理,用于在对比学习期间正则化发电机优化,避免崩溃的琐碎解决方案(见第3.2节)。

本文贡献:

(i)我们首次尝试将可学习先验与图形神经网络相结合,在有指导意义的先例假设下进一步利用丰富数据的力量;

(ii)我们在自适应和自动化方面学习,这不仅需要很少的人力来预制先验,即增强函数,但也以数据驱动、灵活和有原则的方式在自我监督过程中学习这些知识。这对于根据图多态性挑战实现更好的泛化至关重要,这是以数据驱动的方式实现的,无需手工知识或昂贵的试错,尤其是在大规模数据集上。

我们在图数据集上评估了我们提出的半监督学习和转移学习方法,包括社交网络、蛋白质相互作用网络、代码抽象语法树和分子。在数值上,我们表明,在小基准上,GraphCL中学习到的先验与SOTA竞争对手的性能相当,并且在大规模数据集上具有更好的泛化能力,而不需要任何人工劳动来预先定义扩充或繁琐的调整。

2 相关工作

2.1 Graph contrastive learning.

2.2 Learnable prior.

以图对比学习为例,我们通常会采用节点去除,边去除,节点特征掩膜等方法进行图增强。选用这些增强方法的一个前提是,我们知道这些增强方法不会改变图的语义信息。那么,这个前提实际就是prior.

2.3 Graph generative model.

我们在这里关注最近的基于学习的生成模型在输入图𝐺的条件,将𝜙-parameterized随机生成函数定义为𝑔𝜙:G→G,对目标的LGen (G,𝜙)进行优化。

3 方法

3.1 可学习先验的图生成模型

- 在GraphCL中制定先验。

作者把图对比学习中的prior定义为图流形中的随机映射m。这个随机映射是从一个图空间映射到另外一个图空间 m :G→G 。 - 在对比学习中结合先前学习的图形生成模型的框架。

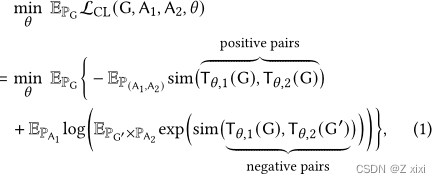

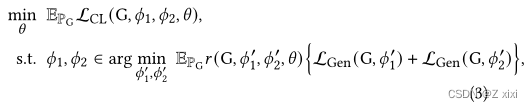

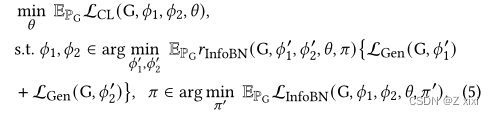

具有学习先验的GraphCL的简单双层优化形式写为:

- 图形发生器的奖励信号。

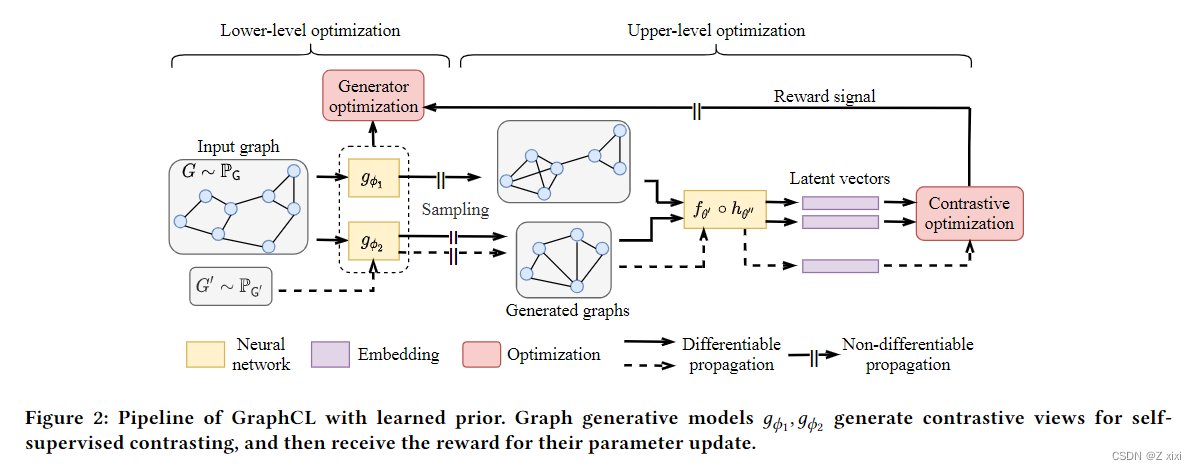

公式(2)虽然合理,但在训练期间没有从上层优化传递到下层优化的消息。换言之,生成模型在(2)中训练,没有考虑GraphCL,这使得先验学习不适应对比学习,并可能导致先验的平凡解和对比学习的模式崩溃(例如,两个图生成器输出相同地分布,导致简单的对比优化)。为了将反馈传播到较低级别的生成器优化,我们另外给它一个“奖励”信号(如图2所示),并得出一个新的双层优化公式,如下所示:

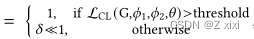

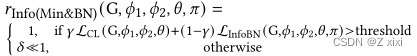

奖励的形式很简单,𝑟 (G, 𝜙1, 𝜙2, 𝜃 ) = {1, given some condition ; 𝛿 ≪1, otherwise},如果条件不满足,奖励减弱到𝛿。

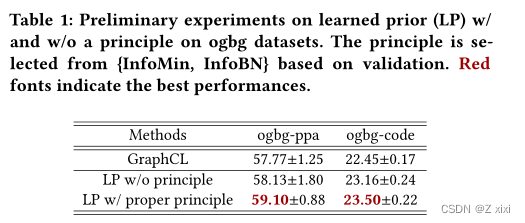

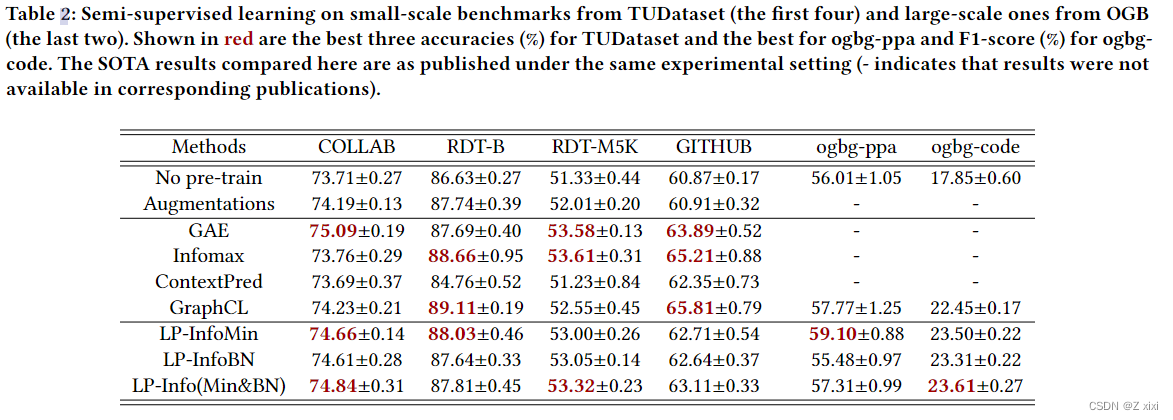

基于ogbg数据集的学习先验(LP)w/和w/o原理的初步实验。该原理是根据验证从{InfoMin,InfoBN}中选择的。红色字体表示最佳性能。

图生成模型𝑔𝜙1、𝑔𝜙2生成对比视图进行自监督对比,并因参数更新而获得奖励。

图生成模型𝑔𝜙1、𝑔𝜙2生成对比视图进行自监督对比,并因参数更新而获得奖励。

3.2 对比学习先验的原则

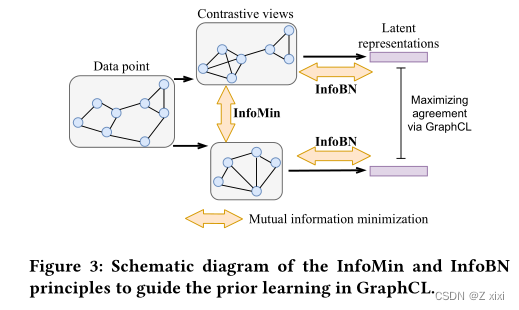

InfoMin和InfoBN原则示意图,用于指导GraphCL中的先前学习。

-

信息最小化原则(InfoMin):鼓励对比视图在最大化其潜在表达之间的一致性时共享更少的互信息(MI)。

InfoMin奖励函数定义为 𝑟InfoMin (G, 𝜙1, 𝜙2, 𝜃 )

-

信息瓶颈原则(InfoBN):最初是为了阻止表示获取与预测目标无关的多余信息,以实现更好的通用性和鲁棒性。

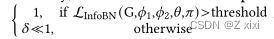

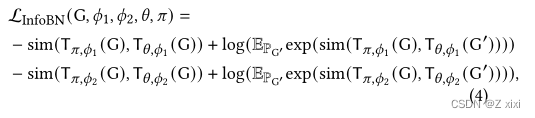

InfoBN奖励函数定义为为𝑟InfoBN (G, 𝜙1, 𝜙2, 𝜃, 𝜋) =

关于最小化 𝜋 。实现精确估计。这样,带有InfoBN的GraphCL写为:

- 将InfoMin与InfoBN合并。

最后,将InfoMin与InfoBN as Info(Min&BN)结合起来,以探索这两种原则的适当协作是否能够超越各自的表现。我们根据两个对比视图之间以及视图及其嵌入之间的估计MI的加权和构建协作奖励,表述为

4 实验

4.1 与最先进水平的比较

4.1.1 半监督学习

4.1.2 迁移学习

4.2 进一步分析

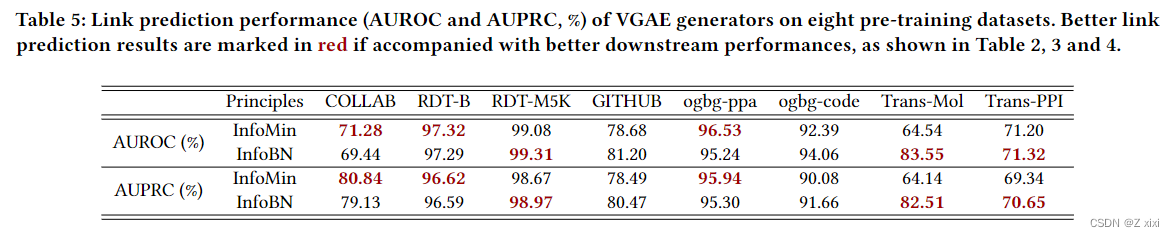

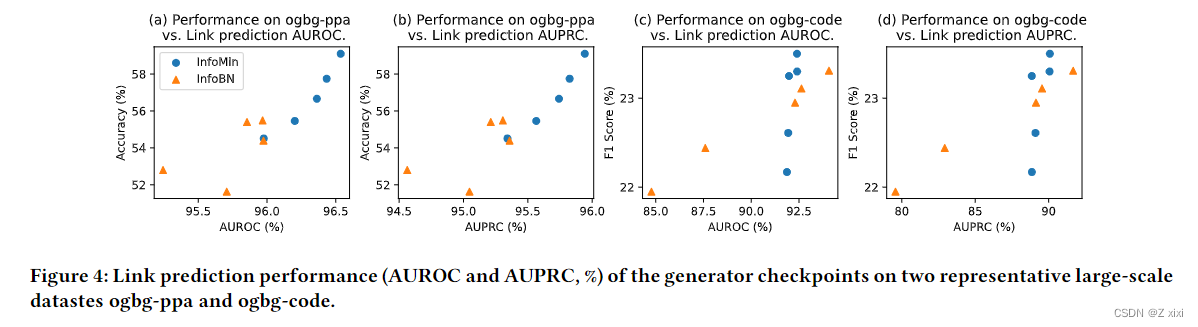

4.2.1图形生成质量通常与下游性能保持一致

-

表5显示,在InfoMin和InfoBN原则的指导下,生成器进行了更精确的链路预测(在AUROC和AUPRC中),导致8个数据集中有6个具有更好的下游性能。

-

如图4所示,在训练期间的不同检查点中观察到相同的趋势。

4.2.2 单独使用分子特异性生成器对分子数据集没有显著的好处。

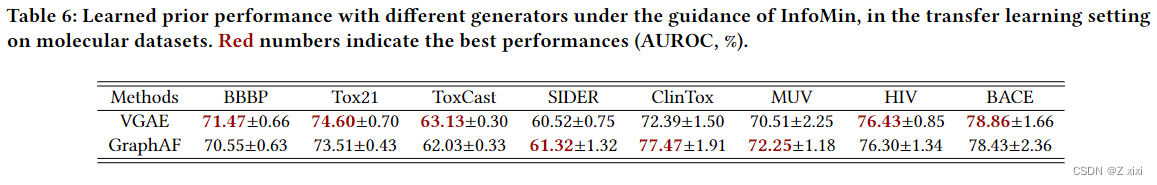

我们在表6中展示了纳入InfoMin原理的结果。

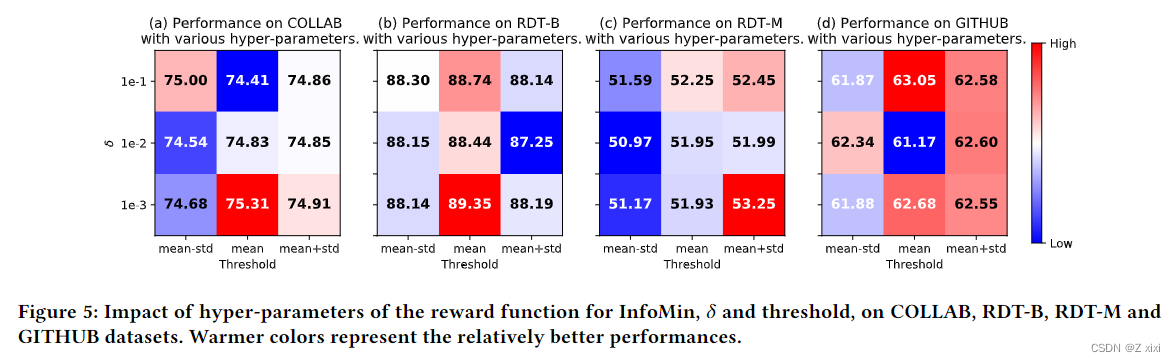

4.2.3 调整原则性奖励超参数可以进一步增强竞争性能。

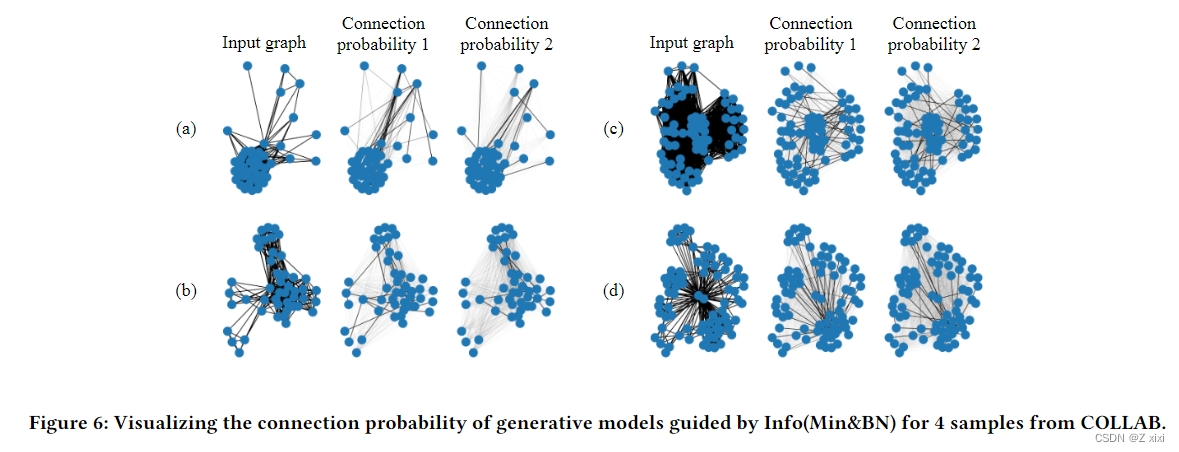

4.2.4 生成图连接稀疏,以捕捉模式。

5 总结

结论在本文中,我们通过引入可学习先验和学习框架来实现更具自适应性、自动性和可推广性的图自监督学习。利用SOTA-GraphCL框架作为基础模型,我们将预制的离散先验扩展为可学习的连续先验,由图生成模型参数化。此外,还结合了InfoMin和InfoBN等原则,以避免陷入琐碎地解决方案中。由此产生的框架被表述为双层优化。从经验上看,这是首次尝试将自适应和动态学习的先验知识与GNN相结合,在小型基准测试上与SOTA竞争对手不相上下,并在大规模数据集上具有更好的泛化能力,而无需借助领域知识的专业知识或依赖下游验证的繁琐试错。我们提出的可学习先验进一步利用了图域中深度学习和大数据的能力,因此在推荐系统、药物发现和组合优化中具有广泛的兴趣和应用。

这篇关于【阅读笔记】Bringing Your Own View: Graph Contrastive Learning without Prefabricated Data Augmentations的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!