本文主要是介绍新注意力!新主干!清华南开提出VAN:视觉注意力网络,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达、

作者:Menghao Guo | 已授权转载(源:知乎)

https://zhuanlan.zhihu.com/p/470850053

大家新年好哇,我来介绍我们最近期间做的一个工作啦。

该博文用于介绍我们最新的文章 :

Title : Visual Attention Network

Arxiv Link : https://arxiv.org/abs/2202.09741

Code Link :

https://github.com/Visual-Attention-Network

概述:

最近各种 vision transformer 层出不穷,迅速占领了计算机视觉中的各个领域,可能大家对 transformer 和 self-attention 已经审美疲劳了。这篇文章中提出了一种全新的针对于视觉任务的注意力机制 Large-Kernel Attention (完全不同于 self-attention),基于该注意力机制,我们提出了一种新的简单且有效的视觉主干网络 Visual Attention Network (VAN), 该网络在图像分类、目标检测和语义分割任务上均取得了不错的效果。

研究动机(motivation):

自注意力(self-attention)首先成功应用于自然语言处理领域。近来,在计算机视觉中也取得了非常显著的效果。我们这时候就考虑一个问题: 简单的将自然语言处理中的自注意力机制拿到计算机视觉中是否合理 ? 思考之后,我认为最少有三个不足之处:

自注意力擅长处理一维的序列结构,如果直接用于处理图像,会忽略图像自身的二维结构信息。

由于自注意力自身的复杂度问题,难以用于处理高分辨率图像。

自注意力机制仅仅考虑了空间上了自适应性,而忽略了通道维度上的自适应性(已经在 SENet 等网络中证明了通道注意力的重要性)。

自注意力机制也有自己的优点:

可以捕捉长距离依赖。

具有空间维度上的自适应性。

除了自注意力机制,我们认为卷积操作本身也有可取之处,比如可以充分利用图像的 2D 结构信息。有了这些思考之后,我们就想为计算机视觉专门设计一种注意力机制,而不是简单沿用自然语言处理中的自注意力机制。

本文专门为计算机视觉设计了一种新的注意力机制:大核注意力(Large-kernel Attention (LKA)),该方法吸收了自注意力和卷积操作的优点,并且避免了自注意力和卷积的不足。

下面正式开始介绍文章

注意力机制

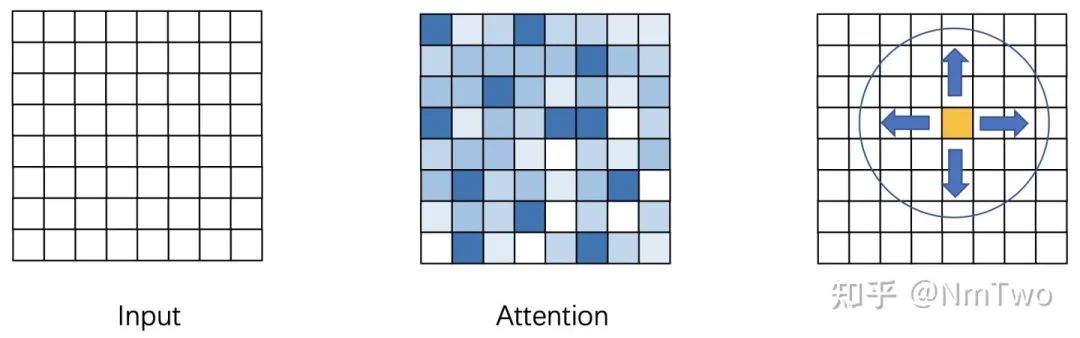

首先,说一下我理解的注意力机制。明确一点,自注意力机制是一种特殊的注意力机制,不是说自注意力机制就等于注意力机制。我理解的注意力机制是神经网络对可以自动关注到重要的区域,然后对重要的区域进行处理。注意力过程是一个自适应(动态)过程,根据输入去调节输出的过程。注意力机制大概可以分成两个过程: 1. 得到注意力图 (attention map) 的过程,2. 根据 attention map 对输入进行处理的过程。

大核注意力 (Large Kernel Attention)

那么 attention map 是什么呢 ?attention map 应该反映不同特征的重要程度。对于 SENet 来说,attention map 是一个 C 维向量,该向量反映了每个通道的重要程度。对于自注意力来说,每个点都有一个 H x W 的 attention map,这个 attention map 反映的是空间中每个点的重要程度。

那么如何判断一个点的重要程度呢 ?其实根据单个点的信息,你难以判断这个点重要还是不重要,你需要知道它周围点的信息你才可以进行判断,所以我们需要根据周围点的信息,点越多越好(long-range dependence)。

有两种常见的方式去捕捉长距离的依赖:

使用自注意力机制。我们在开篇的 motivation 中已经讲述了在视觉中使用自注意力机制的不足。

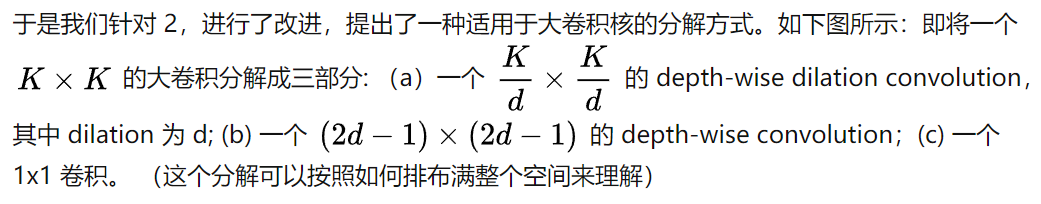

使用大核卷积来捕捉长距离依赖。使用该方法的不足在于,大卷积核的参数量和计算量太大,难以接受。

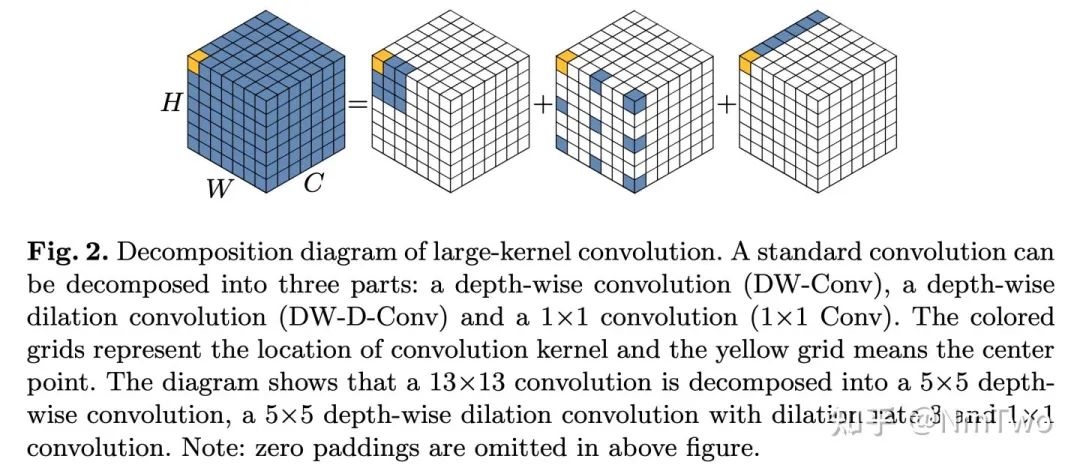

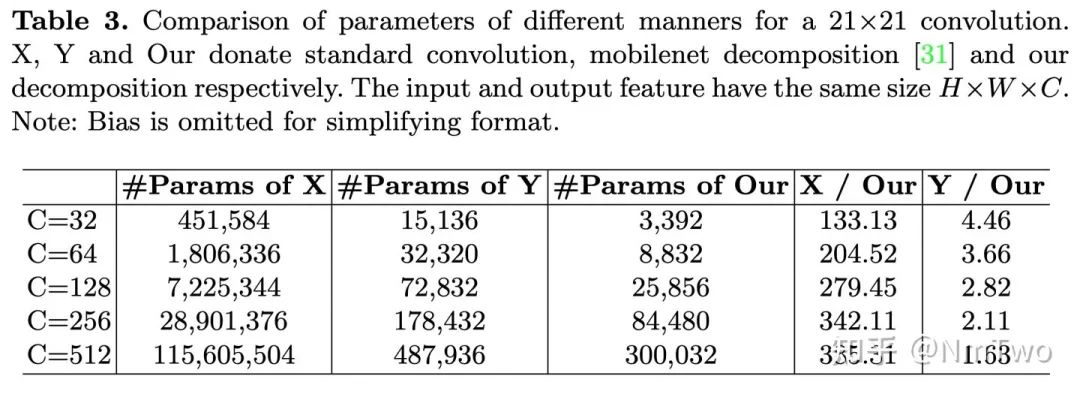

该分解,和 mobilenet 中的分解的不同在于,我们对空间进行了二次分解,这使得该方法更加适用于大核卷积的分解。本文默认选择使用 21 x 21 的卷积(我们认为这个足够大了),通过计算(列公式 + 求导)可以发现,按照我们的分解方式,分解一个 21 x 21 的卷积时候,d = 3 可以使得参数量和计算量最小。同时我们也对比了我们的分解方式与原始卷积 以及 mobilenet 分解方式的参数量和计算量对比,如下所示,可以发现我们在分解大卷积核(捕捉长距离依赖方面有着明显的优势)。

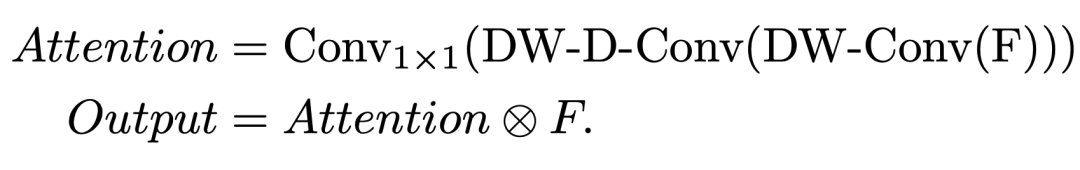

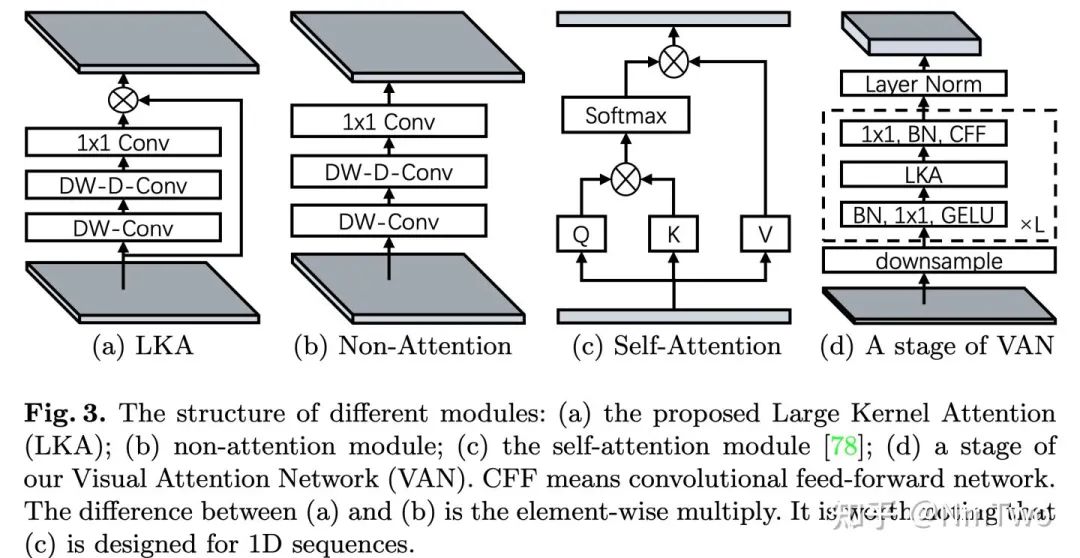

介绍完了分解,那我们现在给出我们 attention map 的实现方式,其实就是 Attention map = Conv(x) ,只不过,我们这里使用的 conv kernel 比较大,并对 conv 进行了分解,整体的注意力过程如下所示:

用图表示就是如下图(a)所示。

至此,我们介绍完了我们的新型注意力机制,注意,我们是希望设计一种针对计算机视觉的注意力机制,该机制要有 (a)局部性(b)长距离依赖(c)空间和通道维度的自适应性。

视觉注意力网络 Visual Attention Network (VAN)

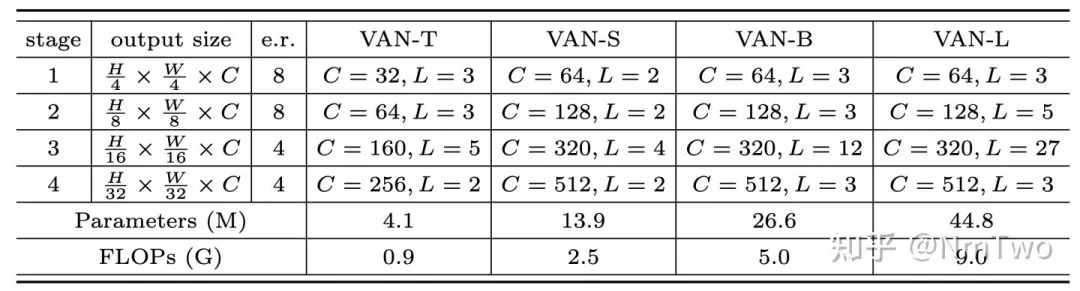

有了 Large kernel attention,我们就可以搭建一个新的基于注意力机制的视觉主干网络。我们使用了类似层次化 transformer 的结构,即 Attention - FFN 结构,具体结构如图 6 (d) 所示。我们给了四种不同大小的网络 (Tiny, Small, Base, Large),具体配置如下图所示。

至此,我们已经介绍完了我们的注意力机制 (LKA),以及所提出的视觉主干网络 (VAN),下面简单介绍下实验。

实验

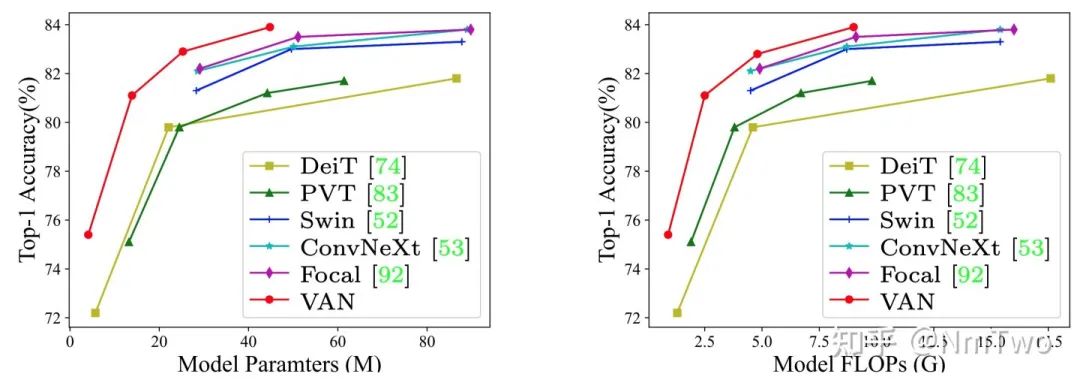

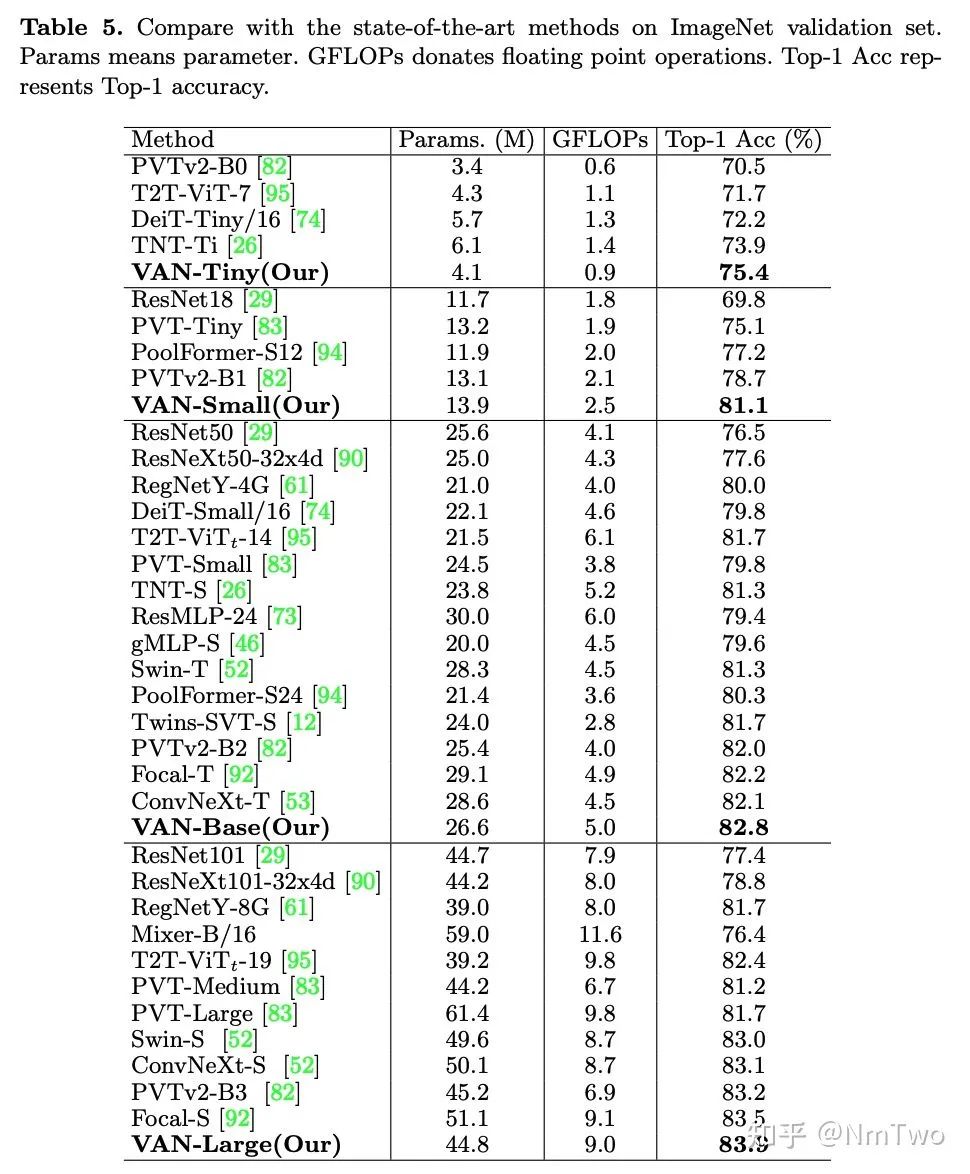

我们主要在图像分类、检测和分割上做了实验,并和 Swin Transformer 以及 ConvNeXt 进行了详尽的对比和分析,具体请看论文。这里仅展示分类实验结果和可视化结果。

分类结果 :

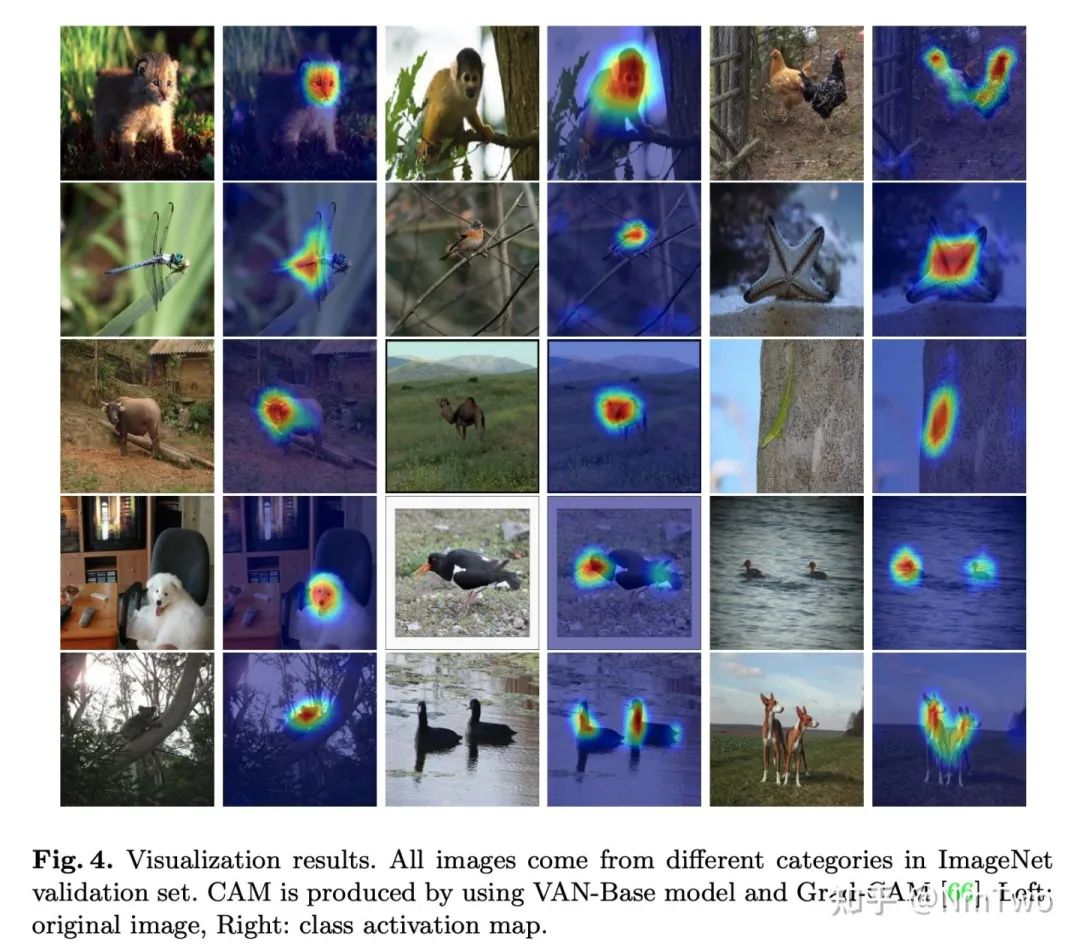

通过 Grad-CAM 进行可视化的结果:

最后,谢谢大家的阅读,代码已经开源,欢迎大家使用。

VAN论文和代码下载后台回复:VAN,即可下载上述论文和代码ICCV和CVPR 2021论文和代码下载后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

CVer-Transformer交流群成立

扫码添加CVer助手,可申请加入CVer-Transformer 微信交流群,方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲长按加小助手微信,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!▲扫码进群

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看这篇关于新注意力!新主干!清华南开提出VAN:视觉注意力网络的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!