本文主要是介绍Leveraging Implicit Relative Labeling-Importance Information for Effective Multi-Label Learning,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Leveraging Implicit Relative Labeling-Importance Information for Effective Multi-Label Learning

论文大纲:

- 背景

- 介绍RELIAB(相对标记重要性感知多标签学习)方法

- 实验分析

- 总结和未来的问题

1、背景:

多标签学习处理的是一个由单个实例表示的训练实例,同时又与多个类标签相关联,并且其任务是训练一个预测模型,该模型可以为未有标签的实例分配一组合适的标签。现有的方法都采用所有的标签重要性是一样的假设,即所有相关的标签都被认为与训练实例相关,而它们在描述其语义时的相对重要性没有区别。尽管如此,这种常见的假设并不能反映出每个相关标签的重要性程度通常是不同的,尽管重要性信息不能直接从训练实例中获取。在本文中,我们利用多重标记(RLI)来归纳隐含的预测信息,有助于证明该模型的相对重要性。具体地说,RLI度被形式化为标签空间上的多项式分布,可以通过全局标签传播过程或局部k近邻重构来估计。相应地,用估计的RLI度拟合模型输出,结合多标签经验损失正则化,得到多标签预测模型。大量的实验清楚地证明了利用隐含的RLI信息是有效的实现多标签学习的有利策略。

2、RELIAB方法介绍:

2.1标签相对重要性程度:

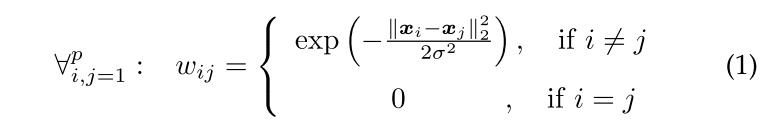

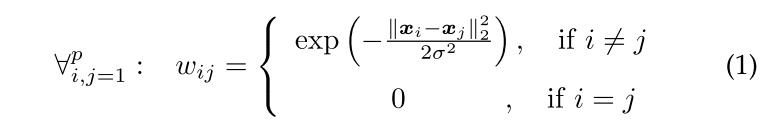

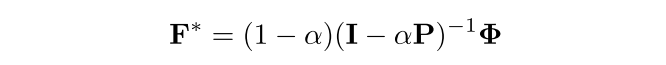

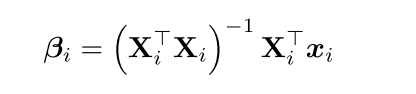

![]() 表是标签相对重要性的程度,其中yl ∈ Y(实例相关标签的集合),x表示实例,并且标签相对重要性程度只能从被给的多标签训练集中得到。

表是标签相对重要性的程度,其中yl ∈ Y(实例相关标签的集合),x表示实例,并且标签相对重要性程度只能从被给的多标签训练集中得到。

2.2对标签相对重要性程度的评估:

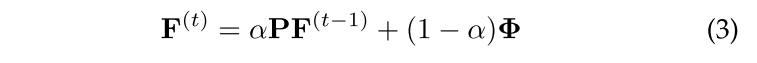

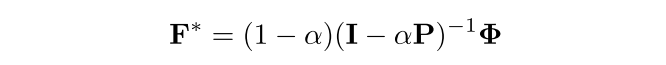

对标签相对重要性程度的评估简单有效的模型是全局标签传播过程或局部k近邻重建。

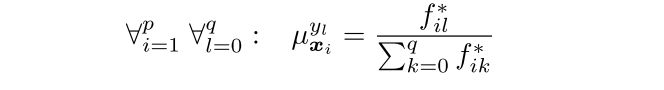

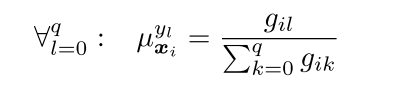

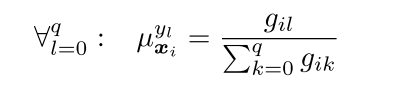

2.2.1 全局标签传播过程:

![]()

![]()

![]()

![]()

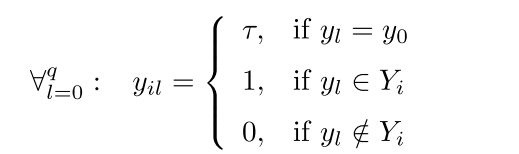

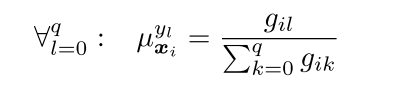

2.2.2 局部k近邻重建:

gi=![]()

2.3 The pseudo-code of RELIAB

3、实验分析

|S|:样本数量

dim(S):特征数量

L(S):标签类的数量

F(S):各类特征类

LCard(S):标签基数

LDen(S):标签密度

DL(S):不同的标签集

PDL(S): 不同标签集的比例

|

这些结果表明,RELIAB适用于多标签实例中相关标签具有内在相对标签重要性的问题。

4、总结和未来的问题

现有的方法通过假设相同的标签重要性从多个标签示例中学习,其中每个相关标签对学习过程的贡献是相等的。在这篇论文中,我们对我们先前的研究[22]进行了扩展,它利用了从训练示例中获得的隐式RLI信息来进行模型归纳。因此,我们提出了两种简单而有效的估计RLI度的策略,并进一步利用这些策略来建立具有经验损失正则化的多标签预测模型。比较研究验证了所提出的方法估计的RLI信息的质量,以及利用它们进行有效的多标签学习的好处。在未来,除了标签传播和knearest邻域技术外,探索其他的隐式RLI信息估计方法是很有意义的。此外,还需要进一步研究依赖于具有基本真实RLI信息的数据集在更高数量的类标签上估计RLI度的质量。

这篇关于Leveraging Implicit Relative Labeling-Importance Information for Effective Multi-Label Learning的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!