本文主要是介绍Learning the Extraction Order of Multiple Relational Facts in a Sentence with Reinforcement Learning,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Abstract

现有的方法中没有考虑到相关事实的提取和整理,多重关系提取任务尝试从句子中提取所有关系事实,本文认为提取顺序在此任务中至关重要,为了考虑提取顺序,文本将强化学习应用到Seq2Seq模型中,所提出的模型可以自由生成关系事实。

model

通过双向RNN对句子进行编码,再通过另一个RNN逐个生成三元组,当所有有效的三元组生成后,解码器将生成NA三元组。

在时间步长t中,需要三步生成三元组:

- t%3 =1:预测该关系

- t%2=2:复制第一个实体

- t%3=0:复制第二个实体

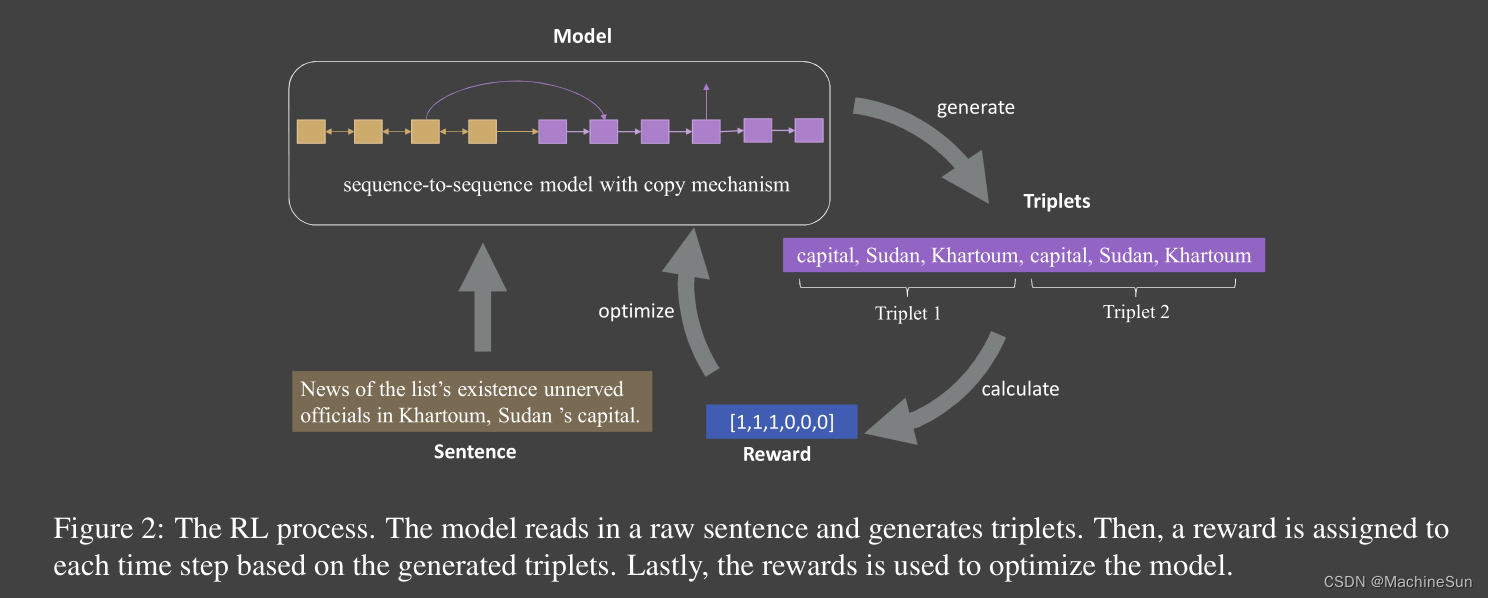

Reinforcement Learning Process

- state: s t = ( y ∧ < t , x , θ ) s_t=(\overset{\wedge}{y}^{<t},x,\theta) st=(y∧<t,x,θ)

- aciton: 该action是在每个时间步中预测的动作,在时间步t和t%3=1是,需要模型来确定三元组的关系;在t%3=2或0的时间步t中,需要模型来确定第一个或第二个实体,该实体是从源语句中复制的

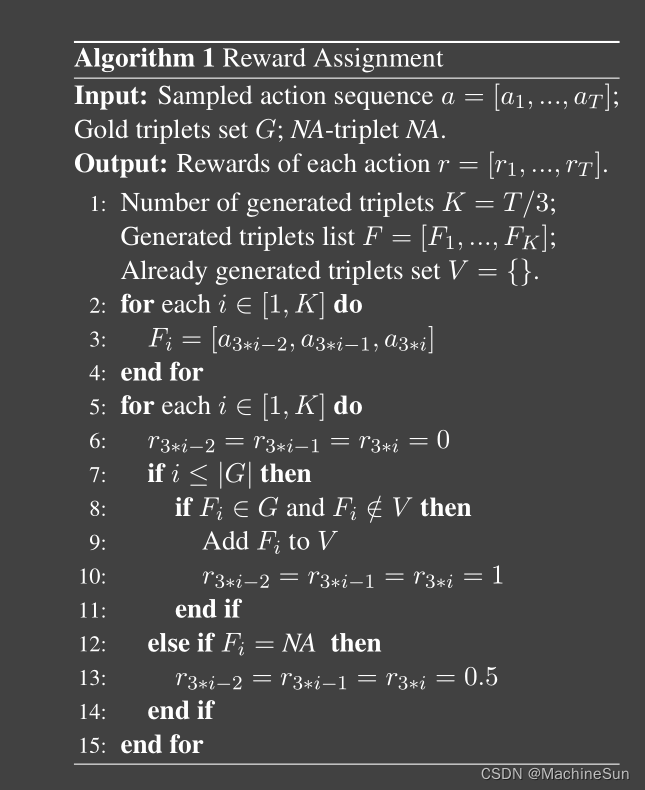

- reward:

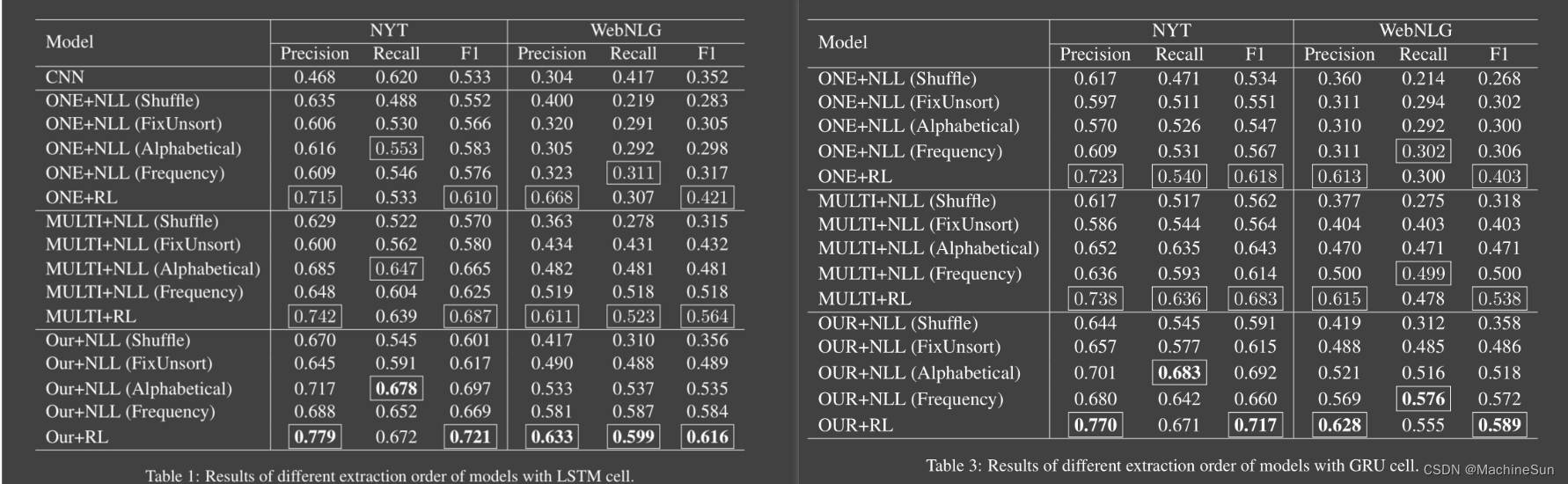

Result

启示

- 引入了强化学习,只可惜我不会,但是这个分数直接提升了十个点着实有点让人意想不到,有大佬可以看看接着往下做

这篇关于Learning the Extraction Order of Multiple Relational Facts in a Sentence with Reinforcement Learning的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!