本文主要是介绍使用Jetson AGX Orin进行口罩识别,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在 https://gitee.com/gpus/maskDetection_jetson 代码仓有个口罩识别的案例,我们来看看能不能在Jetson AGX Orin上搞定。

先将该代码仓fork到自己的代码仓(以便魔改)

回到自己的代码仓:

根据README.md来操作吧!

首先需要下载darknet框架并安装,但是众所周知,github不是很友好。

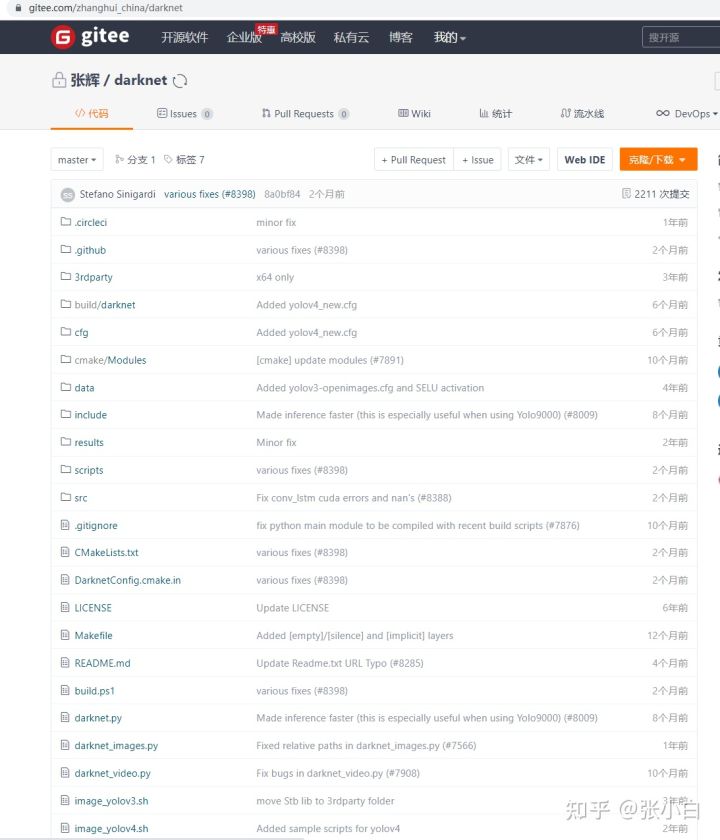

所以还是把 https://github.com/AlexeyAB/darknet 通过gitee来过渡:https://gitee.com/zhanghui_china/darknet

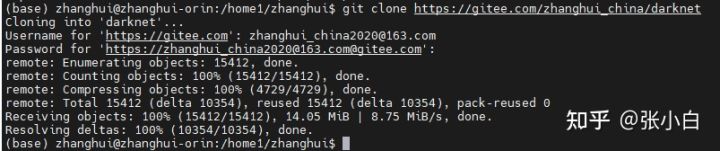

git clone https://gitee.com/zhanghui_china/darknet

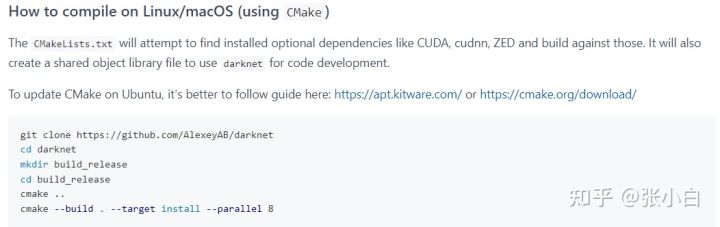

根据README

我们来操作:

cd darknet

mkdir build_release

cd build_release

cmake ..

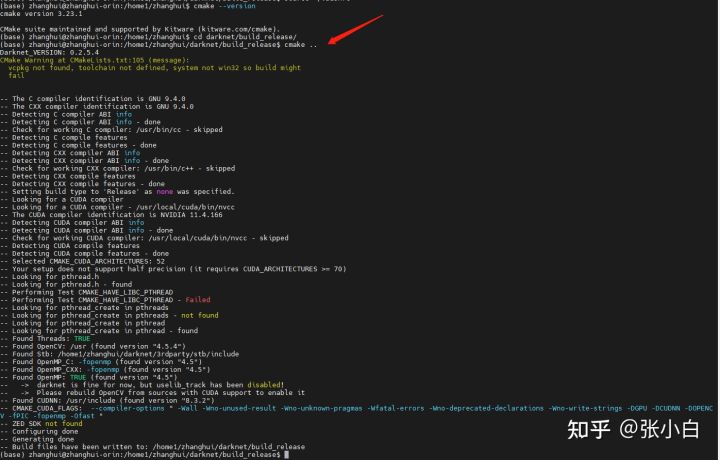

cmake的版本好像有点不够:

记得上次是装过cmake 3.23了。

那怎么回事呢?原来张小白上次整理存储,把/home/zhanghui下的很多东西都挪到/home/zhanghui1下面去了。

那就改一下.bashrc吧:

source ~/.bashrc

cmake --version

cd darknet/build_release/

cmake ..

cmake --build . --target install --parallel 12

...

成功完成安装。

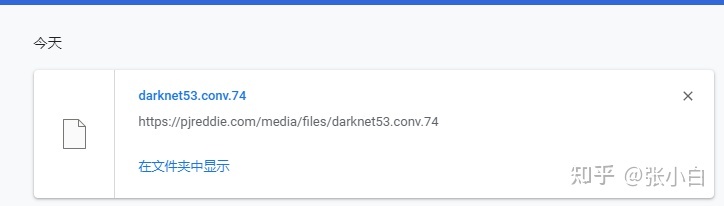

下载darknet53.conv.74模型:

wget https://pjreddie.com/media/files/darknet53.conv.74

由于这又不是一个好的URL,张小白只好再用其他方法下载:

然后使用MobaXterm传到Orin上去。

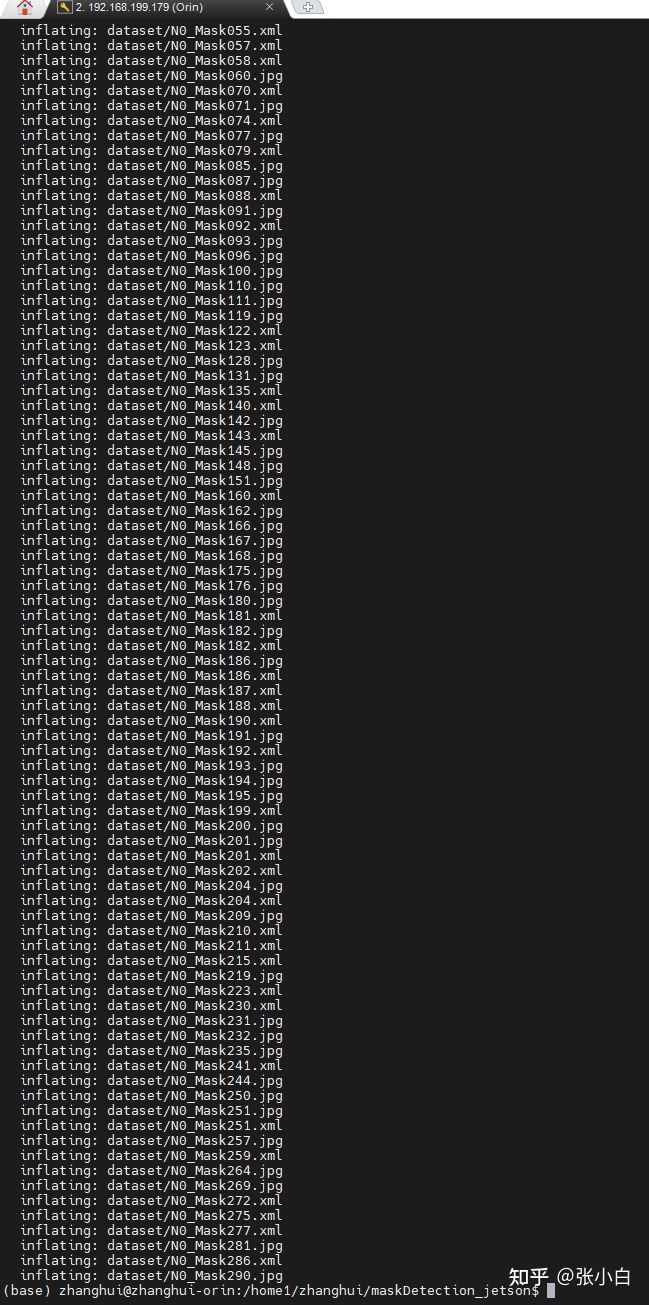

下载口罩识别工程:

git clone https://gitee.com/zhanghui_china/maskDetection_jetson

cd maskDetection_jetson

unzip dataset.zip

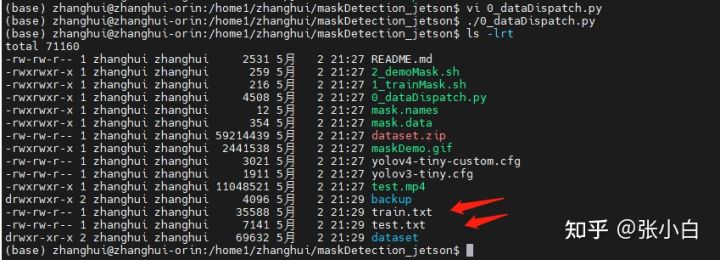

执行 ./0_dataDispatch.py

执行结果如下:

修改mask.data文件:

将每个文件或目录名改为真实的地址:

复制 /home1/zhanghui/darknet/cfg/yolov4-tiny-custom.cfg 到当前目录:

根据以下要求:

修改 yolov4-tiny-custom.cfg

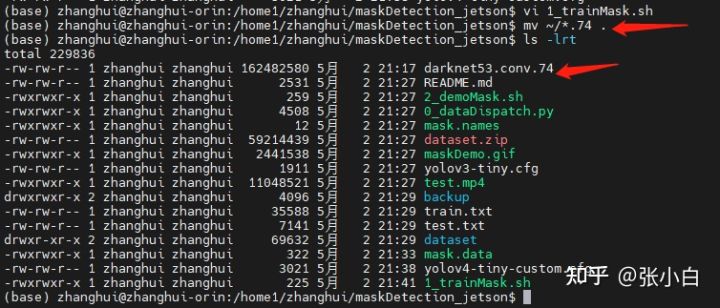

编辑 1_trainMask.sh

将前面下载的74文件移动到当前目录:

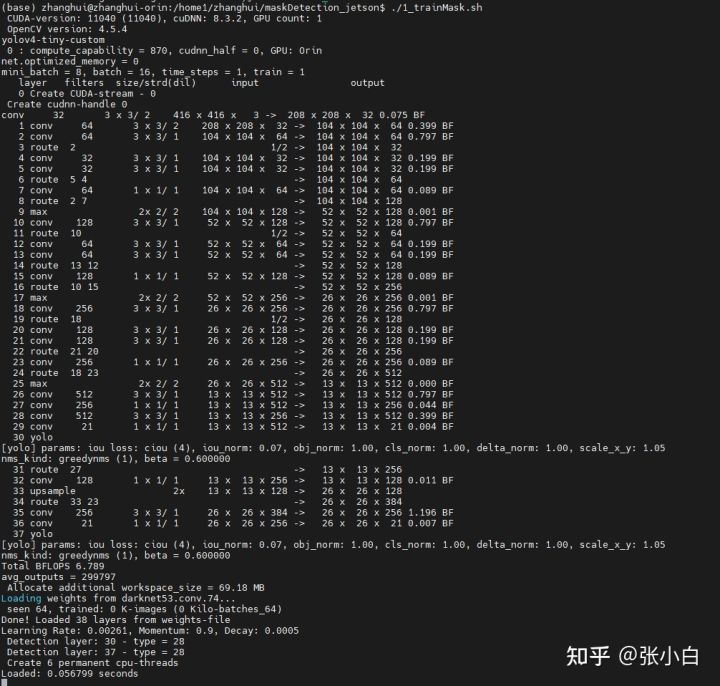

开始模型训练:

屏幕会闪很久:

据说Jetson Nano 4G会训练90分钟左右。

看看Orin到底需要训练多久:

在训练的过程中,Orin的风扇开始响了。前面都是静悄悄的干活。。。

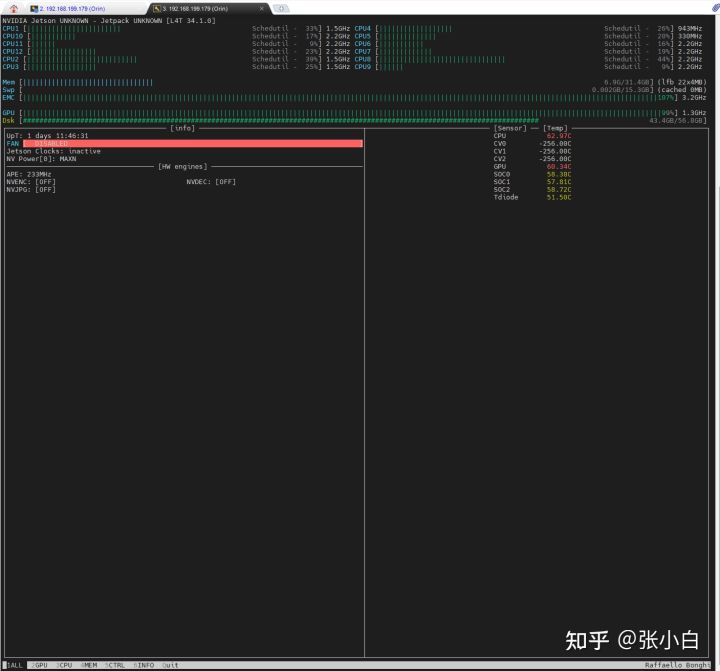

我们另开一个终端窗口,打开jtop看下使用情况:

ALL:

GPU:

CPU:

确实有12个CPU。

看来主要是GPU在跑。

跑完了。

其实时间也帮我算了:

real 13m19.088s

user 26m12.781s

sys 2m59.157s

现在GPU是休息了:

看来算力比Jetson Nano 4G大很多的结论是没跑的了。(等有空把这些骚操作在我的Jetson Nano B01上试一下——你这个喜新厌旧的张小白。。。)

cp yolov4-tiny-custom.cfg yolov4-tiny-custom.cfg.train

再按照下面的指引:

修改yolov4-tiny-custom.cfg的参数:

像上图那样打开注释,增加注释即可。

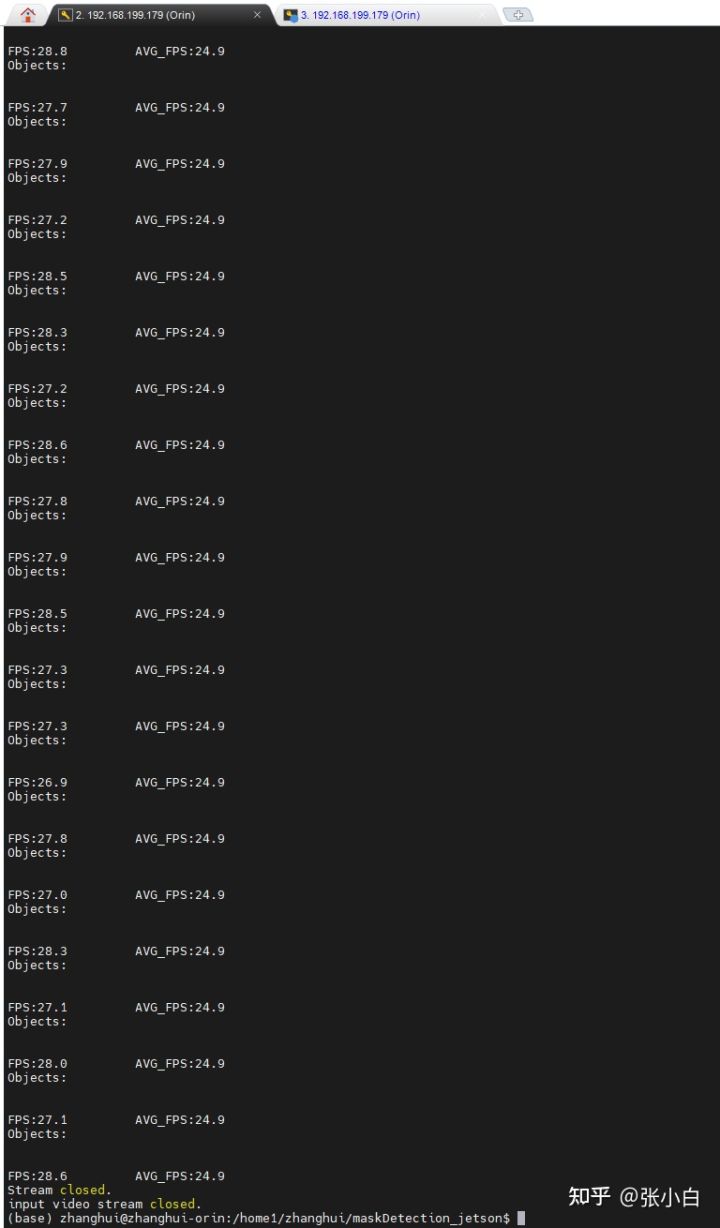

修改推理代码 2_demoMask.sh

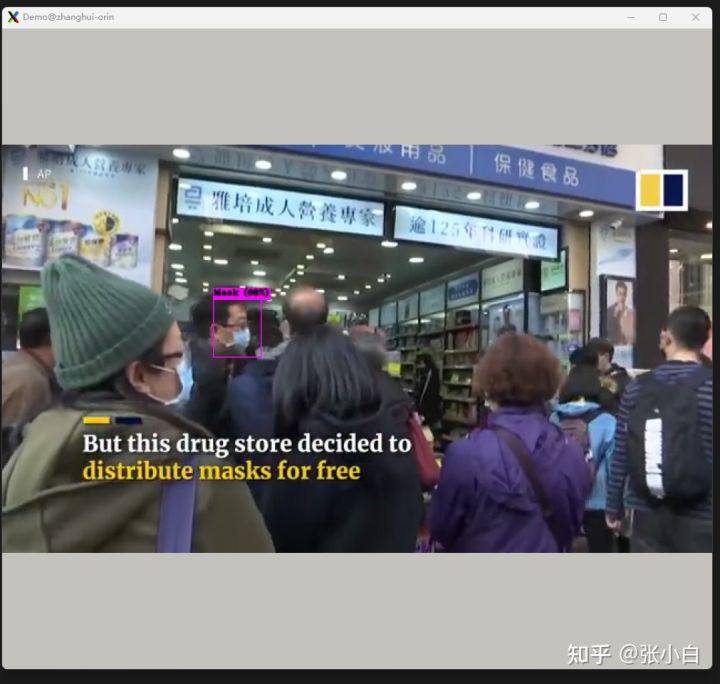

先用本地test试一下吧:

./2_demoMask.sh

由于MobaXterm的加持,图形界面显示到了Windows中:

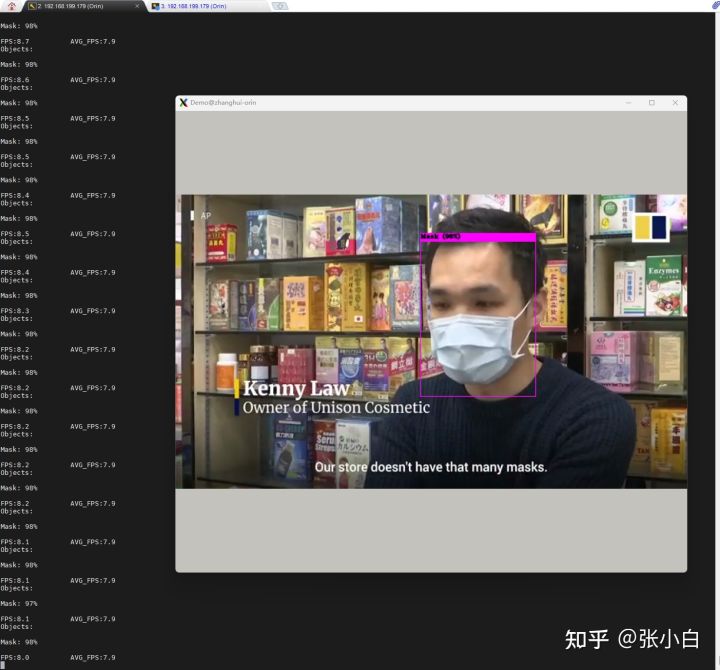

从测试视频上来看,正面戴口罩识别率较好,侧脸识别率略差。也有误识别的情况:

你对着一个口罩识别它没有戴口罩是几个意思?

当然,也可以识别出人没有戴口罩:

识别完毕!

下次等张小白搞定了摄像头后,再来看下Jetson AGX Orin能否用摄像头识别有没有戴口罩。

(全文完,谢谢阅读)

这篇关于使用Jetson AGX Orin进行口罩识别的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!