本文主要是介绍大模型训练核心算法之——损失函数算法,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

“ 损失函数是实现大模型训练的基础”

今天就来介绍一下大模型训练的一个核心算法——损失函数算法。

大模型正是利用损失差和反向传播算法来更新模型参数的权重,依此达到最优化模型参数的目的,而这也直接关系到大模型的推测效果。

大模型损失函数计算

损失函数是机器学习与深度学习中用于衡量模型预测与实际结果之间差距的函数;选择合适的损失函数对于训练模型的性能至关重要。

以下从技术原理,实现等多个方面介绍损失函数:

原理

损失函数是一个衡量模型预测与实际结果之间差异的函数,它输出的通常是一个标量,表示预测结果的误差大小;目标是最小化损失函数的值,从而提高模型的预测性能。

作用

模型训练:损失函数用来指导模型的训练过程,通过优化算法调整模型参数,以降低预测误差

性能评价:损失函数的值可以用于评价模型性能

优化目标

优化目标是通过梯度下降或其它优化算法最小化损失函数,从而找到模型参数的最优解

实现

损失函数类型

-

回归问题:

-

-

均方误差(Mean Squared Error, MSE):

L(y,y)=1N∑i=1N(yi−yi)2

其中 yiyi 是实际值,yiyi 是预测值,NN 是样本数。MSE对较大误差较为敏感。

-

均绝对误差(Mean Absolute Error, MAE):

L(y,y)=1N∑i=1N∣yi−yi∣

MAE对异常值的敏感度较低。

-

-

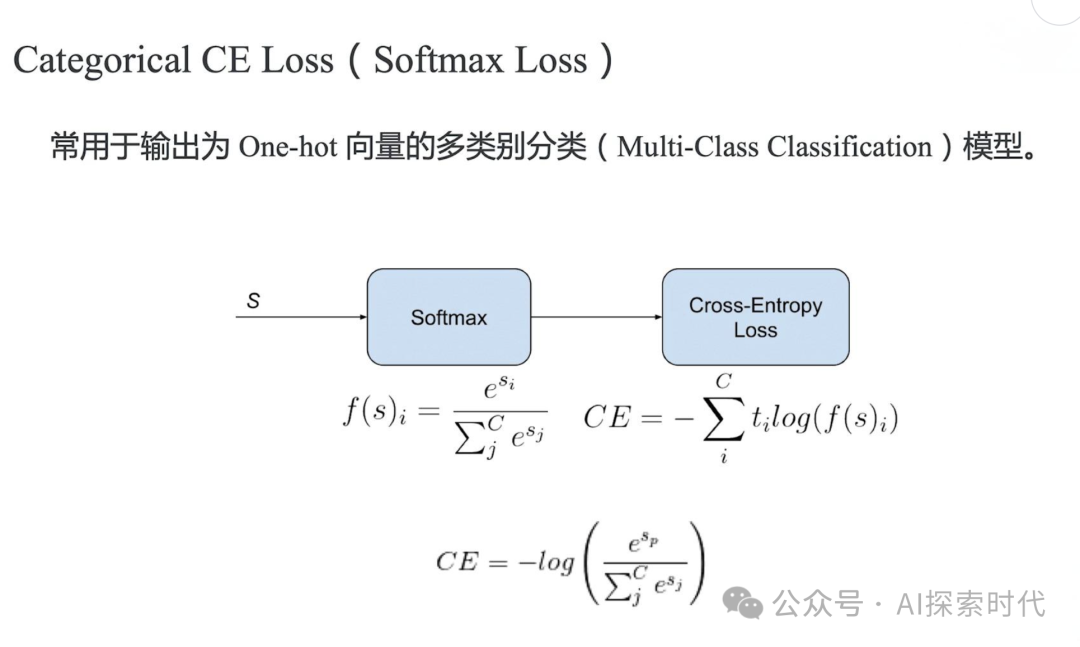

分类问题:

-

-

交叉熵损失(Cross-Entropy Loss):

L(y,y)=−∑i=1Nyilog(yi)

其中 yiyi 是实际类别的标签(通常是独热编码),yiyi 是预测概率。交叉熵损失在分类问题中广泛使用,尤其是多类分类。

-

对数损失(Log Loss):

L(y,y)=−[ylog(y)+(1−y)log(1−y^)]

用于二分类问题,其中 yy 是实际标签(0或1),yy 是预测概率。

-

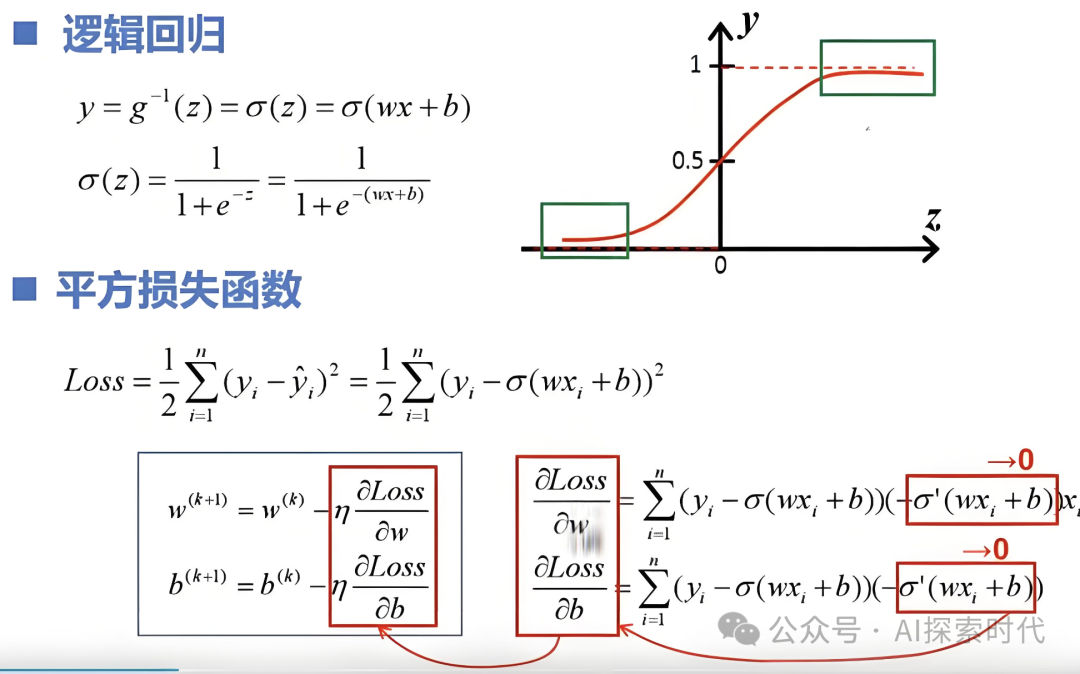

计算过程

前向传播:计算模型预测值

损失计算:将预测值与实际标签带入损失函数,计算损失值

反向传播:通过链式法则计算损失函数相对于模型参数的梯度,指导参数更新

技术细节

梯度计算

链式法则:用于计算损失函数对每个模型参数的梯度,在反向传播过程中,通过链式法则将损失函数的梯度逐层传播到网络的每个参数

示例:对均方差损失函数的梯度计算

数值稳定性

- 避免对数函数中的零:在计算交叉熵损失时,预测概率可能为零,导致对数函数的计算不稳定。通常采用平滑处理,如 log(y+ϵ)log(y+ϵ),其中 ϵϵ 是一个小常数(如 1e−101e−10)。

- 标准化:对输入数据进行标准化,以提高数值计算的稳定性和收敛速度。

选择损失函数

- 根据任务选择:根据具体的任务(回归、分类、排序等)选择合适的损失函数。例如,回归任务通常使用均方误差,分类任务通常使用交叉熵损失。

- 损失函数的鲁棒性:根据数据特征选择适合的损失函数。例如,当数据中存在较多异常值时,可以选择对异常值不敏感的损失函数,如均绝对误差。

优化算法

- 梯度下降算法:常用的优化算法有批量梯度下降(BGD)、随机梯度下降(SGD)和小批量梯度下降(Mini-Batch SGD)。

- 高级优化算法:如动量法、RMSprop、Adam等,这些算法通过调整学习率和引入动量,能够加速收敛和提高训练效果。

实现细节

- 框架支持:现代深度学习框架(如 TensorFlow、PyTorch)提供了丰富的损失函数实现,并自动计算梯度。使用这些框架可以简化损失函数的实现和计算过程。

- 自定义损失函数:在需要特殊损失函数时,可以根据任务要求自定义损失函数。这通常涉及定义损失函数的计算过程并确保其可导性。

总结

损失函数是机器学习模型训练过程中的关键组成部分,它衡量模型预测的准确性并指导模型参数的优化。理解损失函数的原理、实现和技术细节对于成功训练和优化模型至关重要。选择合适的损失函数、计算梯度、处理数值稳定性问题以及使用优化算法,都是提高模型性能的重要步骤。

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。

这篇关于大模型训练核心算法之——损失函数算法的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!