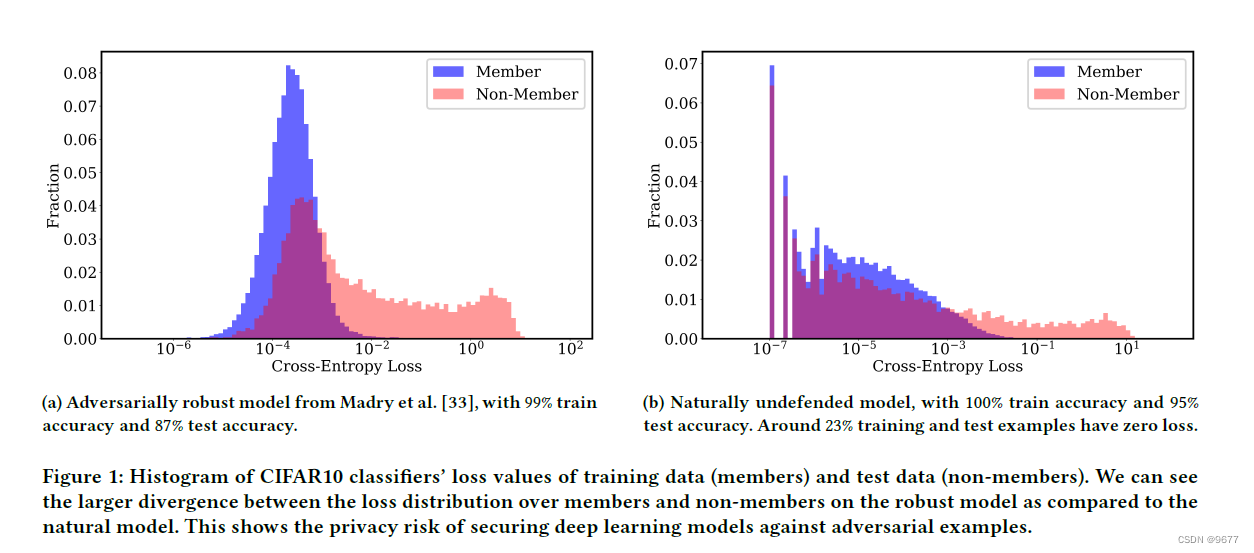

本文主要是介绍the histogram of cross-entropy loss values 交叉熵损失值的直方图以及cross-entropy loss交叉熵损失,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

交叉熵损失值的直方图在机器学习和深度学习中有几个重要的作用和用途:

-

评估模型性能: 直方图可以帮助评估模型在训练数据和测试数据上的性能。通过观察损失值的分布,可以了解模型在不同数据集上的表现情况。例如,损失值分布的形状和范围可以反映模型对训练数据的拟合程度以及在测试数据上的泛化能力。

-

检测过拟合和欠拟合: 直方图可以显示训练数据和测试数据的损失值分布是否存在偏差。过拟合情况下,模型在训练数据上表现良好(低损失),但在测试数据上表现较差(高损失),这种情况可以在直方图中得到体现。相反,欠拟合情况下,模型在训练和测试数据上的损失值都可能较高。

-

对比不同模型: 直方图可以用于比较不同模型在相同数据集上的损失值分布。通过比较直方图的形状、峰值位置和分布情况,可以帮助确定哪个模型在训练和测试数据上表现更好或更稳健。

-

调整模型参数: 观察损失值的直方图可以帮助数据科学家和机器学习工程师调整模型的超参数和训练策略。例如,如果发现训练数据和测试数据的损失值分布差异较大,可能需要调整模型的复杂度或者应用正则化方法来改善模型的泛化能力。

总之,交叉熵损失值的直方图是评估和理解深度学习模型性能的重要工具,通过损失值的分布特征可以帮助指导模型优化和改进策略的制定。

Cross-entropy loss(交叉熵损失)

是在机器学习和深度学习中常用的一种损失函数,特别是在分类任务中广泛应用。它衡量了两个概率分布之间的差异性,通常用于衡量模型预测与实际标签之间的差异。

定义和用途

交叉熵损失通常用于多类别分类问题,其定义如下:

假设有一个分类任务,输入数据样本为 ( \mathbf{x}i ),对应的真实标签为 ( \mathbf{y}i ),模型的预测概率分布为 ( \mathbf{p}i = (p{i1}, p{i2}, \ldots, p{iC}) ),其中 ( C ) 是类别数目。则交叉熵损失定义为:

[ \text{CE}(\mathbf{y}i, \mathbf{p}i) = -\sum{c=1}^{C} y{ic} \log(p_{ic}) ]

其中,( y_{ic} ) 是真实标签 ( \mathbf{y}i ) 在第 ( c ) 类别上的概率(通常为0或1),( p{ic} ) 是模型预测的第 ( c ) 类别的概率。

特点和优势

-

适用性: 交叉熵损失特别适用于多类别分类问题,尤其是在神经网络的 softmax 层后面用作损失函数。

-

概率解释: 通过最小化交叉熵损失,模型更倾向于预测正确类别的概率接近于1,而错误类别的概率接近于0。

-

梯度计算: 交叉熵损失的梯度相对简单,对于神经网络的反向传播(backpropagation)算法来说效率高。

示例

假设有一个3类分类任务,真实标签为第2类(one-hot 编码为 [0, 1, 0]),模型预测的概率分布为 [0.3, 0.6, 0.1]。则交叉熵损失计算如下:

[ \text{CE}([0, 1, 0], [0.3, 0.6, 0.1]) = - (0 \cdot \log(0.3) + 1 \cdot \log(0.6) + 0 \cdot \log(0.1)) ]

[ \text{CE}([0, 1, 0], [0.3, 0.6, 0.1]) = - \log(0.6) ]

结论

交叉熵损失是一种常用且有效的损失函数,广泛应用于分类任务中,特别是在神经网络训练中。它不仅能够衡量预测和实际标签之间的差异,还能够推动模型向正确的方向进行学习和优化。

如果横坐标是交叉熵损失,纵坐标是 fraction(分数或比例),通常表示的是在某个损失值区间内的样本所占的比例。这种图表可以帮助我们理解模型在不同损失值范围内的样本分布情况。

这篇关于the histogram of cross-entropy loss values 交叉熵损失值的直方图以及cross-entropy loss交叉熵损失的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!