本文主要是介绍QLoRA:高效的LLMs微调方法,48G内存可调65B 模型,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章:https://arxiv.org/pdf/2305.14314.pdf

代码:https://github.com/artidoro/qlora

概括

QLORA是一种有效的微调方法,它减少了内存使用,足以在单个48GB GPU上微调65B参数模型,同时保留完整的16位微调任务性能。QLORA通过冻结的4位量化预训练语言模型将梯度反向传播到低秩适配器(Low Rank Adapters, LoRA)。Guanaco模型在Vicuna基准上优于之前所有公开发布的模型,达到ChatGPT性能水平的99.3%,而只需要在单个GPU上进行24小时的微调。使用QLORA对1000多个模型进行了微调,提供了8个指令数据集、多种模型类型(LLaMA、T5)和常规微调无法运行的模型规模(例如33B和65B参数模型)上的指令跟随和聊天机器人性能的详细分析。结果表明,即使使用比以前的SoTA更小的模型,在小的高质量数据集上进行QLoRA微调也可以得到最先进的结果。

一句话总结:基于LoRA微调技术引入深度量化,在不损失模型精度的前提下加大的降低了训练成本。

微调原理与创新点

引入三个创新点

(a) 4位NormalFloat (NF4),这是一种新的数据类型,理论上对正态分布权重是最优的;比4位整数和4位浮点数产生更好的经验结果。

(b) 双量化,通过量化常量来减少平均内存占用;每个参数平均节省约0.37比特(65B型号约为3gb)。

© 分页优化器,使用NVIDIA统一内存,以避免处理具有长序列长度的小批量时发生的梯度检查点内存峰值。

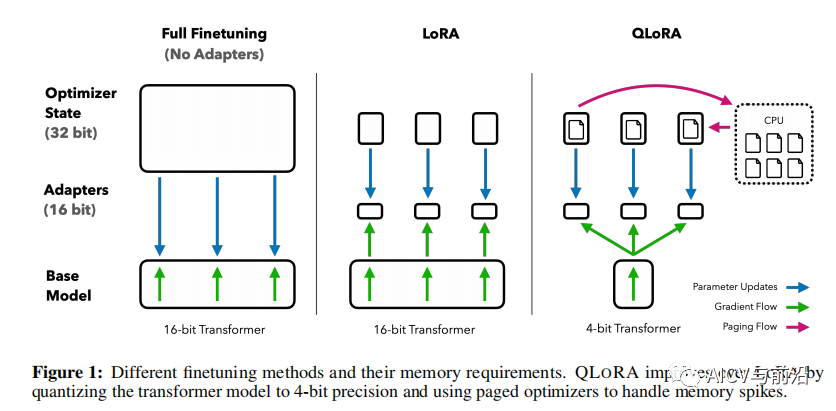

不同的调优方法及其内存需求。QLORA通过将转换器模型量化到4位精度并使用分页优化器处理内存峰值来改进LoRA。

QLORA包含两个组件:4-bit NormalFloat量化和Double Quantization。其中:4-bit NormalFloat数据类型是基于Quantile Quantization技术开发的,通过估计输入张量的分位数来保证每个量化区间分配相等的值。Double Quantization是将额外的量化常数进行量化以减小内存开销的过程。为了防止梯度检查点所引起的内存波动导致的内存不足错误,QLORA引入了Paged Optimizers技术。这种技术使用了NVIDIA统一内存的特性,实现了CPU和GPU之间自动的页面转换,在GPU内存不足的情况下自动将优化器状态转移到CPU内存。QLORA通常使用4位NormalFloat作为存储数据类型和16位BrainFloat作为计算数据类型,在计算梯度时只对LoRA的参数计算梯度。

实验结果

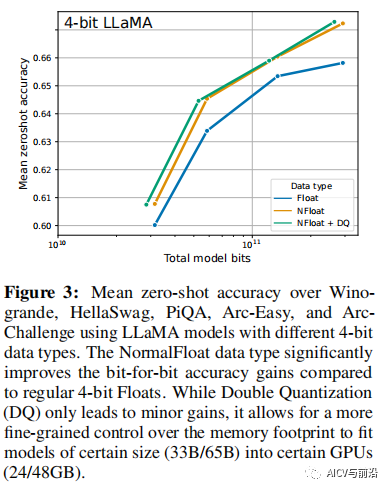

使用不同4位数据类型的LLaMA模型,在Winogrande, HellaSwag, PiQA, Arc-Easy和ArcChallenge上的平均zero-shot精度。**与常规的4位浮点数相比,NormalFloat数据类型显著提高了逐位精度增益。**虽然双量化(DQ)只带来很小的收益,它允许对内存占用进行更细粒度的控制,以适应特定大小(33B/65B)的模型到特定的gpu (24/48GB)。

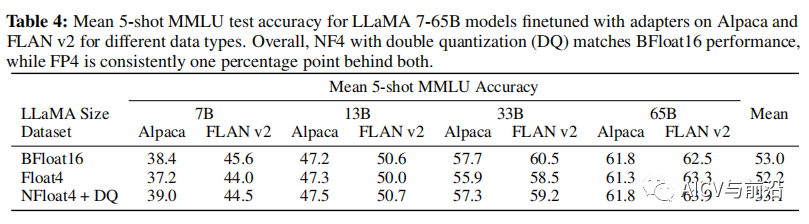

在Alpaca和FLAN v2上对不同数据类型的适配器进行微调后,LLaMA 7-65B模型的平均5次MMLU测试精度。总体而言,具有双量化(DQ)的NF4与BFloat16性能相当,而FP4始终比两者落后一个百分点。

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。

这篇关于QLoRA:高效的LLMs微调方法,48G内存可调65B 模型的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!