qlora专题

[论文笔记]QLoRA: Efficient Finetuning of Quantized LLMs

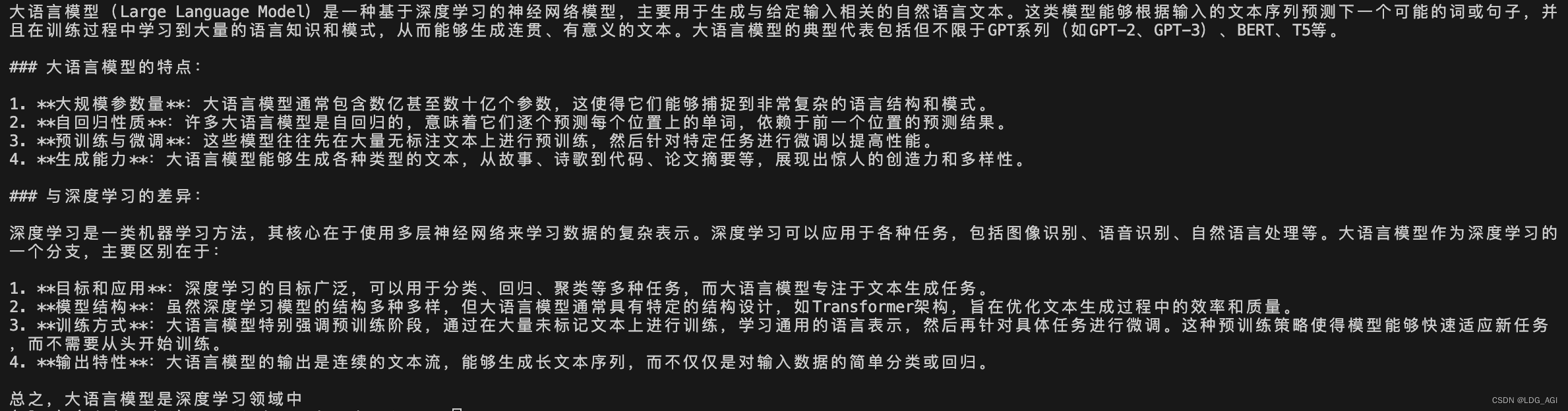

引言 今天带来LoRA的量化版论文笔记——QLoRA: Efficient Finetuning of Quantized LLMs 为了简单,下文中以翻译的口吻记录,比如替换"作者"为"我们"。 我们提出了QLoRA,一种高效的微调方法,它在减少内存使用的同时,能够在单个48GB GPU上对65B参数的模型进行微调,同时保持16位微调任务的完整性能。QLoRA通过一个冻结的4位量化预

欺诈文本分类微调(十):QLora量化微调

1. 引言 前文微调方法概览总结了微调的各种方法,并且在更前面两篇文章Lora单卡训练 和 lora单卡二次调优中已经尝试过用Lora进行微调,本文出于好奇准备尝试下用QLora进行微调的效果。 QLoRA是一种新的微调大型语言模型(LLM)的方法,它的特点是能在节省内存的同时保持推理性能。它的出现是为了应对大型模型微调时内存需求大,成本昂贵的问题。 工作原理:首先将LLM进行4位量化,从而

神经网络微调技术全解(01)-不同的微调方法如PEFT、SFT、LoRa、QLoRa等,旨在解决不同的问题和挑战

微调技术在深度学习和大模型的应用中起到了关键作用。不同的微调方法如PEFT、SFT、LoRa、QLoRa等,旨在解决不同的问题和挑战。以下是它们的简介及各自解决的问题。 1. PEFT (Parameter-Efficient Fine-Tuning) 问题:在处理大规模预训练模型时,全面微调所有参数会消耗大量计算资源和存储空间。对于一些特定任务,全面微调可能不必要,并且可能导致过拟合。

QLoRA:高效的LLMs微调方法,48G内存可调65B 模型

文章:https://arxiv.org/pdf/2305.14314.pdf代码:https://github.com/artidoro/qlora 概括 QLORA是一种有效的微调方法,它减少了内存使用,足以在单个48GB GPU上微调65B参数模型,同时保留完整的16位微调任务性能。QLORA通过冻结的4位量化预训练语言模型将梯度反向传播到低秩适配器(Low Rank Adapter

【机器学习】QLoRA:基于PEFT亲手微调你的第一个AI大模型

目录 一、引言 二、量化与微调—原理剖析 2.1 为什么要量化微调? 2.2 量化(Quantization) 2.2.1 量化原理 2.2.2 量化代码 2.3 微调(Fine-Tuning) 2.3.1 LoRA 2.3.2 QLoRA 三、量化与微调—实战演练:以Qwen2为例,亲手微调你的第一个AI大模型 3.1 模型预处理—依赖安装、库包导入、模型下载 3

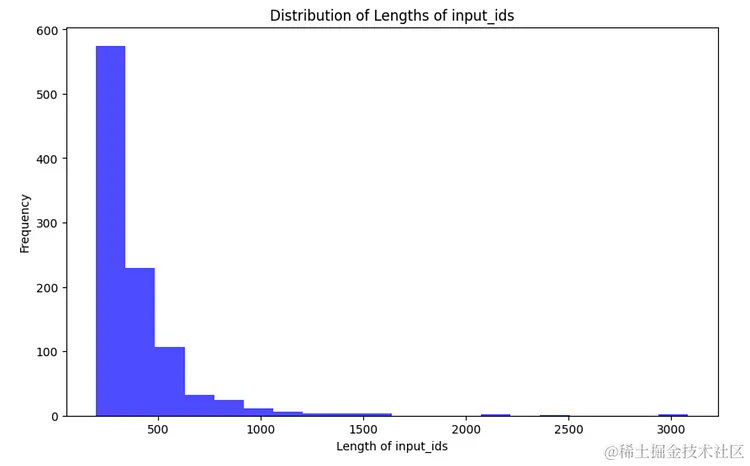

使用QLoRA在自定义数据集上finetuning 大模型 LLAMA3 的数据比对分析

概述: 大型语言模型(LLM)展示了先进的功能和复杂的解决方案,使自然语言处理领域发生了革命性的变化。这些模型经过广泛的文本数据集训练,在文本生成、翻译、摘要和问答等任务中表现出色。尽管LLM具有强大的功能,但它可能并不总是与特定的任务或领域保持一致。 什么是LLM微调? 微调LLM涉及对预先存在的模型进行额外的训练,该模型之前使用较小的特定领域数据集从广泛的数据集中获取了模式和特征。在“L

AI大模型探索之路-训练篇17:大语言模型预训练-微调技术之QLoRA

系列篇章💥 AI大模型探索之路-训练篇1:大语言模型微调基础认知 AI大模型探索之路-训练篇2:大语言模型预训练基础认知 AI大模型探索之路-训练篇3:大语言模型全景解读 AI大模型探索之路-训练篇4:大语言模型训练数据集概览 AI大模型探索之路-训练篇5:大语言模型预训练数据准备-词元化 AI大模型探索之路-训练篇6:大语言模型预训练数据准备-预处理 AI大模型探索之路-训练篇7:大语言模型

Trl SFT: llama2-7b-hf使用QLora 4bit量化后ds zero3加上flash atten v2单机多卡训练(笔记)

目录 一、环境 1.1、环境安装 1.2、安装flash atten 二、代码 2.1、bash脚本 2.2、utils.py 注释与优化 2.3、train.py 注释与优化 2.4、模型/参数相关 2.4.1、量化后的模型 2.4.1.1 量化后模型结构 2.4.1.2 量化后模型layers 2.4.2

Trl: llama2-7b-hf使用QLora 4bit量化后ds zero3加上flash atten v2单机多卡训练(笔记)

目录 一、环境 1.1、环境安装 1.2、安装flash atten 二、代码 2.1、bash脚本 2.2、utils.py 注释与优化 2.3、train.py 注释与优化 2.4、模型/参数相关 2.4.1、量化后的模型 a) 量化后模型结构 b) 量化后模型layers 2.4.2、参数

QLoRa 低秩分解+权重量化的微调

QLoRa的核心思想是首先使用低秩分解技术降低参数的数量,然后对这些低秩表示的参数应用量化技术,进一步减少所需的存储空间和计算量。 https://arxiv.org/abs/2305.14314 低秩分解 低秩分解(Low-Rank Factorization):通过将模型中的权重矩阵分解为更小的矩阵乘积,减少模型中的参数数量。 参看:LoRA 微调和低秩矩阵 类似下图,4×5

使用 QLoRA 在 Google Colab 中微调 Mistral 7b(完整指南)

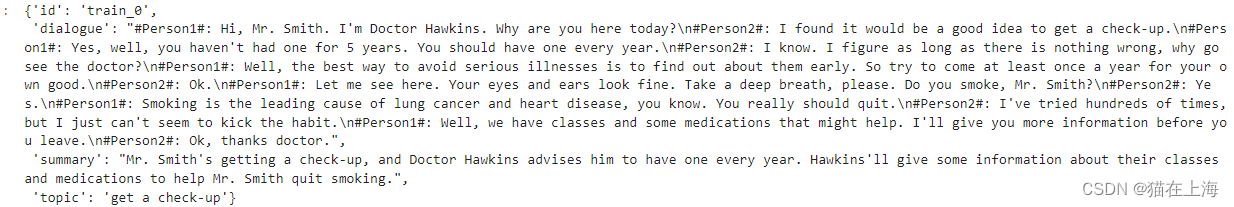

使用 QLoRA 在 Google Colab 中微调 Mistral 7b(完整指南) 在本文中,我们将在一个名为 Enlighten 的游戏的整个代码库上微调 Mistral 7b,所有这些都在 Google Colab(或 Kaggle)中免费提供合成数据。在我们的基准测试中,由此产生的模型将优于 Openai 的 GPT-4。 步骤如下: 将代码库转换为基于合成对话的训练测试数据

使用LoRA和QLoRA微调LLMs:数百次实验的见解

前言 翻译文章《Finetuning LLMs with LoRA and QLoRA: Insights from Hundreds of Experiments》原文地址因译者水平有限,翻译过程中有错误请在评论区指出 提要 LoRA是用于训练自定义LLM的最广泛使用、参数效率最高的微调技术之一。从使用QLoRA节省内存到选择最佳 LoRA设置,本文为有兴趣应用它的人提供了实用的见解。

MoE模型性能还能更上一层楼?一次QLoRA微调实践

Fine-Tuning Mixtral 8x7B with QLoRA:Enhancing Model Performance 🚀 编者按:最近,混合专家(Mixture of Experts,MoE)这种模型设计策略展现出了卓越的语言理解能力,如何在此基础上进一步提升 MoE 模型的性能成为业界热点。 本文作者使用一种名为 QLoRA 的方法,通过量化和 LoRA 技术对 MoE 模型 M

QLoRA实战 | 使用单卡高效微调bloom-7b1,效果惊艳

来自:YeungNLP 进NLP群—>加入NLP交流群 在文章Firefly(流萤): 中文对话式大语言模型、中文对话式大语言模型Firefly-2b6开源,使用210万训练数据中,我们介绍了关于Firefly(流萤)模型的工作。对大模型进行全量参数微调需要大量GPU资源,所以我们通过对Bloom进行词表裁剪,在4*32G的显卡上,勉强训练起了2.6B的firefly模型。 在本文中,我们将介绍

用 bitsandbytes、4 比特量化和 QLoRA 打造亲民的 LLM

众所周知,LLM 规模庞大,如果在也能消费类硬件中运行或训练它们将是其亲民化的巨大进步。我们之前撰写的 LLM.int8 博文 展示了我们是如何将 LLM.int8 论文 中的技术通过 bitsandbytes 库集成到 transformers 中的。在此基础上,我们不断努力以不断降低大模型的准入门槛。在此过程中,我们决定再次与 bitsandbytes 联手,支持用户以 4 比特精度运行任何

LLM高效参数微调方法:从Prefix Tuning、Prompt Tuning、P-Tuning V1/V2到LoRA、QLoRA(含对模型量化的解释)

前言 学过大模型的都知道,PEFT 方法仅微调少量(额外)模型参数,同时冻结预训练 LLM 的大部分参数,比如Prefix Tuning、P-Tuning V1/V2、LoRA、QLoRA,其实网上介绍这些微调方法的文章/教程不少了,我也看过不少,但真正写的一目了然、一看就懂的还是少,大部分文章/教程差点意思 总之,把知识写清楚、讲清楚并不容易,比如“把知识写清楚”的这个能力 我从2010年

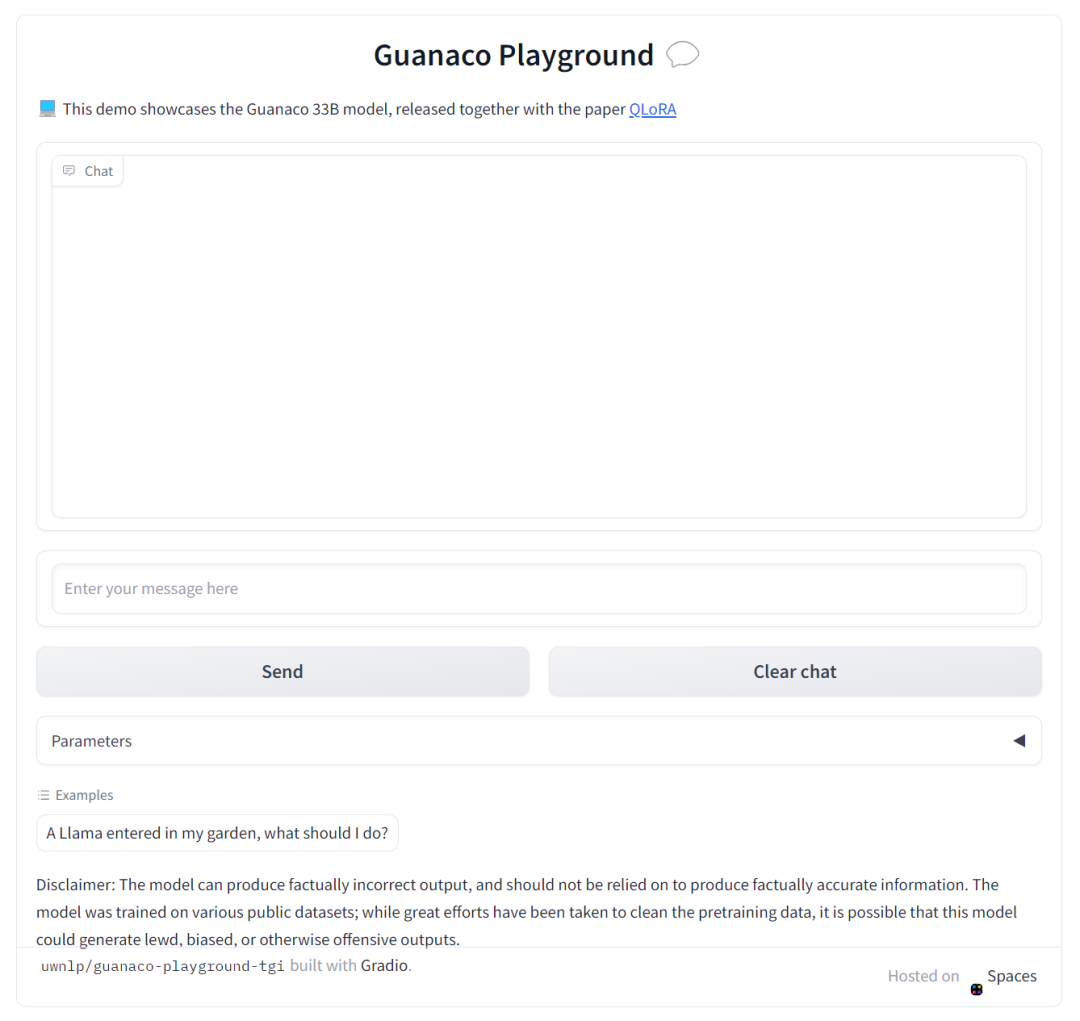

ChatGLM2-6B微调实践-QLora方案

ChatGLM2-6B微调实践-QLora方案 环境部署Lora微调项目部署准备数据集修改训练脚本adapter推理模型合并与量化合并后的模型推理 参数调优微调过程中遇到的问题参考: 环境部署 申请阿里云GPU服务器: CentOS 7.6 64Anaconda3-2023.07-1-Linux-x86_64Python 3.11.5GPU NVIDIA A10(显存24

![[论文笔记]QLoRA: Efficient Finetuning of Quantized LLMs](https://img-blog.csdnimg.cn/img_convert/e75c9a4137c39630cd34c5ebe3fe8196.png)