65b专题

QLoRA:高效的LLMs微调方法,48G内存可调65B 模型

文章:https://arxiv.org/pdf/2305.14314.pdf代码:https://github.com/artidoro/qlora 概括 QLORA是一种有效的微调方法,它减少了内存使用,足以在单个48GB GPU上微调65B参数模型,同时保留完整的16位微调任务性能。QLORA通过冻结的4位量化预训练语言模型将梯度反向传播到低秩适配器(Low Rank Adapter

【BestCoder Round 65B】【博弈 对称思想】ZYB's Game 范围取数都知道x谁取到x谁必败

ZYB's Game Accepts: 672 Submissions: 1207 Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others) 问题描述 ZYBZYB在远足中,和同学们玩了一个“数字炸弹”游戏:由主持人心里想一个在[1,N][1,N]中的数

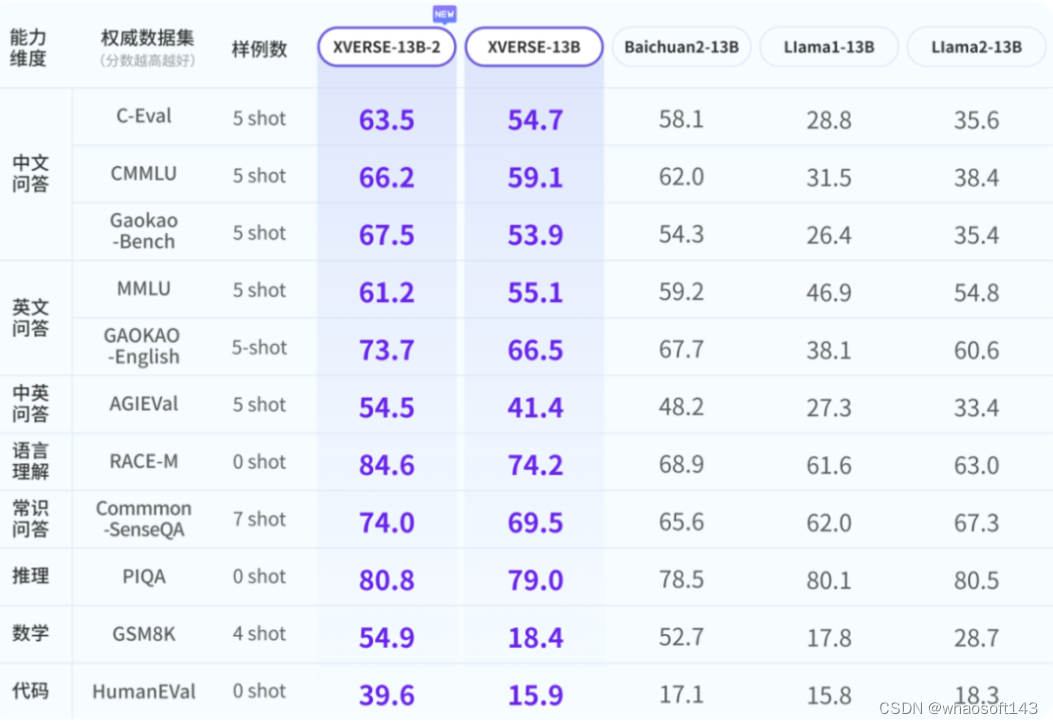

XVERSE-65B

大模型也太卷了吧, 国内此前开源了多个 70 到 130 亿参 数大模型,落地成果涌现,开源生态系统初步建立。随着智能体等任务复杂性与数据量的提升,业界与社区对更「大」模型的需求愈发迫切。国内最大开源模型来了,高性能无条件免费商用,元象 研究表明,参数量越高,高质量训练数据越多,大模型性能才能不断提升。而业界普遍共识是达到 500 到 600 亿参数门槛,大模型才能「智能涌现」,在多任务中展现强