超参专题

YOLO算法检测模型训练参数大合集!!再也不用看不懂超参啦!

参数默认值描述modelNone指定用于训练的模型文件。接受预训练模型(.pt 文件)或配置文件(.yaml 文件)的路径。对于定义模型结构或初始化权重至关重要。dataNone数据集配置文件的路径(例如,coco8.yaml)。该文件包含特定于数据集的参数,包括训练和验证数据的路径、类名以及类的数量。epochs100训练的总轮数。每个轮数代表对整个数据集的完整遍历。调整此值会影响训练持续时间和

AUTOML_NNI案例之 1.pytorch——minist 超参优化

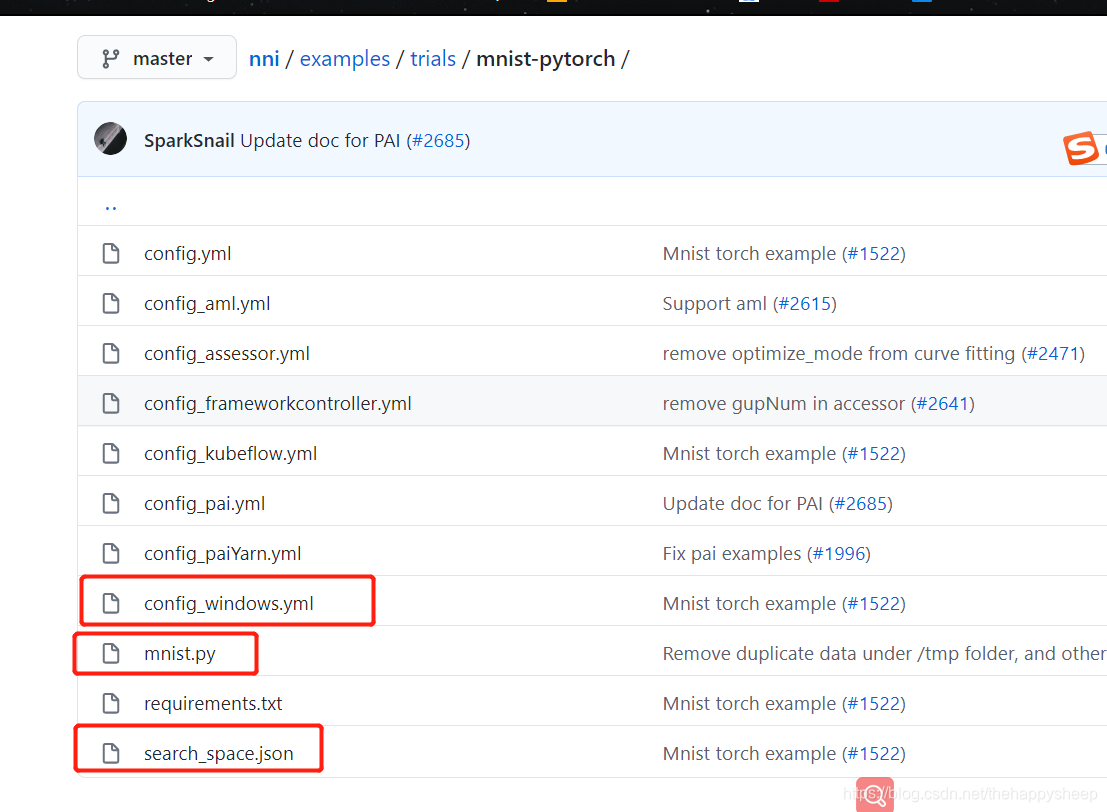

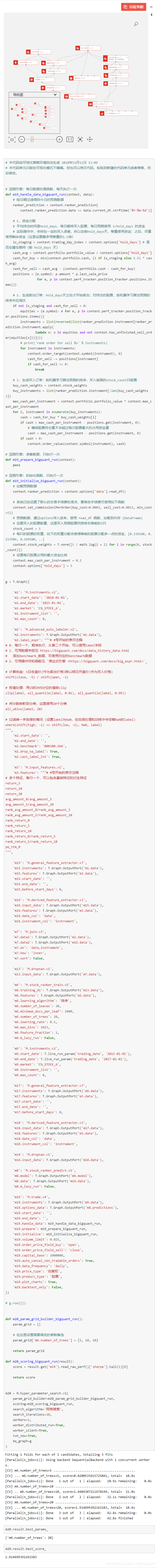

1.代码文件 https://github.com/microsoft/nni/tree/master/examples/trials/mnist-pytorch 主要包括,配置文件config_windows.yml和minist.py文件,搜索空间文件search_space.json文件。 2.config_windows.ymal配置文件 配置文件中包设置了trial次数和时间

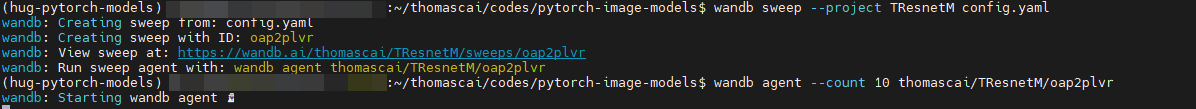

【炼丹神器】wandb实践之sweep超参扫描工具

文章目录 一、四步上手wandb二、四步玩转sweep 参考官方文档:https://docs.wandb.ai/guides/sweeps/define-sweep-configuration 一、四步上手wandb 首先,wandb其实类似tensorboard,mindinsight,都是观察训练时的学习率,训练loss、验证loss等指标以了解训练进程的工具

AUTOML_NNI案例之 1.pytorch——minist 超参优化

1.代码文件 https://github.com/microsoft/nni/tree/master/examples/trials/mnist-pytorch 主要包括,配置文件config_windows.yml和minist.py文件,搜索空间文件search_space.json文件。 2.config_windows.ymal配置文件 配置文件中包设置了trial次数和时间

G.4PaddleHub--{超参优化AutoDL Finetuner}【二】

NLP专栏简介:数据增强、智能标注、意图识别算法|多分类算法、文本信息抽取、多模态信息抽取、可解释性分析、性能调优、模型压缩算法等 专栏详细介绍:[NLP专栏简介:数据增强、智能标注、意图识别算法|多分类算法、文本信息抽取、多模态信息抽取、可解释性分析、性能调优、模型压缩算法等]

又一AI神器全新升级!自动超参搜索带着免费算力资源拯救你!

点击上方“CVer”,选择加"星标"置顶 重磅干货,第一时间送达 在人工智能领域,算法工程师在训练神经网络模型的过程中,在完成网络构建和训练数据准备好后,往往需要对模型进行各种参数优化,以获得更好的模型效果。但调参其实并不简单,背后往往是通宵达旦的参数调试与效果验证,并需要做大量的实验,不仅耗时也耗费大量算力。 这个时候,往往想尝试自动超参搜索,但又开始担心算力要求所带来的额外训练成本。 莫慌

百度全功能AI开发平台BML自动超参搜索技术全面解析

在人工智能领域,算法工程师在训练神经网络模型的过程中,完成网络构建和准备好训练数据后,往往需要对模型进行各种参数优化,以获得更好的模型效果。但调参其实并不简单,背后往往是通宵达旦的参数调试与效果验证,并需要做大量的实验,不仅耗时还耗费大量算力。 这个时候,往往想尝试自动超参搜索的算法工程师,大多会开始担心算力要求所带来的额外训练成本。 莫慌!百度全功能 AI 开发平台 BML 带着免费算力

调参到脱发?自动超参搜索带着免费算力资源拯救你!

在人工智能领域,算法工程师在训练神经网络模型的过程中,完成网络构建和准备好训练数据后,往往需要对模型进行各种参数优化,以获得更好的模型效果。但调参其实并不简单,背后往往是通宵达旦的参数调试与效果验证,并需要做大量的实验,不仅耗时也耗费大量算力。 这个时候,往往想尝试自动超参搜索,但又开始担心算力要求所带来的额外训练成本。 莫慌!百度全功能AI开发平台BML带着免费算力额度与自动超参搜索能力来了

干货速递,自动超参搜索技术原理揭秘与实战攻略!

点击左上方蓝字关注我们 在人工智能领域,算法工程师在训练神经网络模型的过程中,在完成网络构建和训练数据准备好后,往往需要对模型进行各种参数优化,以获得更好的模型效果。但调参其实并不简单,背后往往是通宵达旦的参数调试与效果验证,并需要做大量的实验,不仅耗时也耗费大量算力。 这个时候,往往想尝试自动超参搜索,但又开始担心算力要求所带来的额外训练成本。 莫慌!百度全功能AI开发平台BML带着免费算力