实列专题

linux下获取一些系统配置信息的方法及实列

sysconf 在linux下如何获取一些系统信息: 方法一:通过一些系统函数,如sysconf()。 方法二:读取一些系统的配置文件:如:/proc/cpuinfo 方法一: #include <unistd.h> long sysconf (int name); 说明: sysconf() 返回选项 ( 变量) 的当前值,这个值可配置的但也是

网络并发编程进阶版 实列自制服务端电影下载

服务端代码 import jsonimport socketimport struct#mac本多次刷新链接,需要添加from socket import SOL_SOCKET, SO_REUSEADDR#socket实现各个主机之间互连server = socket.socket()#mac本多次刷新链接,需要添加server.setsockopt(SOL_SOCKET, SO_

oracel 12c 在实列下新建表空间和用户

第一步 :创建表空间 --默认使用的表空间 create tablespace 表空间名 datafile'/oradata/xxx/xxx.dbfA' size 20G autoextend on next 1G maxsize unlimited extent management local; --临时表空间 使用order by group by 子句数据量过大时保存的临时表空间 cr

VC++中使用XML实列

/**************************************** //必要的头文件 #import <msxml.dll> //xml using namespace MSXML; //**************************************** class CXMLControl { //公有方法 public: _bstr_t GetNodeT

Verilog HDL语言组合逻辑电路设计实列

Verilog DHL语言组合逻辑举列 内容8位带进位端的加法器的设计指令译码电路设计比较重组信号设计比较器设计3-8译码器设计 内容 8位带进位端的加法器的设计 实现模块: module adder_8(cout,sum,a,b,cin);input cin;input[7:0] a,b;output cout;output[7:0] sum;assign {cout,s

Kaptcha验证码(springboot后端加vue前端简单实列)

搭建编写环境 搭建前端环境(vue) 使用cmd创建一个基本的vue项目,并用idea打开 搭建后端环境(springboot) 在根目录创建一个Module 选择spring,并下一步。 勾选Web下的Spring Web。并下一步。 这样你的后端环境就搭建完成了。 代码编写 后端 第一步:导入kaptcha依赖 <!-- 验证码 依赖-

Spark学习笔记(详解,附代码实列和图解)----------累加器和广播变量

Spark三大数据结构分别是: ➢ RDD : 弹性分布式数据集 ➢ 累加器:分布式共享只写变量 ➢ 广播变量:分布式共享只读变量 一.累加器(accumulator) 问题引入: 当使用foreach来对rdd求和会发现求和数据为0 val rdd = sc.makeRDD(List(1,2,3,4))var sum = 0rdd.foreach(num => {sum += num})p

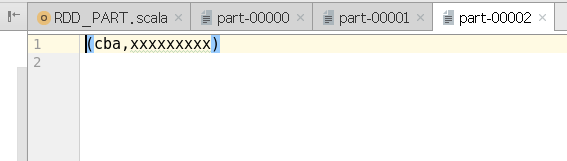

Spark学习笔记(详解,附代码实列和图解)----------RDD(四)分区器

七.RDD分区器 Spark 目前支持 Hash 分区和 Range 分区,和用户自定义分区。Hash 分区为当前的默认分区。分区器直接决定了 RDD 中分区的个数、RDD 中每条数据经过 Shuffle 后进入哪个分区,进而决定了 Reduce 的个数。 ➢ 只有 Key-Value 类型的 RDD 才有分区器,非 Key-Value 类型的 RDD 分区的值是 None ➢ 每个 RDD

Spark学习笔记(详解,附代码实列和图解)----------RDD(三)持久化

六. RDD 持久化 当需要对RDD连续使用时,重复调用是否就可以避免从头再来呢? val list = List("Hello Scala", "Hello Spark")val rdd = sc.makeRDD(list)val flatRDD = rdd.flatMap(_.split(" "))val mapRDD = flatRDD.map(word=>{println("@@@@

Spark学习笔记(详解,附代码实列和图解)----------RDD(二)行动算子,依赖关系

四.RDD行动算子 行动算子 所谓的行动算子,其实就是触发作业(Job)执行的方法底层代码调用的是环境对象的runJob方法底层代码中会创建ActiveJob,并提交执行。 1.reduce ➢ 函数签名 def reduce(f: (T, T) => T): T ➢ 函数说明 聚集 RDD中的所有元素,先聚合分区内数据,再聚合分区间数据 val rdd=sc.makeRD

Spark学习笔记(详解,附代码实列和图解)----------RDD(一)基础和转换算子

RDD : 弹性分布式数据集 一.简介 RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是 Spark 中最基本的数据处理模型。代码中是一个抽象类,它代表一个弹性的、不可变、可分区、里面的元素可并行计算的集合。 ➢ 弹性 --------存储的弹性:内存与磁盘的自动切换; --------容错的弹性:数据丢失可以自动恢复; --------计算的弹