剪枝专题

usaco 1.3 Prime Cryptarithm(简单哈希表暴搜剪枝)

思路: 1. 用一个 hash[ ] 数组存放输入的数字,令 hash[ tmp ]=1 。 2. 一个自定义函数 check( ) ,检查各位是否为输入的数字。 3. 暴搜。第一行数从 100到999,第二行数从 10到99。 4. 剪枝。 代码: /*ID: who jayLANG: C++TASK: crypt1*/#include<stdio.h>bool h

hdu1010 奇偶剪枝

恰好t时间到达 import java.io.BufferedReader;import java.io.InputStream;import java.io.InputStreamReader;import java.io.PrintWriter;import java.math.BigInteger;import java.util.Arrays;import

[论文笔记] LLM大模型剪枝篇——2、剪枝总体方案

https://github.com/sramshetty/ShortGPT/tree/main My剪枝方案(暂定): 剪枝目标:1.5B —> 100~600M 剪枝方法: 层粒度剪枝 1、基于BI分数选择P%的冗余层,P=60~80 2、对前N%冗余层,

[论文笔记] LLM大模型剪枝篇——1、调研

Attention Is All You Need But You Don’t Need All Of It For Inference of Large Language Models LLaMA2在剪枝时,跳过ffn和跳过full layer的效果差不多。相比跳过ffn/full layer,跳过attention layer的影响会更小。 跳过attention layer:7B/13B从

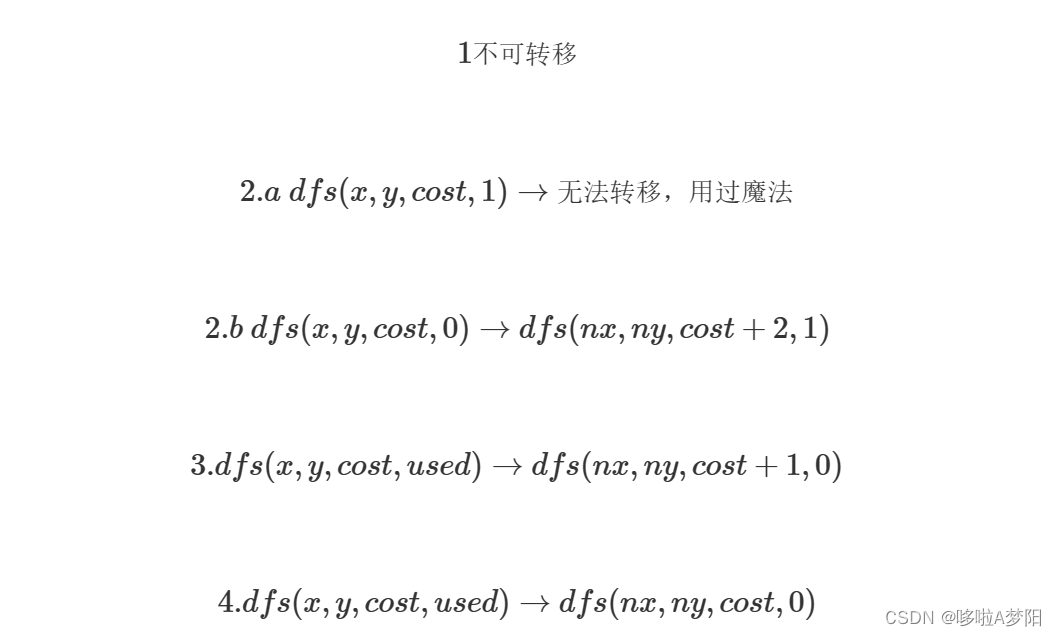

hdu---1010 Tempter of the Bone (经典DFS,注意剪枝)

/*经典的dfs 主要考虑剪枝否则会超时 HDU 1010 */ # include<iostream> # include<cstdio> # include<cmath> # include<cstdlib> # include<cstring> # include<string> using namespace std; char

力扣每日一题 划分为k个相等的子集 回溯 递归 细节剪枝

Problem: 698. 划分为k个相等的子集 👨🏫 参考题解 🍻 球选桶 class Solution {public boolean canPartitionKSubsets(int[] nums, int k) {int sum = 0;for (int i = 0; i < nums.length; i++)sum += nums[i];if (sum %

[Mdfs] lc473. 火柴拼正方形(剪枝优化+经典题+好题)

文章目录 1. 题目来源2. 题目解析 1. 题目来源 链接:473. 火柴拼正方形 拔高、证明: [dfs] aw167. 木棒(dfs剪枝与优化+分类讨论+思维+好题) 2. 题目解析 水一篇。和之前的一个问题一模一样,在此不再赘述,写出来方便搜索。 [Mdfs] lc698. 划分为k个相等的子集(剪枝优化+经典题+好题) 时间复杂度:此类 dfs 和剪枝

poj1699--Best Sequence(dfs+剪枝)

题目链接:点击打开链接 题目大意:给出n个字符串,要求组合后的串最短 #include <cstdio>#include <cstring>#include <algorithm>using namespace std ;char str[12][22] ;char s[300] , s1[300] ;int vis[12] , min1 , n , l[12];void d

uva10400 - Game Show Math(回溯+剪枝)

题目:uva10400 - Game Show Math(回溯+剪枝) 题目大意:给出N个数,并且给出一个目标数值,要求用上面的数字(全部),并且顺序不能乱,然后用+-*/这些操作,问最终能不能得到目标数值。这里要注意给出的数会在【-32000,32000】之间, 并且要用除法的时候,只有在能整除的时候才能用。并且中间计算结果不能超过【-32000,32000】范围。如果超过这个操作不能做

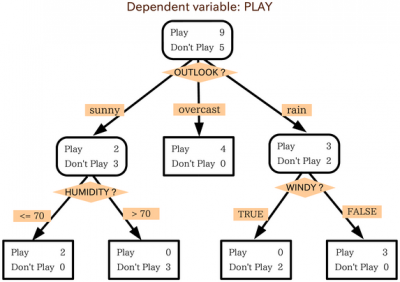

《机器学习》 决策树剪枝、树模型参数及案例演示

目录 一、决策树剪枝 1、什么是决策树剪枝? 2、如何剪枝 3、剪枝剪哪个位置的叶子结点 二、树模型参数及用法 1、参数种类 2、参数解释 1)criterion:gini or entropy 2)splitter:best or random 3)max_feature:最大特征数目 4)max_depth:最大层数 5)min_samples_split :内部节点最

HDU 1253 胜利大逃亡 (BFS,剪枝)

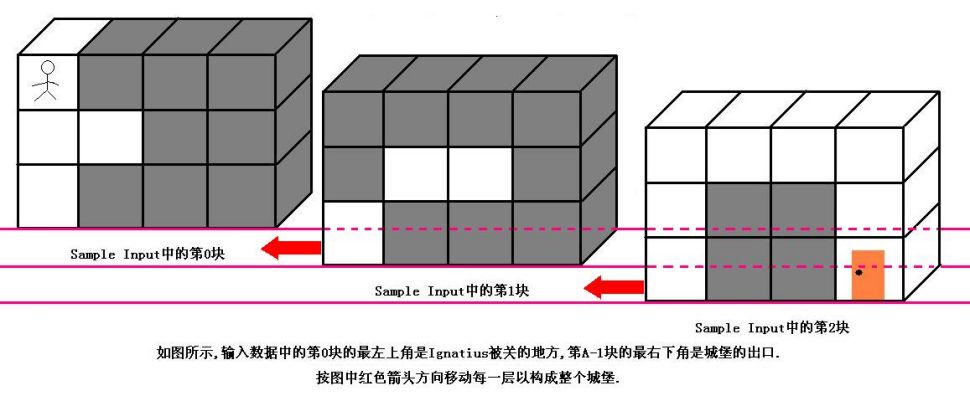

http://acm.hdu.edu.cn/showproblem.php?pid=1253 胜利大逃亡 Time Limit: 4000/2000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others) Total Submission(s): 24270 Accepted Submission(s): 9300

Sticks ---- 深度优先搜索+剪枝优化

这是我第一道接触剪枝算法的题目,剪枝的用处就是为了优化深度优先搜索的时间复杂的,使其代码跑的更快。 Time Limit: 1000MS Memory Limit: 10000KTotal Submissions: 118677 Accepted: 27381 Description George took sticks of the same length and cut

深度神经网络——决策树的实现与剪枝

概述 决策树 是一种有用的机器学习算法,用于回归和分类任务。 “决策树”这个名字来源于这样一个事实:算法不断地将数据集划分为越来越小的部分,直到数据被划分为单个实例,然后对实例进行分类。如果您要可视化算法的结果,类别的划分方式将类似于一棵树和许多叶子。 这是决策树的快速定义,但让我们深入了解决策树的工作原理。 更好地了解决策树的运作方式及其用例,将帮助您了解何时在机器学习项目中使用它们。 决

量化、剪枝、蒸馏,这些大模型黑话到底说了些啥?

扎克伯格说,Llama3-8B还是太大了,不适合放到手机中,有什么办法? 量化、剪枝、蒸馏,如果你经常关注大语言模型,一定会看到这几个词,单看这几个字,我们很难理解它们都干了些什么,但是这几个词对于现阶段的大语言模型发展特别重要。这篇文章就带大家来认识认识它们,理解其中的原理。 模型压缩 量化、剪枝、蒸馏,其实是通用的神经网络模型压缩技术,不是大语言模型专有的。 模型压缩的意义 通过压缩

【网络裁剪】——通道剪枝问答/code解读

亮点:原理,code 论文和原理和参考上一篇博客:Learning Efficient Convolutional Networks through Network Slimming 通道裁剪在训练时需要做什么? 在训练的时候需要训练一个通道稀疏特性的模型,实现通道稀疏化需要将和一个通道有关联的所有输入和输出的连接都剪掉。 其如何训练一个通道稀疏的模型的? 利用BN层的缩放因子,引

【递归、搜索与回溯】穷举vs暴搜vs深搜vs回溯vs剪枝

穷举vs暴搜vs深搜vs回溯vs剪枝 1.全排列2.子集 点赞👍👍收藏🌟🌟关注💖💖 你的支持是对我最大的鼓励,我们一起努力吧!😃😃 管他什么深搜、回溯还是剪枝,画出决策树就完事了~~~ 1.全排列 题目链接:46. 全排列 题目描述: 算法原理: 其实这道题本身是一个穷举(枚举)的题,3个数你可以三层for循环,但是如果10个数,100个数

uva 690 - Pipeline Scheduling(dfs+剪枝)

题目链接:uva 690 - Pipeline Scheduling 题目大意:有10个任务,5个管道,每个任务需要占用不同时间的管道,给出任务所占用管道的时间,求最短需要多少时间。 解题思路:dfs+剪枝,剪枝1,将所有可以的相对位置记录。剪枝2,当当前开销加上剩余任务的最有情况仍大于ans。 #include <stdio.h>#include <string.

uva 219 - Department of Redundancy Department(dfs+剪枝)

题目链接:uva 219 - Department of Redundancy Department 题目大意:给定一些关系,问哪一些关系是可以被替代的,如果可以被替代,给出替代的方案,一种即可。 解题思路:因为总共也就26个字母,所以用二进制数表示状态。剪枝,每次将所有可选关系均考虑进去都无法满足则是false。 #include <cstdio>#include <cstring

算法人生(18):从神经网络的“剪枝策略”看“怎么找回时间”

IT人的工作和生活难平衡这事,到底要怎么解决呢,让我们从神经网络的“剪枝策略”中找点灵感吧! 剪枝策略是指训练和优化深度神经网络时采取的一种技术,从名字就知道,它就像修剪树木一样,去除不必要的枝叶,让主干更加清晰,更有利于模型的健康成长。它旨在减少模型中的参数数量和计算量,从而提高模型的效率和性能。剪枝策略的核心思想是通过删除不必要的神经元或连接来简化网络结构,同时尽量保持模型的性能不受影响

『大模型笔记』量化 vs 剪枝 vs 蒸馏:为推理优化神经网络!

量化 vs 剪枝 vs 蒸馏:为推理优化神经网络! 文章目录 一. 量化 vs 剪枝 vs 蒸馏:为推理优化神经网络!1.1. 量化(Quantization)1.2. 剪枝(purning)1.3. 知识蒸馏(Knowledge Distillation,也称为模型蒸馏)1.4. 工程优化(Engineering Optimizations)1.5. 总结 二. 参考文献

ACWing471. 棋盘-DFS剪枝

题目 思路 本思路参考博客AcWing 471. 棋盘 - AcWing 约束方程: 代码 #include <iostream>#include <cstring>#include <algorithm>using namespace std;const int N = 110, INF = 0x3f3f3f3f;int g[N][N], n,

AcWing166. 数独-DFS剪枝与优化

题目 思路 思考问题:搜索顺序->考虑剪枝搜索顺序:先随意选择一个空格子,枚举该格子可填写的数字,当所有格子都填完的时候,说明可以退出了剪枝: 优化搜索顺序:随意选择一个空格子:应该优先搜索分支数量较少的方案,如果分支数量相同,则选择前者可行性剪枝:当前数字不能与行,列,九宫格有重复本题用到了位运算优化:9位的01串:0表示尚未用过,1表示用过;与运算 行:123456789 行01

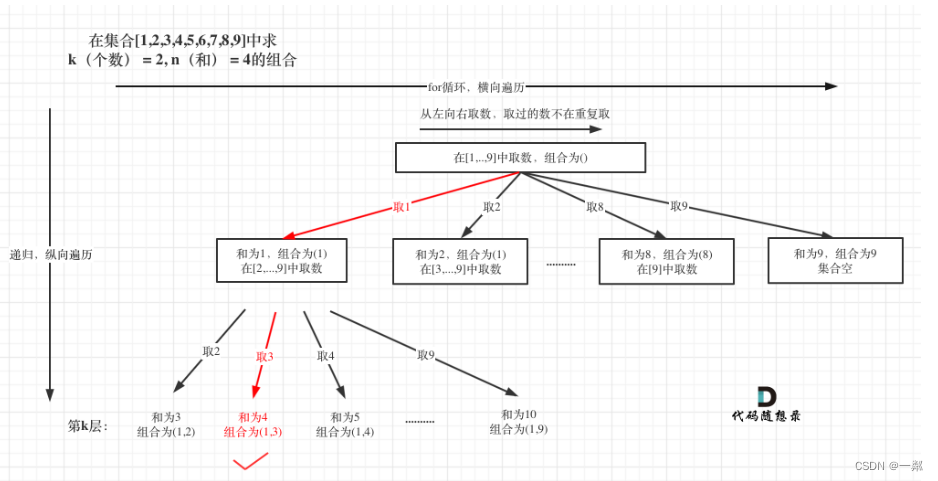

算法训练营第二十八天 | LeetCode 77 组合(剪枝优化)、LeetCode 216 组合总和III、LeetCode 17 电话号码的字母组合

LeetCode 77 组合(剪枝优化) 当我们到达某一层,后面的结点数已经不能满足条件时。可以进行剪枝操作。 代码如下: class Solution {private:vector<int> path;vector<vector<int>> res;void backtracking(int n, int index, int k) {if (path.size() == k) {re

九宫格数独(深搜剪枝)

描述 在提瓦特大陆上,你作为一名旅行者发现了一个古老的神庙,里面有一块被称为“天地平衡板”的神秘石碑。为了解开石碑上的封印,你需要通过正确放置元素之力来恢复它的平衡。 天地平衡板是一个9x9的方格,每个方格可以填入代表不同元素力量的数字1-9。每种力量在每一行、每一列以及每一个由粗实线分隔的3x3宫格中必须恰好出现一次,这样才能保持元素之间的平衡。 部分格子中已经注入了元素力量(数字已知),