前馈专题

基于Python的机器学习系列(29):前馈神经网络

在本篇文章中,我们将学习如何使用PyTorch构建和训练一个前馈神经网络。我们将以线性回归为例,逐步了解PyTorch的各个组件及其在神经网络中的应用。这些步骤包括: 指定输入和目标:我们将定义输入特征和目标变量。数据集和数据加载器:使用PyTorch的数据集和数据加载器来管理和加载数据。nn.Linear(全连接层):创建前馈神经网络中的线性层。定义损失函数:选择合适的损失函数

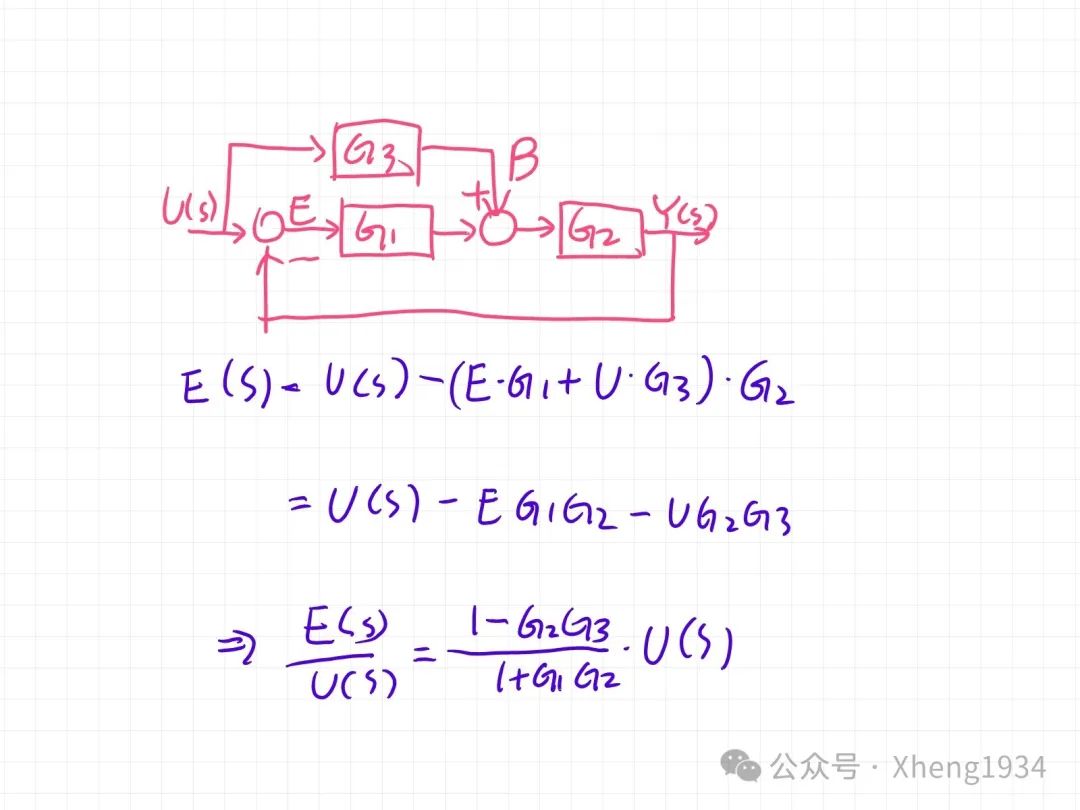

自控原理-传递函数(闭环 扰动 偏差 前馈 复合 顺馈)

都知道闭环传递函数定义为:G1·G2/(1+G1·G2·H) 但是当碰到复杂的系统,比如复合顺馈,前馈扰动等,就不知道分子到底要不要乘上G2了。 这个公式是如何推导出来的,今天看到一个公式图片: 过程非常详细。 由此我也分别针对: 闭环扰动系统的传递函数和偏差传递函数问题 前馈扰动系统的误差分析 复合顺馈系统的误差分析 这三类问题给出了相应的解答方案。 闭环扰动系统的

深度学习100问23:什么是前馈型神经网络

嘿,前馈型神经网络就像一个神奇的小工厂哟! 一、定义及原理 这个小工厂呀,有个特别的工作方式。数据就像是原材料,从输入层这个“大门”进入工厂。然后呢,这些数据一路向前,经过一个又一个隐藏层,就好像经过不同的加工车间。每个车间都对数据进行一番特别的处理和改造。最后,数据到达输出层这个“成品出口”,变成了我们想要的结果。在这个过程中,数据只能一个劲儿地往前跑,可不能绕回来,就像一条单行道。比如

【电控笔记z27】相对位置控制(无前馈)

相对位置控制系统(Relative Position Control System)是一种用于控制对象之间相对位置的控制系统。在工程应用中,这类系统广泛用于自动化、机器人控制、航空航天、机电设备等领域。系统通过感知和调节两个或多个物体之间的相对位置,确保它们在特定条件下保持预定的距离或方位。 相对位置控制系统的关键要素 传感器: 位置传感器:用于检测物体的当前位置,如激光测距仪、超声波传感器

吴恩达机器学习作业ex3:多类分类和前馈神经网络(Python实现)详细注释

文章目录 1 多类分类1.1数据集1.2 数据可视化1.3 向量化逻辑回归1.3.1 向量化代价函数1.3.2 矢量化梯度下降以及正则化表达1.4 一对多分类 2.神经网络2.1模型表示 总结(自己训练求解参数全流程) 1 多类分类 在本练习中,您将使用逻辑回归和神经网络来识别手写数字(从 0 到 9)。如今,自动手写数字识别被广泛使用 - 从识别邮件信封上的邮政编码到识别银行支

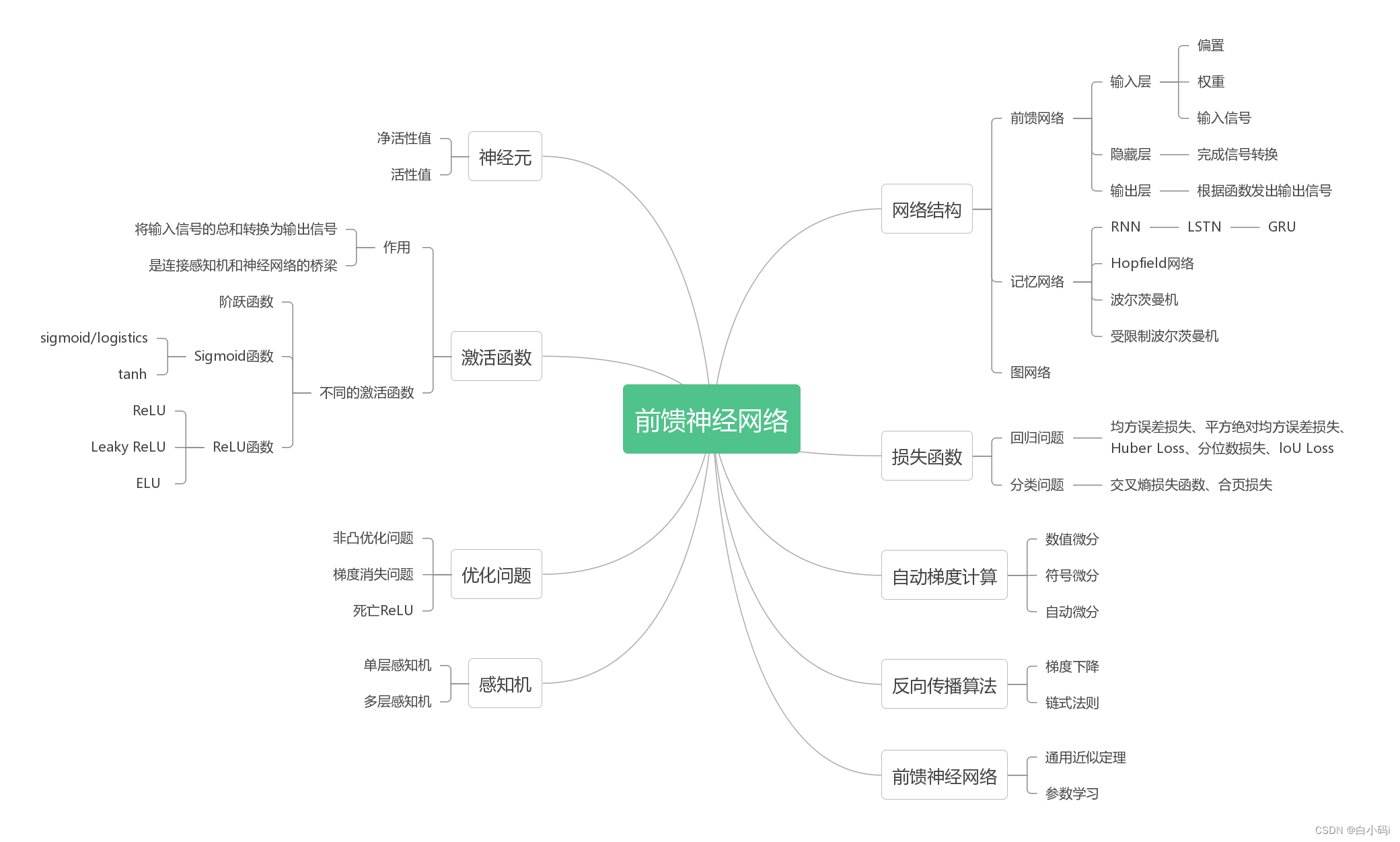

深度学习与神经网络-邱锡鹏 第4章 前馈神经网络

文章目录 引言4.1 神经元4.2 网络结构4.3 前馈神经网络4.4 反向传播算法4.5 自动梯度计算4.6 优化问题 引言 Q:连接主义中的分布式并行处理(Parallel Distributed Processing, PDP)模型是的3个主要特性是什么? 1.信息表示是分布式的(非局部的)2.记忆和知识是存储在单元之间的连接上3.通过逐渐改变单元之间的连接强度来学习新的知

Transformer详解(4)-前馈层残差连接层归一化

1、前馈层 前馈层接收自注意力层的输出作为输入。 from torch import nnimport torch.nn.functional as Fclass FeedForward(nn.Module):def __init__(self, d_model=512, d_ff=2048, dropout=0.1):super().__init__()# d_ff 默认设置为2048s

前馈神经网络FNN、多层感知机MLP和反向传播推导

目录 一、前馈神经网络FNN 激活函数的使用 二、多层感知机MLP MLP的典型结构 多层感知机MLP的特点 和前馈神经网络FNN的区别 三、传播推导 1、前向传播(Forward propagation) (1)输入层到隐藏层 (2)隐藏层到输出层 2、反向传播(Backward propagation) (1)正向传播(Forward Pass) (2)反向传播(Ba

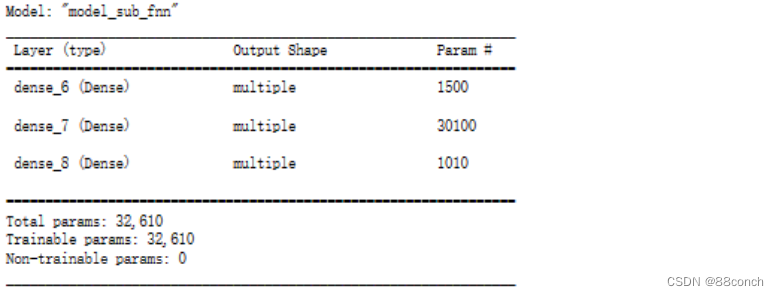

深度学习技术之加宽前馈全连接神经网络

深度学习技术 加宽前馈全连接神经网络1. Functional API 搭建神经网络模型1.1 利用Functional API编写宽深神经网络模型进行手写数字识别1.1.1 导入需要的库1.1.2 加载虹膜(Iris)数据集1.1.3 分割训练集和测试集1.1.4 定义模型输入层1.1.5 添加隐藏层1.1.6 拼接输入层和第二个隐藏层1.1.7 添加输出层1.1.8 创建模型1.1.9

深度学习之前馈神经网络

1.导入常用工具包 #在终端中输入以下命令就可以安装工具包pip install numpypip install pandasPip install matplotlib 注: numpy是科学计算基础包 pandas能方便处理结构化数据和函数 matplotlib主要用于绘制图表。 #导包的代码:import numpy as npimport pandas as pdim

读书笔记--神经网络与深度学习(三)前馈神经网络

4 前馈神经网络 从机器学习的角度看,神经网络一般可以看做是一个非线性模型。 4.1 神经元 净输入z 在经过一个非线性函数f(·)后,得到神经元的活性值(Activation)a,a = f(z), 其中非线性函数f(·)称为激活函数(Activation Function)。 激活函数 激活函数在神经元中非常重要的。为了增强网络的表示能力和学习能力,激活函数需要具备以下几点性质: 连续

前馈神经网络基础教程

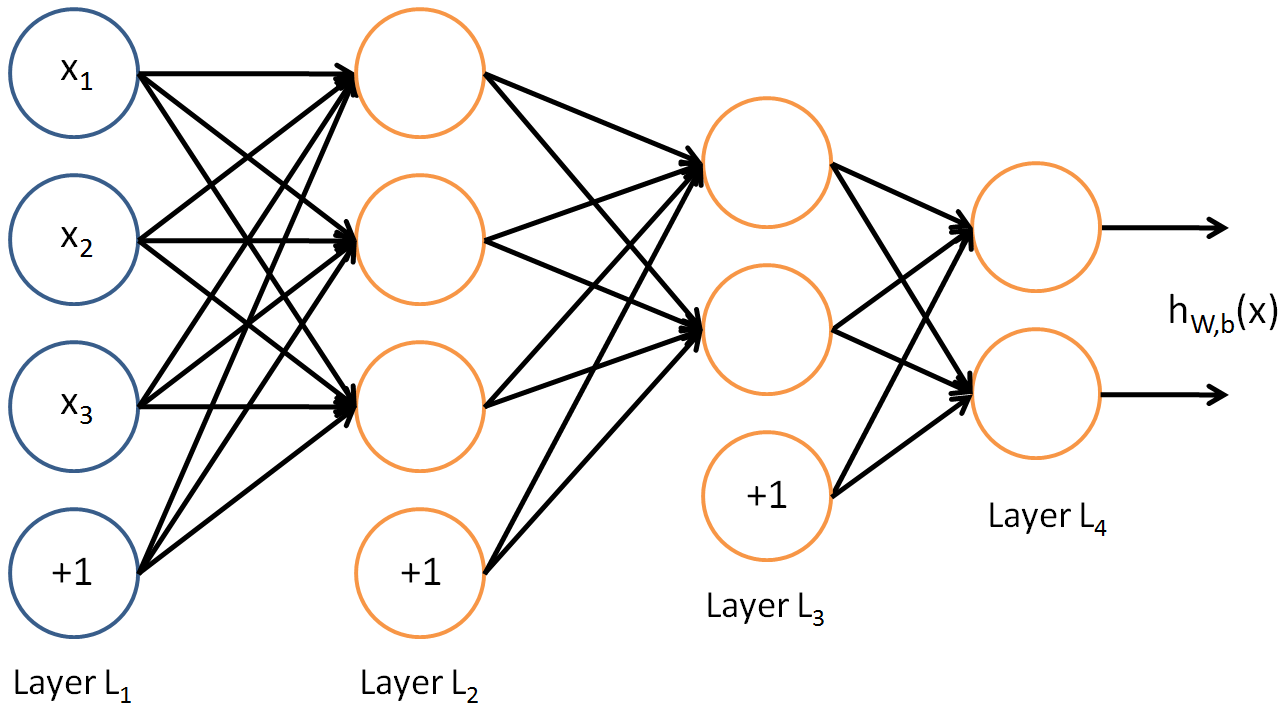

@(深度学习)[神经网络] 本文主要参考链接 #1. 前馈神经网络基础教程 ##1.1. 概述 以监督学习为例,假设我们有训练样本集 ( x ( i ) , y ( i ) ) (x(^i),y(^i)) (x(i),y(i)),那么神经网络算法能够提供一种负责且非线性的假设模型 h W , b ( x ) h_{W,b}(x) hW,b(x),它具有参数 W , b W,b W,b,可以通过调

【第三章】神经网络的架构-前馈神经网络

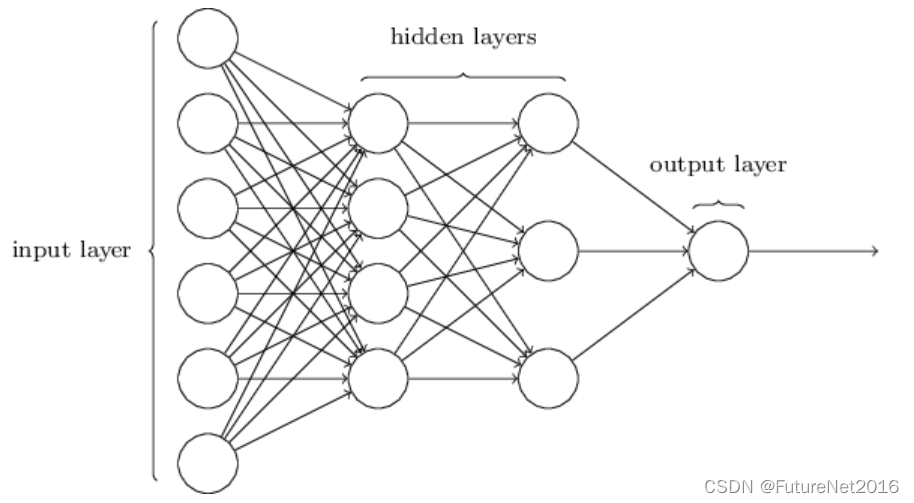

架构 在下一部分,我将介绍一个能够相当不错地对手写数字进行分类的神经网络。为了做好准备,有必要解释一些术语,这些术语让我们能够给网络的不同部分命名。假设我们有以下网络: 如前所述,这个网络中最左边的层被称为输入层,层内的神经元被称为输入神经元。最右边或输出层包含输出神经元,或者在这种情况下,一个单独的输出神经元。中间层被称为隐藏层,因为这一层中的神经元既不是输入也不是输出。术语"隐藏"可能听起

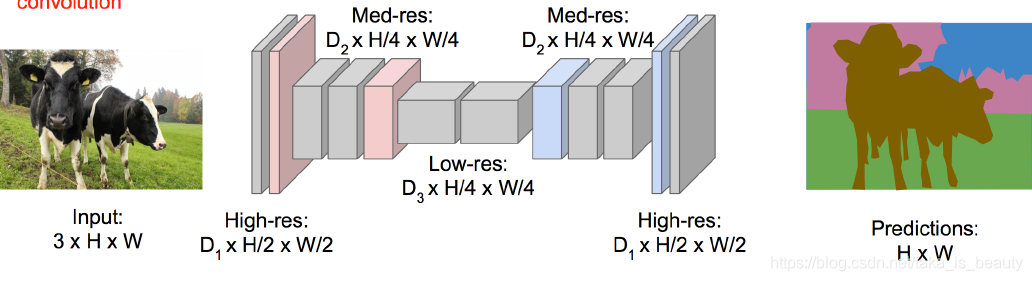

前馈(向)网络之卷积神经网络的应用

图像识别: 卷积神经网络(CNN) 分类任务:C个类别 输入:图片, 输出:类别标签, 评估准则:准确率 图像识别与定位 输入:图片, 输出:物体边界框(x,y,w,h) 评估准则:交并准则 交并准则是预测值与真实值的交集的面积除去并集的面积,值大于0.5通常会认为是有效的定位 图像识别+定位:识别主体+定位

前馈(向)网络之卷积神经网络

传统的神经网络: 多层感知器(DNN,MLP等),对图片这类数据可能不太适合! 图片数据,比如:32*32*3,展开大概是4000维的向量,如果一层神经元是1024个那么进行全连接每层会有400W个参数 ps:参数过多主要是会导致过拟合的,而且网络学习很缓慢。 ps:一般是没有足够的样本量来去学习这么复杂的网络。 ps:基于参数的问题,于是引出了卷积神经网络(CNN)! 引出卷积神经

前馈(向)网络之深度神经网络

1.多层感知器(MLP,DNN) 模型:拥有一个输入层,一个输出层,加上隐藏层,每一层都是通过全连接来进行的! ps:添加少量隐藏层叫做浅层神经网络,而增多隐藏层就是深度神经网络! ps:每一层都进行了全连接,导致参数量比较大,模型比较复杂。 ps:全连接可以看成笛卡尔积,两者是一样的概念。 一个简单的神经网络模型: 可以理解为它是对线性的(输入层)输入,经过(隐藏层)非线性的变换

NNDL 实验五 前馈神经网络—鸾尾花分类

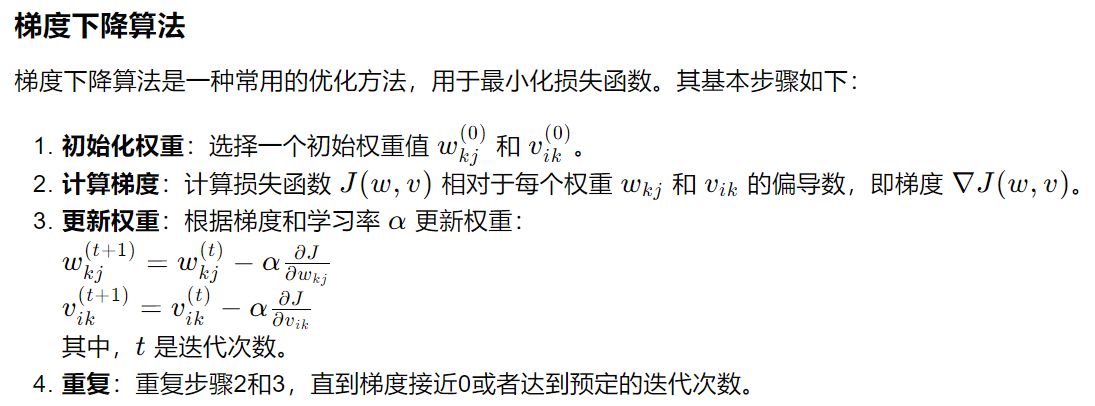

通过前两次对前馈神经网络的探究实验,基础掌握了前馈神经网络的基本概念、网络结构及代码实现,利用前馈神经网络完成一个分类任务,并通过两个简单的实验,观察前馈神经网络的梯度消失问题和死亡ReLU问题,以及对应的优化策略。接下来便落实实例,完成基于前馈神经网络完成鸾尾花分类。 目录 深入研究鸾尾花数据集 小批量梯度下降法 数据分组 数据处理 用DataLoader进行封装 模型构建

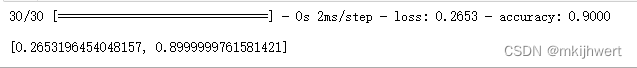

机器学习11-前馈神经网络识别手写数字1.0

在这个示例中,使用的神经网络是一个简单的全连接前馈神经网络,也称为多层感知器(Multilayer Perceptron,MLP)。这个神经网络由几个关键组件构成: 1. 输入层 输入层接收输入数据,这里是一个 28x28 的灰度图像,每个像素值表示图像中的亮度值。 2. Flatten 层 Flatten 层用于将输入数据展平为一维向量,以便传递给后续的全连接层。在这里,我们将 28x28

收放卷前馈量计算FC(梯形图+SCL代码)

这篇博客是收放卷基础系列的速度前馈量计算介绍文章,在学习这篇文章之前大家可以先学习下面这篇文章: https://rxxw-control.blog.csdn.net/article/details/136031227https://rxxw-control.blog.csdn.net/article/details/136031227上面这篇文章,主要介绍如何通过电机转速计算物体的转动线速度,

深度学习本科课程 实验2 前馈神经网络

任务 3.3 课程实验要求 (1)手动实现前馈神经网络解决上述回归、二分类、多分类任务 l 从训练时间、预测精度、Loss变化等角度分析实验结果(最好使用图表展示) (2)利用torch.nn实现前馈神经网络解决上述回归、二分类、多分类任务 l 从训练时间、预测精度、Loss变化等角度分析实验结果(最好使用图表展示) (3)在多分类任务中使用至少三种不同的激活函数 l 使用不同的激活函数,进行对比

深度学习入门笔记(五)前馈网络与反向传播

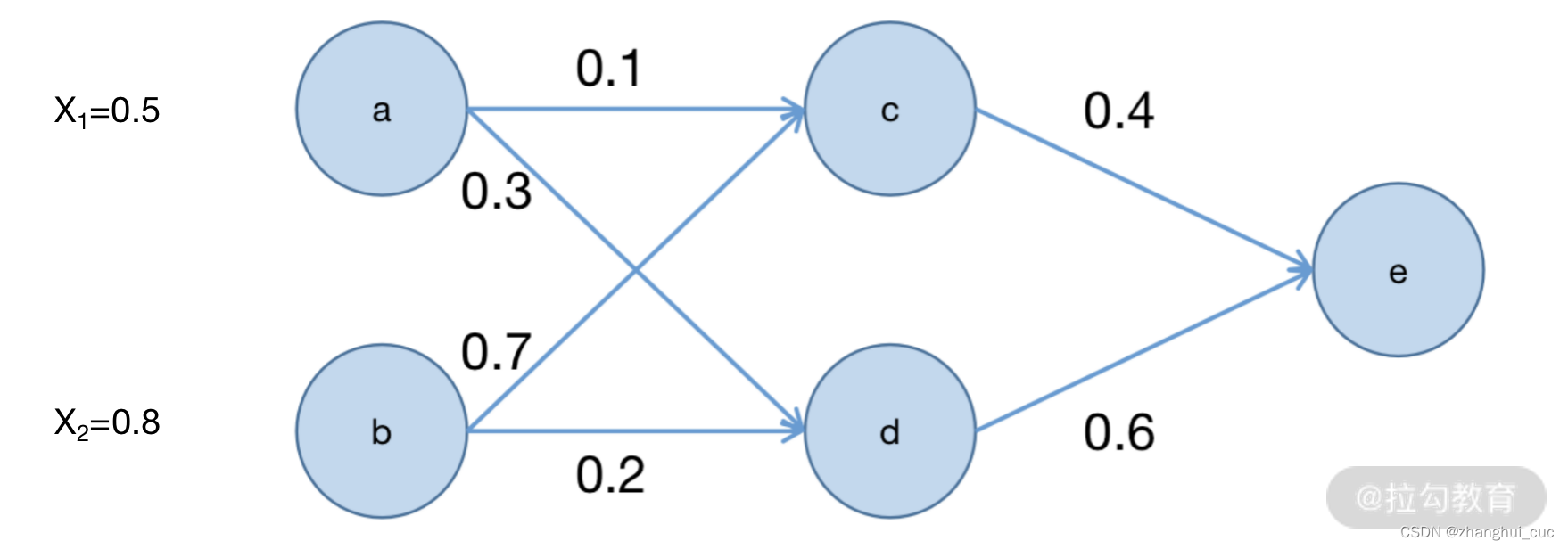

接着上一节,本节讲解模型自我学习的数学计算过程究竟是怎么样的。 5.1 前馈网络 一个最简单的前馈神经网络如图所示,对于每一个隐藏层,输入对应前一层每一个节点权重乘以节点输出值,输出则是经过激活函数(例如sigmoid函数)计算后的值。 在这样的网络中,输入的数据 x 经过网络的各个节点之后,即可计算出最终的模型结果。这样就完成了一个最基本的前馈网络从输入到输出的计算过程。 5.2反向传

自动控制原理6.4:前馈校正

参考书籍:《自动控制原理》(第七版).胡寿松主编. 《自动控制原理PDF版下载》 4.前馈校正 4.1 前置滤波组合校正 为了改善系统性能,在系统中常引入形如 G c ( s ) = ( s + z ) / ( s + p ) G_c(s)=(s+z)/(s+p) Gc(s)=(s+z)/(s+p)的串联校正网络,以改变系统的闭环极点;但 G c ( s ) G_c(s) Gc(

【DeepLearning-3】前馈(feed-forward)神经网络层

类定义 class FeedForward(nn.Module): FeedForward 类继承自 nn.Module,nn.Module是PyTorch中所有神经网络模块的基类。nn.Module允许您创建自己的神经网络层。 nn.Module 是构建所有神经网络层和模型的基类。当创建一个类继承自 nn.Module时,意味着你在创建一个自定义的神经网络层或整个神经网络模型。

深度学习之前馈神经网络(前向传播和误差反向传播)

转自:https://www.cnblogs.com/Luv-GEM/p/10694471.html 这篇文章主要整理三部分内容,一是常见的三种神经网络结构:前馈神经网络、反馈神经网络和图网络;二是整理前馈神经网络中正向传播、误差反向传播和梯度下降的原理;三是梯度消失和梯度爆炸问题的原因及解决思路。 一、神经网络结构 目前比较常用的神经网络结构有如下三种: 1、前馈神经网络 前馈神经网络

图像分类任务中 CNN 相比于前馈神经网络的优势

在图像分类任务中,卷积神经网络(CNN)相比于前馈神经网络(Feedforward Neural Network)具有以下优势: 局部感知能力:CNN通过使用卷积层和池化层来捕捉图像中的局部特征。卷积操作可以有效地共享参数,使得网络能够对输入图像中的不同位置进行共享权重的特征提取。这种局部感知能力使得CNN对于平移、旋转和尺度变化等图像变换具有较好的鲁棒性。 参数共享:CNN中的卷积层和池化