transpose专题

Tensorflow 中train和test的batchsize不同时, 如何设置: tf.nn.conv2d_transpose

大家可能都知道, 在tensorflow中, 如果想实现测试时的batchsize大小随意设置, 那么在训练时, 输入的placeholder的shape应该设置为[None, H, W, C]. 具体代码如下所示: # Placeholders for input data and the targetsx_input = tf.placeholder(dtype=tf.float32, s

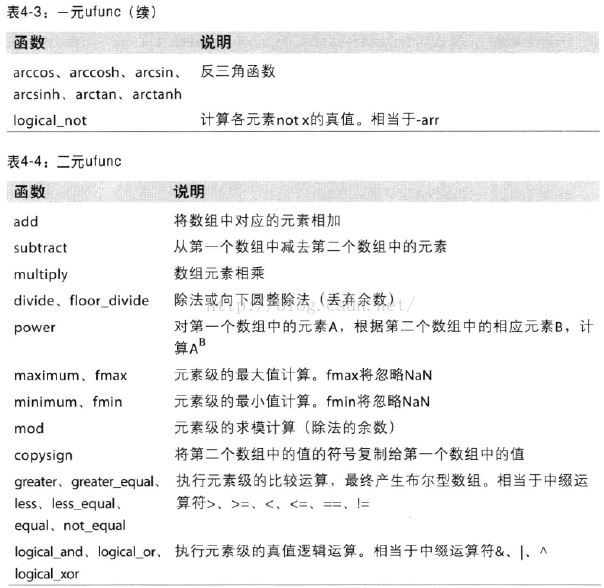

python transpose

1.数组转置和轴对换:数组不仅有transpose方法,还有一个特殊的T属性: arr = np.arange(15).reshape(3,5) arr输出: array([[ 0, 1, 2, 3, 4],[ 5, 6, 7, 8, 9],[10, 11, 12, 13, 14]]) arr.T 输出: array([[ 0, 5, 10],[ 1, 6, 11]

Meta Llama 3 .transpose().contiguous().view

Meta Llama 3 .transpose().contiguous().view() flyfish 参考地址 https://pytorch.org/docs/stable/generated/torch.transpose.html transpose美[træn'spoʊz] 英[træns'pəʊz;trɑːns-;-nz-] v. 使换位 / 转移 / 转换 / 调换n.

pytorch中的维度变换操作性质大总结:view, reshape, transpose, permute

在深度学习中,张量的维度变换是很重要的操作。在pytorch中,有四个用于维度变换的函数,view, reshape, transpose, permute。其中view, reshape都用于改变张量的形状,transpose, permute都用于重新排列张量的维度,但它们的功能和使用场景有所不同,下面将进行详细介绍,并给出测试验证代码,经过全面的了解,我们才能知道如何正确的使用这四个函数。

【NumPy】关于numpy.transpose()函数,看这一篇文章就够了

🧑 博主简介:阿里巴巴嵌入式技术专家,深耕嵌入式+人工智能领域,具备多年的嵌入式硬件产品研发管理经验。 📒 博客介绍:分享嵌入式开发领域的相关知识、经验、思考和感悟,欢迎关注。提供嵌入式方向的学习指导、简历面试辅导、技术架构设计优化、开发外包等服务,有需要可加文末联系方式联系。 💬 博主粉丝群介绍:① 群内高中生、本科生、研究生、博士生遍布,可互相学习,交流困惑。② 热榜t

10,09_维度变换,view、reshape,unsqueeze,Squeeze,expand,repeat,矩阵转置,transpose维度交换,permute,Broadcasting

1.9.Tensor维度变换 1.9.1.view、reshape 1.9.2.unsqueeze 1.9.3.Squeeze 1.9.4.expand 1.9.5.repeat 1.9.6.矩阵转置 1.9.7.transpose维度交换 1.9.8.permute 1.10.Broadcasting 1.9.Tensor维度变换 1.9.1.view、reshape 1.两者功能一样:将

np.transpose() 维度抽象理解

传入参数: a:输入数组 axis: int类型的列表。默认情况下,(0,1,2)到 (2,1,0) 对于一维向量而言,numpy.transpose()是不起作用的,返回它本身。 对于二维数组而言, 二位数据的两个坐标就是(0,1), transpose(1,0)就是将 0坐标和 1坐标 的值对调 对于三维数组而言, 三维数组的坐标就是 (0,1,2) ,默认 transpose(

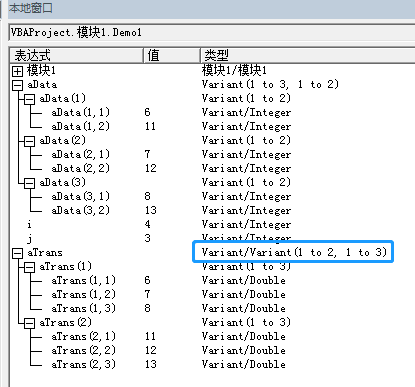

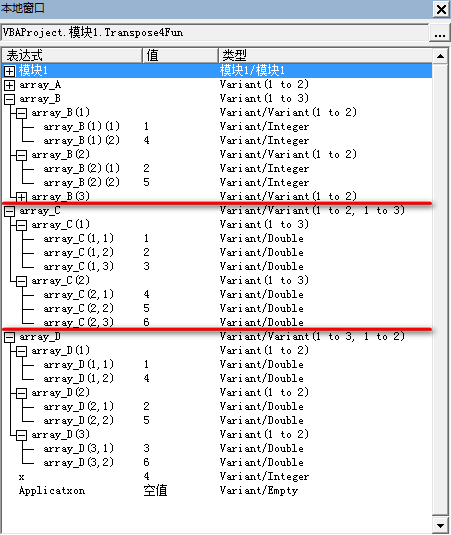

Transpose实现数组行列转置的限制

提到数组,大家都不陌生,什么是数组行列转置呢?其实也很简单,如下图所示,行列转置就是将数组元素的存放方式进行转换,原来保存在第一列的数据,将保持在新数组的第一行,并且保持原有顺序,即6在第一个位置,8在最后一个位置。其他列依次类推。 在Excel工作表中有个强大的函数Transpose,可以直接实现数组行列转置,作为VBA开发者来说,肯定不会忘记用这个。 S

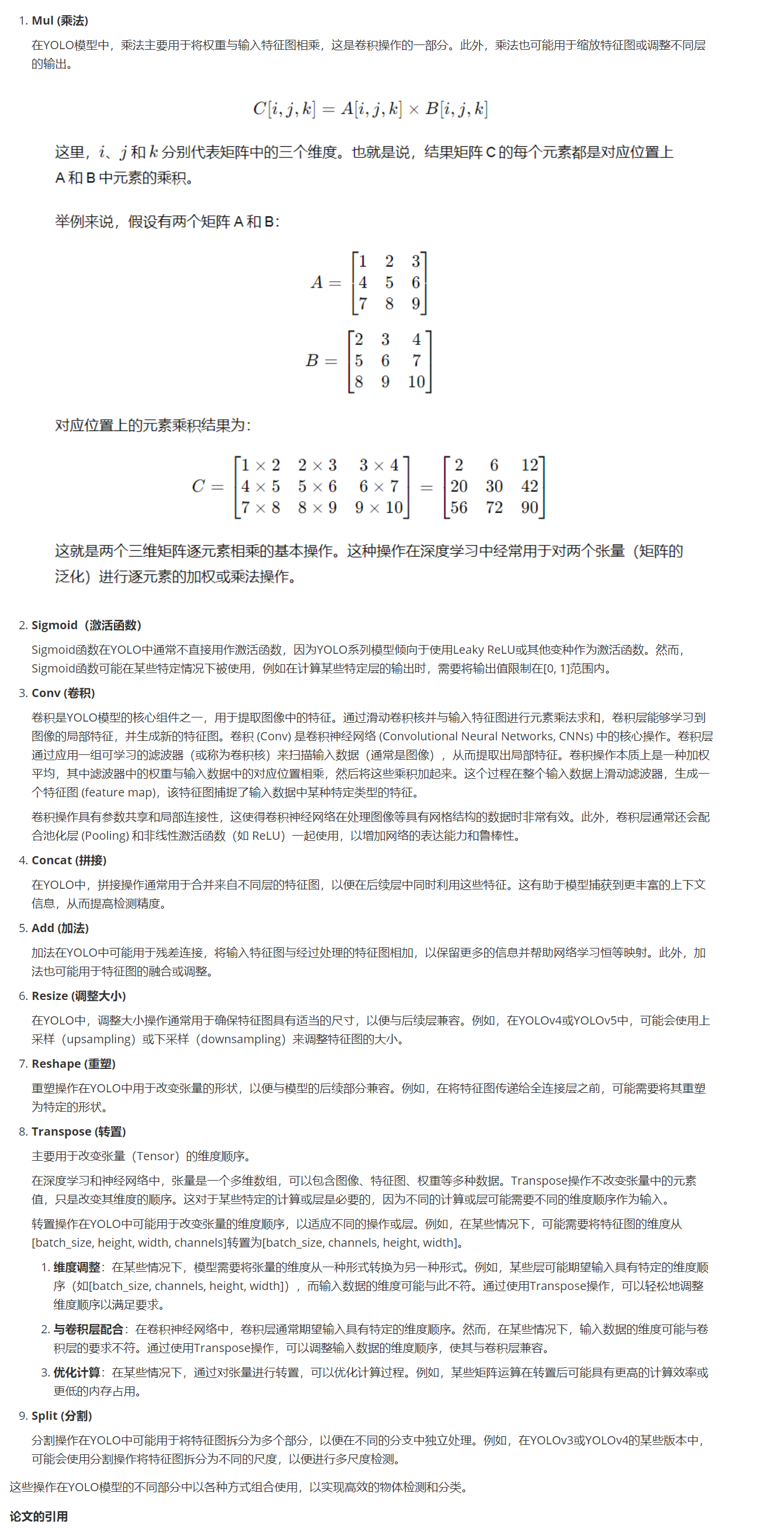

yolo模型中神经节点Mul与Sigmoid 和 Conv、Concat、Add、Resize、Reshape、Transpose、Split

yolo模型中神经节点Mul与Sigmoid 和 Conv、Concat、Add、Resize、Reshape、Transpose、Split 在YOLO(You Only Look Once)模型中,具体作用和用途的解释:

对keras.permute_dimensions和numpy.transpose空间维度转置过程的理解(Axis的理解)

keras.permute_dimensions和numpy.transpose,这两个函数的作用是对矩阵进行维度的转置, 具体请参考官方文档,这里只给出矩阵维度转置是怎么理解的? 1. 写在前面 今天遇到一个时间序列分析的任务,使用了Attention机制,看代码之后,有几个空间转置的过程其实有点懵。 所以通过查资料理解了一下空间维度转置,顺便理解了一下三维矩阵的沿着某一个轴的加法,我把自

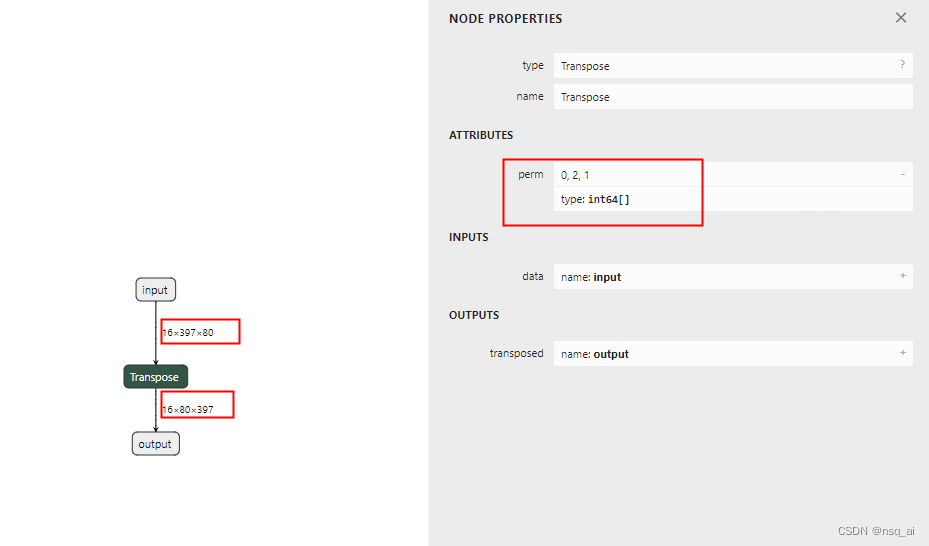

TensorRT转换onnx的Transpose算子遇到的奇怪问题

近来把一个模型导出为onnx并用onnx simplifier化简后转换为TensorRT engine遇到非常奇怪的问题,在我们的网络中有多个检测头时,转换出来的engine的推理效果是正常的,当网络中只有一个检测头时,转换出来的engine的推理效果奇差,类别得分经sigmoid()计算出来的很多很大的值,导致输出上百万个3D box,这明显不正常。 开始以为3D box的C++后处理解码部

tf.transpose()转置函数介绍

如果一个二维张量做转置,我们很清楚该怎么做;如果一个三维或者更高维张量做转置呢,这时候可能会比较麻烦,人工去做就容易出错。tensorflow中有一个函数可以帮我们做这个工作:tf.transpose() 函数定义: tf.transpose(a, perm=None, name=“transpose”) a待转置张量; perm转置方式,二维矩阵只有一种,高维矩阵有n!-1种,默认为None,

K.transpose(-1, -2)

代码片段 `K.transpose(-1, -2)`,这看起来是使用某种深度学习框架(例如 TensorFlow、Keras 或 PyTorch)中的转置操作。 `K.transpose` 是一个用于交换张量维度顺序的函数。在这个函数中,`-1` 和 `-2` 是维度索引,用于指定需要交换的维度。 具体来说,`-1` 表示最后一个维度,而 `-2` 表示倒数第二个维度。使用这两个索引作为参数,

numpy基础之transpose

1 numpy基础之transpose 用法 ndarray.transpose(*axes) 描述 根据axes将ndarray数组进行转置。 入参 axes:可选,元组或列表。若指定,则元素个数必须为数组轴大小(ndarray.ndim),元素值的范围为[0,1,2,…,ndarray.ndim-1],返回数组的第i个轴对应输入的轴编号。未指定,默认为range(ndarray.

理解pytorch系列:transpose是怎么实现的

在PyTorch中,transpose()是一种操作,它交换张量中两个指定维度的位置。实现这一点的关键在于不实际移动数据,而是通过改变张量的元数据(包括步长(stride)和尺寸(size))来达到效果。 举例来说,假设我们有一个形状为(3, 4)的二维张量,其内存布局为行优先(row-major)即C风格的。当我们对这个张量执行transpose(0, 1)操作时,我们期望该张量行变成列,列变

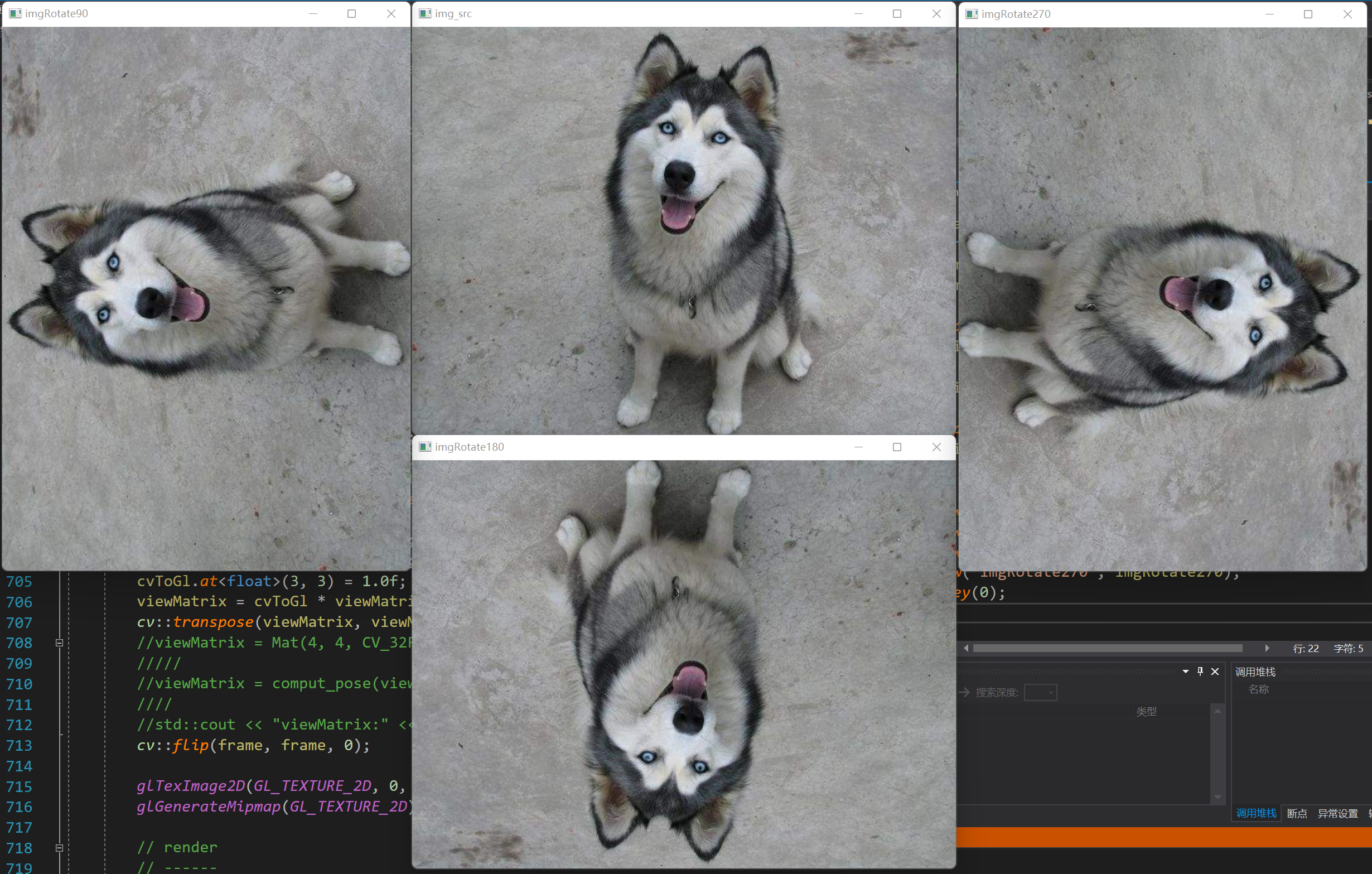

OpenCV学习笔记(一):flip和transpose

1.flip和transpose 1.1 flip // flipCOde:// 0:沿X轴翻转// 1:沿Y轴翻转// -1:既沿X轴翻转,又沿Y轴翻转,等价于旋转180度void flip(InputArray src, OutputArray dst, int flipCode); 测试代码: #include "opencv2/opencv.hpp"int main(i

867. Transpose Matrix

867. 转置矩阵 给定一个矩阵 A, 返回 A 的转置矩阵。 矩阵的转置是指将矩阵的主对角线翻转,交换矩阵的行索引与列索引。 示例 1: 输入:[[1,2,3],[4,5,6],[7,8,9]]输出:[[1,4,7],[2,5,8],[3,6,9]] 示例 2: 输入:[[1,2,3],[4,5,6]]输出:[[1,4],[2,5],[3,6]] 提示: 1 <= A

pytorch transpose 转置和梯度的传播

今天写代码的时候遇到一个需要进行转置的矩阵,由于涉及到梯度反传,所以有疑问转置之后的矩阵在转置之前的梯度是否存在,经过验证,转置不影响梯度的传播 import torchx = torch.ones(2, 2, requires_grad=True)y = x*8z = y.transpose(0,1)z=z*2out =z[0][0]# 求梯度 backward()out.back

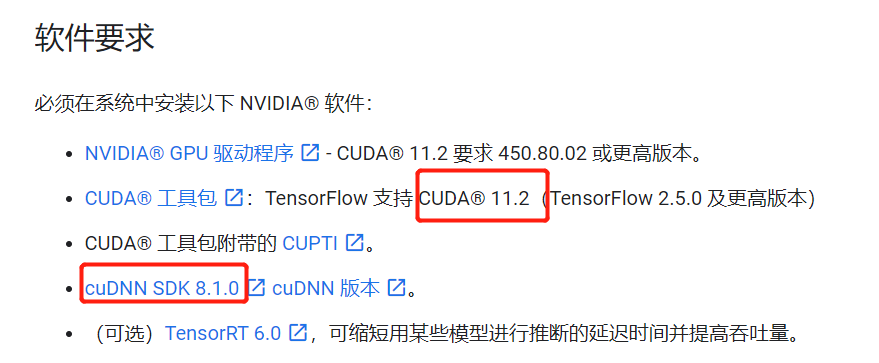

Node: ‘conv2d_transpose_1/conv2d_transpose/Conv2DBackpropFilter‘No algorithm worked Error messages

情况说明 用tensorflow在GPU上跑一个fit,模型里用到了两个卷积函数layers.Conv2D和layers.Conv2DTranspose epoch时出错,具体错误日志见下文,一开始Conv2D位置报错 解决过程 (1)搜索到一个类似的:No algorithm worked!,即代码开头加上以下设置 from tensorflow.config.experimental

pytorch中的transpose用法

注意:维数从0开始,0维 1维2维…,负数代表从右往左数,-1代表第一维,以此类推 import torchimport numpy as np# 创建一个二维数组arr = torch.tensor([[[1, 2],[3, 4]],[[5, 6],[7, 8]]])print("原始数组:")print(arr)# torch.transpose转置数组, dim的顺序谁先谁后没有关

4.7 构建onnx结构模型-Transpose

前言 构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构 本文主要是简单学习和使用两种不同onnx结构, 下面以transpose 结点进行分析 方式 方法一:pytorch --> onnx 暂缓,主要研究方式二 方法二: onnx import onnx from onnx im

数组行列转置神器Transpose被玩坏了

几天前的博文和大家分享了“Transpose实现数组行列转置的限制”。今天来看数组行列转置神器Transpose另一个奇特的用法。 以二维数组为例,一般情况下代码中引用二维数组的元素使用如a(x,y)的形式,可以称为普通二维数组,下图左侧为一个3x2的数组,共有6个元素。 其实,数组也可以有其他的形式,暂且称为嵌套二维数组(不确定是否有更专业的的

Tensorflow反卷积(conv2d_transpose)实现原理+手写python代码实现反卷积(DeConv)

1 反卷积原理 反卷积原理不太好用文字描述,这里直接以一个简单例子描述反卷积过程。 假设输入如下: [[1,0,1],[0,2,1],[1,1,0]] 反卷积卷积核如下: [[ 1, 0, 1],[-1, 1, 0],[ 0,-1, 0]] 现在通过stride=2来进行反卷积,使得尺寸由原来的3*3变为6*6.那么在Tensorflow框架中,反卷积的过程如下(不同框架在裁剪这步可

Pytorch:transpose、view、t()、contiguous()

日萌社 人工智能AI:Keras PyTorch MXNet TensorFlow PaddlePaddle 深度学习实战(不定时更新) 1.view(*args) → Tensor返回一个有相同数据但大小不同的tensor。 返回的tensor必须有与原tensor相同的数据和相同数目的元素,但可以有不同的大小。一个tensor必须是连续的contiguous()才能被查看。2