stand专题

Transformer系列-6丨LRNet和Stand-Alone Self-Attention网络解析

0. 前言 本次主要分享之前看的两篇将自注意力机制self-attention应用在视觉感知任务的文章,分别为LRNet和Stand-alone self-attention。为了深化读者的理解,本文提供了较为详细的中文注释的代码。 首先了解一下这两篇文章的背景,其都是在Vision Transformer(ViT)提出之前将transformer应用在感知任务上的尝试。尽管这些方法没有取得像

UVa 11174 Stand in a Line

依旧是《训练指南》上的一道例题。书上讲的比较抽象,下面就把解法具体一下。因为涉及到父子关系,因此自然而然可以将n个节点构造成一棵树,最后将形成一个森林。接下来将使用递归的手法。设f(i)是以节点i为树根的子树,节点i有儿子c1,c2,c3....cj共j棵子树。s[i]为树根为i的子树包含的节点数。如果分别先给各个子树内部排序,那么毫无疑问, 共有f(c1)*f(c2)*f(c3).

创建IOS 5 News Stand应用程序之一 – 外观

from:http://www.cocoachina.com/iphonedev/sdk/2011/1214/3724.html 1. 让程序运行于News Stand内 可以在Info.plist中添加 1 2 <key>UINewsstandApp</key> <true/> 或者直接在Xcode中更改Info.plist(如图): 就这么简

和Stand-up再次相遇

缘起 还是在13年的时候,彼时还在某福报厂做某旅行APP。当时在搞的一个大版本,团队里来了几个奇怪的人,不写代码,一来就拉着大家开会,往黑板上画好几个格子,贴一堆纸片,每天还坐在我们项目室监视我们,动不动往我们耳朵里扔各种没听过的专业词汇,燃尽图、sprint、scrum 等等等,早上还非要拉着团队开站会,要知道互联网公司晚上都是干到十一二点,尤其在上下班通勤平均需要1.5小时的大北京,早上十点

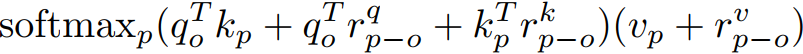

论文精读:Stand-Alone Self-Attention in Vision Models

论文地址:https://proceedings.neurips.cc/paper/2019/file/3416a75f4cea9109507cacd8e2f2aefc-Paper.pdf Abstract 提出问题:注意力机制是否可以成为视觉模型的独立原始元素,而不仅仅是卷积之上的增强。 作者验证了自注意力机制确实可以是一个有效的独立层。用应用于ResNe

论文精读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation

论文地址:https://arxiv.org/abs/2003.07853 Abstract 卷积利用局部性来提高效率,但代价是缺少长期上下文。自我注意已经被用来通过非局部的交互作用来增强cnn。最近的研究证明,通过将注意力限制在一个局部区域,可以通过叠加自注意层来获得一个完全的注意网络。本文试图通过将二维自注意分解为两个一维自注意来消除这一约束。这降低了计算的复杂度,并允许

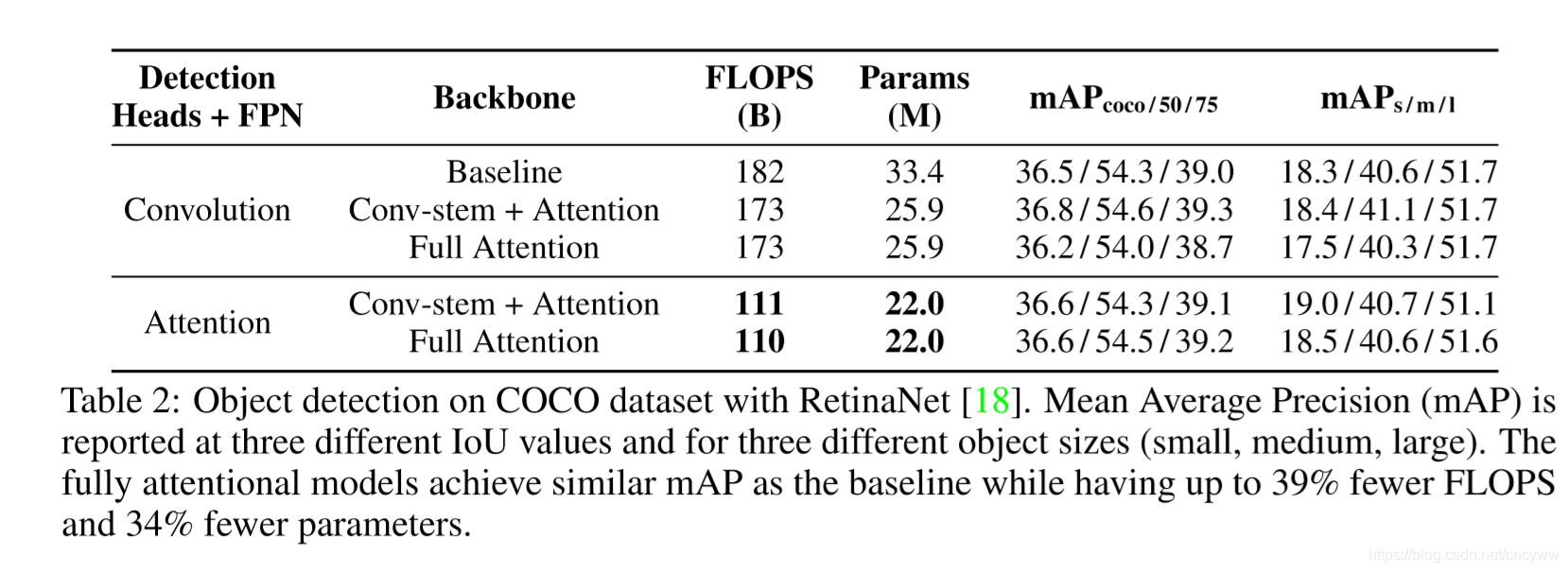

Stand-Alone Self-Attention in Vision Models

转自微信公众号 谷歌研究和谷歌大脑团队提出针对视觉任务的独立自注意力(stand-alone self-attention)层,用它创建的纯注意力(fully attentional)模型,在ImageNet分类任务和COCO目标检测任务中都超越了用卷积的基准模型,而且用了更少的浮点运算和更少的参数量。LearnX对具体内容整理如下。 在开始之前先对几个新的概念做一些解释。

Axial-DeepLab: Stand-Alone Axial-Attention for Panoptic Segmentation

Axis-DeepLab:用于全景分割的独立轴注意 Abstract 卷积利用局部性来提高效率,但代价是丢失长范围上下文。自我注意被用来通过非局部的相互作用来增强CNN。最近的研究证明,通过将注意力限制在局部区域来堆叠自我注意层来获得完全注意网络是可能的。在本文中,我们试图通过将二维自我注意分解为两个一维自我注意来消除这一限制。这降低了计算复杂度,并允许在更大甚至全局区域内进行注意。同时,我们

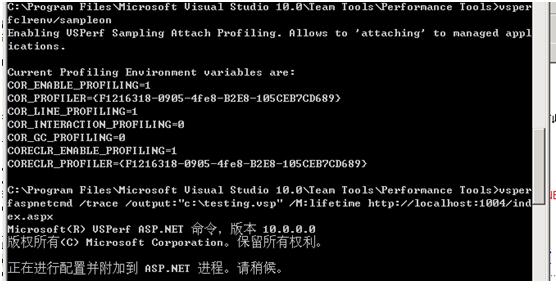

运用Stand-AloneProfiler

运用Stand-AloneProfiler 操作步骤: 1、安装VS _profiler,这里安装步骤省略 (注意:系统版本位数不同,安装的也不同) 2、配置用户级的系统环境变量, 把安装的路径设置在path中 3、启动doc命令窗口,进入PeopleTrax.exe程序存在路径。 4、输入:VSPerfCLREnv/sampleon //启动profilser环境 5、输入:

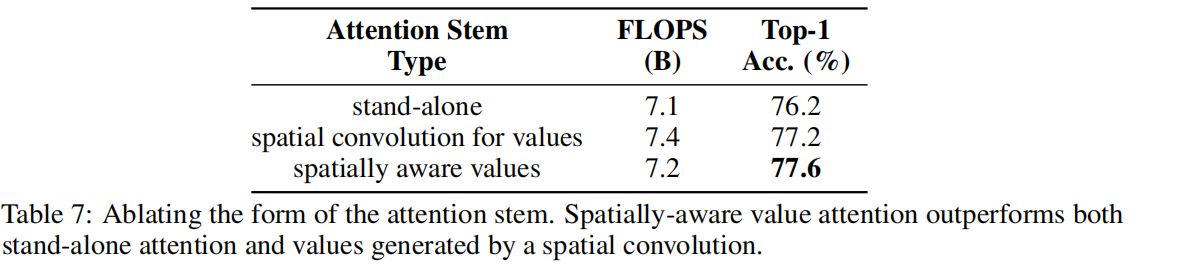

【PaperReading】Stand-Alone Self-Attention in Vision Models

论文链接:https://arxiv.org/abs/1906.05909 代码:https://github.com/leaderj1001/Stand-Alone-Self-Attention 启示 1. 提出了一种代替空间卷积的操作——self attention,可以有效结合self attention操作和原来的空间卷积操作,在网络的初期使用原来的空间卷积操作,而后面和各个he

Partitioning can not be used stand-alone in query .. mysql 创建分区

今天遇到一个狗血的问题,Partitioning can not be used stand-alone in query near 'PARTITION BY RANGE COLUMNS(stats_dt) (,其实是简单的错误,建立mysql分区时,语句,写错了,在在之前,多了一个分号,报错。 分号,应该在建表最后,分去最后才对。 简化示例如下: DROP TABLE IF

MYSQL创建分区时报错Partitioning can not be used stand-alone in query near 'partition by hash(id) partition

Partitioning can not be used stand-alone in query near 'PARTITION BY RANGE COLUMNS(stats_dt) 其实是简单的错误,建立mysql分区时,语句,写错了,在在之前,多了一个分号,报错。 分号,应该在建表最后才对。 分区不能单独创建,在建表的时候就要创建一个分区表。 需要分区的字段必须是在 prima

Can you stand on the shoulders of giants?

在图灵技术图书的封面上,都会有站在巨人肩膀上这句话,但是我们稍微思考一下,巨人的肩膀你真的站的上去吗?这些大师门的著作,我们是否真的能理解并实践呢? 学习任何知识,如果没有达到融汇贯通的境界,那么你的知识结构都是零散的。在中国古代,读书讲究有没有读通。这个通字很重要。如果没有读通,那么你就只能生搬硬套。学过的所有东西都是零散且有很多自相矛盾的地方。 那么怎么样融汇贯通呢?我个人认为,学习并实践

Linux-stand alone与super daemon

鸟哥的Linux私房菜--基础学习篇内谈到,在一般正常的Linux系统环境下,服务的启动与管理主要有两种方式: stand alone:顾名思义,stand alone就是直接执行该服务的可执行程序(执行档),让该可执行程序(执行档)直接载入到内存当中运作,用这种方式来启动可以让该服务具有较快速回应的优点。一般来说,这种服务的启动script都会放置到/etc/init.d/这个目录底下(貌

论文解读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation

论文是一个分割任务,但这里的方法不局限于分割,运用到检测、分类都可以。 论文下载 https://www.yuque.com/yuqueyonghupjh9oc/ovceh4/onilw42ux6e9n1ne?singleDoc# 《轴注意力机制》 一个问题 为什么transformer一开始都有CNN:降低H、W,降低self-attention计算规模O(特征点的个数^2,即(H*W)

英语单词学习归类,stand引发系列单词

先上缩略图 上面三个很常见,容易记住,下面的sist、stitute根据谐音就记住了,剩余destination、steady、instead很容易记。 展开图 详细解释 1 stand 1.1 understand v.理解 1.1.1 misunderstand v.误解 1.2 outstanding a. 杰出的 1.3 stadium n.运动场 1.3.