sbt专题

ubuntu14 手动安装sbt

参见官网配置说明http://www.scala-sbt.org/release/tutorial/Manual-Installation.html 1、下载sbt通用平台压缩包:sbt-0.13.5.tgz http://www.scala-sbt.org/download.html 2、建立目录,解压文件到所建立目录 $ sudo t

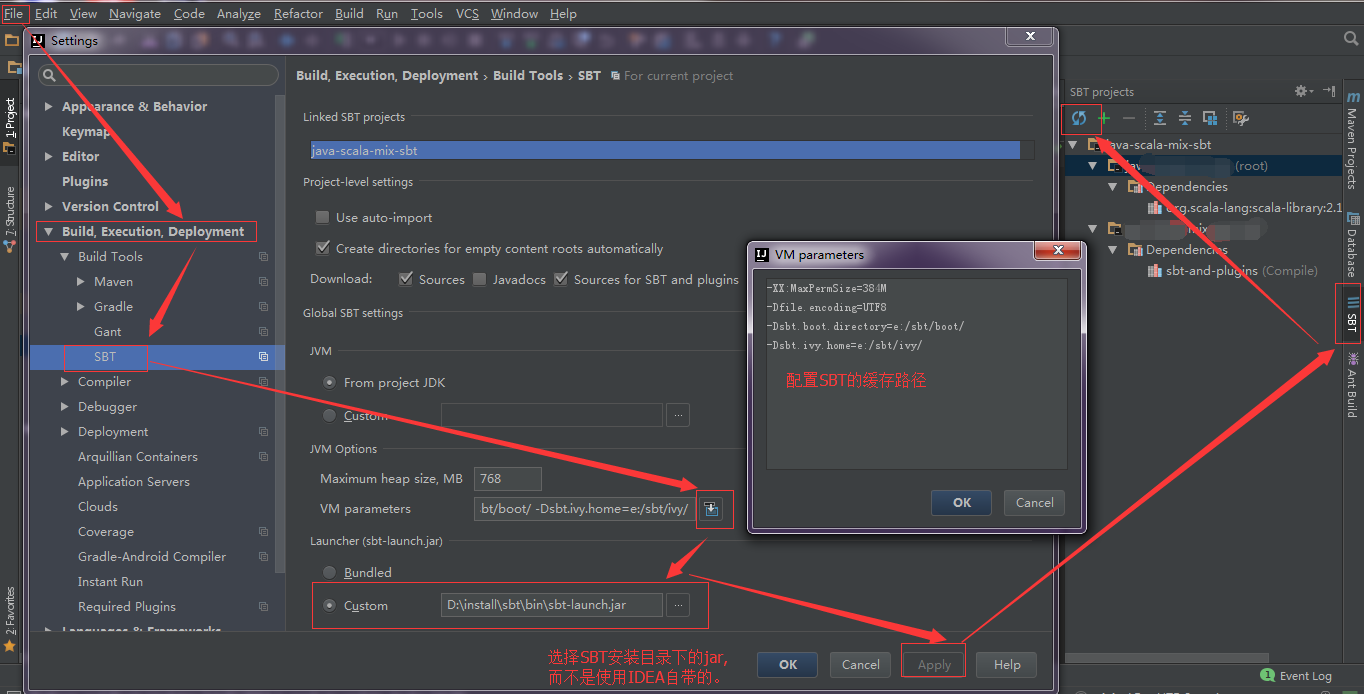

在windows7 IDEA sbt 插件安装配置教程

原文:http://blog.csdn.net/zrc199021/article/details/73543210 1. 在Windows中安装sbt 下载 官网: http://www.scala-sbt.org/ github: https://github.com/sbt/sbt/releases/download/v0.13.15/sbt-0.13.15.msi (

Intellij IDEA 手动安装Scala 和SBT

jetBrains sbt插件库https://plugins.jetbrains.com/plugin/5007-sbt jetBrains scala插件库https://plugins.jetbrains.com/plugin/1347-scala 注意版本对应问题,不然会报错 ‘plugin scala is incompatible‘ 。 下载好文件后,按如下步骤操作 一、打

使用SBT正确构建IndexedRDD环境

IndexedRDD由AMPLab的Ankur Dave提出,它是Immutability和Fine-Grained updates的精妙结合。IndexedRDD是一个基于RDD的Key-Value Store,扩展自RDD[(K, V)],可以在IndexRDD上进行高效的查找、更新以及删除。由于其并没有合并到 Spark 的主项目分支,所以在使用时需要引入特别的对其的支持。 Indexe

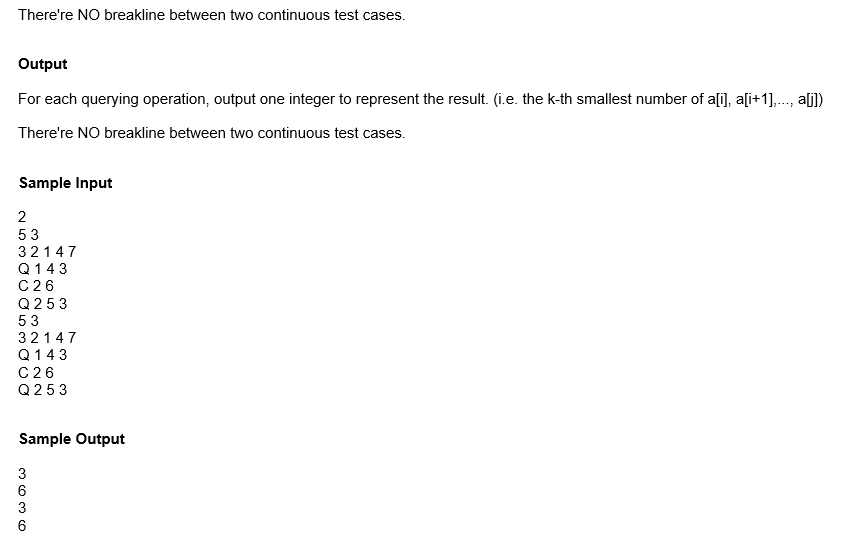

ZOJ 2112 Dynamic Rankings (动态区间第K大) (线段树套SBT+二分)

题目:支持修改数组元素的区间第k大。 看题解这道题是可以用树状数组套主席树做的,但是树状数组套主席树不优化空间的话,要140MB左右,这题只给了32MB。 没看懂怎么优化,只能用线段树套平衡树了,我写的是线段树套SBT,线段树的每个节点上的SBT存这个节点代表的区间的所有数。 修改操作就是对于叶节点到根的所有SBT删除旧元素再加入新元素,删除的元素把下标入栈,插入元素时优先从栈中取。

如何安装sbt(sbt在ubuntu上的安装与配置)(有详细安装网站和图解)

sbt下载官网 选择对应的版本和安装程序 Download | sbt (scala-sbt.org) 安装 解压 将sbt-1.9.0.tgz上传到xshell,并解压 解压: tar -zxvf sbt-1.9.0.tgz 配置 1、在/home/hadoop/sbt中创建sbt脚本 /home/hadoop/sbt 注意要改成自己的地址 cd

sbt下载依赖太慢解决记录及配置阿里Maven仓库

新机器上安装的sbt执行太慢,主要是下载依赖包比较慢,还容易因下载不成功报错: downloading https://repo1.maven.org/maven2/com/google/errorprone/error_prone_annotations/2.4.0/error_prone_annotations-2.4.0.jar ... [SUCCESSFUL ] com

使用Intellij idea编写Spark应用程序(Scala+SBT)

使用Intellij idea编写Spark应用程序(Scala+SBT) 对Scala代码进行打包编译时,可以采用Maven,也可以采用SBT,相对而言,业界更多使用SBT。 运行环境 Ubuntu 16.04 Spark 2.1.0 Intellij Idea (Version 2017.1) 安装Scala插件 安装Scala插件,该Scala插件自带SBT工具。如果已经安装Sca

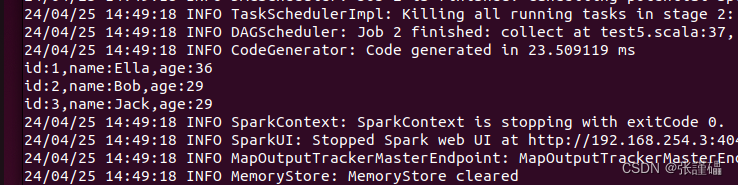

Intellj IDEA +SBT + Scala + Spark Sql读取HDFS数据

前提Spark集群已经搭建完毕,如果不知道怎么搭建,请参考这个链接: http://qindongliang.iteye.com/blog/2224797 注意提交作业,需要使用sbt打包成一个jar,然后在主任务里面添加jar包的路径远程提交即可,无须到远程集群上执行测试,本次测试使用的是Spark的Standalone方式 sbt依赖如下: Java代码 name := "

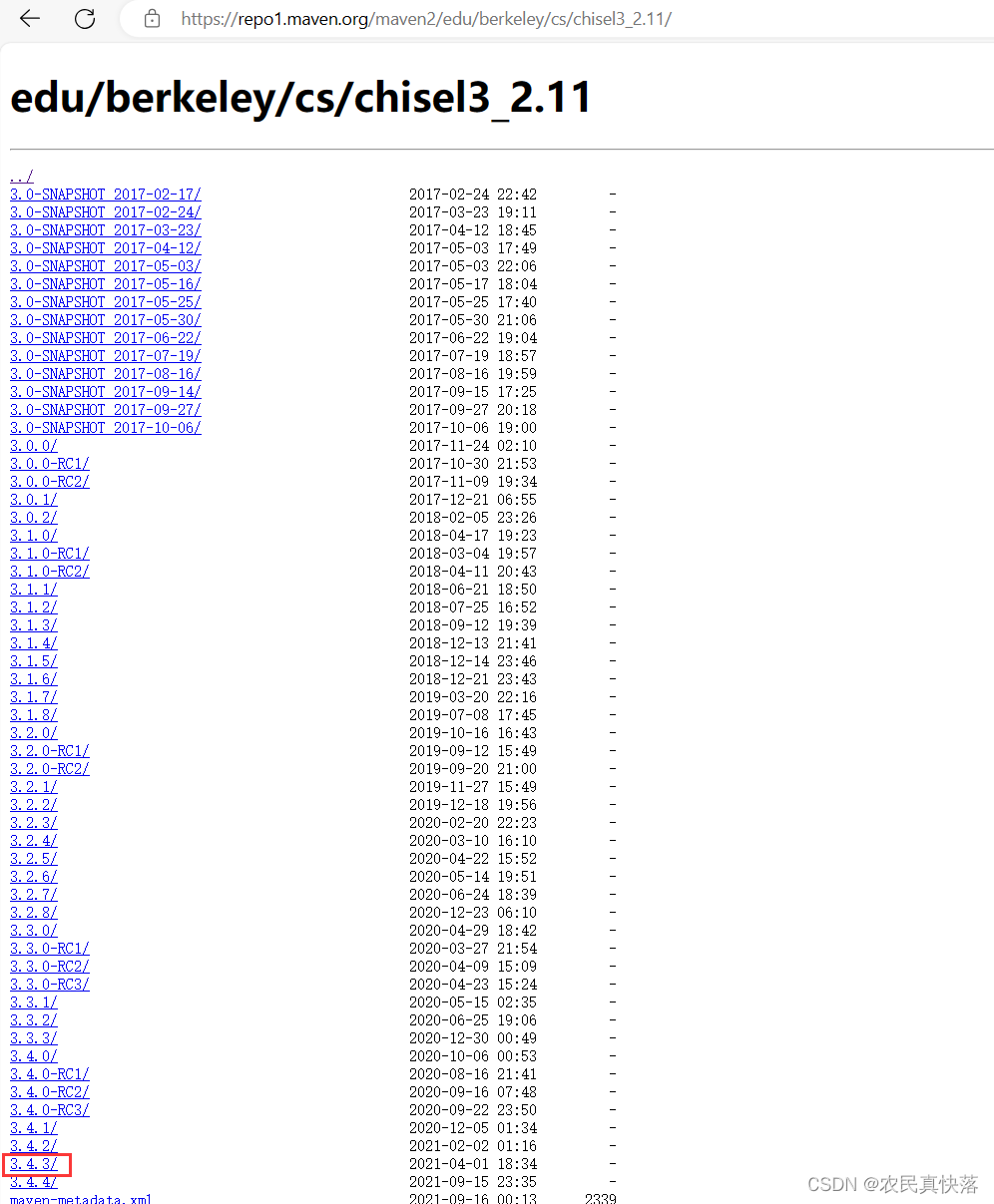

【异常处理】sbt构建Chisel库时出现extracting structure failed:build status:error的解决办法

文章目录 报错背景:解决思路:①IDEA中配置本地的SBT进行下载②更改下载源为华为的镜像站1. 修改sbtconfig.txt2. 增加repositories文件 ③查看报错信息 总结整理的Scala-Chisel-Chiseltest版本信息对应表 报错背景: 最近在写Chisel时,构建项目常常需要等待很久,然后报错extracting structure failed

docker 内sbt安装

安装 准备安装1.0 1) 官网安装方式 ubuntu和其他debian的发行版 echo "deb https://dl.bintray.com/sbt/debian /" | sudo tee -a /etc/apt/sources.list.d/sbt.listsudo apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --r

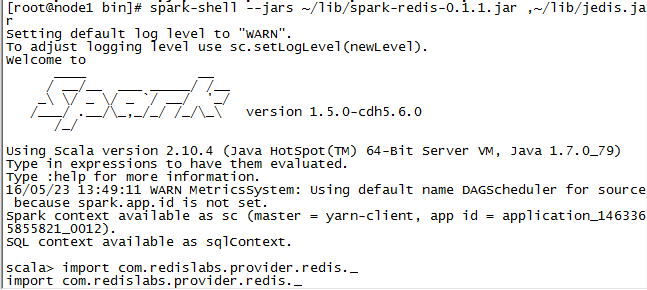

SBT编译spark-redis-master

spark-redis-master是用来让spark更简单地操作redis 将源码下载后解压缩到E盘,运行sbt,下载依赖jar包 run结果出错 采用官方教程 第一步:配置git,mvn命令 yum -y install gitgit --versionvim /etc/profileexport PATH=/usr/local/git/bin:$PATHsource

【模板】普通平衡树(Treap/SBT)||Splay

题目描述 您需要写一种数据结构(可参考题目标题),来维护一些数,其中需要提供以下操作: 插入 xx 数 删除 xx 数(若有多个相同的数,因只删除一个) 查询 xx 数的排名(排名定义为比当前数小的数的个数 +1+1 。若有多个相同的数,因输出最小的排名) 查询排名为 xx 的数 求 xx 的前驱(前驱定义为小于 xx ,且最大的数) 求 xx 的后继(后继定义为大于 xx ,且最小

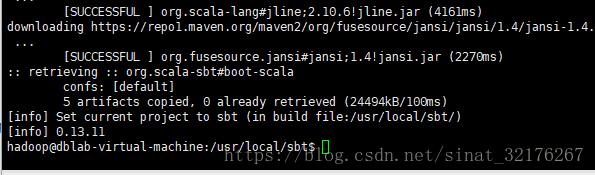

Spark打包方式SBT

下载sbt地址: sudo mkdir /usr/local/sbtsudo chown -R hadoop /usr/local/sbt # 此处的 hadoop 为你的用户名cd /usr/local/sbt 安装以后 把sbtlanuncher放在sbt目录下 接着在 /usr/local/sbt 中创建 sbt 脚本(vim ./sbt),添加如下内容: #!/bin

rman SBT_TAPE NFS disk 模拟NBU带库 FRA

-----------------rman 将本地磁盘变成磁带----------------------------------- ##RAC 本地 /nfs----两个备份策略 cluster=n run { allocate channel ch00 device type 'SBT_TAPE' PARMS="SBT_LIBRARY=oracle.disksbt, ENV=

Idea 建立sbt项目非常慢问题

问题:在国内通过idea建立sbt项目往往很慢,是因为镜像仓库在国外很慢 解决方案:配置国内镜像仓库 在sbt目录下配置文件,国内镜像文件,可以增加一个repo.repositories文件。 内容: [repositories]localNexus osc : http://maven.oschina.net/content/groups/public/Nexus osc th

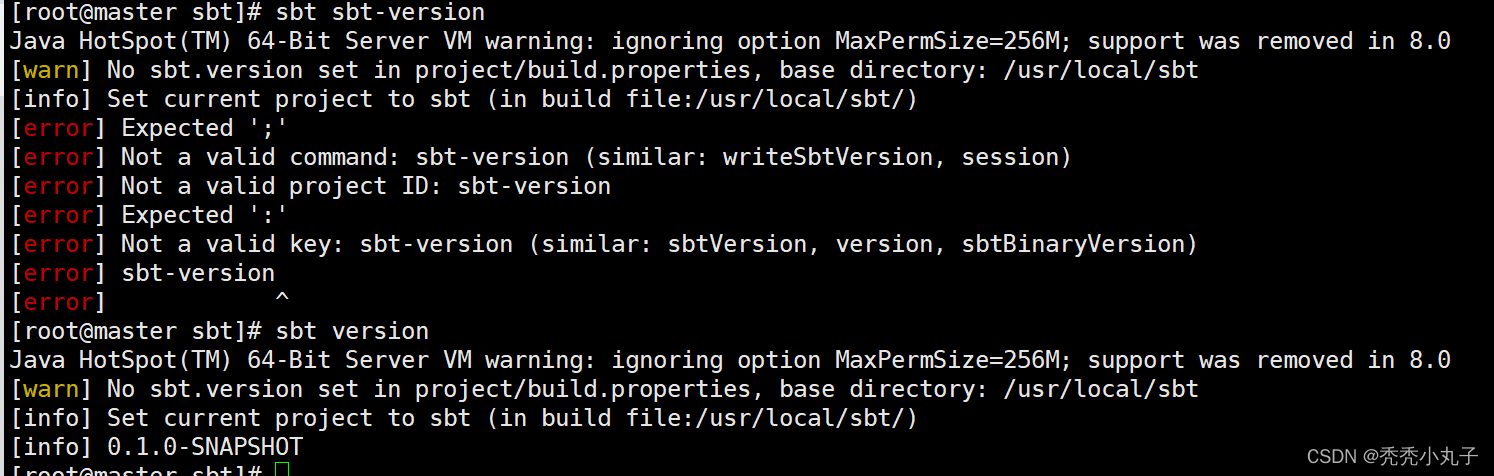

【已解决】Not a valid command: sbt-version (similar: writeSbtVersion, session)

如果报这个错的话 [info] Set current project to sbt (in build file:/usr/local/sbt/) [error] Expected ';' [error] Not a valid command: sbt-version (similar: writeSbtVersion, session) [error] Not a valid projec

Windows下IDEA,Git,SBT整合详解

IDEA,Git,SBT,Java,Scala的相关安装不做过多累述。 版本: jdk7 sbt-0.13.5.zip scala-2.11.7.tgz IDEA2016 Git-1.9.0 本文采用GitHub作为远程仓库。 首先创建一个远程仓库。 然后Clone远程仓库到本地。 在IDEA中创建一个SBT项目,如下图所示。 创建完成之后,进行相关配置。 然后

使用Idea创建Scala项目报错scalac: Error: Error compiling the sbt component ‘compiler-interface-2.10.0-52.0‘

错误日志: scalac: Error: Error compiling the sbt component 'compiler-interface-2.10.0-52.0' sbt.internal.inc.CompileFailed: Error compiling the sbt component 'compiler-interface-2.10.0-52.0' at sbt.

Error:scalac: Error: Error compiling the sbt component compiler-interface-2.11.8-55.0

错误 ```java Error:scalac: Error: Error compiling the sbt component ‘compiler-interface-2.11.8-55.0’ sbt.internal.inc.CompileFailed: Error compiling the sbt component ‘compiler-interface-2.11.8-55.0’ a

[ Scala ]关于scala环境搭建过程中,sbt编译中maven下载失败的解决方案(改成阿里的maven仓库)...

最近应公司要求开始研究Spark,把《Learning Spark》看完后发现有必要学习一下Scala这门语言,而且百度一下发现广大码农对Scala普遍反映良好,学习兴趣浓厚。 Scala环境搭建过程中发现《Programming Scala》中提及了sbt环境的安装(不用搭建sbt仅用idea也可以实现scala开发),下载安装scala并配置环境变量,然后打开cmd,执行: 1 sbt t

sbt.internal.inc.CompileFailed: Error compiling the sbt component ‘compiler-interface-2.11.8-61.0‘

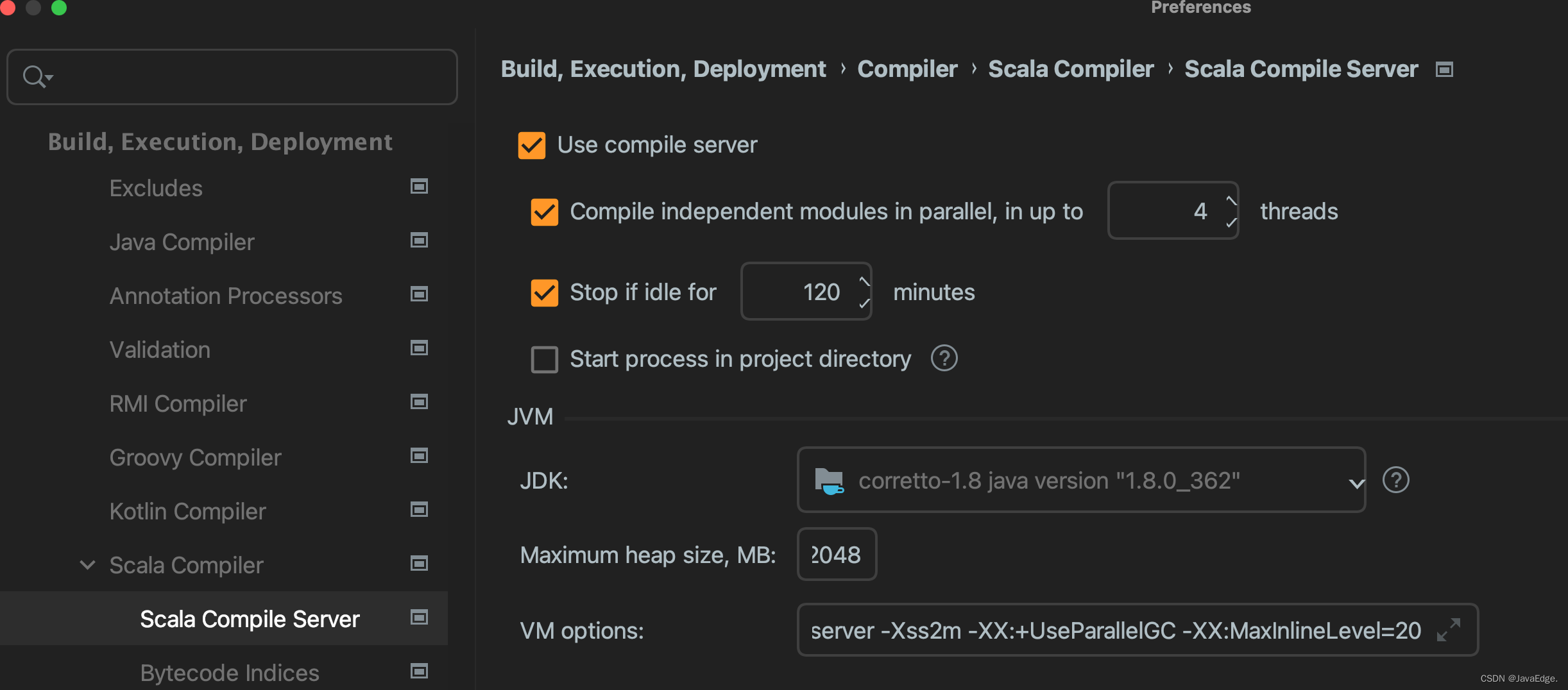

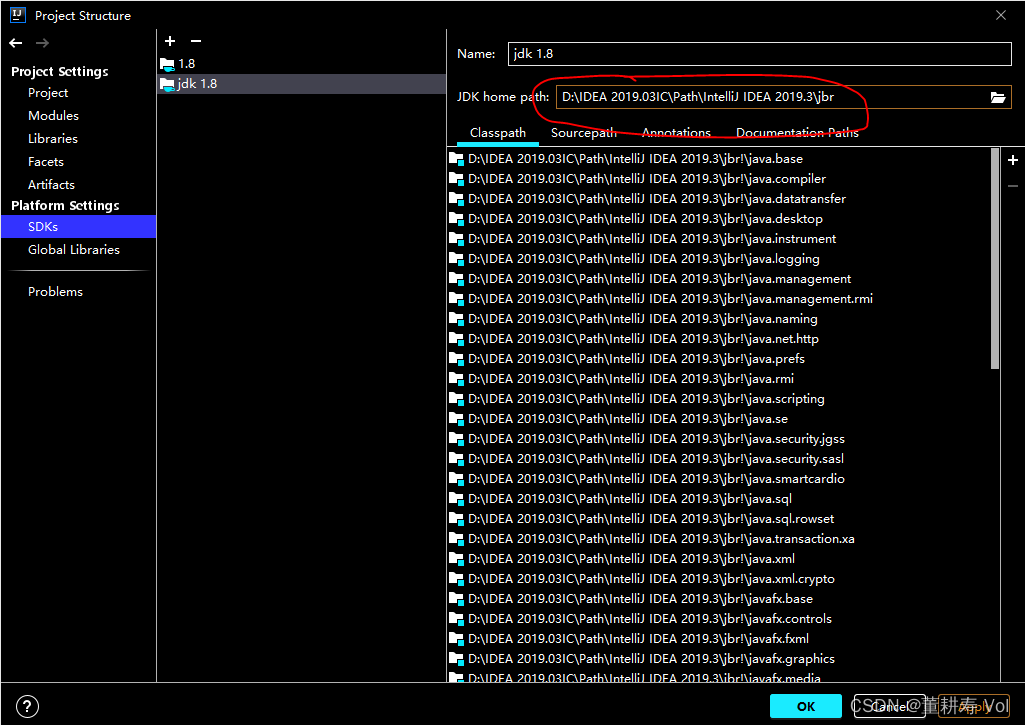

IDEA 的 JDK 和 Scala 版本对应不上。 使用 Scala12.1.8配上 JDK8 修改此处即可:

Error: Error compiling the sbt component ‘compiler-interface-2.11.8-55.0‘ sbt.internal.inc.CompileFa

Error: Error compiling the sbt component ‘compiler-interface-2.11.8-55.0’ sbt.internal.inc.CompileFailed

使用idea sbt运行spark程序

scala-sbt 项目(参考 http://blog.sina.com.cn/s/blog_5742944d0102vfwo.html) 2.待sbt及相关依赖下载完成后,配置spark依赖 spark 2.0.0后,目录下没有lib文件夹,也找不到assembly jar包,实际上该jar已经分拆成了spark安装目录下的jars文件夹下的各jar包。导入依赖如下 打开idea - fi

![[ Scala ]关于scala环境搭建过程中,sbt编译中maven下载失败的解决方案(改成阿里的maven仓库)...](https://images2015.cnblogs.com/blog/754612/201703/754612-20170310223638748-1626939112.jpg)