本文主要是介绍Spark打包方式SBT,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

下载sbt地址:

sudo mkdir /usr/local/sbt

sudo chown -R hadoop /usr/local/sbt # 此处的 hadoop 为你的用户名

cd /usr/local/sbt安装以后 把sbtlanuncher放在sbt目录下

接着在 /usr/local/sbt 中创建 sbt 脚本(vim ./sbt),添加如下内容:

#!/bin/bash

SBT_OPTS="-Xms512M -Xmx1536M -Xss1M -XX:+CMSClassUnloadingEnabled -XX:MaxPermSize=256M"

java $SBT_OPTS -jar `dirname $0`/sbt-launch.jar "$@"保存后,为 ./sbt 脚本增加可执行权限:

chmod u+x ./sbt

运行命令检查是否可用。

./sbt sbt-version

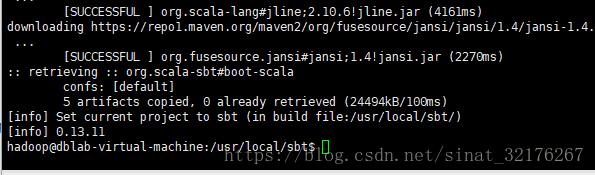

过程会比较慢,如果有VPN更快些的,成功后的截图如下:

以下例子是使用SBT在linux上进行SparkStreaming代码的编写

在调试Spark Streaming应用程序的时候,我们可以使用streamingContext.queueStream(queueOfRDD)创建基于RDD队列的DStream。

下面是参考Spark官网的QueueStream程序设计的程序,每隔1秒创建一个RDD,Streaming每隔2秒就对数据进行处理。

请登录Linux系统,打开一个终端,进入Shell命令提示符状态,然后执行下面命令新建代码文件:

- cd /usr/local/spark/mycode/streaming/src/main/scala //这个目录在前面章节操作中已经创建好了

- vim TestRDDQueueStream.scala

Shell 命令

上面用vim编辑器新建了一个TestRDDQueueStream.scala文件,请在该文件中输入以下代码:

package org.apache.spark.examples.streaming

import org.apache.spark.SparkConf

import org.apache.spark.rdd.RDD

import org.apache.spark.streaming.StreamingContext._

import org.apache.spark.streaming.{Seconds, StreamingContext}object QueueStream {def main(args: Array[String]) {val sparkConf = new SparkConf().setAppName("TestRDDQueue").setMaster("local[2]")val ssc = new StreamingContext(sparkConf, Seconds(20))val rddQueue =new scala.collection.mutable.SynchronizedQueue[RDD[Int]]()val queueStream = ssc.queueStream(rddQueue)val mappedStream = queueStream.map(r => (r % 10, 1))val reducedStream = mappedStream.reduceByKey(_ + _)reducedStream.print()ssc.start()for (i <- 1 to 10){rddQueue += ssc.sparkContext.makeRDD(1 to 100,2)Thread.sleep(1000)}ssc.stop()}

}

然后,我们用sbt进行打包编译。我们可以直接使用前面章节已经创建好的simple.sbt文件,如果你没有学习前面章节,还没有创建simple.sbt文件,请按照下面方法来创建simple.sbt(如果已经存在该文件,这里就不用重复创建):

- cd /usr/local/spark/mycode/streaming

- vim simple.sbt

上面用vim编辑器新建一个simple.sbt文件,请在该文件中输入以下代码:

name := "Simple Project"

version := "1.0"

scalaVersion := "2.11.8"

libraryDependencies += "org.apache.spark" %% "spark-streaming" % "2.1.0"

保存该文件并退出vim编辑器。然后,运行下面命令使用sbt打包编译:

- cd /usr/local/spark/mycode/streaming

- /usr/local/sbt/sbt package

打包成功后,执行下面命令运行程序:

- cd /usr/local/spark/mycode/streaming

- /usr/local/spark/bin/spark-submit --class "org.apache.spark.examples.streaming.QueueStream" /usr/local/spark/mycode/streaming/target/scala-2.11/simple-project_2.11-1.0.jar

如果无法看到类似上面的屏幕信息,请修改log4j的设置,首先在终端内输入如下命令:

- cd /usr/local/spark/conf

- vim log4j.properties

Shell 命令

打开后,要把其中的rootCategory设置为如下:

log4j.rootCategory=INFO, console这篇关于Spark打包方式SBT的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!