padded专题

DESUtils 加解密时 Given final block not properly padded bug小记

事情的经过是这个样子的。。。。。。 先说说问题是怎么出现的。根据客户需求,需要完成一个一键登录的功能,于是我的项目中就诞生了DesUtil,但是经过上百次用户测试,发现有一个用户登录就一直报错!难道又遇到神坑啦!!发火 让我们先看看源代码,干货来了! package com.kwp.main.util.security;import java.io.IOException;import

javax.crypto.BadPaddingException: Given final block not properly padded解决方案

JAVA的AES加密解密在windows上测试一切正常,上传到空间上在解密时就出现错误。空间是Linux系统 查看日志发现出现此异常 javax.crypto.BadPaddingException: Given final block not properly padded 后面百度了一下终于解决了,在生成key的时候出现错误的 原来的代码: private Key initKeyFo

[tf 2.0] padded_batch_use

参考: tf2.0中输出 不用sess.run https://stackoom.com/question/3nd25/%E5%BB%BA%E8%AE%AE%E5%9C%A8tensorflow-%E4%B8%AD%E8%B0%83%E8%AF%95-tf-data-Dataset-%E6%93%8D%E4%BD%9Cpadded_batch用法 https://blog.csdn.net/z2

javax.crypto.BadPaddingException: Given final block not properly padded. Suc

在在进行token加密解密的时候报错: javax.crypto.BadPaddingException: Given final block not properly padded. Suc 然后百度一下: 对着这哥们的修改一波: https://www.cnblogs.com/zempty/p/4318902.html 主要就是修改加密部分: 在linux上面 错误部分: priva

【mindspore】【API】如何实现pack_padded_sequence以及pad_packed_sequenc

问题描述: 在实现模型的过程中,移植的源码需要用到Pytorch提供的两个API的功能,即torch.nn.utils.rnn.pack_padded_sequence以及torch.nn.utils.rnn.pad_packed_sequenc。 不过好像没有在文档中找到相关API。。。 希望能得到帮助 【操作步骤&问题现象】 API 欠缺 【截图信息】 解答: M

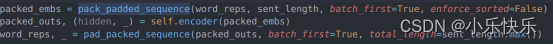

pytorch 笔记:PAD_PACKED_SEQUENCE 和PACK_PADDED_SEQUENCE

1 PACK_PADDED_SEQUENCE 1.0 功能 将填充的序列打包成一个更加紧凑的形式这样RNN、LSTM和GRU等模型可以更高效地处理它们,因为它们可以跳过不必要的计算 1.2 基本使用方法 torch.nn.utils.rnn.pack_padded_sequence(input, lengths, batch_first=False, enforce_sorted=True

pytorch nn.utils.rnn.pack_padded_sequence 分析

pack_padded_sequence 在nlp模型的forward方法中,可能有以下调用令读者疑惑 packed_embedded = nn.utils.rnn.pack_padded_sequence(embedded, text_lengths, batch_first=True, enforce_sorted=False) 为什么要使用pack_padded_sequence?

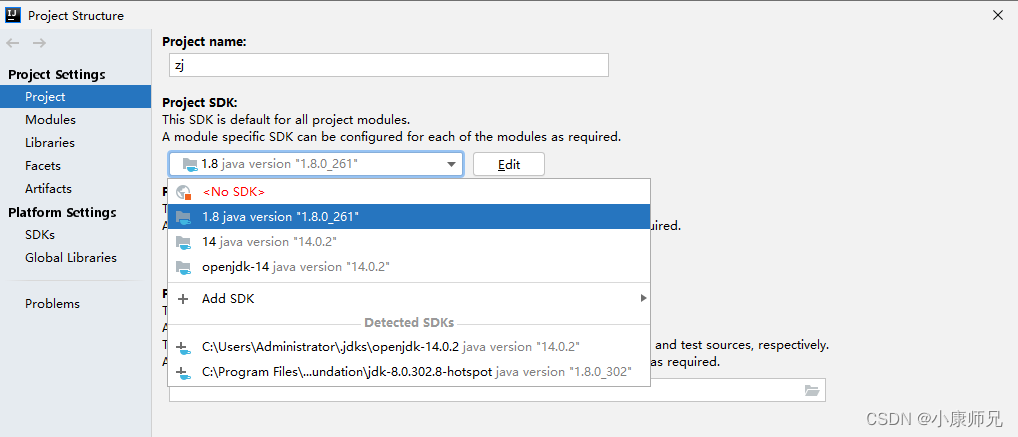

javax.crypto.BadPaddingException: Given final block not properly padded. Such issues can arise if a

文章目录 一、发现问题二、分析问题三、解决问题3.1 方法一:不要用openjdk3.2 方法二:修改KeyGenerator.init 四、全部源码 一、发现问题 javax.crypto.BadPaddingException: Given final block not properly padded. Such issues can arise if a bad ke

pytorch中 nn.utils.rnn.pack_padded_sequence和nn.utils.rnn.pad_packed_sequence

1. 官方文档: torch.nn — PyTorch 1.11.0 documentation 2. 应用背景: 在使用pytorch处理数据时,一般是采用batch的形式同时处理多个样本序列,而每个batch中的样本序列是不等长的,导致rnn无法处理。所以,通常的做法是先将每个batch按照最长的序列进行padding处理等长的形式。 但padding操作会带来一个问题,

pack_padded_sequence and pad_packed_sequence

此文章为阐述pytorch中pack_padded_sequence 和pad_packed_sequence的原理 在变长序列文本中,一个batch中的各样本长度可能不一致,在使用RNN模型时,需要填充至统一长度,被填充的位置实际无意义。我们通常取最后一个时刻的输出作为最终输出,但是填充后的最后时刻并非是原样本的最后时刻。为了获取每个样本真实的最后时刻位置输出,便有了pack_padded_s

![[tf 2.0] padded_batch_use](https://img-blog.csdnimg.cn/20200111171217673.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L1RyYW5jZTk1,size_16,color_FFFFFF,t_70)