openvino专题

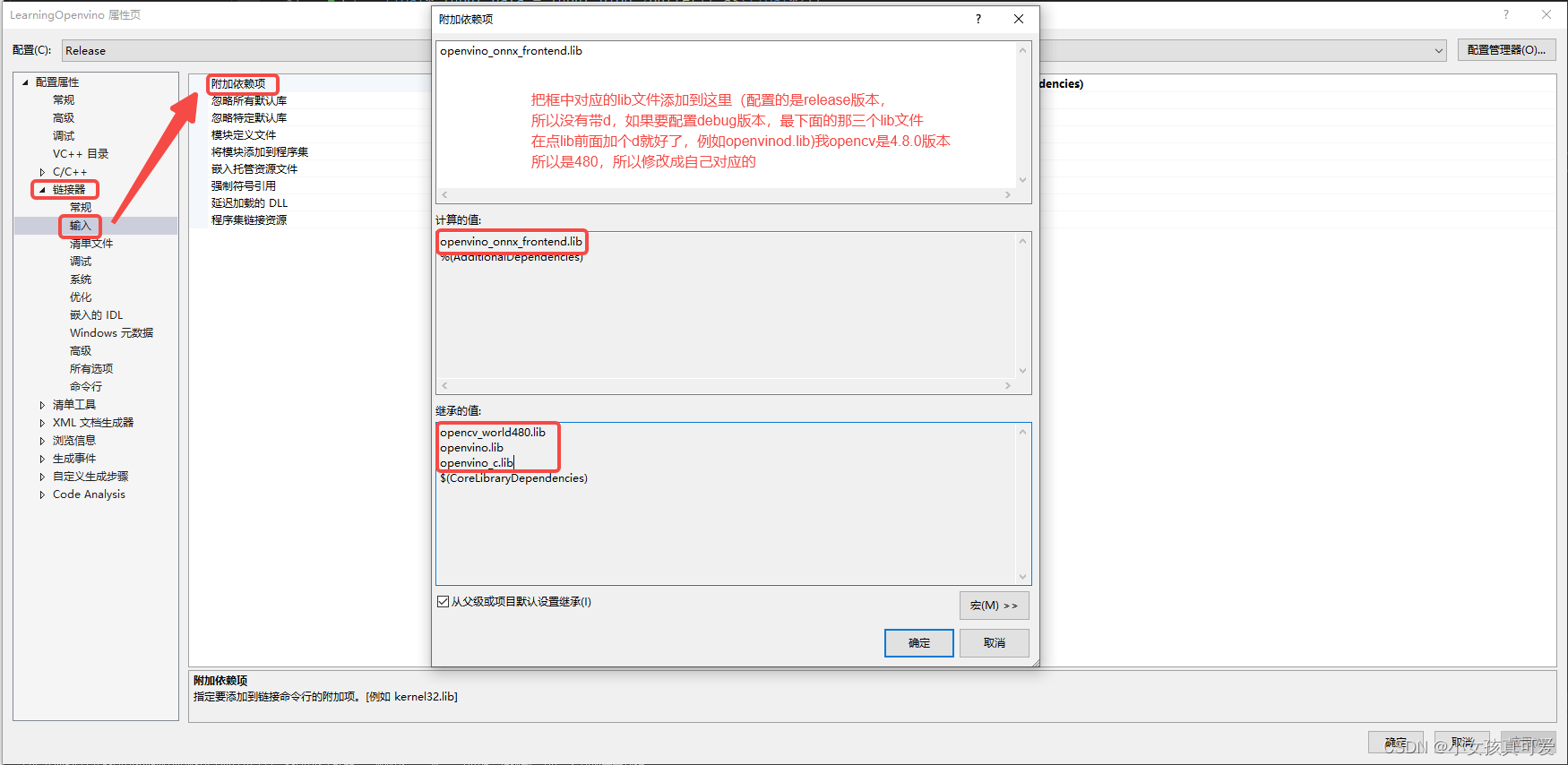

vs2022配置openvino环境(无需修改系统环境变量)

openvino版本:2022.3.0 opencv版本:4.8.0 配置openvino Release版本 (一)右键打开项目的属性 (二)配置opencv和openvino的环境(路径根据自己的安装路径进行修改)

【OpenVINO™】使用 OpenVINO™ C++ 异步推理接口部署YOLOv8 ——在Intel IGPU 上实现80+FPS视频推理

OpenVINO Runtime支持同步或异步模式下的推理。Async API的主要优点是,当设备忙于推理时,应用程序可以并行执行其他任务(例如,填充输入或调度其他请求),而不是等待当前推理首先完成。 当我们使用异步API时,第二个请求的传输与第一个推理的执行重叠,这防止了任何硬件空闲时间。 本文章中,我们以YOLOv8模型为例,对比了OpenVINO分别使用同步推理接口以及异步推理接口

基于OpenVINO实现无监督异常检测

异常检测(AD) 在欺诈检测、网络安全和医疗诊断等关键任务应用中至关重要。由于数据的高维性和底层模式的复杂性,图像、视频和卫星图像等视觉数据中的异常检测尤其具有挑战性。然而,视觉异常检测对于检测制造中的缺陷、识别监控录像中的可疑活动以及检测医学图像中的异常至关重要。 在本文中,您将学习如何使用OpenVINO 工具包中的FiftyOne和Anomalib对视觉数据执行异常检测。为

Windows下 CLion中,配置 OpenVINO,运行Yolov8

之前我们完成了Windows下 CLion中,配置 OpenCV、LibTorch,下面我们来装OpenVINO OpenVINO下载与安装 下载并解压OpenVINO Archives (当前测试了2024.1版本),记住路径,我的是:C:\Libraries\Intel\openvino_2024.1.0 然后下载yolov8_od_ov_infer.cpp 源码(感谢开源!) 自己编写

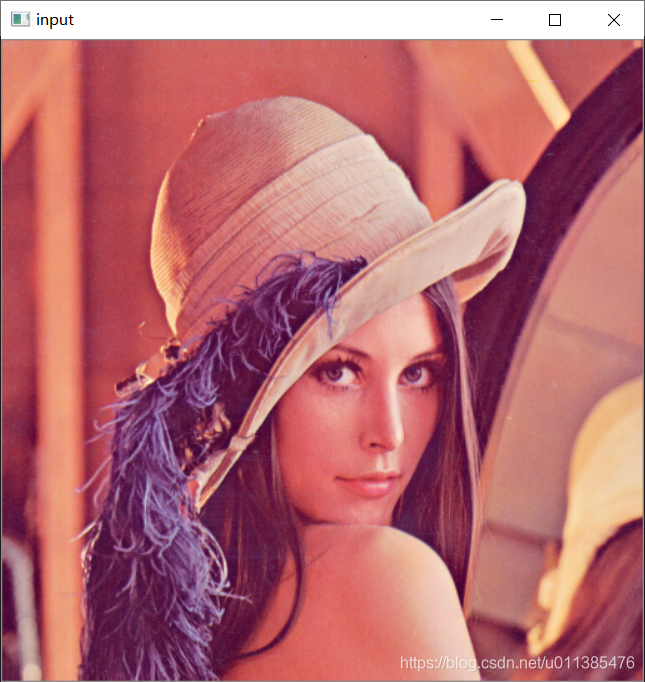

OpenVINO 学习笔记(4):使用 OpenCV

OpenVINO 学习笔记(4):使用 OpenCV 本节主要记录如何使用 OpenVINO 的 OpenCV 库。 1. 建立新项目 打开 VS2017 ,点击文件,再点击新建,最后点击项目,创建一个空项目。 2. 配置包含目录 打开 Debug | x64 属性页 ,在 VC++ 的包含目录添加以下内容 C:\IntelSWTools\openvino_2020.1.033\ope

OpenVINO 学习笔记(3):执行 OpenVINO Demos

执行 OpenVINO Demos 在 open_model_zoo 文件夹下,OpenVINO 给我们提供了许多 Demo ,今天我们就来学习怎么让这些 Demo 运行起来。 1. 编译 build_demos_msvc.bat 文件 打开 cmd ,进入以下目录:C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_

OpenVINO 学习笔记(2):安装并配置 OpenVINO

安装并配置 OpenVINO 1. 准备工作 在安装 OpenVINO 之前,我们必须先安装一些软件 带有 MSBuild 的 VS2015,VS2017 或 VS2019CMake 64 位的 3.4 版本或更高版本 (如果是安装的 VS2019 ,则 CMake 必须在 3.16 版本或更高版本)Pyhton 64 位的 3.6.5 我的软件版本: VS2017 社区版CMake 3.16

OpenVINO 学习笔记(1):OpenVINO 介绍

OpenVINO 介绍 主要介绍 OpenVINO,包括 OpenVINO 的简介以及 OpenVINO 工具包的组件。 1. OpenVINO 简介 OpenVINO 是英特尔基于自身现有的硬件平台开发的一种可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,支持各种英特尔平台的硬件加速器上进行深度学习,并且允许直接异构执行。 2. OpenVINO 工具包的组件:

【OpenVINO™】在C#中使用 OpenVINO™ 部署 YOLOv10 模型实现目标

文章目录 1. 前言1.1 OpenVINO™ C# API1.2 YOLOv10 2. 模型获取2.1 源码下载2.2 配置环境2.3 下载模型 3. Yolov10 项目配置3.1 项目创建与环境配置3.2 定义模型预测方法3.2.1 定义目标检测模型方法3.2.2 使用OpenVINO™ 预处理接口编译模型 3.2 模型预测方法调用 4. 项目运行与演示4.1 项目编译和运行4.2 Y

OPENVINO官方开发进阶教程

http://v.eepw.com.cn/video/playlist/id/5548 OpenCV+Python计算机视觉导学——目录汇总 http://forum.eepw.com.cn/thread/337725/1

OpenVINO安装教程 Docker版

从 Docker 映像安装Intel®Distribution OpenVINO™ 工具套件 本指南介绍了如何使用预构建的 Docker 镜像/手动创建镜像来安装 OpenVINO™ Runtime。 Docker Base 映像支持的主机操作系统: Linux操作系统 Windows (WSL2) macOS(仅限 CPU exectuion) 您可以使用预构建和发布的

使用OpenVINO在本地CPU运行大模型的过程

1. 引入 OpenVINO 工具套件是Intel开源的工具,可以在CPU上加速 AI推理过程。主要是用在CPU场景下的,在Intel的硬件上使用。 本文在CPU上实测一下OpenVINO运行大模型ChatGLM3-6b的运行效果,并记录整个过程。 2. 测试环境 在如下配置的笔记本上进行实测: Windows 11 家庭中文版,CPUAnaconda3-2024.02-1-Windows

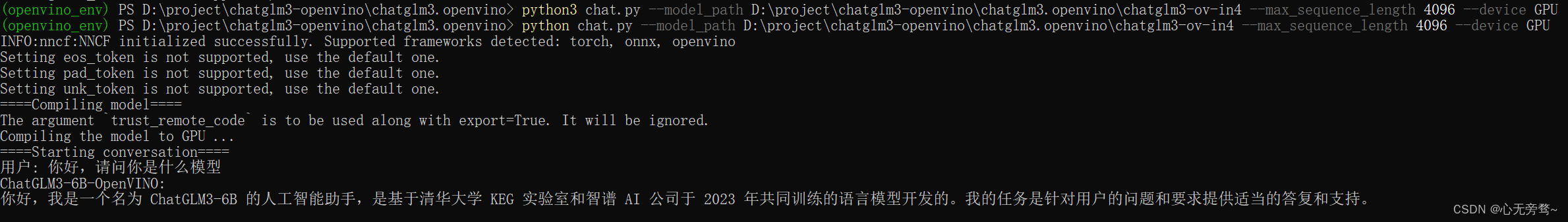

本地部署openvino-chaglm3-6b

chatglm3.openvino Demo: https://github.com/OpenVINO-dev-contest/chatglm3.openvino/tree/main 想将github下的代码拉取到本地文件夹中,再打开Windows PowerShell,执行以下命令激活环境。 python -m venv openvino_env.\openvino_env\Scripts\

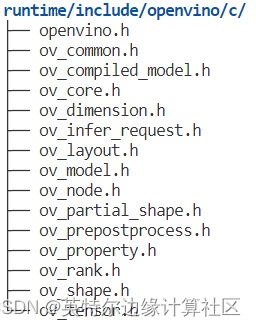

OpenVINO 的 C API 2.0 有何新特性?

作者:武卓 博士;River Li;Peter Chen 您是否准备好在新的一年体验英特尔® OpenVINO™ 工具套件分发版的最新长期支持 (LTS) 版本?OpenVINO™ 2022.3 LTS 版本现已发布,可帮助您快速轻松地开发卓越的人工智能应用,并跨边缘和云端部署深度学习推理工作负载,无论您处于人工智能编程的什么阶段。 作为人工智能开发人员,无论您希望将 OpenVINO 用于

OpenVINO™ DEVCON 中国系列工作坊 2024

活动报名链接:OpenVINO™ DEVCON 中国 系列工作坊 2024 DEVCON 2024 全面升级,全新启航!洞悉行业趋势,分享技术干货、演示 Demo 操作,全方位助力开发者系统进阶,稳步提升技术实力!不容错过! 英特尔每月定期举办的工作坊研讨会,诚邀您的参与,共同探索混合 AI 、边缘 AI 、AI PC 以及生成式 AI 应用的优化之道。 ✓实时掌握人工智能领域的前沿动态

玩转OpenVINO之二:试运行mask_rcnn_demo

调试open_model_zoo/mask_rcnn_demo 接前面一篇,编译好了DEMO,我们继续玩转OpenVINO,试一下open_model_zoo中的模型。 假设你要调试open_model_zoo中的某个模型(注意,下面的命令中,使用你自己想用的模型,我一般是好几个同时转换,完了随机测试的)。 先是要完成Optimizer工作,转换模型得到IR文件, 命令如下 python

玩转OpenVINO之一:cpp samples和demo的编译

今天开始,决定给最新版的OpenVINO留个纪念,写一个OpenVINO的使用系列吧。 原来还想写个源码解析什么,但Optimizer代码才看了一点就觉得这事该免了,暂时不打算细写了,主要原因是代码量比pytorch/mxnet等这些框架还要大,而且各个模块之间关系复杂,不是一朝半天能说明白的。 能写到哪里,目前还不知道,但前面已经有过一些经历,又因为没有时间写太具体的教程,只能是在回过头来看

初试Docker desktop与OpenVINO DL Workbench的使用入门

一,初试Docker desktop 你可以使用WIN+R 输入powershell启动powershell,也可以用anaconda的powershell 快捷方式,我选择用anaconda-powershell,进入命令界面后开始测试 运行: docker --version (base) PS C:\Users\space> docker --version Docker versio

OpenVINO+Yolov5+Windows10的CPU部署

主要是记录一些参考网址,顺便记录一些废话。。。 在windows上,有时部署还是挺痛苦的,相对部署的人比较少,参考资料也不多,很多模型要自己去摸索。OpenVINO的话主要看官方的模型。 为了在Windows上部署模型,通常我们可以这样做: (1)可以选择一些比较容易或别人已经部署过的模型。 (2)在没有GPU的情况下,一般用NCNN比较容易成功。本人多次在windows上编译过这个短小精悍的

YOLOv7-Openvino和ONNXRuntime推理【CPU】

纯检测系列: YOLOv5-Openvino和ONNXRuntime推理【CPU】 YOLOv6-Openvino和ONNXRuntime推理【CPU】 YOLOv8-Openvino和ONNXRuntime推理【CPU】 YOLOv7-Openvino和ONNXRuntime推理【CPU】 YOLOv9-Openvino和ONNXRuntime推理【CPU】 跟踪系列: YOLOv5/6/7-O

YOLOv5-Openvino-ByteTrack【CPU】

纯检测如下: YOLOv5-Openvino和ONNXRuntime推理【CPU】 YOLOv6-Openvino和ONNXRuntime推理【CPU】 YOLOv8-Openvino和ONNXRuntime推理【CPU】 YOLOv9-Openvino和ONNXRuntime推理【CPU】 注:YOLOv5和YOLOv6代码内容基本一致! 全部代码Github:https://github.c

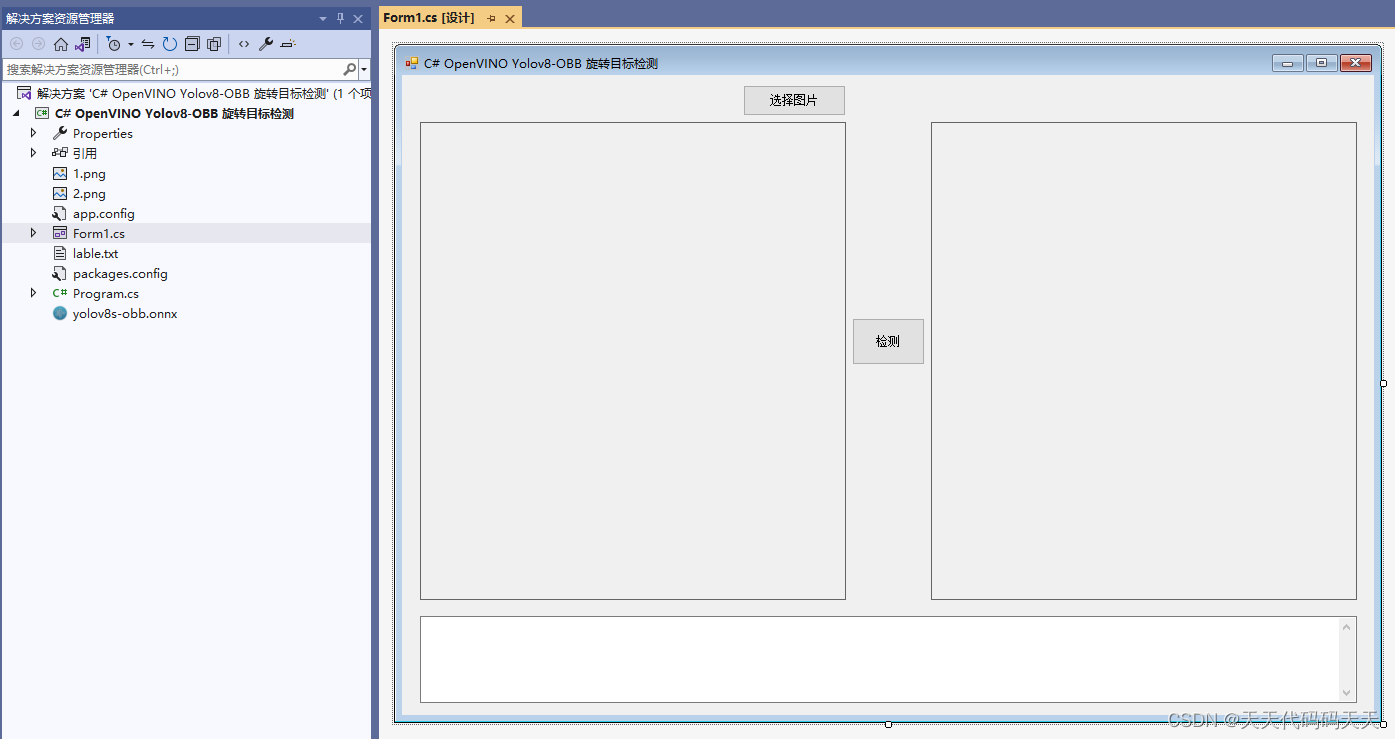

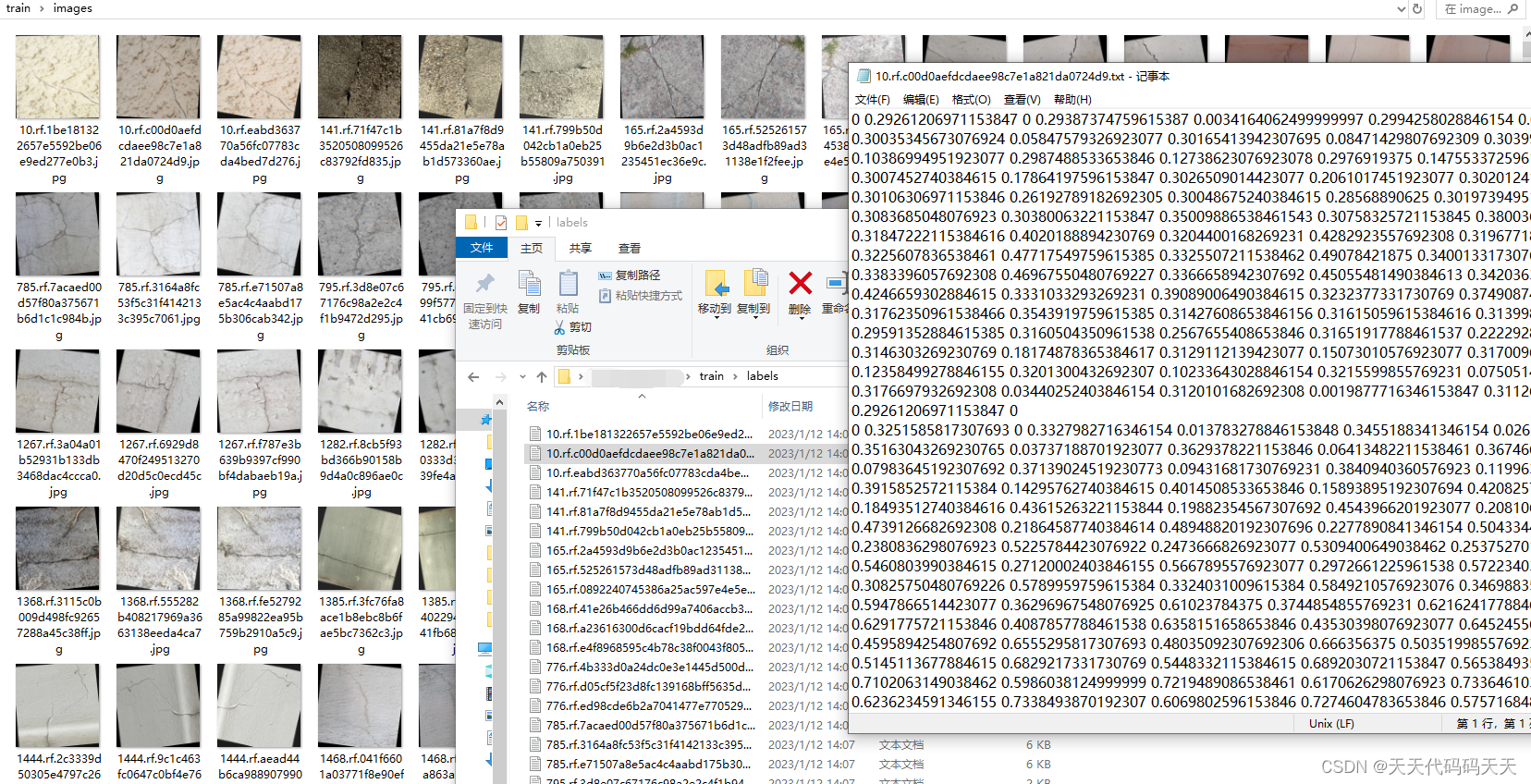

C# OpenVINO Yolov8-OBB 旋转目标检测

目录 效果 模型 项目 代码 下载 C# OpenVINO Yolov8-OBB 旋转目标检测 效果 模型 Model Properties ------------------------- date:2024-02-26T08:38:44.171849 description:Ultralytics YOLOv8s-obb model trained on runs

YOLOv8-Openvino-ByteTrack【CPU】

纯检测如下: YOLOv5-Openvino和ONNXRuntime推理【CPU】 YOLOv6-Openvino和ONNXRuntime推理【CPU】 YOLOv8-Openvino和ONNXRuntime推理【CPU】 YOLOv9-Openvino和ONNXRuntime推理【CPU】 注:YOLOv8和YOLOv9代码内容基本一致! 全部代码Github:https://github.c

YOLOv5-Openvino和ONNXRuntime推理【CPU】

1 环境: CPU:i5-12500 Python:3.8.18 2 安装Openvino和ONNXRuntime 2.1 Openvino简介 Openvino是由Intel开发的专门用于优化和部署人工智能推理的半开源的工具包,主要用于对深度推理做优化。 Openvino内部集成了Opencv、TensorFlow模块,除此之外它还具有强大的Plugin开发框架,允许开发者在Openv

C# OpenVINO Crack Seg 裂缝分割 裂缝检测

目录 效果 模型信息 项目 代码 数据集 下载 C# OpenVINO Crack Seg 裂缝分割 裂缝检测 效果 模型信息 Model Properties ------------------------- date:2024-02-29T16:35:48.364242 author:Ultralytics task:segment version:8.

YOLOv9-Openvino和ONNXRuntime推理【CPU】

1 环境: CPU:i5-12500 Python:3.8.18 2 安装Openvino和ONNXRuntime 2.1 Openvino简介 Openvino是由Intel开发的专门用于优化和部署人工智能推理的半开源的工具包,主要用于对深度推理做优化。 Openvino内部集成了Opencv、TensorFlow模块,除此之外它还具有强大的Plugin开发框架,允许开发者在Openv