本文主要是介绍本地部署openvino-chaglm3-6b,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

chatglm3.openvino Demo: https://github.com/OpenVINO-dev-contest/chatglm3.openvino/tree/main

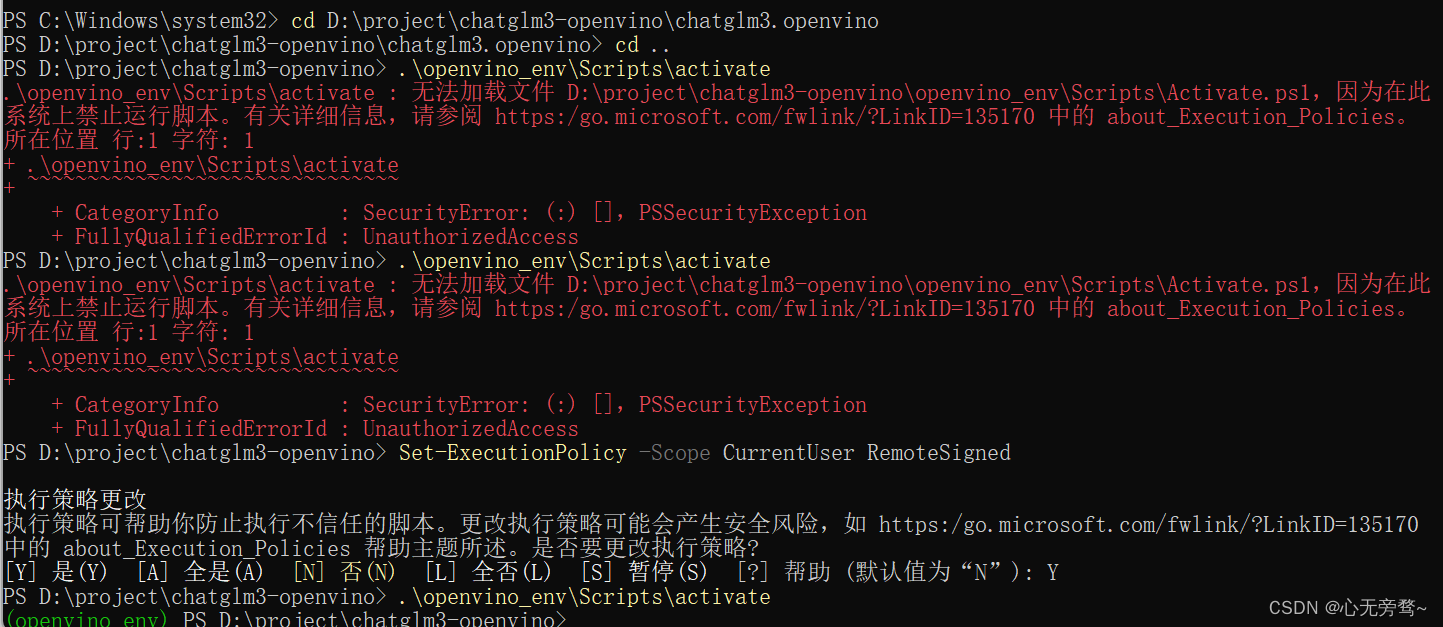

想将github下的代码拉取到本地文件夹中,再打开Windows PowerShell,执行以下命令激活环境。

python -m venv openvino_env.\openvino_env\Scripts\activate

激活环境的时候,可能会报如下错误,这时候我们只需要输入以下命令,然后输入Y即可解决:

Set-ExecutionPolicy -Scope CurrentUser RemoteSigned

接下来我们使用以下命令更新pip以及安装所需要的一些依赖库。

python -m pip install --upgrade pippip install wheel setuptoolspip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

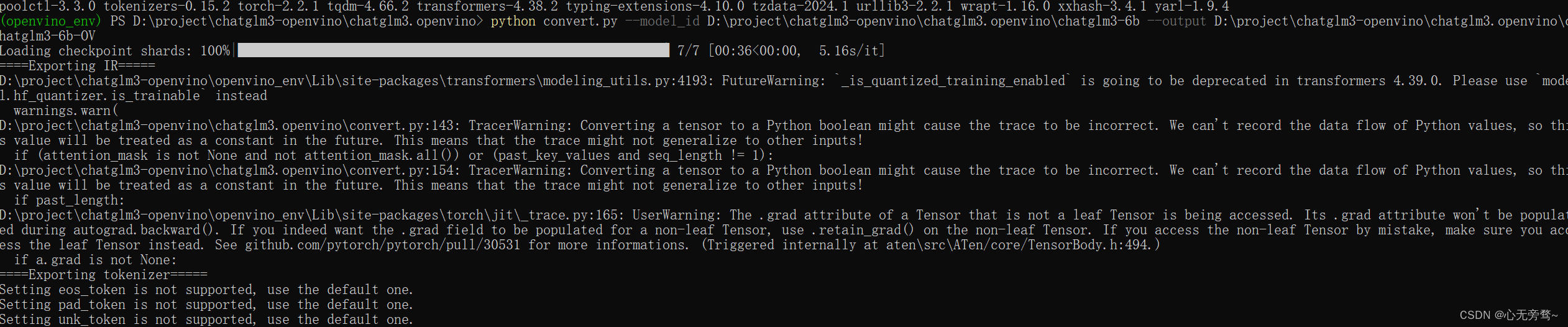

2. 转换模型

python convert.py --model_id THUDM/chatglm3-6b --output {your_path}/chatglm3-6b

-

–model_id - 用于从 Huggngface_hub (https://huggingface.co/models) 或 模型所在目录的路径(绝对路径)。

-

–output - 转换后模型保存的地址

如果访问huggingface 有困难,可以尝试使用 mirror-hf 进行下载.

# LINUX

export HF_ENDPOINT=https://hf-mirror.com

# Windows Powershell

$env:HF_ENDPOINT = "https://hf-mirror.com"

Download model

huggingface-cli download --resume-download --local-dir-use-symlinks False THUDM/chatglm3-6b --local-dir {your_path}/chatglm3-6b

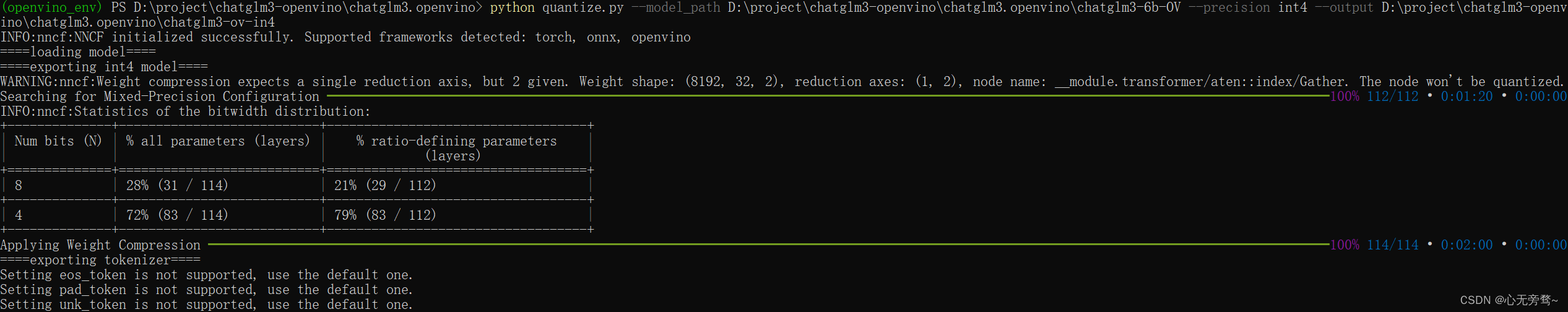

3. 量化模型(非必须)

python quantize.py --model_path {your_path}/chatglm3-6b --precision int4 --output {your_path}/chatglm3-6b-int4

- –model_path - OpenVINO IR 模型所在目录的路径。

- – precision - 量化精度:int8 或 int4。

- –output - 保存模型的路径。

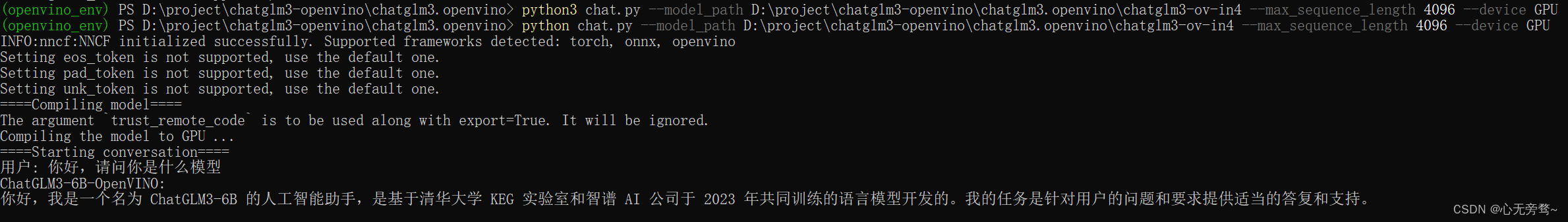

4. 运行流式聊天机器人

python chat.py --model_path {your_path}/chatglm3-6b --max_sequence_length 4096 --device CPU

- –model_path - OpenVINO IR 模型所在目录的路径。

- –max_sequence_length - 输出标记的最大大小。

- –device - 运行推理的设备。例如:“CPU”,“GPU”。

这篇关于本地部署openvino-chaglm3-6b的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!