mmdeploy专题

MMdeploy在cuda+tensorrt下的配置和编译

MMdeploy在cuda+tensorrt下的配置和编译 Python安装配置MMdeploy配置openmmlab系列从工程安装mmdeploy MMdeploy_runtime以及demo编译安装量化编译runtime和demo Python安装配置MMdeploy 配置openmmlab系列 pip install -U openmim 如果mim命令遭遇故障,

mmdetection模型使用mmdeploy部署在windows上的c++部署流程【详细全面版】

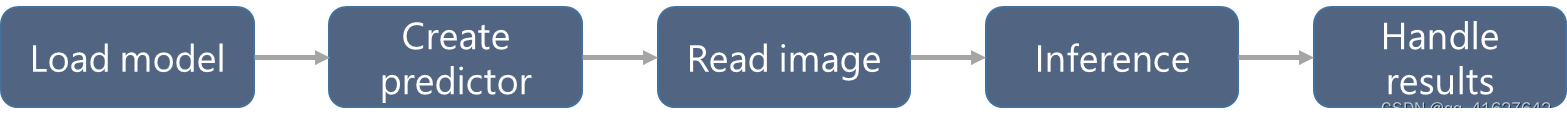

0. 前置说明: 该文档适用于:已经使用mmdetection训练好了模型,并且完成了模型转换。要进行模型部署了。 1. 概述 MMDeploy 定义的模型部署流程,如下图所示: 模型转换【待撰写,敬请期待…】 主要功能是:把输入的模型格式,转换为目标设备的推理引擎所要求的模型格式。 目前,MMDeploy 可以实现:① 把PyTorch模型,转换为 ONNX、TorchScrip

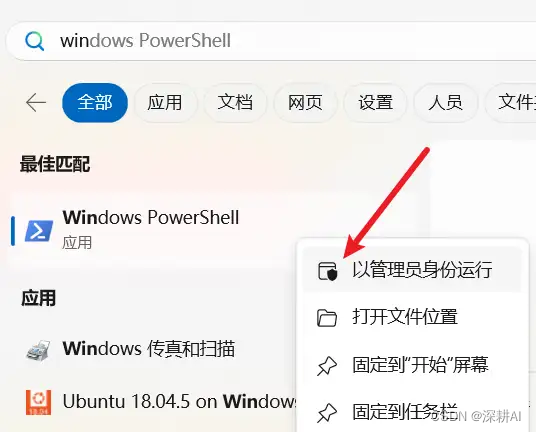

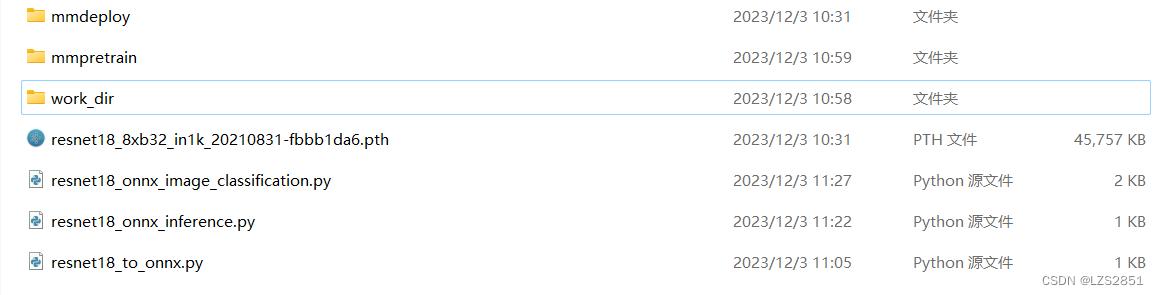

Windows利用MMDeploy部署OpenMMLab 模型并使用Python进行部署

目录 前言 一、准备工作 二、安装 MMDeploy 总结 前言 近期在用OpenMMLab构建模型,然后需要使用MMDeploy对模型进行部署。虽然官方文档提供了详细的说明,但是写的太繁琐了,而且在实际部署过程中,发现并不是所有步骤和内容都需要,因此,自己通过测试,记录一下如何利用MMDeploy部署OpenMMLab 模型。 一、准备工作 在利用MMDepl

OpenMMLab OpenMMLab mmdeploy v1.1.0模型部署(一)

一、MMDepoly整体框架 模型部署是指把机器学习训练生成的算法模型,部署到各类云、边、端设备上去, 并使之高效运行,从而将算法模型实际地应用到现实生活中的各类任务中去,从而实现AI+的智能化转型。 目前,我们已经支持 5 个算法库和 5 种后端推理引擎,囊括多种应用场景: MMDeploy 所支持算法库: • 检测(MMDetection) • 分割(MMSegmentation) •