本文主要是介绍Windows利用MMDeploy部署OpenMMLab 模型并使用Python进行部署,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

前言

一、准备工作

二、安装 MMDeploy

总结

前言

近期在用OpenMMLab构建模型,然后需要使用MMDeploy对模型进行部署。虽然官方文档提供了详细的说明,但是写的太繁琐了,而且在实际部署过程中,发现并不是所有步骤和内容都需要,因此,自己通过测试,记录一下如何利用MMDeploy部署OpenMMLab 模型。

一、准备工作

在利用MMDeploy部署模型之前,需要安装好CUDA、CUDNN。对于端到端的模型转换和推理,MMDeploy 依赖 Python 3.6+ 以及 PyTorch 1.8+。

第一步:从官网下载并安装 Miniconda

第二步:创建并激活 conda 环境

conda create --name mmdeploy python=3.8 -y

conda activate mmdeploy第三步: 参考官方文档并安装 PyTorch。本文主要是在GPU下测试,因此,安装脚本为:

pip install torch==2.1.0 torchvision==0.16.0 torchaudio==2.1.0 --index-url https://download.pytorch.org/whl/cu118二、安装 MMDeploy

第一步:通过 MIM 安装 MMCV

pip install -U openmim

mim install "mmcv>=2.0.0rc2"第二步: 安装 MMDeploy 和 推理引擎

主要执行以下命令:

# 1. 安装 MMDeploy 模型转换工具(含trt/ort自定义算子)

pip install mmdeploy==1.3.0

# 2. 支持 onnxruntime-gpu tensorrt 推理

pip install mmdeploy-runtime-gpu==1.3.0

# 3. onnxruntime-gpu

pip install onnxruntime-gpu==1.8.1第三步: 准备mmdeploy和mmpretrain

1.克隆mmdeploy仓库

git clone -b main https://github.com/open-mmlab/mmdeploy.git这里主要为了使用configs文件,所以没有加--recursive来下载submodule,也不需要编译mmdeploy

2.安装mmpretrain

git clone -b main https://github.com/open-mmlab/mmpretrain.git

cd mmpretrain

pip install -e .3.准备一个PyTorch的模型文件当作我们的示例

这里选择了resnet18_8xb32_in1k_20210831-fbbb1da6.pth,对应的训练config为resnet18_8xb32_in1k.py

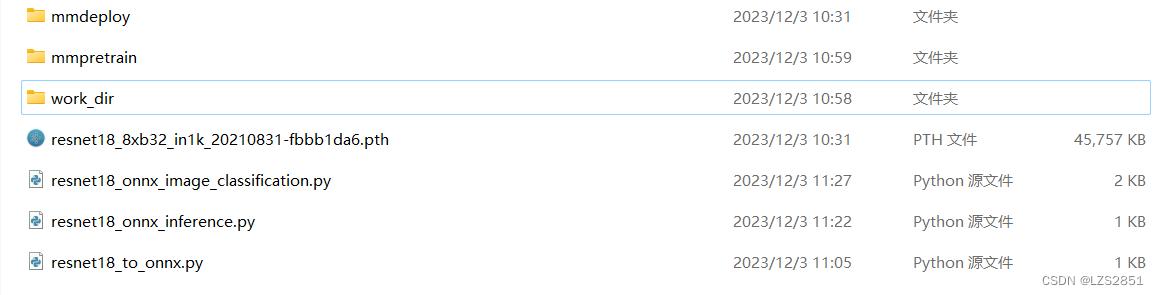

此时,文件夹目录为:

4.在构建python 转换代码时,官方给出的代码会出现无法找到deploy_cfg文件的问题,所以我这里使用了绝对目录,只需要将absolute_path修改为自己得文件路径即可。

from mmdeploy.apis import torch2onnx

from mmdeploy.backend.sdk.export_info import export2SDKabsolute_path = "自己电脑上的路径"img = absolute_path + "mmpretrain/demo/demo.JPEG"

work_dir = absolute_path + "work_dir/onnx/resnet"

save_file = absolute_path + "end2end.onnx"

deploy_cfg = absolute_path + "mmdeploy/configs/mmpretrain/classification_onnxruntime_dynamic.py"

model_cfg = absolute_path + "mmpretrain/configs/resnet/resnet18_8xb32_in1k.py"

model_checkpoint = absolute_path + "resnet18_8xb32_in1k_20210831-fbbb1da6.pth"

device = "cpu"# 1. Convert model to ONNX

torch2onnx(img, work_dir=work_dir, save_file=save_file,deploy_cfg=deploy_cfg, model_cfg=model_cfg,device=device, model_checkpoint=model_checkpoint)# 2. Extract pipeline info for sdk use (dump-info)

export2SDK(deploy_cfg=deploy_cfg, model_cfg=model_cfg, work_dir=work_dir, device=device, pth=model_checkpoint)5.推理代码如下。

# Copyright (c) OpenMMLab. All rights reserved.

import argparseimport cv2

from mmdeploy_runtime import Classifierabsolute_path = "自己电脑上的路径"

model_path = absolute_path + 'work_dir/onnx/resnet/'

img_path = absolute_path + "mmpretrain/demo/bird.JPEG"def parse_args():parser = argparse.ArgumentParser(description='show how to use sdk python api')parser.add_argument('--device_name', default="cpu", help='name of device, cuda or cpu')parser.add_argument('--model_path', default=model_path, help='path of mmdeploy SDK model dumped by model converter')parser.add_argument('--image_path', default=img_path, help='path of an image')args = parser.parse_args()return argsdef main():args = parse_args()img = cv2.imread(args.image_path)classifier = Classifier(model_path=args.model_path, device_name=args.device_name, device_id=0)result = classifier(img)for label_id, score in result:print(label_id, score)if __name__ == '__main__':main()

总结

通过对官方文档的测试,发现也不是所有的内容都需要的。尤其是当仅仅使用python进行推理的情况下,是不需要下载mmdeploy-1.3.0-windows-amd64.zip或mmdeploy-1.3.0-windows-amd64-cuda11.8.zip的。

这篇关于Windows利用MMDeploy部署OpenMMLab 模型并使用Python进行部署的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!