mem专题

perf 基础 -- perf ext_mem_req

perf ext_mem_req ext_mem_req 是 perf 工具事件列表中的一项,主要用于追踪处理器对外部内存的访问请求。它在以下几种情况下会触发: 数据缓存未命中:当处理器访问的数据未命中缓存时,处理器会向外部内存发送请求,加载所需的数据。指令缓存未命中:处理器在获取指令时,如果指令未命中缓存,也会触发外部内存请求,加载所需的指令。内存控制器交互:ext_mem_req 还用于衡

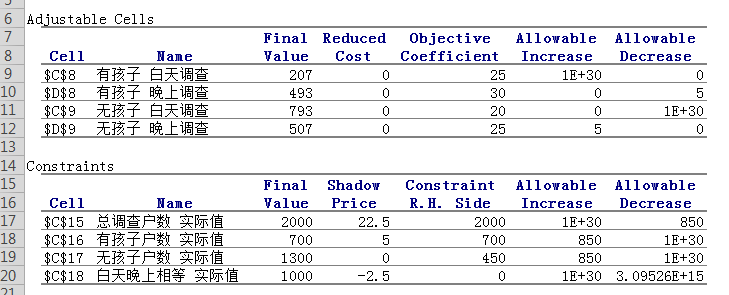

清华MEM作业-利用管理运筹学的分析工具slover求解最优解的实现 及 通过使用文件或者套节字来识别进程的fuser命令

一、清华MEM作业-利用管理运筹学的分析工具slover求解最优解的实现 最近又接触了一些线性求解的问题,以前主要都是在高中数学里接触到,都是使用笔算,最后通过一些函数式得出最小或者最大值,最近的研究生学业上接触到了一个Excel solver分析工具,对这种线性求最优解的问题感觉使用起来真是得心应手。在使用这个工具前,EXCEL里需要先装上solver工具,装起来很也简单,网上

CUDA系列-Mem-9

这里写目录标题 Static Architecture.Abstractions provided by CUSW_UNIT_MEM_MANAGERMemory Object (CUmemobj) Memory Descriptor(CUmemdesc)Memory Block(CUmemblock)Memory BinsSuballocations in Memory BlockFunct

memset、memcpy等mem家族函数

整理一下mem家族函数。 文章目录 memsetmemcpy memset 这是我最喜欢的函数。初始化为非零的数,或者中途使用的时候直接全部重置。 memcpy 我也喜欢这个函数,整段复制,终于不用for循环挨个复制了。 char *s = "GoldenGlobalView";char d[20];memcpy(d, s + 3, 4); //从第13个字符(V)开始复

java程序监控linux服务器硬件,cpu、mem、disk等

实现 使用Oshi和Hutool工具包1、pom依赖 <dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-web</artifactId></dependency><dependency><groupId>com.github.oshi</groupId>

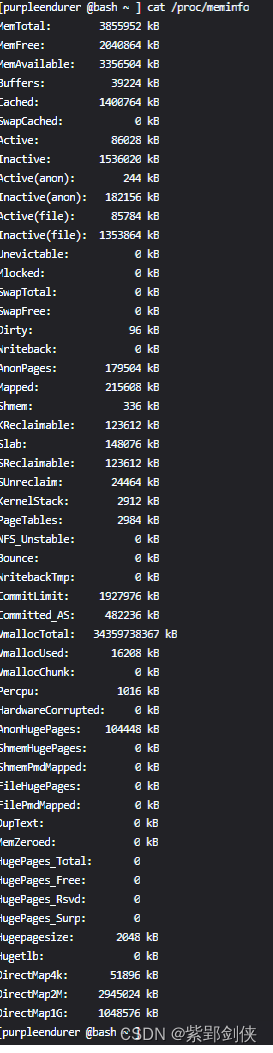

Linux shell编程学习笔记58:cat /proc/mem 获取系统内存信息

0 前言 在开展系统安全检查的过程中,除了收集cpu信息,我们还需要收集内存信息。在Linux中,获取内存信息的命令很多,这里我们着重研究 cat /proc/mem命令。 1 cat /proc/mem命令 /proc/meminfo 文件提供了有关系统内存的使用情况报告。 当我们想找出已用和可用内存、交换空间或缓存和缓冲区等统计信息时,我们可以分析此文件的内容。 需要注意的

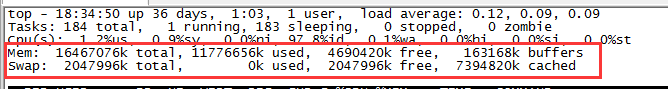

linux top mem/swap内存显示

如图:top 命令 Mem : 16467076 total, 11776656 used, 4690420 free, 163168 bufffer //第4行显示内存:物理内存总量(15.7G),空闲内存总量(4.5G),使用中的内存总量(10.1G),缓冲内存量 Swap: 2047796 total, 2047996 free, 0 used.

[内核内存] [mem_cgroup] cgroup内存子系统详解

该板块后续更新!!!!! 相关资源: https://www.cnblogs.com/lisperl/tag/%E8%99%9A%E6%8B%9F%E5%8C%96%E6%8A%80%E6%9C%AF/

request_mem_region和ioremap

本文转自:内核request_mem_region 和 ioremap的理解 几乎每一种外设都是通过读写设备上的寄存器来进行的,通常包括控制寄存器、状态寄存器和数据寄存器三大类,外设的寄存器通常被连续地编址。根据CPU体系结构的不同,CPU对IO端口的编址方式有两种: (1)I/O映射方式(I/O-mapped) 典型地,如X86处理器为外设专门实现了一个单独的地址空间,称为"I/O

Mem Cgroup目录无法清理问题分析

Cgroup(Control Group)是内核提供的资源隔离的技术,用于对Linux 系统中用户态进程使用的资源进行隔离,核心思想是:把进程分组,然后为进程组分配资源(包括内存、CPU、IO等)。其中Mem Cgroup用来隔离进程组使用的内存资源。 在Hadoop集群中,我们使用了Mem Cgroup对MapReduce任务使用的内存资源进行隔离控制,以保证单个任务不能

笔记:linux内核内存布局以及/dev/mem

参考一下两篇文章: linux内核内存管理(zone_dma zone_normal zone_highmem)(linux memory layout) /dev/mem可没那么简单 学习笔记(以x86为例) linux的虚拟地址空间: 32位的CPU,最大寻址范围为2^32 - 1也就是4G的线性地址空间。Linux简化了分段机制,使得虚拟地址与线性地址总是一致的。linux一般把这

通过/dev/mem进行恶意代码注入

通过/dev/mem进行恶意代码注入 Anthony Lineberry «anthony.lineberry@gmail.com» 2009年3月27日 原文 http://www.dtors.org/papers/malicious-code-injection-via-dev-mem.pdf 摘要 在本文中,我们将要讨论使用字符设备/dev/mem向kernel进行代码注入的方法。大多数

request_mem_region __request_region(iomem_resource,(start),(n),(name))

linux下request_mem_region的粗略理解 文章来源:http://gliethttp.cublog.cn Linux把基于I/O映射方式的I/O端口和基于内存映射方式的I/O端口资源统称为“I/O区域”(I/O Region)。I/O Region仍然是一种I/O资源,因此它仍然可以用resource结构类型来描述。 Linux是以一种倒置的树形结构来管理每一类I/

ioremap,request_mem_region

文章内容来自:http://blog.csdn.net/fudan_abc/archive/2007/10/04/1811451.aspx 以我们家 Intel 为代表的 i386 系列处理器中 , 内存和外部 IO 是独立编址独立寻址的 , 于是有一个地址空间叫做内存空间 , 另有一个地址空间叫做 I/O 空间 . 也就是说 , 从处理器的角度来说 ,i386 提供了一些单独的指令

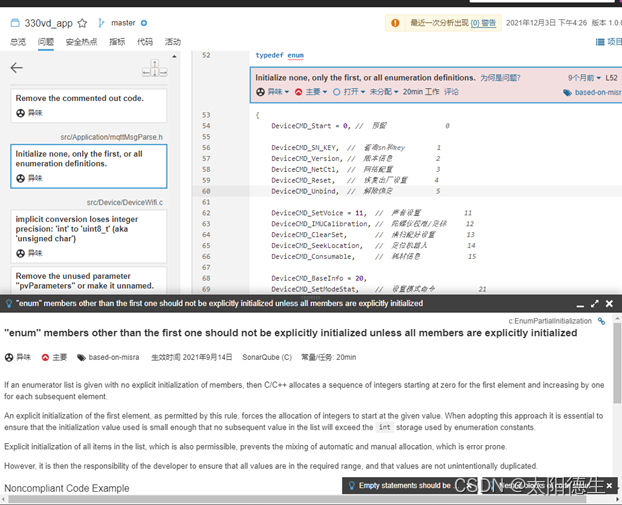

C语言常见问题(5):enum members other than the first one should not be explicitly initialized unless all mem

就是枚举里面的元素不是连续的,要不就只有一个赋初值的,要么就所以元素都单独赋值。这种问题我们在写代码的时候经常出现,但是确实不是那么规范,引以为戒。

简单c之模拟实现mem类函数

1.模拟实现memcpy #include<stdio.h> #include<assert.h> void* my_memcpy(void* dest,void* src,int count) { char* pdest=(char*) dest;//必须要把目标数组跟原数组强制转化为char*指针,因为count需要一个一个字节拷贝。 char* psrc =(char*) src;

[玩转BLE]nRF52832提示ERROR 4 [NRF_ERROR_NO_MEM]的处理方法

打开跟踪调试模块,错误定位如下: error> app: ERROR 4 [NRF_ERROR_NO_MEM] at ..\..\..\ble_app.c:1293 我们转到ble_app.c 的1293行看一下: 其实看一下ble_ancs_c_init()的返回值,就知道是在函数内部已经出错了,进入到函数中继续跟踪调试。 ret_code_t ble_ancs_c_init(ble_anc

linux top命令中 cpu 利用率/mem 使用率与load average平均负载计算方式

文章目录 1 简介2 CPU% 字段3 MEM% 字段4 load average 平均负载 1 简介 top 命令是 Linux 上一个常用的系统监控工具,它经常用来监控 Linux 的系统状态,是常用的性能分析工具,能够显示较全的系统资源信息,包括系统负载,CPU 利用分布情况,内存使用,进程资源占用情况等。 如下示例: top - 15:20:14 up 8 days,

2005-2022年MBA/MPA/MEM国家线

今年的全国MBA/MPA/MEM联考复试国家线预计3月中上旬才能出来,近来不少考生都比较关心国家线的走势,为大家整理了2005年-2022年三大项目国家线趋势图,以方便大家作为复试基准线的参考,自2021年开始实行分专业划线政策,不同专业会拥有自己的国家线,浙大等34所院校拥有自主划线权,能否进复试需要结合自身提前批面试的情况做综合评估。

ICC2:mem出pin的Off Grid问题

我正在「拾陆楼」和朋友们讨论有趣的话题,你⼀起来吧? 拾陆楼知识星球入口 在ICC2做先进工艺时会有off-grid的问题,off-grid可以理解为绕线没有在preferred方向track上。解决办法有如下两种,以供参考。 1)版本问题 测试发现,2022版本以前的ICC2绕线容易有off-grid问题。主要在mem出pin的M2/M3层次上,切换版本绕线能很大程

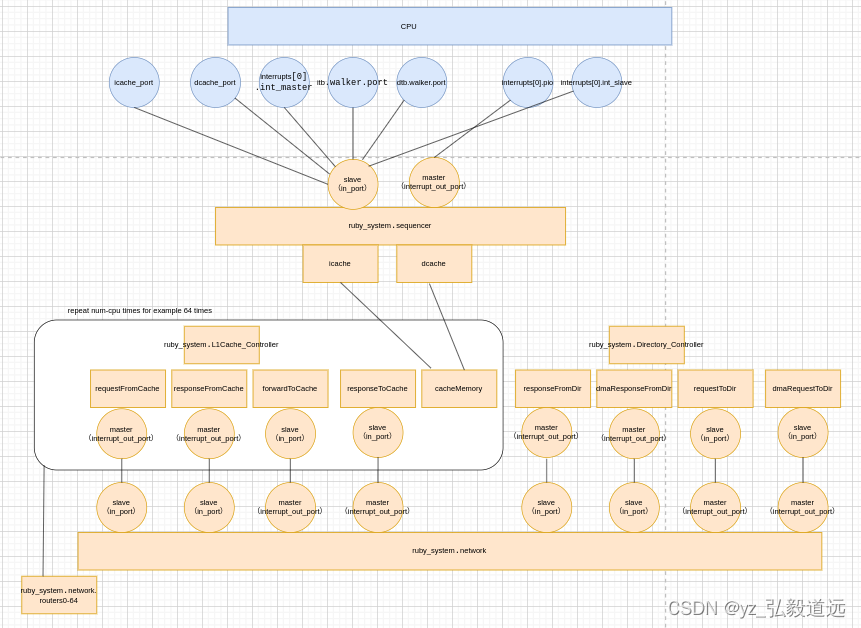

gem5 RubyPort: mem_request_port作用与连接 simple-MI_example.py

简介 回答这个问题:RubyPort的口下,一共定义了六个口,分别是mem_request_port,mem_response_port,pio_request_port,pio_response_port,in_ports, interrupt_out_ports,他们分别有什么用,应该怎么接 overview是下面这个图。 以一个简单的l1 cache为例子 https://www.

gem5 RubyPort: mem_request_port作用与连接 simple-MI_example.py

简介 回答这个问题:RubyPort的口下,一共定义了六个口,分别是mem_request_port,mem_response_port,pio_request_port,pio_response_port,in_ports, interrupt_out_ports,他们分别有什么用,应该怎么接 overview是下面这个图。 以一个简单的l1 cache为例子 https://www.

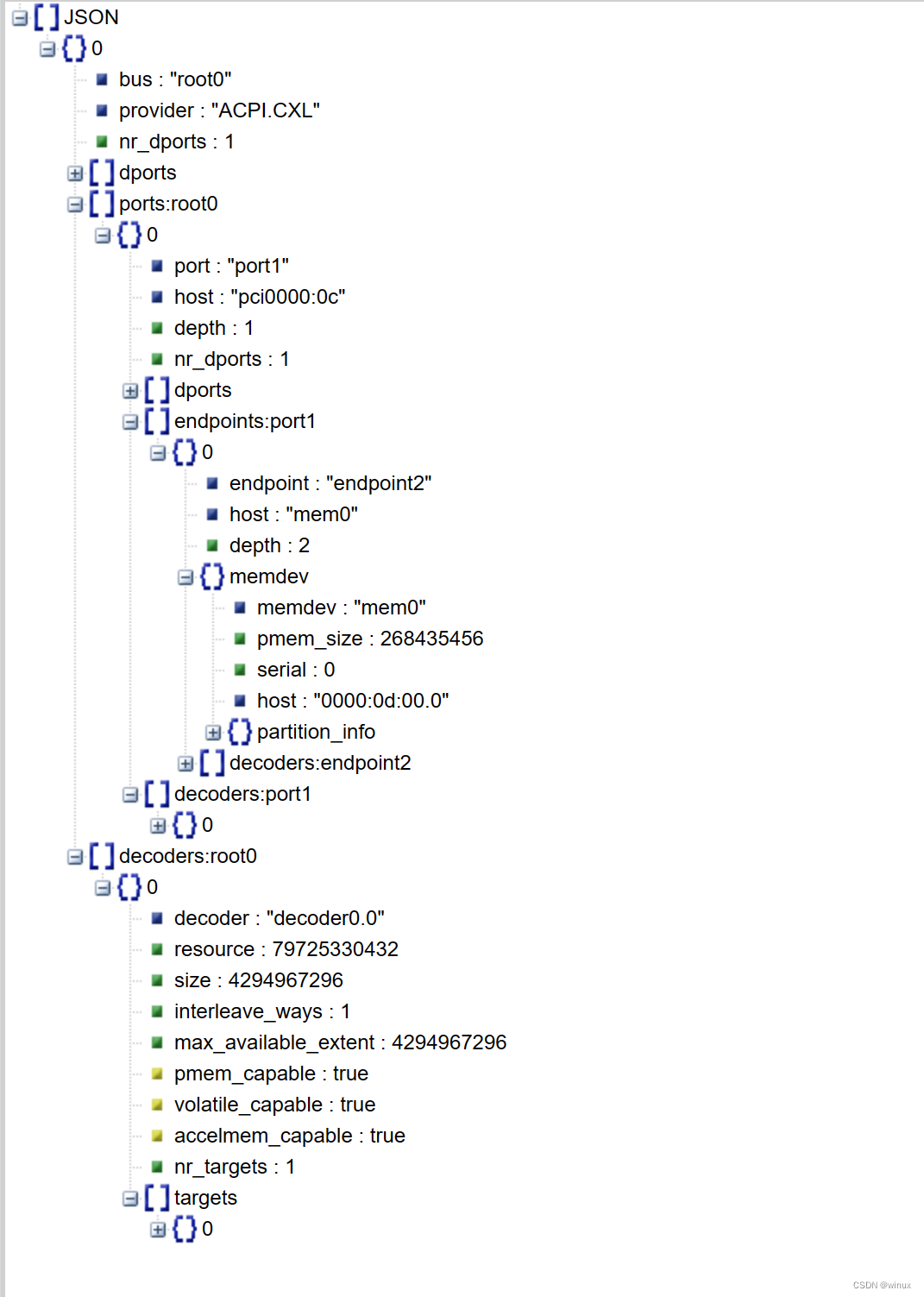

使用qemu模拟CXL.mem设备

CXL可以说是自PCIe技术诞生几十年以来最具变革性的新技术了。可以想象有了CXL以后机箱的边界将被彻底打破,服务器互相使用对方的内存,网卡,GPU 。整个机架甚至跨机架的超级资源池化成为可能,云计算也将进入一个新的时代。 当前Intel, AMD 目前最新CPU型号也都已经支持CXL接口,三星也有支持CXL的内存模组提供,但是普及性还是非常低,可能只有极个别的研究人员才能拿到真正的物理设备。作

linux mem overcommit

linux overcommit 机制会欺骗进程,承诺分配给他的内存空间,只有当这些page被真正touch到的时候才通过缺页机制拿到真正的物理内存。 以下摘自kernel doc The Linux kernel supports the following overcommit handling modes0 - Heuristic overcommit handling. Obviou

![[玩转BLE]nRF52832提示ERROR 4 [NRF_ERROR_NO_MEM]的处理方法](https://img-blog.csdnimg.cn/20200608095323398.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3NsaW1tbQ==,size_16,color_FFFFFF,t_70)