lstms专题

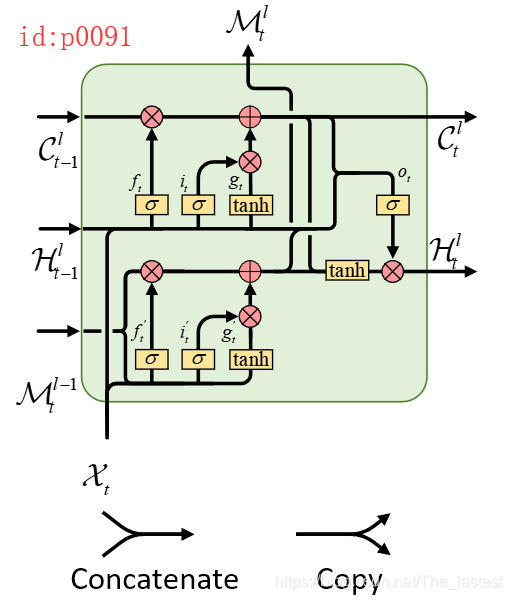

PredRNN: Recurrent Neural Networks for Predictive Learning using Spatiotemporal LSTMs

这是一篇2017年发表在顶级期刊NIPS上的文章,作者通过发现传统RNN/LSTM网络的不足,提出了一种新的网络结构PredRNN,并且为这一网络结构设计了一种新的RNN单元(ST-LSTM)。由于博主能力有限,通过阅读原文短时间能只是领悟到PredRNN这一网络结构的思想,而并未对ST-LSTM的设计灵感有更深的体会。 下面这篇博文主要是来介绍一下什么是PredRNN,以及通过作者的设

论文浅尝 | Leveraging Knowledge Bases in LSTMs

Yang, B., Mitchell, T., 2017. Leveraging Knowledge Bases in LSTMs for Improving Machine Reading. Association for Computational Linguistics, pp. 1436–1446. 链接:http://www.aclweb.org/anthology/P/P17

Sora背后的论文(1):使用 lstms 对视频展现进行无监督学习

之前那篇《Sora背后的32篇论文》发出后,大家都觉得不错,有很多小伙伴都开始啃论文了。 那么我就趁热打铁,把这32篇论文的通俗解读版贴一下。 从去年开始,我基本上形成了一个思维方式,任何事情做之前先看看 有没有好的AI工具帮助自己提高效率。 我本身不是算法出身,也是散装英语的水平, 所以这个过程是借助了一些AI工具完成,后面会专门写一篇介绍详细的说明。

Leveraging Knowledge Bases in LSTMs for Improving Machine Reading

《Leveraging Knowledge Bases in LSTMs for Improving Machine Reading》 这篇文章是发表在2017年ACL上的,主要是聚焦于外部知识改善LSTM,运用在实体抽取和事件抽取任务。在ACE2005的数据集上得到了SOTA效果。 首先介绍这篇文章的两个知识库,一个是WordNet一个是NELL。 Word net是人工创造的一个词典,里

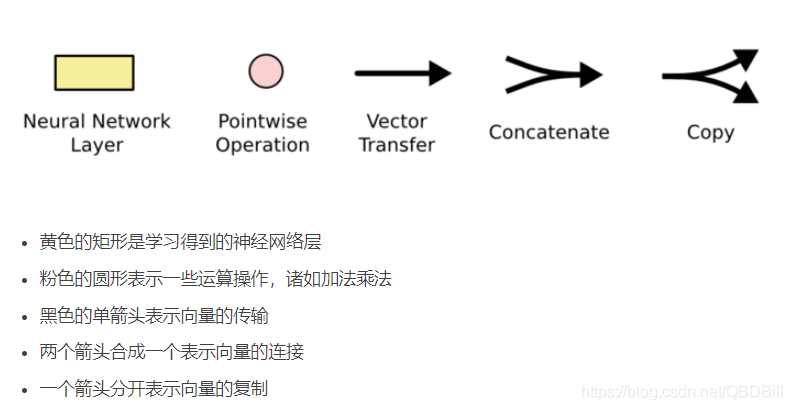

长短记忆网络(LSTMs)

LSTMs (长短期记忆网络)是RNN的特殊类型,可以学习远期依赖信息。 远期依赖信息就是当前信息跟数百个或更多之前的输入有关,远期记忆有不可忽视的影响。 RNN结构 LSTM结构