kv专题

C++笔记17•数据结构:二叉搜索树(K模型/KV模型实现)•

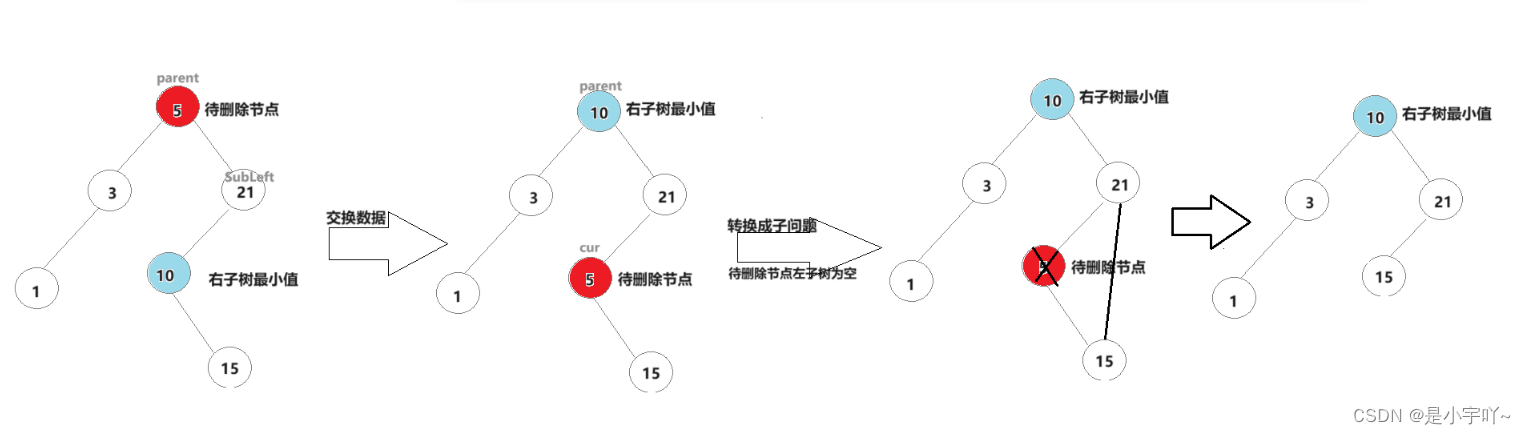

二叉搜索树 1.二叉搜索树 1. 二叉搜索树的查找 a 、从根开始比较,查找,比根大则往右边走查找,比根小则往左边走查找。 b 、最多查找高度次,走到到空,还没找到,这个值不存在。2. 二叉搜索树的插入 插入的具体过程如下: a. 树为空,则直接新增节点,赋值给 root 指针 b. 树不空,按二叉搜索树性质查找插入位置,插入新节点3.二叉搜索树的删除 首先查找元素是否在二叉搜索树中,如果不

【二叉搜索树】K型与KV型二叉搜索树简单实现

关于我: 睡觉待开机:个人主页 个人专栏: 《优选算法》《C语言》《CPP》 生活的理想,就是为了理想的生活! 作者留言 PDF版免费提供:倘若有需要,想拿我写的博客进行学习和交流,可以私信我将免费提供PDF版。 留下你的建议:倘若你发现本文中的内容和配图有任何错误或改进建议,请直接评论或者私信。 倡导提问与交流:关于本文任何不明之处,请及时评论和私信,看到即回

书生大模型实战营闯关记录----第十一关:LMDeploy 量化部署进阶实践 KV cache量化部署,W4A16 模型量化和部署

文章目录 1 配置LMDeploy环境1.1 环境搭建1.2 InternStudio环境获取模型1.3 LMDeploy验证启动模型文件 2 LMDeploy与InternLM2.5 2.1 LMDeploy API部署InternLM2.52.1.1 启动API服务器 2.1.2 以命令行形式连接API服务器 2.1.3 以Gradio**网页形式连接API服务器** 2.2 LMDe

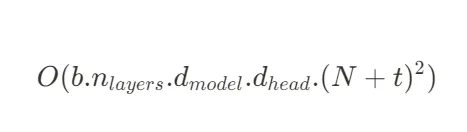

LLM - GPT(Decoder Only) 类模型的 KV Cache 公式与原理 教程

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://spike.blog.csdn.net/article/details/141605718 免责声明:本文来源于个人知识与公开资料,仅用于学术交流,欢迎讨论,不支持转载。 在 GPT 类模型中,KV Cache (键值缓存) 是用于优化推理效率的重要技术,基本思想是通过缓存先

LMDeploy的KV Cache管理器可以通过设置--cache-max-entry-count参数 TurboMind理解

参考https://blog.csdn.net/m0_65719612/article/details/138634868 模型在运行时,占用的显存可大致分为三部分:模型参数本身占用的显存、KV Cache占用的显存,以及中间运算结果占用的显存。LMDeploy的KV Cache管理器可以通过设置–cache-max-entry-count参数,控制KV缓存占用剩余显存的最大比例。默认的比例为0

Kivy tutorial 008: More kv language

Kivy tutorial 008: More kv language – Kivy Blog Central themes: Event binding and canvas instructions in kv language 中心主题: 事件绑定 和 kv语言里的画布结构 This tutorial directly follows on from the previous, so s

移植案例与原理 - utils子系统之KV存储部件 (2)

3、KV存储部件对外接口 在文件utils\native\lite\include\kv_store.h中定义了KV存储部件对外接口,如下,支持从键值对缓存里读取键值,设置键值,删除键值,清除缓存等等。 int UtilsGetValue(const char* key, char* value, unsigned int len);int UtilsSetValue(const char*

大模型KV Cache节省神器MLA学习笔记(包含推理时的矩阵吸收分析)

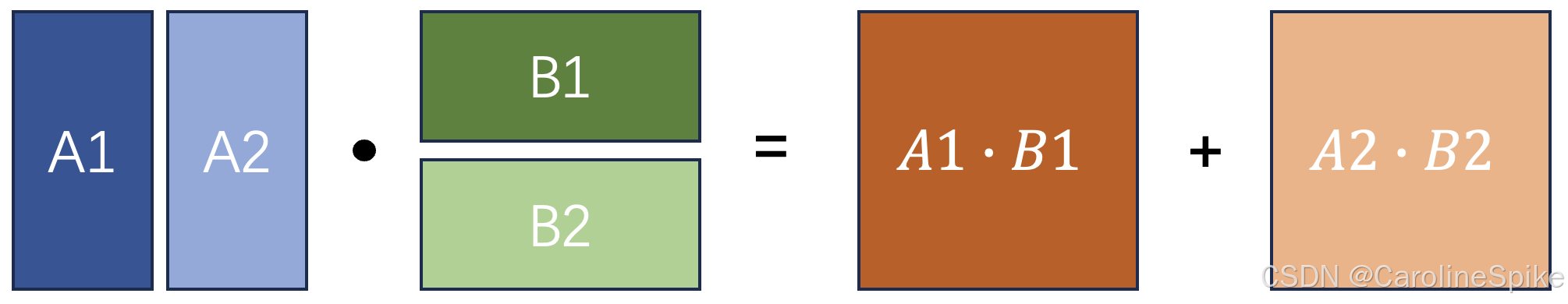

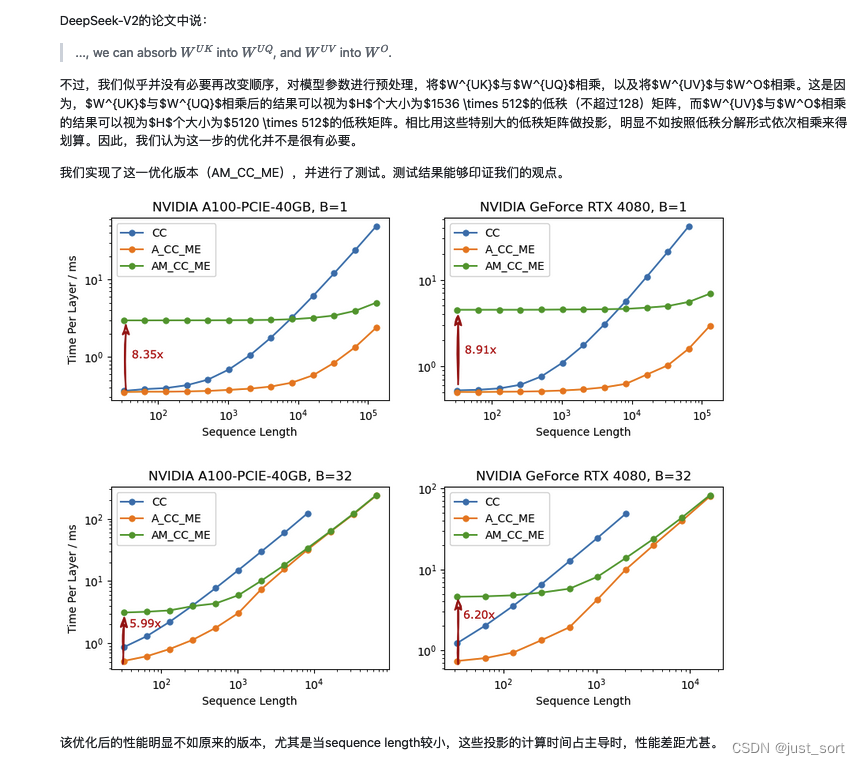

首先,本文回顾了MHA的计算方式以及KV Cache的原理,然后深入到了DeepSeek V2的MLA的原理介绍,同时对MLA节省的KV Cache比例做了详细的计算解读。接着,带着对原理的理解理清了HuggingFace MLA的全部实现,每行代码都去对应了完整公式中的具体行并且对每个操作前后的Tensor Shape变化也进行了解析。我们可以看到目前的官方实现在存储KV Cache的时候并不

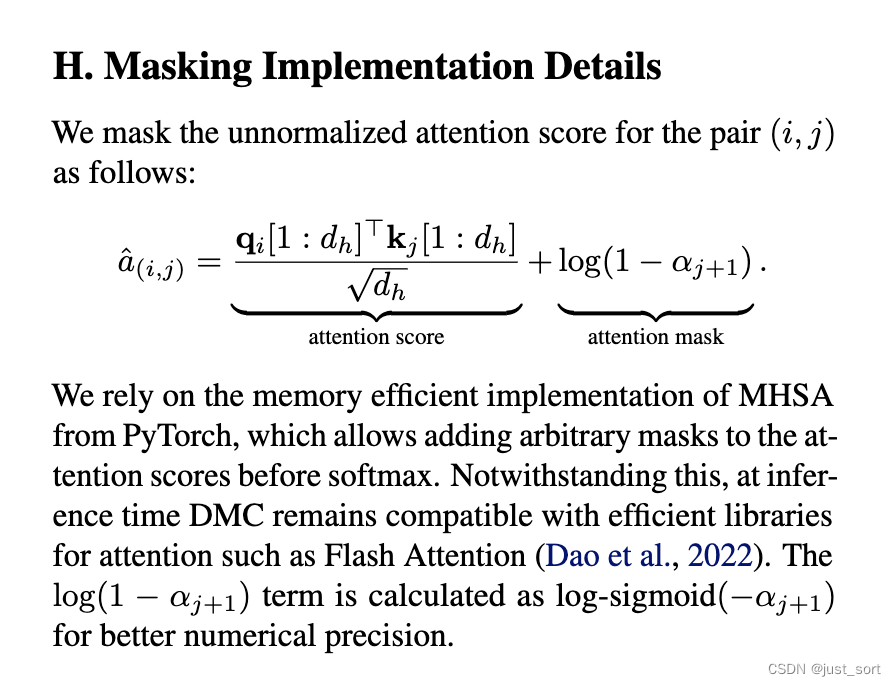

GQA,MLA之外的另一种KV Cache压缩方式:动态内存压缩(DMC)

0x0. 前言 在openreview上看到最近NV的一个KV Cache压缩工作:https://openreview.net/pdf?id=tDRYrAkOB7 ,感觉思路还是有一些意思的,所以这里就分享一下。 简单来说就是paper提出通过一种特殊的方式continue train一下原始的大模型,可以把模型在generate过程中的KV Cache分成多个段,并且每个token都会学出

Transformer系列:图文详解KV-Cache,解码器推理加速优化

前言 KV-Cache是一种加速Transformer推理的策略,几乎所有自回归模型都内置了KV-Cache,理解KV-Cache有助于更深刻地认识Transformer中注意力机制的工作方式。 自回归推理过程知识准备 自回归模型采用shift-right的训练方式,用前文预测下一个字/词,并且前文中的最后一个词经过解码器的表征会映射为其下一个待预测词的概率分布。在训练阶段,句子完整输入给网

cross-attention里为什么encoder提供的是KV?

依照attention在计算全连接图中有向边权重的思路,KV是中心节点的邻居们的KV,中心节点提供Q,与每个邻居单独交流(指QK),然后根据这个权重聚合邻居的信息(V)。因此,encoder提供KV,是全面抛弃了decoder端input的信息库,只将其作为从encoder中摘取信息的媒介(Q)。所以图without self-loop的图,每一个token的output都从同一个节点集合(enc

OSTEP Projects:KV

本文将介绍操作系统导论(Operating Systems: Three Easy Pieces)作者所开源的操作系统相关课程项目 的 KV 部分,包含个人的代码实现和设计思路。 思路 题目要求实现一个最简单的数据库,以支持数据的持久化。 每个操作由格式为 op,[arg1],[arg2] 的命令给出,那么首先要解决的问题就是参数的分离,再根据操作符 op 来对不同的操作进行特殊处理。字符串划

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(三)KV缓存

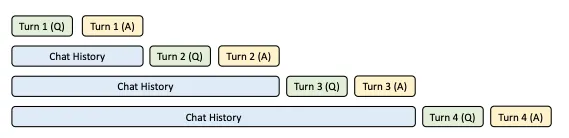

探索和构建 LLaMA 3 架构:深入探讨组件、编码和推理技术(三) KV缓存 在推理的每一步中,只对模型输出的最后一个标记感兴趣,因为已经有了之前的标记。然而,模型需要访问所有先前的标记来决定输出哪个标记,因为它们构成了它的上下文(或“提示”)。 这是一种使模型在推理过程中对已经看到的标记进行更少计算的方法。解决办法就是KV缓存! 在Transformer的推理过程中, 增量且顺序地获取查

这门分布式 KV 存储系统课程教会了我什么? | 我与 Talent Plan

作者介绍 张艺文,华中科技大学武汉国家光电实验室直博二年级,主要研究方向为基于新型存储设备的 KV 存储。PingCAP Talent Plan 第二期优秀学员。 距离我从 PingCAP Talent Plan 结业已经过了三个月,这也算是我第一次与企业或者说工业界近距离接触。与 PingCAP 结缘是在去年的六月份,我们实验室发表了一篇有关 KV 方向的论文,众所周知,

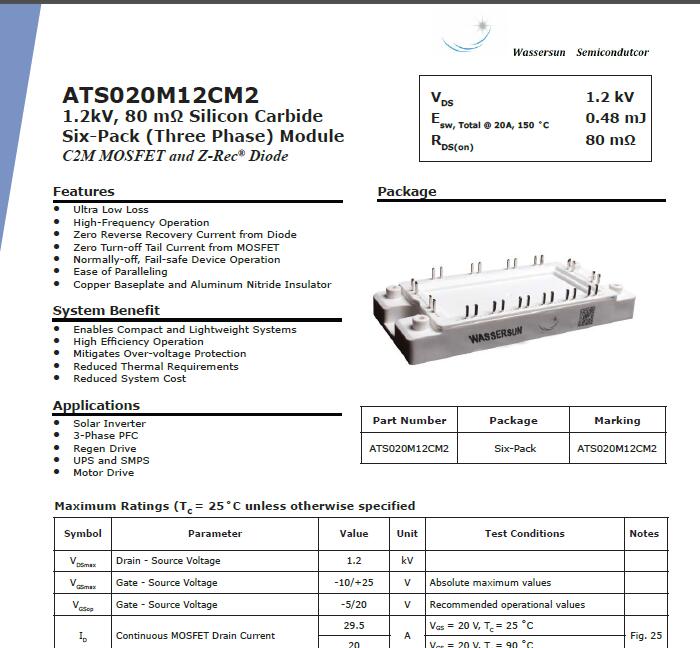

wassersun 水光半导体1.2kv千伏碳化硅模块产销突破千万

作为碳化硅器件的业界最强,wassersun(水光半导体)以突破千万量级产品应用,已经广泛应用于工业自动化,电力技术,动力系统等领域。

LLM 推理优化探微 (3) :如何有效控制 KV 缓存的内存占用,优化推理速度?

编者按: 随着 LLM 赋能越来越多需要实时决策和响应的应用场景,以及用户体验不佳、成本过高、资源受限等问题的出现,大模型高效推理已成为一个重要的研究课题。为此,Baihai IDP 推出 Pierre Lienhart 的系列文章,从多个维度全面剖析 Transformer 大语言模型的推理过程,以期帮助读者对这个技术难点建立系统的理解,并在实践中做出正确的模型服务部署决策。 本文是该系列文章

LLM 推理优化探微 (2) :Transformer 模型 KV 缓存技术详解

编者按:随着 LLM 赋能越来越多需要实时决策和响应的应用场景,以及用户体验不佳、成本过高、资源受限等问题的出现,大模型高效推理已成为一个重要的研究课题。为此,Baihai IDP 推出 Pierre Lienhart 的系列文章,从多个维度全面剖析 Transformer 大语言模型的推理过程,以期帮助读者对这个技术难点建立系统的理解,并在实践中做出正确的模型服务部署决策。 本文是该系列文章的

基于C语言实现内存型数据库(kv存储)

基于C语言实现内存型数据库(kv存储) 文章目录 基于C语言实现内存型数据库(kv存储)1. 项目背景1.1 Redis介绍1.2 项目预期及基本架构 2. 服务端原理及代码框架2.1 网络数据回环的实现2.2 array的实现2.3 rbtree的实现2.4 btree的实现2.5 hash的实现2.6 dhash的实现2.7 skiplist的实现2.8 kv存储协议的实现 3. 性能

6、Redis-KV设计、全局命令和安全性

目录 一、value设计 二、Key设计 三、全局命令——针对所有key 四、安全性 一、value设计 ①是否需要排序?需要:Zset ②需要缓存的数据是单个值还是多个值? 单个值:简单值---String;对象值---Hash多个值:允许重复---List;不允许重复---Set 另一种方案:需要排序使用Zset,否则一律使用String【所有对象都转换为json格式

支持调度的简易KV缓存设计

目录 0.写在前面的话 1.顶层接口 1.1顶层接口KVCache,> 1.2顶层接口CallableCapturer,> 2.缓存实现 3.自定义缓存调度ScheduledKVCache,> 4.线程安全性保证 5.后续改进 0.写在前面的话 本篇介绍一种支持调度的键值缓存设计,其中缓存的对象是一个Callable对象; 主要从顶层接口、缓存实现、自定义缓存调度、线程安

C++:二叉搜索树模拟实现(KV模型)

C++:二叉搜索树模拟实现(KV模型) 前言模拟实现KV模型1. 节点封装2、前置工作(默认构造、拷贝构造、赋值重载、析构函数等)2. 数据插入(递归和非递归版本)3、数据删除(递归和非递归版本)3.1 查找待删除节点位置3.2 删除数据及相关节点调整3.3 完整代码以及递归和非递归版本 四、查找数据五、中序遍历六、所有代码 前言 二叉搜索树又称二叉排序树,他对数据有严格的要求

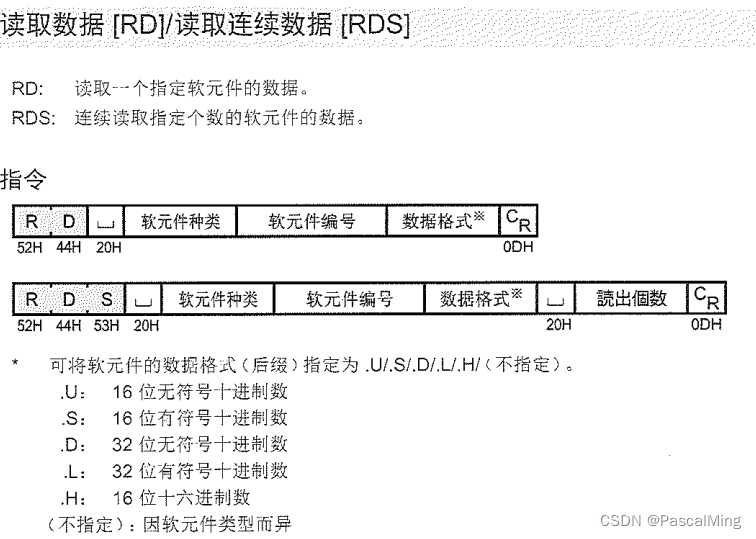

基恩士 KV-8000 PLC通讯简单测试

1、KV-8000通讯协议 基恩士 KV-8000 PLC支持多种通讯方式,包括:OPC UA、Modbus、上位链路命令等。其中OPC UA需要对服务器和全局变量进行设置,Modbus需要调用功能块。默认支持的是上位链路命令,实际是一条条以回车换行结束的ASCII命令串。 TCP、UDP通讯规格如下: 2、上位链路命令概览 常见错误码 3、数据类型和地址范围

基恩士PLC编程kv7000软件KV-STUDIO V11.63从入门到精通学习资料

恩士PLC软件KV-STUDIO V11.63是一款用于编程和配置基恩士PLC的软件。它提供了一个直观的界面,使用户能够轻松地创建和编辑PLC程序,并进行在线调试和监视。该软件还具有丰富的功能,包括数据记录、报警管理、远程访问等。此外,KV-STUDIO V11.63还支持多种通信协议,如Modbus、Ethernet/IP等,以便与其他设备进行通信。总之,KV-STUDIO V11.63是一款功

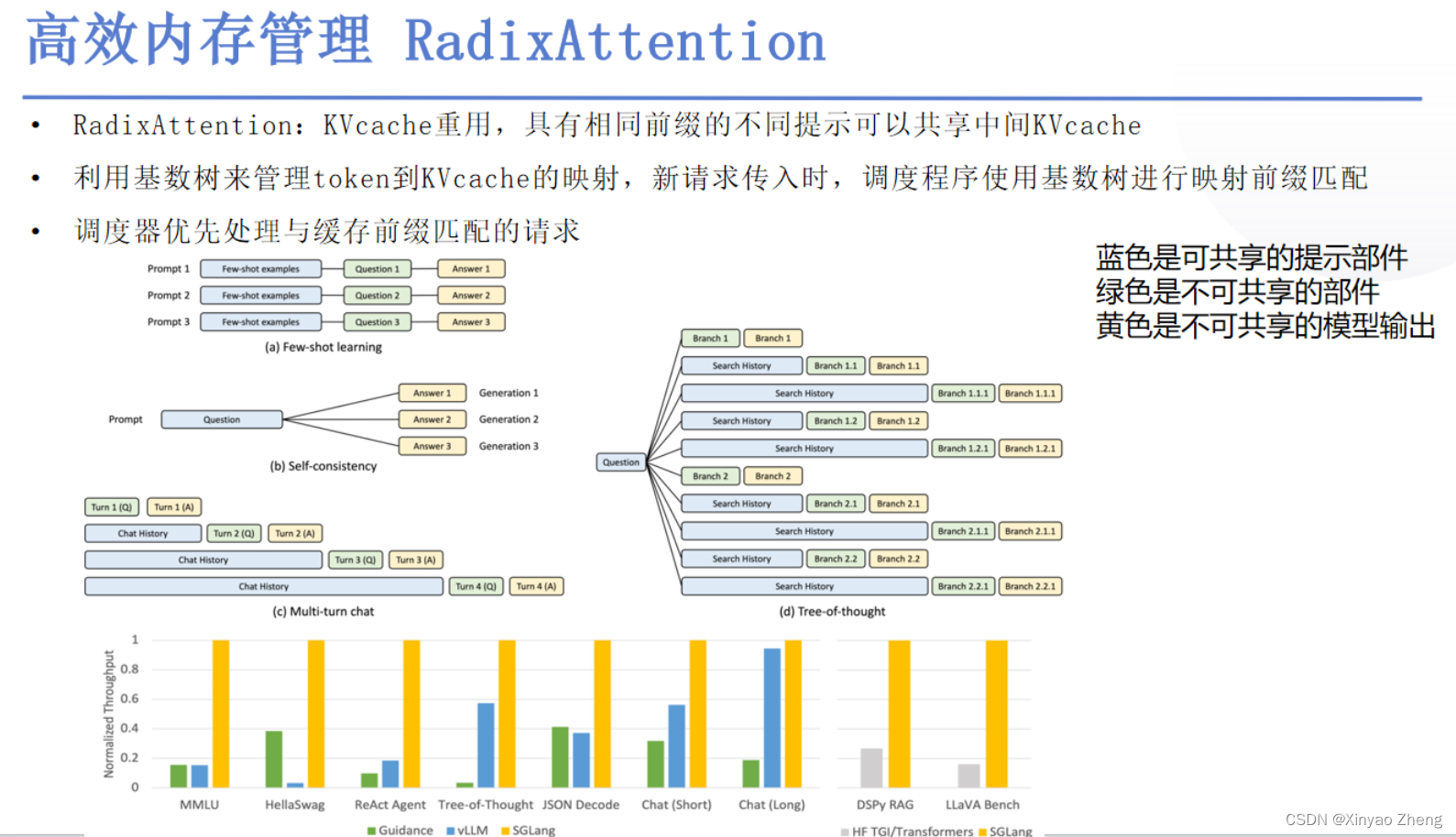

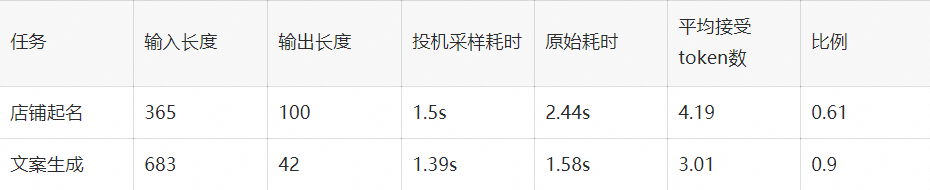

大模型推理优化实践:KV cache 复用与投机采样

作者:米基 一、背景 RTP-LLM 是阿里巴巴大模型预测团队开发的大模型推理加速引擎,作为一个高性能的大模型推理解决方案,它已被广泛应用于阿里内部。该引擎与当前广泛使用的多种主流模型兼容,并通过采用高性能的 CUDA 算子来实现了如 PagedAttention 和 Continuous Batching 等多项优化措施。RTP-LLM 还支持包括多模态、LoRA、P-Tuning、以及

模拟实现一个简单的中英互译字典——二叉搜索树的应用KV模型

模拟实现一个简单的中英互译字典 请模拟实现一个简单的中英互译字典,要求能实现简单的查找,插入新词以及删除操作;例如 BinaryTree.h #pragma once#include <stdio.h>#include <stdlib.h>//二叉搜索树的应用//1. 请模拟实现一个简单的中英互译的字典typedef char* KeyType;typedef char*