kinect专题

Azure_Kinect_ROS版编译及IMU参数标定.

Azure_Kinect_ROS版编译 参照官方文档:https://github.com/microsoft/Azure_Kinect_ROS_Driver/blob/melodic/docs/building.md 编译. 如果是ubuntu18.04等通过命令行安装SDK的,应该可以轻松编译成功.但是如果是在16.04上安装的(安装方法参照https://blog.csdn.net/u01

Azure Kinect SDK ubuntu安装脱坑指南

Azure Kinect SDK ubuntu安装脱坑指南 平台先激动一下DependenceBefore BuildBuild Tools Installation(Including DE)Without Root多设备启动时第二设备报错 平台 ubuntu: 16.04, 18.04. 先激动一下 按官方文档说明检查自己的平台硬件配置是否达标.怀着激动的心情拆机 D

kinect开发教程

kinect开发教程一 : http://blog.csdn.net/chenxin_130/article/details/6693390 kinect开发教程二 : http://blog.csdn.net/chenxin_130/article/details/6696187 关于kinect深度图像和彩色图像提取:http://blog.csdn.net/lixam/artic

Kinect for windows 应用 一,简单的体感超级玛丽

背景知识 1. 游戏模拟器:现在有很多模拟器,让我们可以在PC上玩红白机,PS上的游戏。本破解用的FC 红白机模拟器。网上有很多地方可以下载。注意语言要和你的操作系统一致。 2. 按键模拟器:本破解是通过发送快捷键来模拟游戏操作的。所以需要有一个游戏模拟器。你可以自己写一个,也可以网上找一个。 3. 对比数据:人体动作变化需要有一个基础的对比数据,即正常情况下,人体各关节所处深度和位置

Kinect for windows 开发入门 九:骨骼数据获取和使用

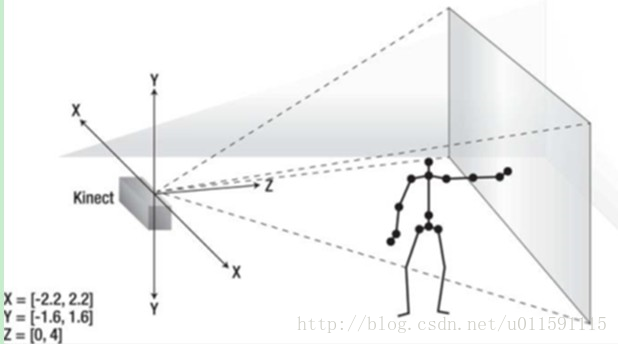

背景知识 1. 骨骼追踪:骨骼追踪技术通过处理景深数据来建立人体各个关节的坐标,骨骼追踪能够确定人体的各个部分,如那部分是手,头部,以及身体。在Kinect里面,是通过20个关节点来表示一个骨架的,具体由下图可以看到。当你走进Kinect的视野范围的时候,Kinect就可以把你的20个关节点的位置找到(当然你得站着),位置通过(x, y, z)坐标来表示。SkeletonStream产生的每一

Kinect for windows 开发入门 八:景深数据获取和使用 下

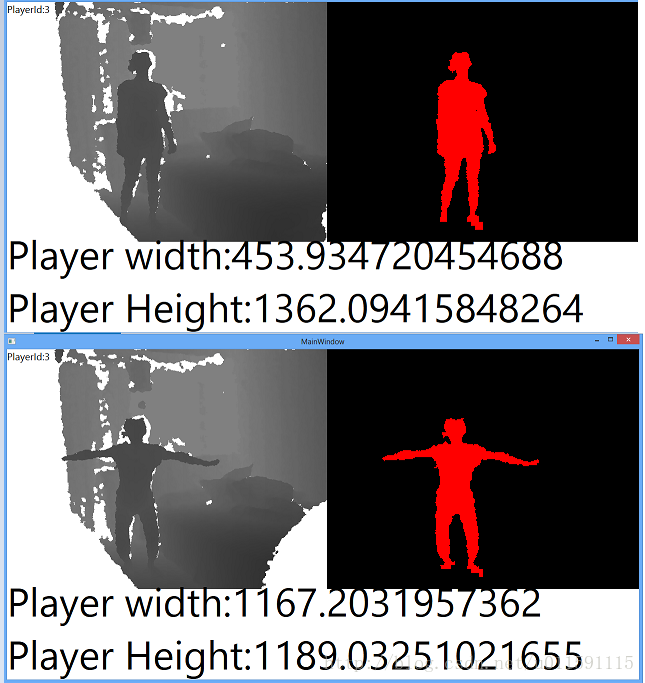

背景知识 1. 前面已经有提到,所谓直方图就是不同深度的像素分布图。 2. Player id只有在打开SkeletonStream的时候才会产生。 SkeletonStream skeletonStream =kinectSensor.SkeletonStream; skeletonStream.Enable(); Playerid是动态分配的,同一个人走出视线再回来

Kinect for windows 开发入门 七:景深数据获取和使用 上

背景知识 1. 景深数据通过Kinect红外传感器(红外发射器和摄像头)获取。 2. 红外摄像机的视场是金字塔形状的。离摄像机远的物体比近的物体拥有更大的视场横截面积。这意味着影像的高度和宽度,比如640X480和摄像机视场的物理位置并不一一对应。但是每个像素的深度值是和视场中物体离摄像机的距离是对应的。 3. Kinect中深度值最大为4096mm,0值

Kinect for windows 开发入门 六:图像处理基础知识

基础概念 1. 什么是图像? 答:在计算机中,图像是以数字方式来记录处理和保存的,所以说图像是一个数字化的图像。 2. 图像的类型有那些? 答:数字化的图像大致可以分为两种类型:向量式图像和点阵式图像。向量式图像也称为矢量式图像,是以数字式的向量方式来记录图像的,内容以线条和色块为主。点阵式图像是由许多点组成的,这些点称为像素。 3.

Kinect for windows 开发入门 五:彩色数据获取和使用

背景知识 1. WriteableBitmap之于Bitmap,就好像StringBuilder之于String。可以减少内存消耗。WriteableBitmap在初始化时需要指定高度,宽度和格式。上一节示例中,获取每帧图像都需要创建并初始化一个新的Bitmap,对GPU来说是一个极大的负担。用WriteableBitmap替代可以很大程度上提高性能。 2. 色彩数据流的解

Kinect for windows 开发入门 三:开发环境部署

我的开发平台 Windows8(英文)+ VS2012(包含1,2,3更新包)+ Kinect for windows SDK v1.7 安装要求 系统要求:Win7\Win8\WindowsEmbedded 7\Windows Embedded 8 硬件要求:32位或64位系统\2.66Ghz以上cpu\2G内存\支持DirectX9.0c以上的显卡\微软的Kinect 软件要求

Kinect开发之体感举起手来程序设计(Kinect俄罗斯方块)

上一篇博文介绍了一下Kinect的简单姿势识别,详细内容请转到http://yacare.iteye.com/blog/1950112,鄙人之前还写过一个俄罗斯方块的程序,具体请看http://yacare.iteye.com/blog/1949398,本博文主要将这两者结合起来,用Kinect姿势来控制游戏。仅作为一个抛砖引玉的案例,不知道公安局是否备案(哈哈,开个玩笑)。来说明去我们

Kinect开发之简单姿势识别

姿势(POSE)识别方案(含简单算法) 简析:身体以及各个关节点的位置定义了一个姿势。更具体的来说,是某些关节点相对于其他关节点的位置定义了一个姿势。 姿势的类型和复杂度决定了识别算法的复杂度。 通过关节点位置的交叉或者关节点之间的角度都可以进行姿势识别。 通过关节点交叉进行姿势识别就是对关节点进行命中测试。在上一篇博文中,我们可以确定某一个关节点的位置是否在 UI 界面上

Kinect+OpenNI学习笔记之1(开发环境的建立)

前言 一般的普通摄像机获取的是RGB彩色图像,在计算机视觉领域,很大一部分都是基于颜色图像来做处理的,取得了不少研究成果。最近几年的深度图研究给计算机视觉和图像处理带来了更多的信息,因为所获取的图像多了一个维度的,通常也称之为RGBD图。比较物美价廉的深度信息获取传感器有MS的Kinect,同时还有ASUS的Xtion。这2种传感器都能较为准确的获得一定范围内物体的深度信息。比如说Ki

Ubuntu14.04下搭建Kinect V2的环境以及出现的问题解决方案

请各位注意是kinect V2,kinect有两个版本,V1和V2 一、安装 1、Download libfreenect2 source git clone git@github.com:DongdongBai/libfreenect2.gitcd libfreenect2 2、Download upgrade deb files cd depends; ./download_d

Ubuntu14.04下搭建Kinect V1的环境

请各位注意是kinect V1,kinect有两个版本,V1和V2 如有任何问题,feel free to contact me at baidongdong@nudt.edu.cn 1.安装依赖项 sudo apt-get install git build-essential python libusb-1.0-0-dev freeglut3-devsudo apt-get ins

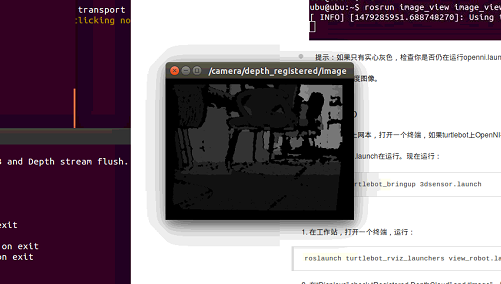

Turtlebot入门-测试Kinect

Turtlebot入门-测试Kinect 测试Kinect或asus_xtion_pro 注意: kinect,请安装freenect替代openni 安装openni和freenect驱动 安装驱动 $ sudo apt-get install ros-indigo-openni-* ros-indigo-openni2-* ros-indigo-freenect-*$ rospack p

Azure Kinect DK 在ubuntu16.04上的安装

这里我安装的是1.2.0版本的sdk,因为我后续要安装Ros版本,现在的Ros版本更新到1.2.0了。 1.下载sdk git clone -b v1.2.0 https://github.com/microsoft/Azure-Kinect-Sensor-SDK.git 2.下载libdepthengine.so.2.0文件 到这个网站中下载libk4a1.2里的deb文件:https:

Kinect for Windows 和 Xbox 360比较

最近因为kinect一直连不上笔记本,所以不断的重装重装系统,后来发现xbox360居然可以! 真坑爹! 记录一下二者在ubuntu下的连接区别: 1.连接接口 Kinect for Windows 大部分的时候还是可以用openni2的,我装过三台电脑,两台可以连接K4W,一台不行。但是只能连接usb2.0接口,usb3.0绝对不行。 xbox360什么接口都可以~~~~ 2.连接速

Unity3D学习:结合Kinect进行游戏开发 | 孤舟博客

最近需要学习Unity3D和Kinect交互进行开发。查阅网上的资料,一直没有找到详尽而又简单的方案。今天终于摸索出来在Unity3D中使用Kinect的方法,特此做个笔记。 一、Unity和Kinect交互的环境配置 我所使用的Unity3D的版本是Unity3.5,使用的Kinect SDK版本是SDK1.6,令Kinect和Unity交互的方法是使用CMU的封装,但是这个方法支持的

飞行机器人专栏(十四)-- Kinect DK 人体骨骼点运动提取方法

系列文章目录 Ubuntu 18.04/20.04 CV环境配置(下)--手势识别TRTpose+Kinect DK人体骨骼识别_ubuntu kinect骨骼测试-CSDN博客文章浏览阅读1.3k次。trt_pose_ros+ kinect实现手势识别和人体骨骼识别,用于机器人运动控制参考_ubuntu kinect骨骼测试https://haowang.blog.csdn.net/artic

kinect学习笔记五(线程并发)

因为想同时处理左右手,想采用线程并发来同时处理,提高处理速度,找了些材料,贴到这里以供以后使用 #include <windows.h>#include <iostream>using namespace std;DWORD WINAPI processRightHand(LPVOID param); //右手处理线程DWORD WINAPI processLeftHand(LPVOID

kinect学习笔记四(距离变换 distance tranform 和opencv像素访问方式)

当时自己理解的一点小误区,放到这里防止再犯错。 距离变换的基本意思就是计算一个图像中非零像素点到最近的零像素点的距离,也就是到所有零像素点的最短距离。建立距离变换图像可以方便提取骨骼 在opencv中有专门的函数cvDistTransform来计算距离变换图像。 DistTransform计算输入图像的所有非零元素对其最近零元素的距离void cvDistTransform( con

kinect学习笔记三(SDK精确度矫正)

1、在提取深度图像的时候提取到的ID和在骨骼定位中的用户ID是相等的。。。惊喜!!! 确切的说应该是这样:深度图像的ID是0、1、2、3、4、5、6、7,其中0是表示背景,而骨骼图像的ID是0、1、2、3、4、5、6,其中0表示的是检测到的一个人,所以两者关系应该是:骨骼ID+1=深度ID