iclr2024专题

ICLR2024: 大视觉语言模型中对象幻觉的分析和缓解

https://arxiv.org/pdf/2310.00754 https://github.com/YiyangZhou/LURE 背景 对象幻觉:生成包含图像中实际不存在的对象的描述 早期的工作试图通过跨不同模式执行细粒度对齐(Biten et al.,2022)或通过数据增强减少对象共现模式(Rohrbach et al.,2018; Kim et al.,2023)来解决小规模多

ICLR2024佳作:多视图Transformer再次升级,直接感知三维几何信息

论文标题: GTA: A Geometry-Aware Attention Mechanism for Multi-View Transformers 论文作者: Takeru Miyato, Bernhard Jaeger, Max Welling, Andreas Geiger 导读: 本文提出一种几何感知注意力机制,替换Transformer中原有的位置编码方式,使得Transfo

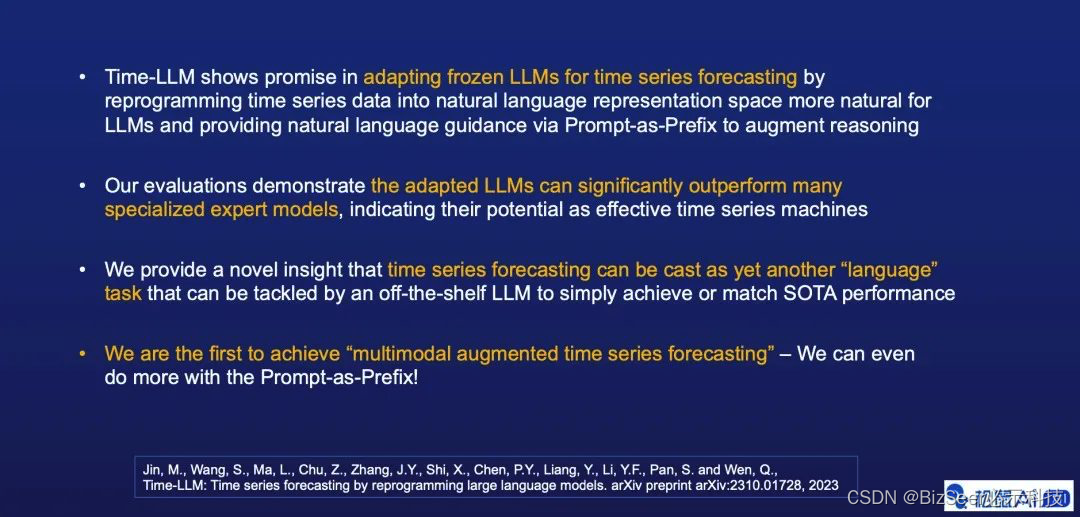

顶会ICLR2024论文Time-LLM:基于大语言模型的时间序列预测

文青松 松鼠AI首席科学家、AI研究院负责人 美国佐治亚理工学院(Georgia Tech)电子与计算机工程博士,人工智能、决策智能和信号处理方向专家,在松鼠AI、阿里、Marvell等公司超10年的技术和管理经验,近100篇文章发表在人工智能相关的顶会与顶刊,多篇文章被AI顶会(NeurIPS, ICLR等)评选为Oral/Spotlight论文,两次入选IJCAI最具影响力论文并排名第一

今日arXiv最热NLP大模型论文:无需数据集,大模型可通过强化学习与实体环境高效对齐 | ICLR2024

引言:将大型语言模型与环境对齐的挑战 虽然大语言模型(LLMs)在自然语言生成、理解等多项任务中取得了显著成就,但是在面对看起来简单的决策任务时,却常常表现不佳。这个问题的主要原因是大语言模型内嵌的知识与实际环境之间存在不对齐的问题。相比之下,强化学习(RL)能够通过试错的方法从零开始学习策略,从而确保内部嵌入知识与环境的对齐。但是,怎样将先验知识高效地融入这样的学习过程是一大挑战,为了解决这一

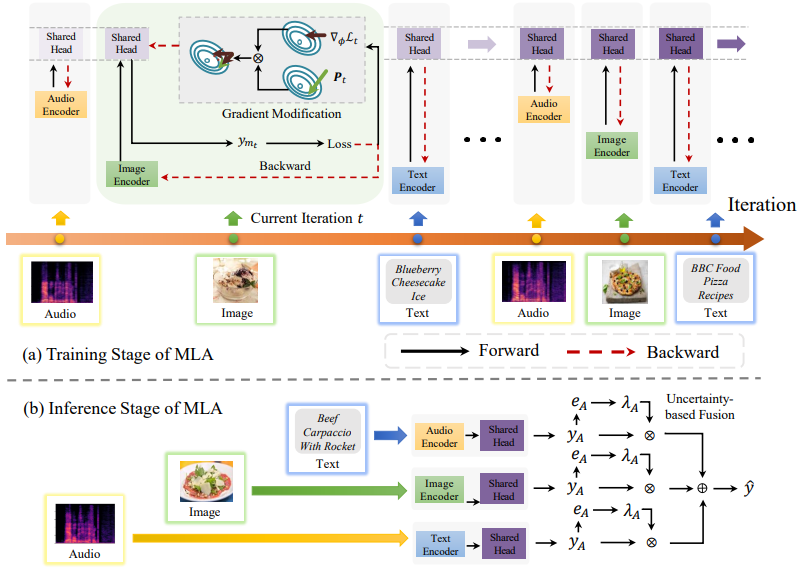

多模态融合最新创新方法汇总(附ICLR2024必看的22篇文章和源码)

今天盘点了 ICLR 2024 顶会中有关多模态融合领域的最新研究成果,共22篇,方便同学们更高效地了解最新的融合方法、快速获得论文创新点的启发。 论文主要涉及大模型+多模态融合、自动选择和构建模态、视觉Transformer的3D对象检测、动态多模态融合的深度平衡、基于Transformer的系统融合方法等热门主题。 论文和代码需要的同学看文末 1.Progressive Fusion f

Openreview IClR2024审稿意见以及如何rebuttal

R1 为什么直接从其他剧集获取信息可以提高性能,尽管动态可能会有所不同。 请与其他一些数据增强基线进行比较。 R2 问题: 批评者和价值差异d(s,a,s',a')似乎是在IM中共同学习的。为什么这是一个有意义的目标?与其他带有类比推理模块的方法相比,该方法的表现如何?该方法如何在其他任务上执行?例如,其他 Mujoco 任务,如 Walker2d、Hopper 和 Humanoi