graphsage专题

图神经网络(GNN):同质图模型【GCN/GraphSAGE/GAT...】、异质图模型【HAN/HetGNN...】

目前的图神经网络主要针对同质图(节点类型和边类型单一)设计. 同质图中只有一种类型的节点和边(例如,只有朋友关系的社交网络),网络结构较为简单.因此,同质图神经网络通常只需要聚合单一类型的邻居来更新节点的表示即可(例如,通过在朋友关系下的邻居来更新节点表示).但真实世界中的图大部分都可以被自然地建模为异质图(多种类型的节点和边,如下图所示,IMDB数据中包含三种类型的节点Actor、Movie和

【intro】GraphSAGE

论文 https://arxiv.org/pdf/1706.02216 abstract 大图中节点的低维embedding已经被证明在各种预测任务中非常有用,然而,大多数现有的方法要求在embedding训练期间图中的所有节点都存在;这些先前的方法属于直推式(transductive),不能自然地推广到看不见的节点。这里我们介绍GraphSAGE,一个通用的归纳式(inductive)框架

图神经网络三剑客:GCN、GAT与GraphSAGE

图神经网络三剑客:GCN、GAT与GraphSAGE 2020-2-27 17:28| 发布者: 炼数成金_小数| 查看: 47856| 评论: 0|原作者: 桑运鑫|来自: PaperWeekly 摘要: 2019 年号称图神经网络元年,在各个领域关于图神经网络的研究爆发式增长。本文主要介绍一下三种常见图神经网络:GCN、GAT 以及 GraphSAGE。前两者是目前应用比较广泛的图神经网络

GraphSAGE 到底在训练什么? 图上的Mini-Batch 是怎么训练的 ?

1. 一个端到端的 同构图(Cora数据集)节点分类代码: import argparseimport dglimport dgl.nn as dglnnimport torchimport torch.nn as nnimport torch.nn.functional as Ffrom dgl import AddSelfLoopfrom dgl.data import Cites

GCN,GraphSAGE 到底在训练什么呢?

根据DGL 来做的,按照DGL 实现来讲述 1. GCN Cora 训练代码: import osos.environ["DGLBACKEND"] = "pytorch"import dglimport dgl.dataimport torchimport torch.nn as nnimport torch.nn.functional as Ffrom dgl.nn.pyt

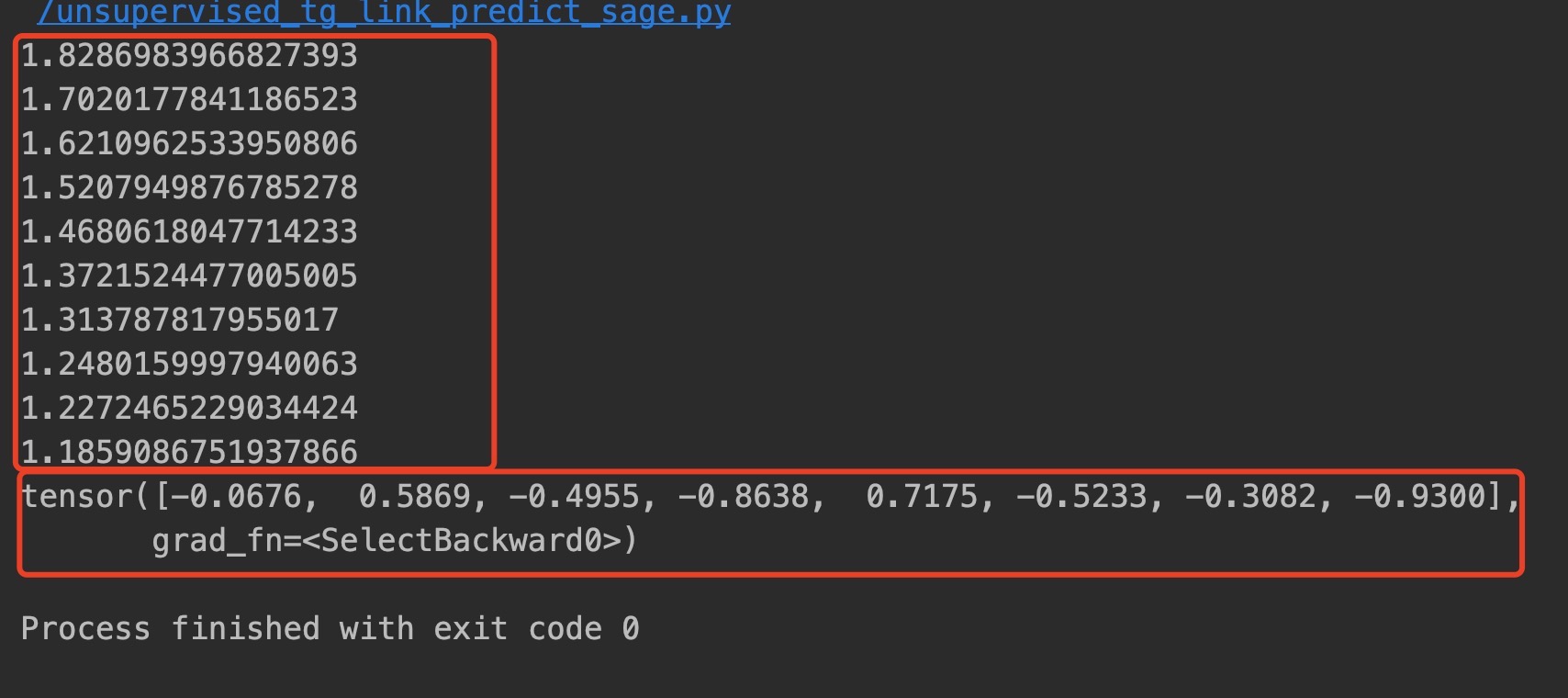

【图神经网络】GraphSAGE 无监督训练源码剖析

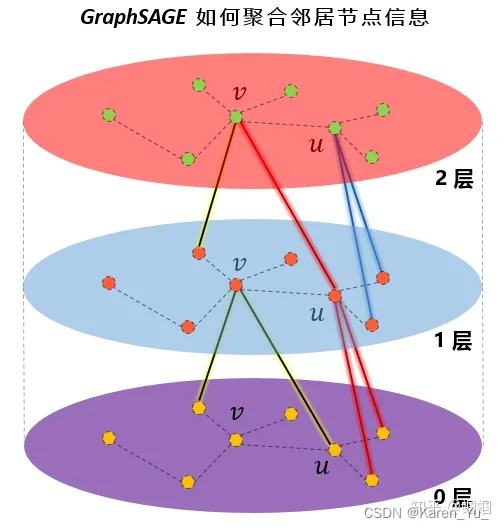

概述 本教程主要介绍pytorch_geometric库examples下的graph_sage_unsup.py的源码剖析,主要的关键技术点,包括: 如何实现随机采样的?SAGEConv是如何训练的? 关键问题1,随机采样和采样方向的问题(有向图) 首先要理解的是,采样的过程和特征聚合的过程是相反的,采样的过程,比如,如下图所示,先采样A节点的一阶邻域节点,再根据一阶采样得到的节

图神经网络必读的5个基础模型: GCN, GAT, GraphSAGE, GAE, DiffPool.

来源:机器学习算法那些事 极市平台 https://zhuanlan.zhihu.com/p/136521625 本文约6000字,建议阅读10分钟 本篇文章将从一个更直观的角度对当前经典流行的GNN网络,包括GCN、GraphSAGE、GAT、GAE以及graph pooling策略DiffPool等等做一个简单的小结。 “近年来,深度学习领域关于图神经网络(Graph Neural Net

Inductive Representation Learning on Large Graphs 论文/GraphSAGE学习笔记

1 动机 1.1 过去的方法 现存的方法大多是transductive的,也就是说,在训练图的时候需要将整个图都作为输入,为图上全部节点生成嵌入,每个节点在训练的过程中都是可知的。举个例子,上一次我学习了GCN模型,它的前向传播表达式为: H ( l + 1 ) = σ ( D ~ − 1 2 A ~ D ~ − 1 2 H ( l ) W ( l ) ) H^{(l+1)}=σ(\wid

【论文笔记】GraphSAGE:Inductive Representation Learning on Large Graphs(NIPS)

学习心得 GCN不能泛化到训练过程中没有出现的节点(即属于 t r a n s d u c t i v e transductive transductive 直推式学习,若加入新节点则需要重新训练模型),既然有新增的结点(一定会改变原有节点),那就没必要一定得到每个节点的固定表示。而GraphSAGE就是为了解决这种问题,利用Sample(采样)和Aggregate(聚合)两大核心步骤,通过

B.图算法:图学习之图神经网络GraphSAGE、GIN图采样算法[系列七]

图学习图神经网络算法专栏简介:主要实现图游走模型(DeepWalk、node2vec);图神经网络算法(GCN、GAT、GraphSage),部分进阶 GNN 模型(UniMP标签传播、ERNIESage)模型算法等,完成项目实战 专栏链接:图学习图神经网络算法专栏简介:含图算法(图游走模型、图神经网络算法等)原理+项目+代码实现+比赛 前人栽树后人乘凉,本专栏提供资料:快速掌握图游走

A.特定领域知识图谱知识推理方案:知识图谱推理算法综述[四](基于图传播的模型:node2vec、GCN、Graphsage、GeniePath等)算法汇总和应用场景归纳

知识图谱专栏简介:数据增强,智能标注,文本信息抽取(实体关系事件抽取)、知识融合算法方案、知识推理、模型优化、模型压缩技术等 专栏详细介绍:知识图谱专栏简介:数据增强,智能标注,文本信息抽取(实体关系事件抽取)、知识融合算法方案、知识推理、模型优化、模型压缩技术等 NLP知识图谱相关技术业务落地方案和码源,本专栏会持续更新包含知识图谱(知识融合、知识推理等)、NLP业务落地方案以及码源

GraphSAGE-Inductive Representation Learning on Large Graphs

简介 GraphSAGE-原文在摘要中这样介绍:we learn a function that generates embeddings by sampling and aggregating features from a node’s local neighborhood.我们学习一个函数,这个函数可以从一个节点的邻居节点中进行采样和聚合特征来生成embedding。 如何理解呢?简单来说

GraphSage与DGL实现同构图 Link 预测,通俗易懂好文强推

GraphSage与DGL实现同构图 Link 预测,通俗易懂好文强推 文章源码下载地址:点我下载http://inf.zhihang.info/resources/pay/7692.html 书接上文,在作者以前的文章 graphSage还是HAN ?吐血力作综述Graph Embeding 经典好文 和 一文揭开图机器学习的面纱,你确定不来看看吗 ,我们已经了解到 图机器学习/深度学习

![B.图算法:图学习之图神经网络GraphSAGE、GIN图采样算法[系列七]](https://img-blog.csdnimg.cn/d553c7dadca54bdb82a3a234befb74d8.png#pic_center)