fcos专题

FCOS:全卷积一阶段Anchor Free物体检测器,多种视觉任务的统一框架

点击上方“AI公园”,关注公众号,选择加“星标“或“置顶” 导读 这是众多Anchor Free中比较有影响力的一篇文章,不光是效果好,而且思路清楚,简单,不需要任何trick,并将众多的视觉任务统一到了一个框架中,值得一看。 摘要 这是一篇one stage的anchor free的目标检测的文章,而且是个全卷积的结构。提出了一个非常简单和灵活的物体检测的框架,效果也非常的好。 1. 介绍

目标检测 CVPR 2019 FCOS

参考: 1 这是一篇anchor-free的目标检测算法。以往的anchor-based算法的缺点: 缺点一:检测性能对于anchor的大小、数量、长宽比都非常敏感 缺点二:固定的anchor损害检测器的普适性,导致对于不同任务,其anchor都必须重新设置大小和长宽比。 缺点三:为匹配真实框,需生成大量anchor,但是大部分anchor在训练时标记为negative,就会造成样本间的不平衡,

FCOS 计算loss源码解读

FCOS loss计算源码解读 最近在看FCOS论文总觉得不够具体,特此调试了源代码解读源代码以供自己以后查看。其中有很多技巧如果不是读作者源码是很难想到的。 包含一下内容: 如何根据原始数据的box坐标生成loss函数需要的box样式如何根据大小不同box的分配不同level的特征图 """This file contains specific functions for comput

FCOS加入ASFF的Attention机制

FCOS加入ASFF加权结构 这里是我对FCOS的结构加入了ASFF的Attention机制,将FCOS中fpn.py替换为下面代码即可。 # Copyright (c) Facebook, Inc. and its affiliates. All Rights Reserved.import torchimport torch.nn.functional as Ffrom torch

最新1904CVPR:FCOS—全卷积单阶段目标检测超越YOLOv3

FCOS:Fully Convolutional One-Stage Object Detection https://arxiv.org/pdf/1904.01355.pdf 简述 几乎所有最先进单阶段目标检测RetinaNet,SSD,YOLOv3和更快的R-CNN都依赖于anchors(预选框)。 FCOS取消了anchors,通过消除预定义的anchor boxes,即proposal

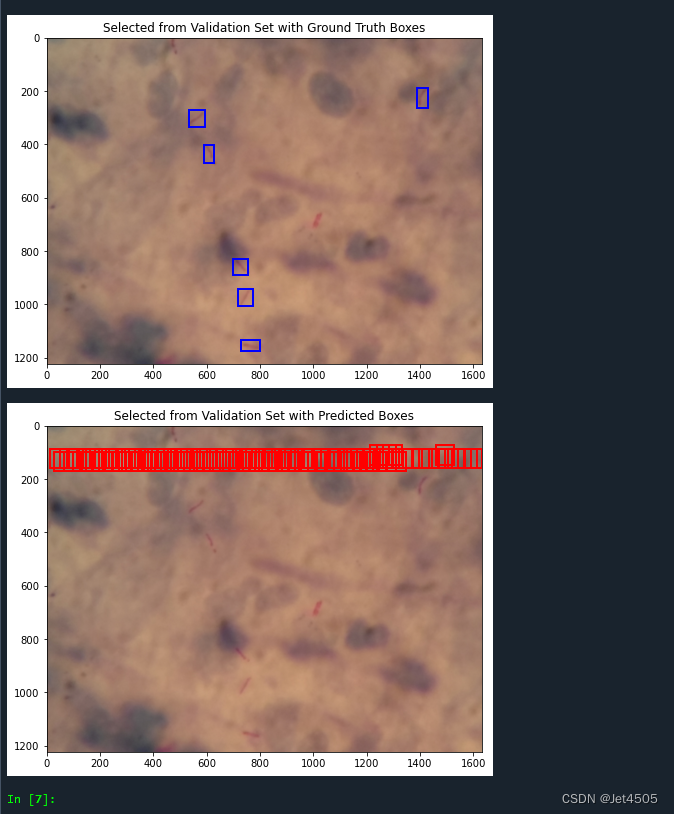

第96步 深度学习图像目标检测:FCOS建模

基于WIN10的64位系统演示 一、写在前面 本期开始,我们继续学习深度学习图像目标检测系列,FCOS(Fully Convolutional One-Stage Object Detection)模型。 二、FCOS简介 FCOS(Fully Convolutional One-Stage Object Detection)是一种无锚框的目标检测方法,由 Tian et al. 在

目标定位与检测系列(16):FCOS

文章目录 摘要动机FCOS检测框架整体框架FPN用于FCOSCenter-ness用于FCOS 实验结果总结 摘要 我们提出了一个全卷积一阶段目标检测框架,以类似于实例分割的逐像素预测方式来解决目标检测问题。目前几乎所有顶尖的目标检测框架(如RetinaNet,SSD,YOLOv3,Faster R-CNN等)都依赖于预定义的锚框。相反,我们提出的FCOS目标检测框架不需要锚框,

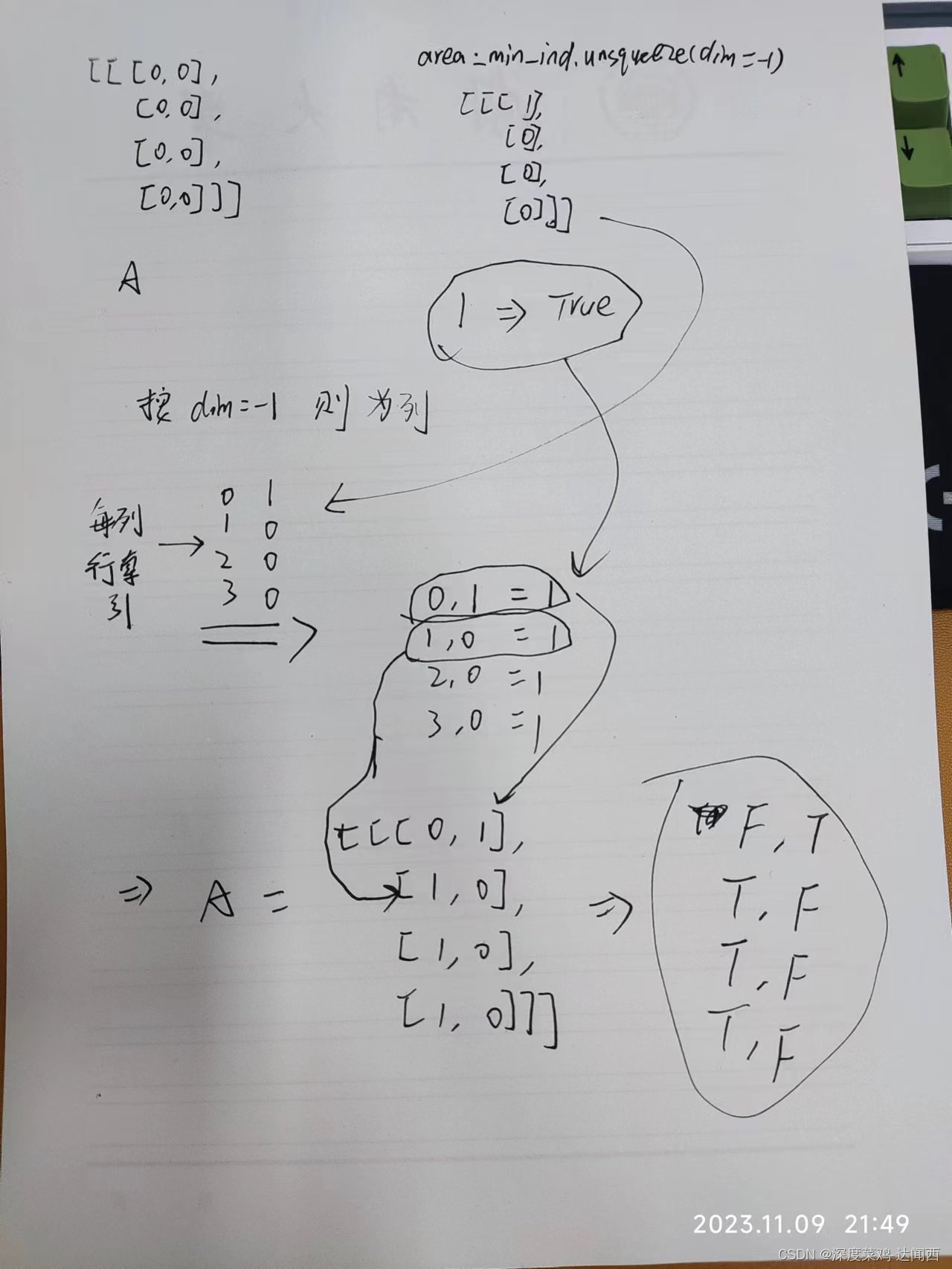

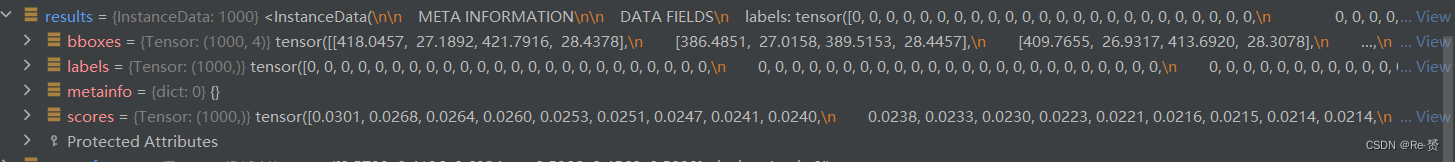

【mmdetection代码解读 3.x版本】以Fcos+FasterRcnn为例

文章目录 前言RPN部分的代码1. loss函数(two_stage.py)1.1 loss_and_predict函数(base_dense_head.py)1.1.1 loss_by_feat函数(fcos_head.py)1.1.1.1 get_targets函数 1.1.2 predict_by_feat函数(base_dense_head.py)1.1.2.1 _predict_b