fastgpt专题

使用Python写一个适用于Dify和FastGPT的JsonPath插件

编写适用于 Dify 和 FastGPT 的 JsonPath 插件 在本文中,我将分享如何编写一个适用于 AI应用平台的 JsonPath 插件,该插件能够处理 JSON 数据的路径查询、正则表达式提取,以及 JavaScript 沙盒执行功能。这个插件的主要目的是让用户能够通过简单的 HTTP 请求,对 JSON 数据进行高效、灵活的查询和处理。接下来,我们将详细介绍如何实现这个插件的功能。

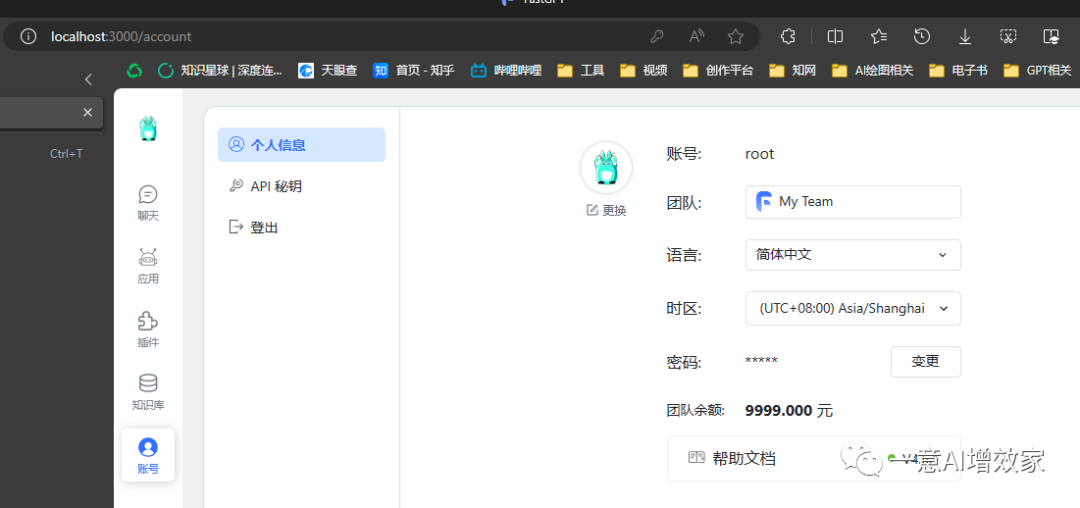

FastGPT如何增减用户

背景 开源版本的FastGPT默认只有一个超级用户root,为了更好地管理应用和知识库,可以通过操作MongoDB数据库来增加新的用户和团队。 所需环境 已安装并运行的FastGPT实例MongoDB客户端工具(如Mongo Shell或Robo 3T等) 操作步骤 启动MongoDB客户端 在命令行中启动MongoDB客户端,并连接到FastGPT使用的数据库。 增加新用户 向us

小白之 FastGPT Windows 本地化部署

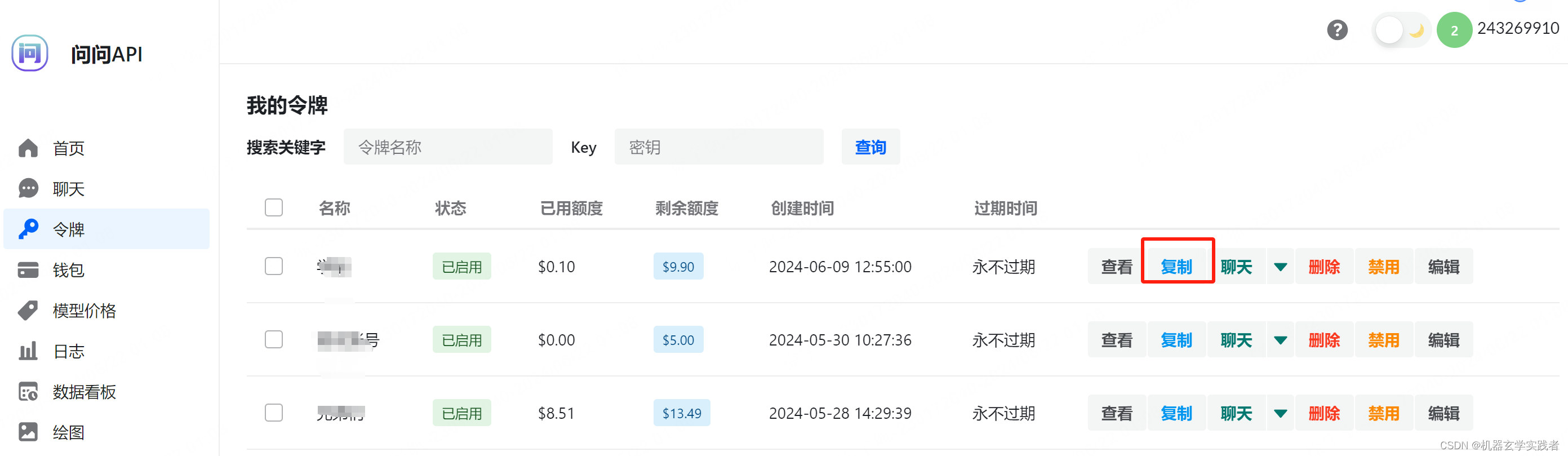

目录 引言环境步骤1. 安装 docker2. 启动 docker3. 浏览器访问4. One API 配置语言模型、向量模型渠道和令牌5. 创建 FastGPT 知识库6. 创建 FastGPT 应用 官方文档 引言 部署之前可以先看一下 RAG 技术原理,也可以后面回过头来看,对一些概念有些了解,对部署的内容会有更好的理解 环境 Windows 10docker 27.0

Chainlit接入FastGpt接口完美对接,实现全新的用户聊天界面

前言 由于fastgpt只提供了一个分享用的网页应用,网页访问地址没法自定义,虽然可以接入NextWeb/ChatGPT web等开源应用。但是如果我们想直接给客户应用,还需要客户去设置配置,里面还有很多我们不想展示给客户的东西怎么办?于是,我使用Chainlit实现了一个无缝快速接入fastgpt实现自定义用户使用界面的应用,代码清晰简单。还可以自定义logo、欢迎语、网站图标等。 之前写一个

Chainlit接入FastGpt接口快速实现自定义用户聊天界面

前言 由于fastgpt只提供了一个分享用的网页应用,网页访问地址没法自定义,虽然可以接入NextWeb/ChatGPT web等开源应用。但是如果我们想直接给客户应用,还需要客户去设置配置,里面还有很多我们不想展示给客户的东西怎么办?于是,我使用Chainlit实现了一个无缝快速接入fastgpt实现自定义用户使用界面的应用,代码清晰简单。还可以自定义logo、欢迎语、网站图标等。 快速开始

Fastgpt AI知识库 - 快速开始本地开发教程

本文主要介绍了如何设置Fastgpt 开源项目的开发环境以构建和测试 开发环境准备 确保你的系统已经安装了以下工具: GitDocker (用于构建镜像)Node.js 版本 v18.17 或 v20.xpnpm 版本 8.6.0(这是官方推荐的开发环境)make 命令:推荐使用 GNU Make 4.3 版本 用户默认的时区为 Asia/Shanghai,非 linux 环境时候,获

一步步教你如何使用Docker和MongoDB迁移FastGPT环境

介绍 如何使用Mongodump来完成从A环境到B环境的Fastgpt的mongodb迁移 前提说明: A环境:我在阿里云上部署的fastgpt,现在需要迁移到B环境。 B环境:是新环境比如腾讯云新部署的fastgpt,更特殊一点的是,NAS(群晖或者QNAP)部署了fastgpt,mongo必须改成4.2或者4.4版本(其实云端更方便,支持fastgpt mongo默认版本) C环境:妥善

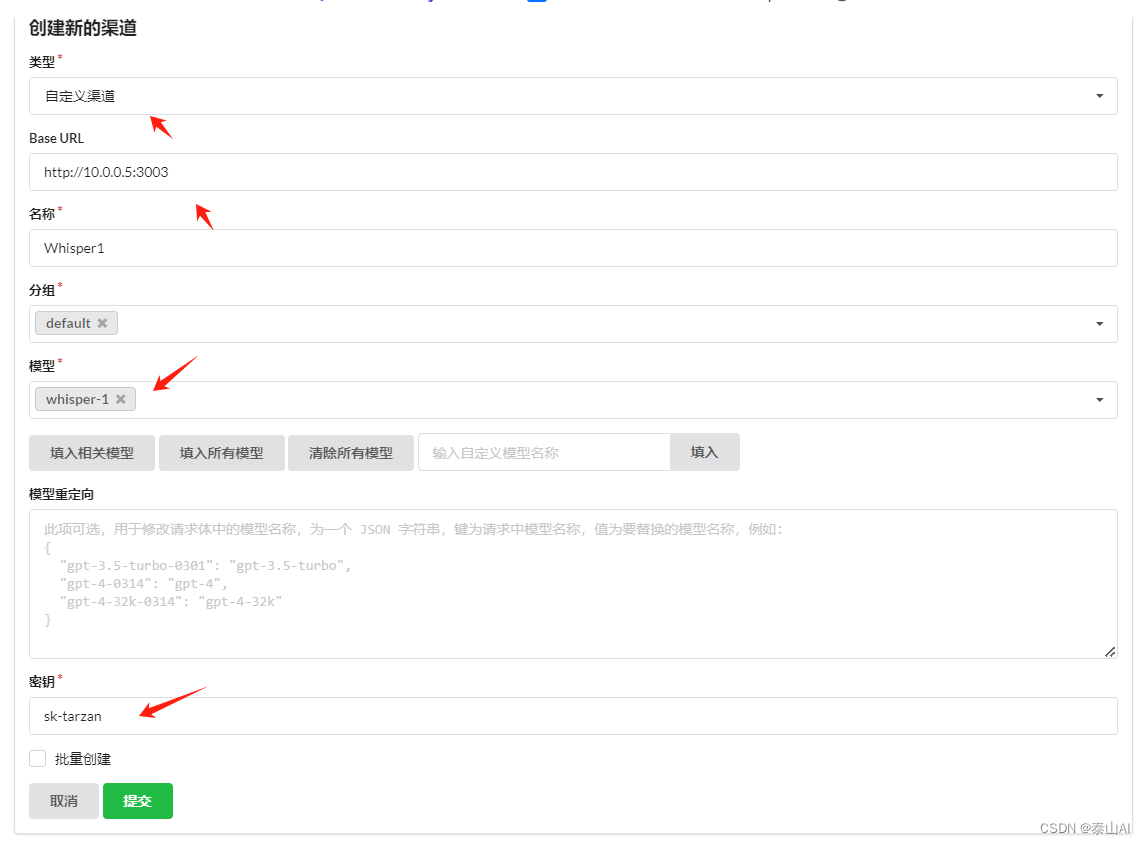

Fastgpt接入Whisper本地模型实现语音输入

前言 FastGPT 默认使用了 OpenAI 的 LLM 模型和语音识别模型,如果想要私有化部署的话,可以使用openai 开源模型Whisper。参考文章 《openai 开源模型Whisper语音转文本模型下载使用》 开源项目地址 : 兼容openai接口api服务 https://gitee.com/taisan/whisper-api 设置安全凭证(即oneapi中的渠道密钥)

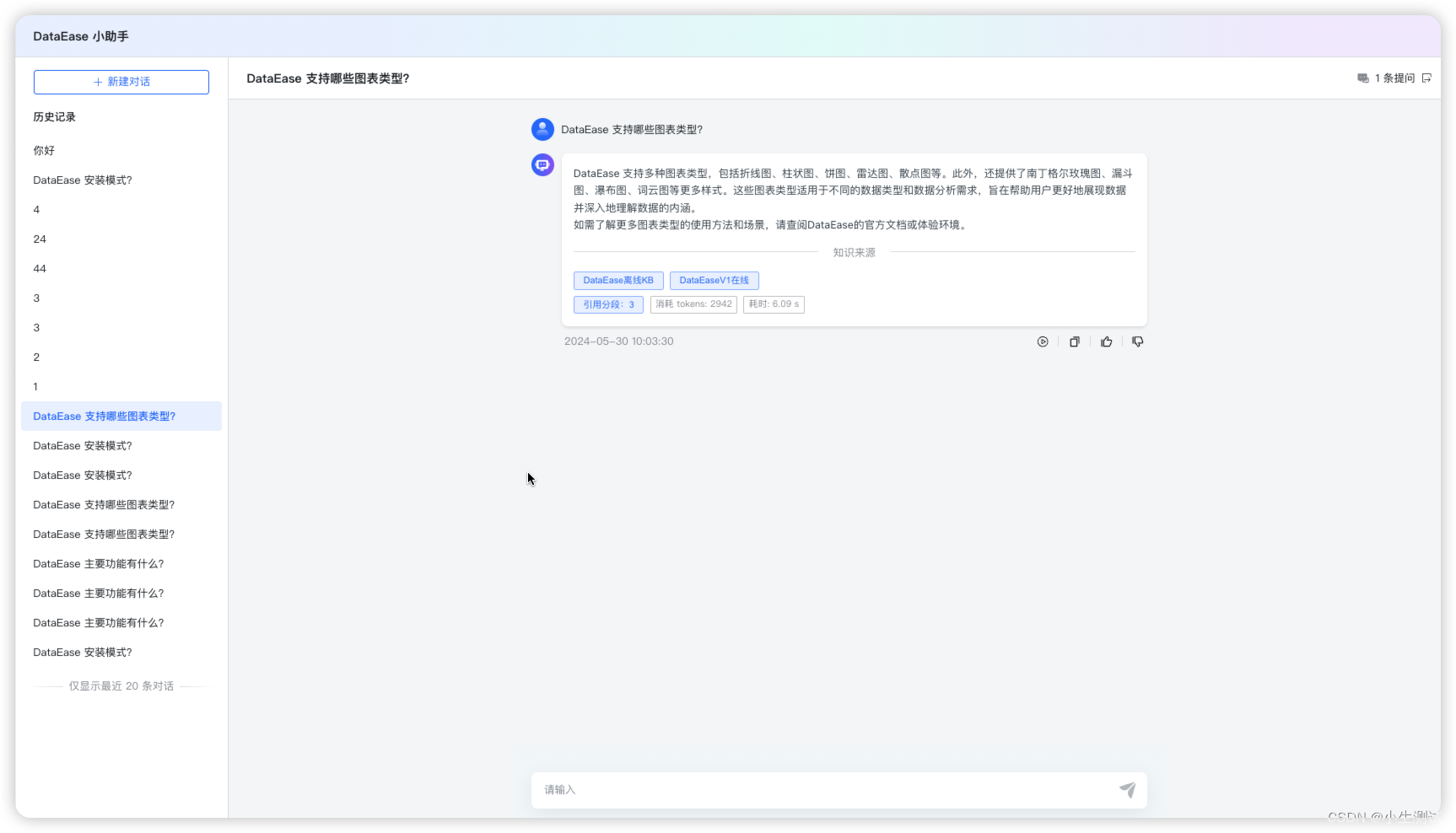

本地知识库开源框架Fastgpt、MaxKB产品体验

本地知识库开源框架Fastgpt、MaxKB产品体验 背景fastgpt简介知识库共享部署 MaxKB总结 背景 上一篇体验了Quivr、QAnything两个开源知识库模型框架,这次介绍两款小众但是体验比较好的产品。 fastgpt 简介 FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化

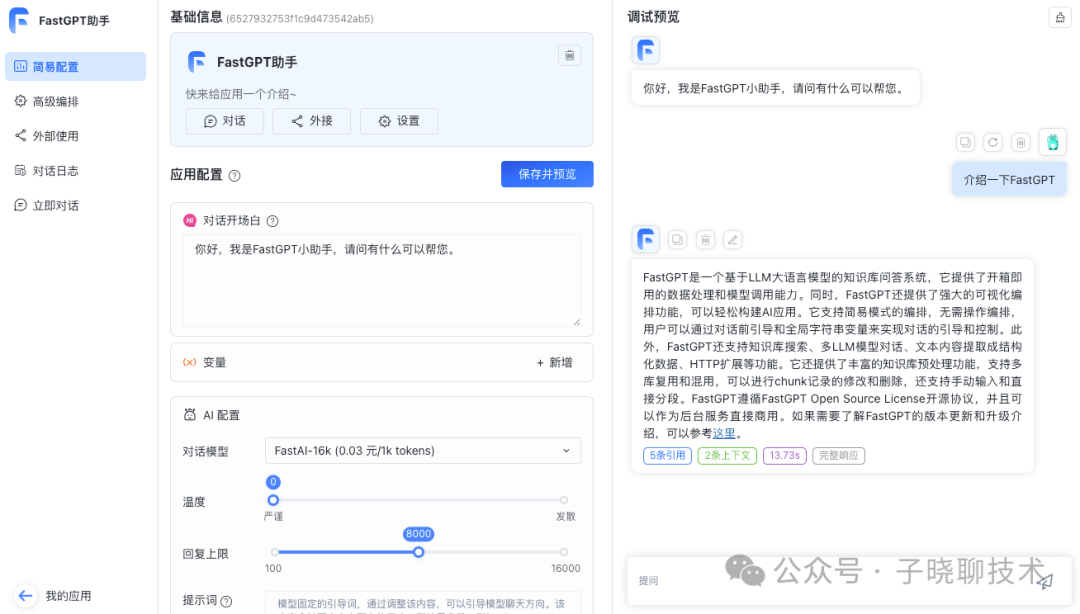

【AI+知识库问答】沉浸式体验了解 AI知识库问答fastGPT

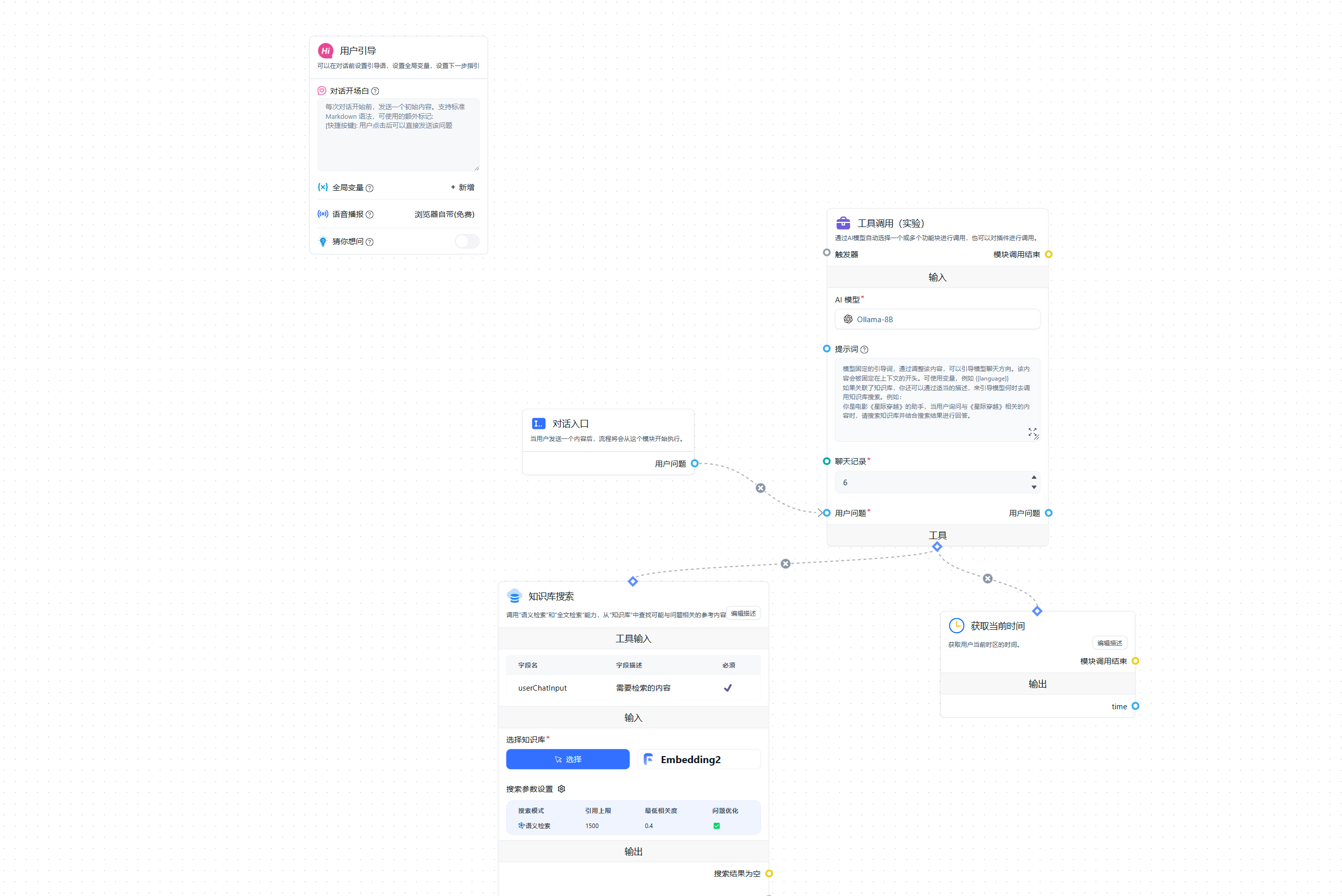

之前写过一篇文章 【AI+本地知识库】个人整理的几种常见本地知识库技术方案 , 由于当时主要是针对AI本地知识库, 所以没列fastGPT。 最近经常刷到fastGPT,这里单独水一篇。 FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!看下图 如何快速上

docker安装部署FastGPT

一:FastGPT介绍 FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景! 官网地址:https://fastgpt.in/zh docker安装部署文档地址:https://doc.fastai.site/docs/development/docker/ 二:创建d

Fastgpt知识库接入oneapi和自定义大模型

本期教程教大家训练自己的知识库回答chatgpt回答不了的问题 FastGPT 是一个知识库问答系统,可以通过调用大模型和知识库回答特定的问题 可以做成专属 AI 客服集成到现有的APP或者网站内当作智能客服支持网络爬虫学习互联网上的很多知识可以通过flow可视化进行工作流程编排 本期教程主要内容 实现fastgpt对接oneapi接入多种大模型实现fastgpt自定义大模型实现添加

使用FastGPT+OneAPI在本地使用Llama3

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!他的重要特点就是工作流编排。 工作流编排:基于 Flow 模块的工作流编排,可以帮助你设计更加复杂的问答流程。例如查询数据库、查询库存、预约实验室等。 FastGPT 遵循附加条件 Apache License 2.0 开

基于FastGPT搭建知识库问答系统

什么是 FastGPT ? FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景! FastGPT 允许用户构建本地知识库,以提高 AI 的理解能力和应用场景的适应性。该系统的设计旨在让 AI 更好地理解用户需求并提供更准确的回答。 FastGPT 功能演

fastgpt、dify功能分析比较

目录 前言 一、dify、fastgpt是什么? 二、同场pk 1.大模型接入 2.chat(最简应用) 3.发布应用 4.知识库 5.workflow 6.其他 三、一些point记录 总结 前言 现在都开始AI应用开发,何谓AI应用,起码要和AI大模型结合,应用表现形式多是对话类,当然也可以是后台调用openapi的生成式。最典型的AI应用即最早一批的chat类应

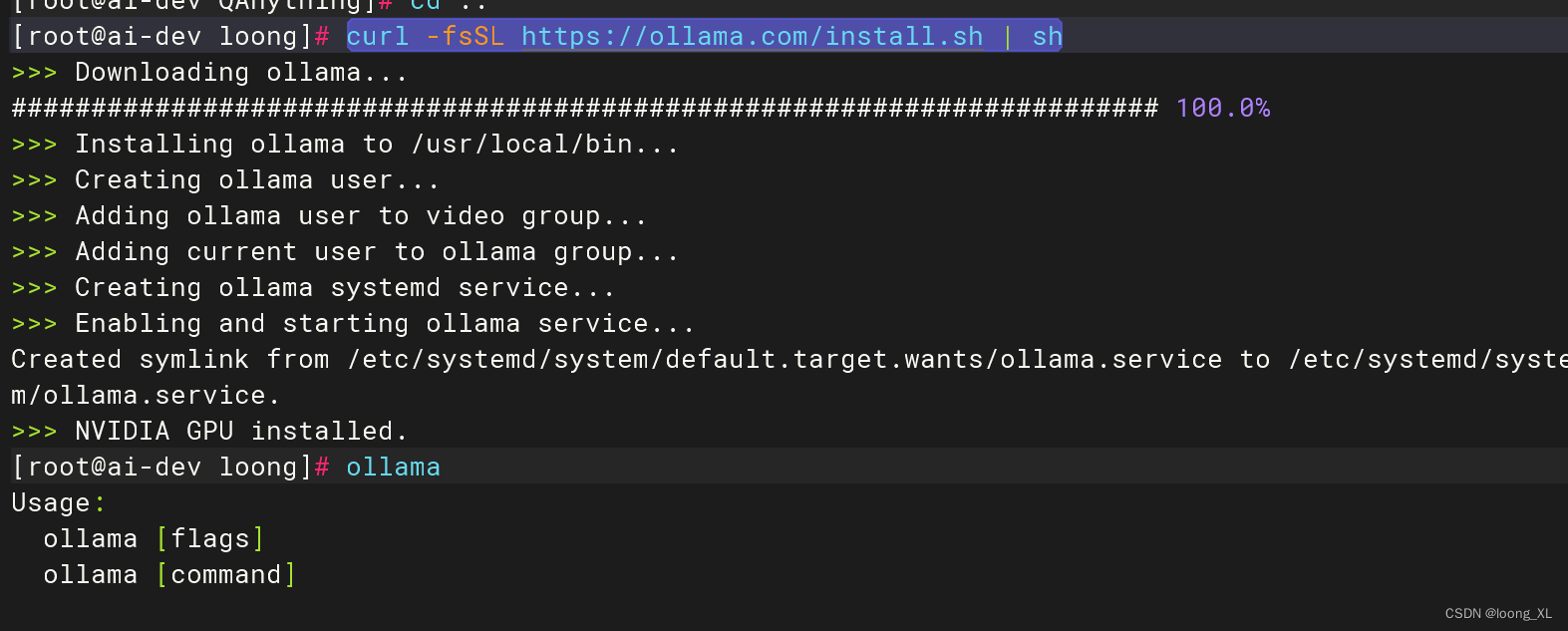

Ollama、FastGPT大模型RAG结合使用案例

参考: https://ollama.com/download/linux https://doc.fastai.site/docs/intro/ https://blog.csdn.net/m0_71142057/article/details/136738997 https://doc.fastgpt.run/docs/development/custom-models/m3e/ Oll

前端对接fastGPT流式数据+打字机效果

首先在对接api时 参数要设置stream: true, const data = {chatId: 'abc',stream: true,//这里true返回流式数据detail: false,variables: {uid: 'sfdsdf',name: 'zhaoyunyao,'},messages: [{ content: text, role: 'user' }]};

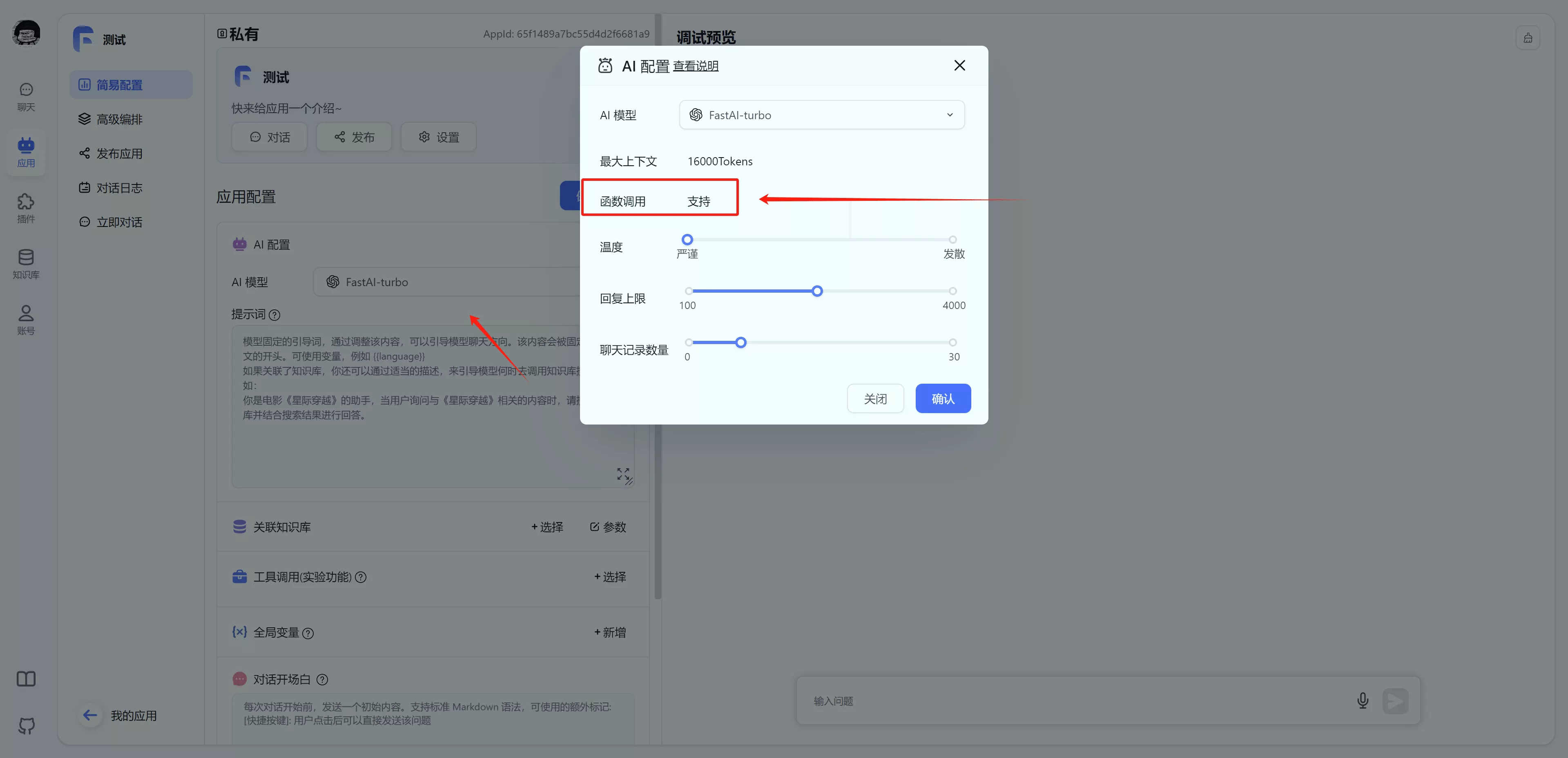

终于来了!FastGPT 正式兼容 GPT 应用

FastGPT V4.7 正式加入了工具调用功能,可以兼容 GPTs 的 Actions。这意味着,你可以直接导入兼容 GPTs 的 Agent 工具! Gapier 是一组无需编码,开箱可用的,并且已经适配好的在线 GPTs Actions 工具,提供了 50 多种现成工具,并且每天有免费额度进行测试,方便用户试用,官方地址为:https://gapier.com/ 本文将会给大家介绍如

如何本地部署开源AI知识库 FastGPT(新手教程)

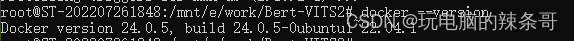

环境: Win10 WSL2 ubuntu22.04 问题描述: 如何本地部署开源AI知识库 FastGPT 解决方案: 一、安装docker和docker-compose 安装docker 1.apt install docker.io2.apt install docker-compose3.docker --version 4.docker compose vers

2024-03-21 AIGC-FastGPT-本地知识库问答系统

相关文档: 接入 ChatGLM2-6B | FastGPT (fastai.site) 相关步骤: FastGPT配置文件及OneAPI程序:百度网盘 请输入提取码 提取码:wuhe 创建fastgpt目录:mkdir fastgpt 切换到fastgpt目录:cd fastgpt 下载docker-compose文件:curl -O https://raw.github

fastgpt本地详细部署以及配置

目录 一、Docker部署1、docker安装2、docker启动3、添加用户到 docker 组:4、验证 Docker 安装: 二、one_api 本地部署1、linux系统部署2、windows系统部署 三、向量模型部署(m3e)四、chatglm2模型本地部署五、fastgpt模型本地部署1、下载配置文件2、文件配置--docker-compose配置和config配置3、fastg

FastGPT配置文件及OneAPI程序:

FastGPT配置文件及OneAPI程序:百度网盘 请输入提取码 提取码:wuhe 创建fastgpt目录:mkdir fastgpt 切换到fastgpt目录:cd fastgpt 下载docker-compose文件:curl -O https://raw.githubusercontent.com/labring/FastGPT/main/files/deploy/fastgpt/do

不!GPTs无法取代知识库?0基础搭建本地私有知识库!本地fastgpt部署!16/45

hi~ 是的!在这个系列我们做了大模型的微调,如何构建数据集、如何去做数据处理、做微调策略、算微调参数!新来的朋友去检索! 群里朋友聊,GPTs出来后,还有必要做私有知识库吗? 有! 雄哥在群里也说了,只要国家/某流行认可的第三方机构没能确保这些闭源LLM+知识库应用是100%安全的,它就有价值! 雄哥认为! 本地化+安全,是无法被取代的企业需求! 搭建知识库这个系列收到好多私信催更

FastGPT + Xinference + OneAPI:一站式本地 LLM 私有化部署和应用开发

Excerpt 随着 GPTs 的发布,构建私有知识库变得无比简易,这为个人创建数字化身份、第二大脑,或是企业建立知识库,都提供了全新的途径。然而,基于众所周知的原因,GPTs 在中国的使用依然存在诸多困扰和障碍。因此,在当… 随着 GPTs 的发布,构建私有知识库变得无比简易,这为个人创建数字化身份、第二大脑,或是企业建立知识库,都提供了全新的途径。然而,基于众所周知的原因,GPTs