exactly专题

Flink Exactly-Once 投递实现浅析

本文作者:Paul Lin 文章来源:https://www.whitewood.me 随着近来越来越多的业务迁移到 Flink 上,对 Flink 作业的准确性要求也随之进一步提高,其中最为关键的是如何在不同业务场景下保证 exactly-once 的投递语义。虽然不少实时系统(e.g. 实时计算/消息队列)都宣称支持 exactly-once,exactly-once 投递似乎是一个已被解

流式处理 术语解释 Exactly-once与Effectively-once

分布式事件流处理已逐渐成为大数据领域的热点话题。该领域主要的流处理引擎(SPE)包括 Apache Storm、Apache Flink、Heron、Apache Kafka(Kafka Streams)以及 Apache Spark(Spark Streaming)等。处理语义是围绕 SPE 最受关注,讨论最多的话题之一,其中“严格一次(Exactly-once)”是很多引擎追求的目标之一,很多

Apache Flink 如何保证 Exactly-Once 语义

一、引言 在大数据处理中,数据的一致性和准确性是至关重要的。Apache Flink 是一个流处理和批处理的开源平台,它提供了丰富的语义保证,其中之一就是 Exactly-Once 语义。Exactly-Once 语义确保每个事件或记录只被处理一次,即使在发生故障的情况下也能保持这一保证。本文将深入探讨 Flink 是如何保证 Exactly-Once 语义的,包括其原理分析和相关示例。 二、

流计算中的 Exactly Once 语义

扫码关注公众号免费阅读全文:冰山烈焰的黑板报 在大数据领域,分布式事件流处理已经成为了热门话题。目前流行的流处理引擎包括 Apache Storm、Apache Flink、Heron、Apache Kafka(Kafka Streams)和 Apache Spark(Spark Streaming)。流处理引擎被广泛讨论的一个特性——Extractly-Once,很多引擎也已经宣称支持。

Flink写出数据到 MySql 控制事务,保证Exactly_Once

文章目录 一、MySql Sink二、控制事务代码1、主线代码2、Druid 数据库连接池类 一、MySql Sink 要想使用TwoPhaseCommitSinkFunction,存储系统必须支持事务 Mysql Sink继承TwoPhaseCommitSinkFunction抽象类,分两个阶段提交Sink,保证Exactly_Once: ①做checkpoint②

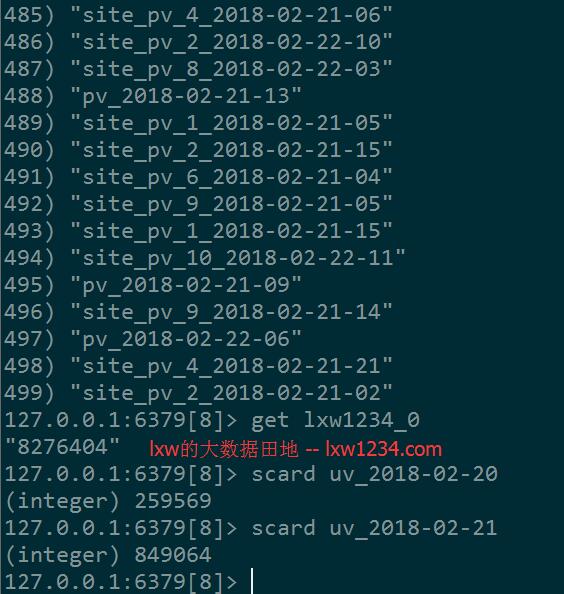

实时流计算、Spark Streaming、Kafka、Redis、Exactly-once、实时去重

本文想记录和表达的东西挺多的,一时想不到什么好的标题,所以就用上面的关键字作为标题了。 在实时流式计算中,最重要的是在任何情况下,消息不重复、不丢失,即Exactly-once。本文以Kafka–>Spark Streaming–>Redis为例,一方面说明一下如何做到Exactly-once,另一方面说明一下我是如何计算实时去重指标的。 1. 关于数据源 数据源是文本格式的日志,由Ng

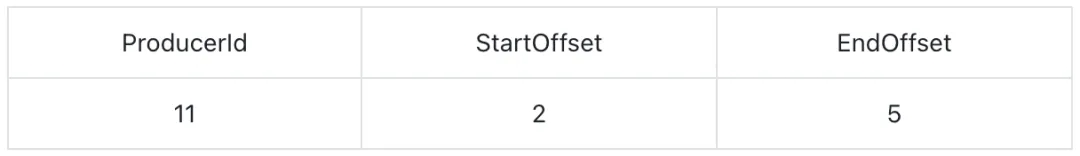

Kafka Exactly Once 语义实现原理:幂等性与事务消息

01 前言 在现代分布式系统中,确保数据处理的准确性和一致性是至关重要的。Apache Kafka,作为一个广泛使用的流处理平台,提供了强大的消息队列和流处理功能。随着业务需求的增长,Kafka 的事务消息功能应运而生,它允许应用程序以一种原子的方式处理消息,即要么所有消息都被正确处理,要么都不处理。本文将深入剖析 Kafka 的 Exactly-Once 语义实现原理,包括幂等性与事务消息的关

逐步学习Go-sync.Once(只执行一次)Exactly Once

sync.Once简介 sync.Once 是一个会执行且仅执行一次动作的对象。该对象在第一次使用后不能再被复制。 在 Go 内存模型的术语中,sync.Once 的 Do 方法中的函数 f 返回的操作,相对于任何对 once.Do(f) 的调用返回的操作,都具有“同步优先”的顺序。简单来说,即使在并发环境下,函数 f 也只会在首次调用 once.Do(f) 时执行。 每个 sync.Onc

Retrofit添加拦截器报错:must call proceed() exactly once

这是因为你的OkHttpClient.Builder调用的addNetworkInterceptor方法添加的拦截器,这种方式添加的拦截器里面的Chain只能调用一次proceed方法,如果想调用多次,你的拦截器就要用addInterceptor方法添加,就没问题了

Kafka Consumer如何实现exactly once/at least once

目录 消费端幂等性消费时出现几种异常情况自动提交手动提交 精确一次消费实现总结 至少消费一次 消费端幂等性 kafka具有两种提交offset(消费偏移量)方式,在Kafka每个分区具备一offset记录消费位置,如果消费者一直处于正常的运行转态,那么offset将没有什么用处,因为正常消费时,consumer记录了本次消费的offset和下一次将要进行poll数据的offs

(已解决)ValueError: all the input array dimensions except for the concatenation axis must match exactly

np.vstack()合并矩阵出错如下: 文本上已经解释的很清楚了,除了合并方向,其他维度上,需要被合并的输入项必须具有相同的结构。 此处我的使用背景是A股沪深300各个股票在2017-01-01到2019-01-01时间段的历史数据,沿着axis=1即垂直方向合并,这就要求在axis=0横向上各个合并项具有相同的行数,而实际因为各只股票可能存在停牌之类的情况,导致历史数据并不完善。 有的个

Kafka系列之:Exactly-once support

Kafka系列之:Exactly-once support 一、Sink connectors二、Source connectors三、Worker configuration四、ACL requirements Kafka Connect 能够为接收器连接器(从版本 0.11.0 开始)和源连接器(从版本 3.3.0 开始)提供一次性语义。请注意,对一次语义的支持高度依赖于您运行

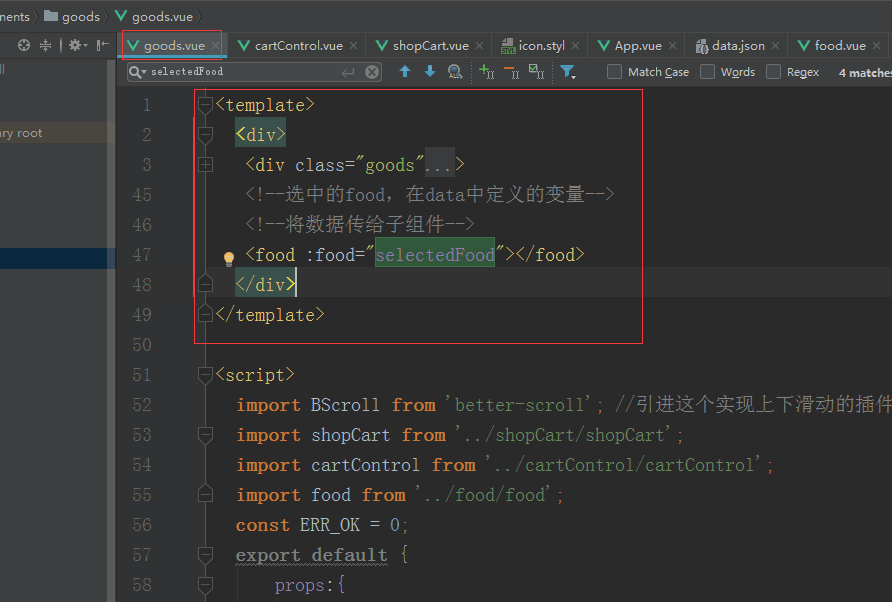

在vue中报错: Component template should contain exactly one root element

在vue中报错: Component template should contain exactly one root element. If you are using v-if on multiple elements, use v-else-if to chain them instead报错的大致意思是:组件的模板<template>应该只能包含一个根元素,也就是是说作为元素<tem

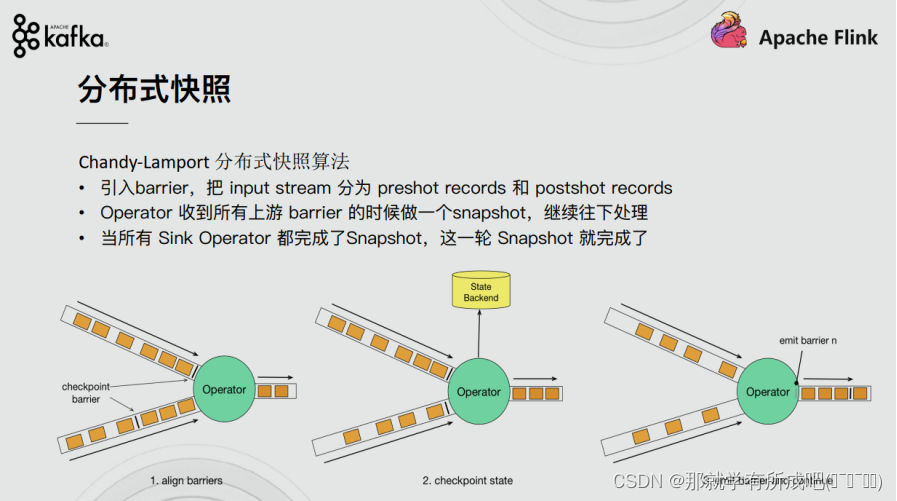

flink重温笔记(十二): flink 高级特性和新特性(1)——End-to-End Exactly-Once(端到端精确一致性语义)

Flink学习笔记 前言:今天是学习 flink 的第 12 天啦!学习了 flink 高级特性和新特性之 End-to-End Exactly-Once(端到端精确一致性语义),主要是解决大数据领域数据从数据源到数据落点的一致性,不会容易造成数据丢失的问题,结合自己实验猜想和代码实践,总结了很多自己的理解和想法,希望和大家多多交流! Tips:端到端的一致性语义,说明每一步都算术,每

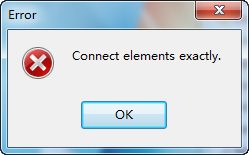

starUML使用以及出现connect elements exactly的解决办法

starUML使用以及出现connect elements exactly的解决办法 1、使用过程 (1)打开StarUML软件,界面如下。选择“Empty Project”,单击OK。 (2)右键单击界面中的“Untitled”,选择"Add"》“Model”,命名为Model1。 (3)右键单击model1,选择“Add D

ValueError: all the input array dimensions except for the concatenation axis must match exactly

输入数组必须保持尺寸维度一致,即shape属性一致!

【Vue2】Component template should contain exactly one root element.

问题描述 [plugin:vite:vue2] Component template should contain exactly one root element. If you are using v-if on multiple elements, use v-else-if to chain them instead. 原因分析 这个错误通常是由于 Vue 组件的模板中包含

【kafka实践】12|如何实现exactly once

前面的章节中我们聊到如何避免保证消息丢失,没有印象的同学可以再看看,本节我们将展开如何实现kafka的一次精确。 首先我们需要明白两个概念“幂等”和“事物” 幂等 “幂等”这个词原是数学领域中的概念,指的是某些操作或函数能够被执行多次,但每次得到的结果都是不变的。比如乘以 1 就是一个幂等操作,而数加 1 这个操作就不是幂等的,因为执行一次和执行多次的结果不同。 在计算机领域中 若一个子

Flink+Kafka如何实现端到端的exactly-once语义

我们知道,端到端的状态一致性的实现,需要每一个组件都实现,对于Flink + Kafka的数据管道系统(Kafka进、Kafka出)而言,各组件怎样保证exactly-once语义呢? 内部 —— 利用checkpoint机制,把状态存盘,发生故障的时候可以恢复,保证内部的状态一致性source —— kafka consumer作为source,可以将偏移量保存下来,如果后续任务出现了故障,恢

解决:ValueError: must have exactly one of create/read/write/append mode

解决:ValueError: must have exactly one of create/read/write/append mode 文章目录 解决:ValueError: must have exactly one of create/read/write/append mode背景报错问题报错翻译报错位置代码报错原因解决方法今天的分享就到此结束了 背景

原理+实践|Exactly-once系列实践之KafkaToKafka

全网最全大数据面试提升手册! 推荐阅读: 原理+实践|Flink-Exactly-Once Kafka2Redis一致性实践 文章目录一、Kafka输入输出流工具类二、统计字符个数案例三、消费者消费kafka的事务数据四、总结与可能出现的问题 一、Kafka输入输出流工具类 代码如下(示例): //获取kafkaStream流public static <T> DataStream<T> g