cvpr2019专题

CVPR2019 少样本学习

分类任务上的少样本学习 1.Edge-Labeling Graph Neural Network for Few-shot Learning(classification) paper: https://arxiv.org/abs/1905.01436 code: https://github.com/khy0809/fewshot-egnn 图网络(Graph Neural Ne

内涵:CVPR2019之GCNet解读

non-local论文地址 non-local代码地址 gcnet论文地址 gcnet代码地址 senet论文地址 senet代码地址 这篇文章是发表于CVPR2019上的一篇文章,文章花了相当多的文笔放在另外两篇文章Non-local(CVPR2018)和Senet(CVPR2018)之上。而且感情基调较为明显,较为质疑 Non-local的做法,中性略带赞赏性的评价Senet

[MGK∗19] 《Neural rerendering in the wild》(CVPR2019)阅读笔记 (完)

一、文献拟解决的问题 提出了一个完整的场景捕捉框架,利用网络上的图片进行一个大型建筑的全景捕获——重建和渲染将输入的场景图像分解为视点,外观,语义标签,并依靠一个近似的几何代理,我们可以渲染出真实感的图像与过去的一些方法的比较,提高了结果的真实性 效果展示: 【Neural Rerendering in the Wild - CVPR 2019-哔哩哔哩】 二、分析的思路 (一)总览 首

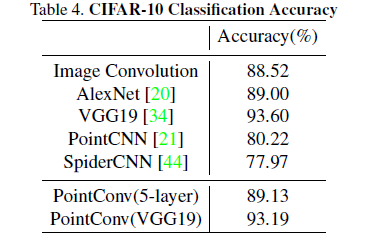

cvpr2019-PointConv

PointConv 1、创新 1、将连续卷积扩展到三维点云,对中心点的邻域内点云进行卷积 2、提出高效的PointConv执行方式(没看懂) 3、将卷积推广到反卷积(和PointNet2类似) 2、具体体现 1、理论推导 将连续的卷积核看作是关于一个3D中心点邻域坐标的连续函数 其中,W和F均为连续函数,(x,y,z)是参考点的坐标, (δx,δy,δz)表示邻域 G 中的 3

CVPR2019目标分割论文推荐(附论文及代码链接)

点上方蓝字计算机视觉联盟获取更多干货 在右上方 ··· 设为星标 ★,与你不见不散 本文来源于联盟成员学习笔记 今天推荐几篇CVPR2019目标分割论文,附带论文及代码链接 1、论文题目 《Dual Attention Network for Scene Segmentation》 论文链接 https://arxiv.org/abs/1809.02983 代码链接 https://githu

CVPR2019| 中科院VIPL实验室11篇CVPR解读:弱监督学习、视频分割、目标检测

点上方蓝字计算机视觉联盟获取更多干货 在右上方 ··· 设为星标 ★,与你不见不散 11篇论文的信息概要介绍如下: 1. VRSTC: Occlusion-Free Video Person Re-Identification (Ruibing Hou, Bingpeng Ma, Hong Chang, Xinqian Gu, Shiguang Shan, Xilin Chen) 针对视频行人重

【SiamDW(CVPR2019)oral】论文阅读Deeper and Wider Siamese Networks for Real-Time Visual Tracking

Deeper and Wider Siamese Networks for Real-Time Visual Tracking 论文地址 代码 写在前面 又是一篇关于SiamRPN的改进,加深了网络宽度与深度,优化特征提取过程,效果很好。 Motivation 深度的网络如ResNet在其他视觉任务上都有很好的表现,然而却不能移植到目标跟踪领域中;网络太深导致最后特征的感受野太大,更加关注

Meta-SR: A Magnification-Arbitrary Network for Super-Resolution 环境搭建 【CVPR2019】| ❤️有效教程❤️

🥇 版权: 本文由【墨理】原创、在CSDN首发、保质保量 🍖 该博文对【用于超分辨率的任意放大倍数网络】 Meta-SR-Pytorch 代码,进行测试和训练步骤详细记录 文章目录 🥇基础信息📕 环境搭建📗 预训练模型进行测试🔴 注意事项🔵 GPU 推理测试🔵 CPU 推理测试🟣 生成效果如下🟡 该博文测试代码分享 📙 Demo 训练🔶 使用GPU进行训练

【CVPR2019】“识面知心”——基于自监督学习的微表情特征表达

编者按:著名心理学家Paul Ekman和研究伙伴W.V.Friesen,通过对脸部肌肉动作与对应表情关系的研究,于1976年创制了“面部运动编码系统”,而利用微表情的“读心术”正是基于这一研究体系。由于该领域有限的数据集和高昂的标注成本,有监督学习的方法往往会导致模型过拟合。本文中,将为大家介绍中科院计算所VIPL组的CVPR2019新作:作者提出了一种基于视频流的自监督特征表达方法,通过利用

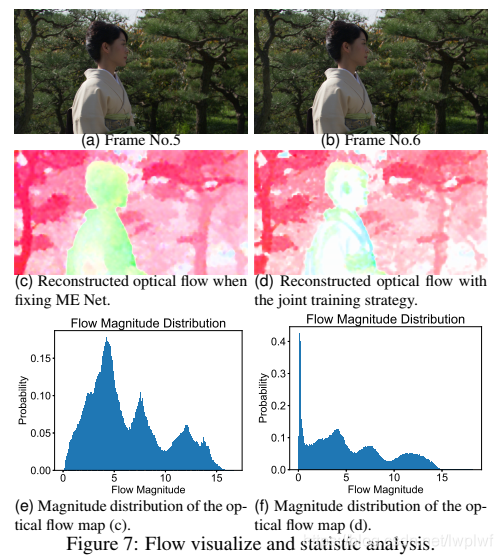

论文笔记24 -- (视频压缩)【CVPR2019】DVC: An End-to-end Deep Video Compression Framework

《DVC: An End-to-end Deep Video Compression Framework》 论文:点这里 原作代码:点这里 TensorFlow开源实现:OpenDVC Guo Lu, Wanli Ouyang, Dong Xu, Xiaoyun Zhang, Chunlei Cai, Zhiyong Gao CVPR 2019 (Oral) DVC是首个端到端的深度学

CVPR2019 无监督异常检测/定位数据集:MVTec AD

《MVTec AD:A Comprehensive Real-World Dataset for Unsupervised Anomaly Detection》 简介 MVTec AD是MVtec公司提出的一个用于异常检测的数据集,发布于2019CVPR。与之前的异常检测数据集不同,该数据集模仿了工业实际生产场景,并且主要用于unsupervised anomaly detection。

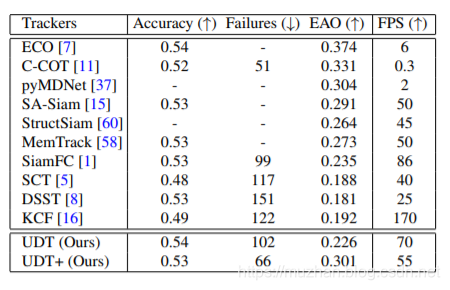

【CVPR2019】Unsupervised Deep Tracking无监督目标跟踪

UDT是中科大、腾讯AI lab和上交的研究者提出的无监督目标跟踪算法。仔细阅读过这篇文章之后,写下一篇paper reading加深印象。 论文标题:Unsupervised Deep Tracking 论文地址:https://arxiv.org/pdf/1904.01828.pdf Github(pytorch):https://github.com/594422814/UDT_pyt

【VQA文献阅读】(CVPR2019)Answer Them All! Toward Universal Visual Question Answering Models ——直观了解最新VQA数据集

【VQA文献阅读】(CVPR2019)Answer Them All! Toward Universal Visual Question Answering Models ——直观了解最新VQA数据集 前言:有些文献虽然不是综述,但其中多多少少都有介绍数据集的情况,对目前公开的VQA数据集有了详细的介绍,可以起到类似综述的效果,让读者能更好的对现有数据集有更加直观的认识,其功用类似综述,该文章

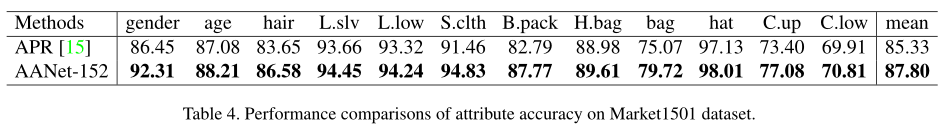

论文阅读(一)CVPR2019 AANet: Attribute Attention Network for Person Re-Identifications

文章地址:http://openaccess.thecvf.com/content_CVPR_2019/papers/Tay_AANet_Attribute_Attention_Network_for_Person_Re-Identifications_CVPR_2019_paper.pdf 源码:谁找到了评论一下呗。 摘要: 本论文提出了一个“属性注意力网络”,这个新颖的

![[MGK∗19] 《Neural rerendering in the wild》(CVPR2019)阅读笔记 (完)](https://img-blog.csdnimg.cn/a67f573728b8426ea9803603d8bd9a5e.png?x-oss-process=image/watermark,type_d3F5LXplbmhlaQ,shadow_50,text_Q1NETiBAbGVlMjgxMw==,size_20,color_FFFFFF,t_70,g_se,x_16#pic_center)