clm专题

【C++风云录】改变气候研究游戏规则:CLM、CESM、WRF、CDO、MPAS和NCL的全面指南

科技与气候:六大工具的洞察和应用 前言 在当前的科技环境中,模型和软件工具对于理解和预测天气,气候变化以及其他地球系统现象起着至关重要的作用。本文将详细介绍六种不同的工具:CLM, CESM, WRF, CDO, MPAS 和 NCL,并探讨它们在相关领域的应用。 欢迎订阅专栏: 文章目录 科技与气候:六大工具的洞察和应用前言1. CLM(Community Land Mod

人脸识别之人脸对齐(四)--CLM算法及概率图模型改进

原文: http://blog.csdn.net/marvin521/article/details/11489453 04、概率图模型应用实例 最近一篇文章《Deformable Model Fitting by Regularized Landmark Mean-Shift》中的人脸点检测算法在速度和精度折中上达到了一个相对不错的水平,这篇技术报告

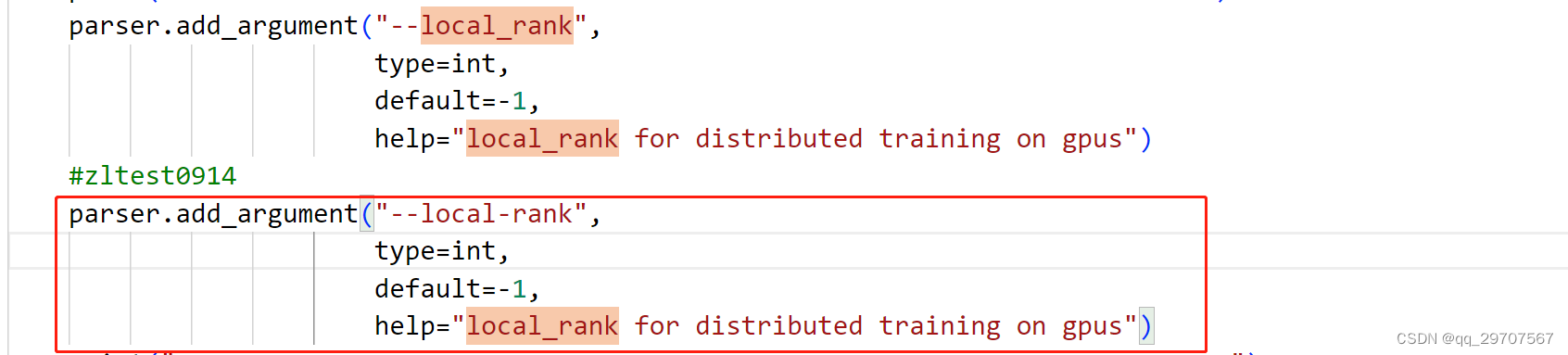

【deepspeed】 gpt模型训练报错run_clm_no_trainer.py: error: unrecognized arguments: --local-rank=0

测试场景:使用deepspeed框架训练gpt模型 问题: 报错torch.distributed.elastic.multiprocessing.errors.ChildFailedError 具体见截图: 解决办法: 含义:表明在运行 train.py 脚本时,传递了一个未被识别的参数 --local-rank=1 这里我在train.py脚本文件中果然没有找到–local

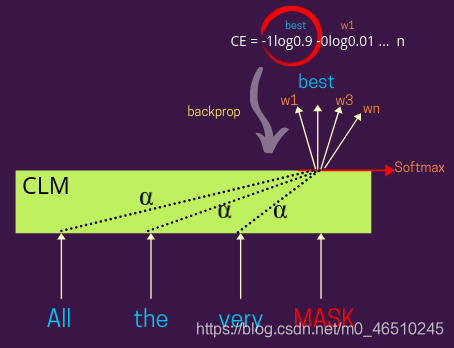

区别探索:掩码语言模型 (MLM) 和因果语言模型 (CLM)的区别

大多数现代 NLP 系统都遵循相当标准的方法来为各种用例训练新模型,即首先预训练,然后微调。这里, 预训练的目标是利用大量未标记的文本并构建语言理解的通用模型,然后针对各种特定的 NLP 任务(例如机器翻译、文本摘要等)进行微调。 在本博客中,我们将讨论两种流行的预训练方案,即掩码语言建模(MLM)和因果语言建模(CLM)。 没有时间阅读整个博客?然后观看这段 <60 秒的 短片 -

NLP中CLM是什么意思

大多数现代的NLP系统都遵循一种非常标准的方法来训练各种用例的新模型,即先训练后微调。在这里,预处理训练的目标是利用大量未标记的文本,在对各种特定的自然语言处理任务(如机器翻译、文本摘要等)进行微调之前,建立一个通用的语言理解模型。 在本文章中,我们将讨论两种流行的训练前方案,即掩蔽语言建模(MLM)和因果语言建模(CLM)。 屏蔽语言模型解释 在屏蔽语言建模中,我们通常屏蔽给定句子中