bn专题

小知识点快速总结:Batch Normalization Layer(BN层)的作用

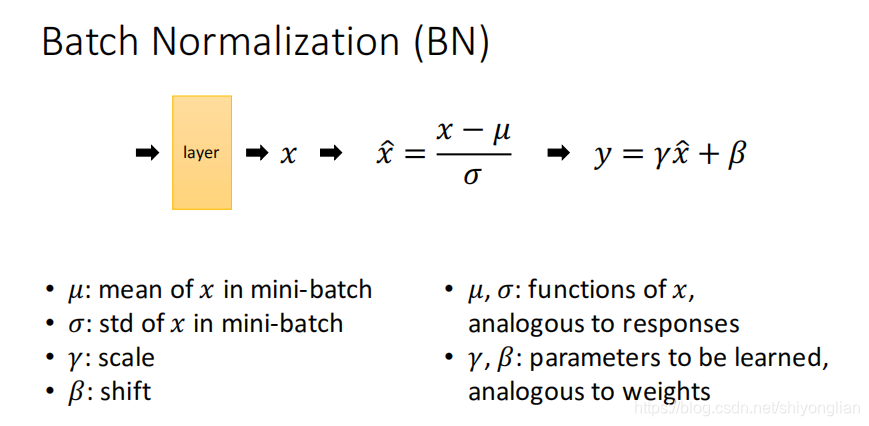

本系列文章只做简要总结,不详细说明原理和公式。 目录 1. 参考文章2. 主要作用3. 具体分析3.1 正则化,降低过拟合3.2 提高模型收敛速度,加速训练3.3 减少梯度爆炸或者梯度消失的情况 4. 补充4.1 BN层做的是标准化不是归一化4.2 BN层的公式4.3 BN层为什么要引入gamma和beta参数 1. 参考文章 [1] Sergey Ioffe, “Batch

【caffe转向pytorch】caffe的BN层+scale层=pytorch的BN层

caffe里面用BN层的时候通常后面接一下scale层,原因如下: caffe 中为什么bn层要和scale层一起使用 这个问题首先你要理解batchnormal是做什么的。它其实做了两件事。 输入归一化 x_norm = (x-u)/std, 其中u和std是个累计计算的均值和方差。 2)y=alpha×x_norm + beta,对归一化后的x进行比例缩放和位移。其中alpha和beta是

关于BN层在颜色恒常性任务中的思考

关于BN层在颜色恒常性任务中的思考 纵观已有的颜色恒常性算法,从15年AlexNet[1],到后来的FC4[2],其网络中都没有出现BN层,以及2020年的两篇CVPR(华为,港理工)也同样如此。看过其他领域的(尤其是目标检测、分类)网络,大多都会引入Batch Normalization,其作用也在ResNet论文中进行了总结,好处多多,不再赘述(面试被问透了的东西)。因此在思考,为什么颜色恒

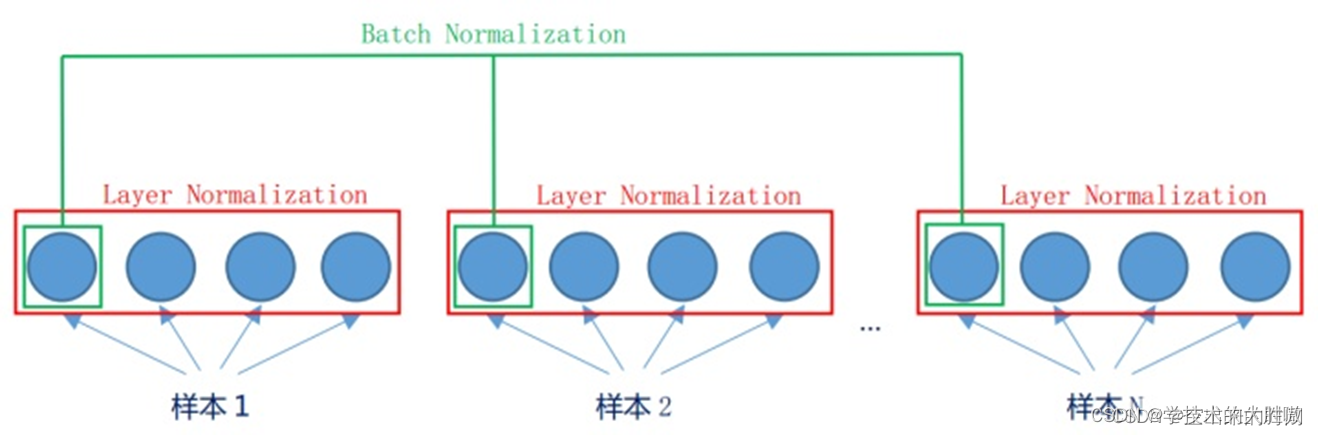

批量归一化(BN)和层归一化(LN)的区别

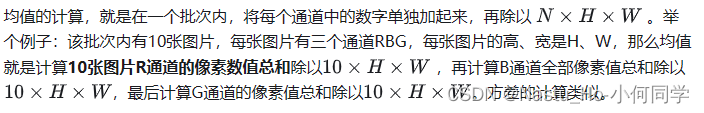

批量归一化(Batch Normalization, BN)和层归一化(Layer Normalization, LN)是深度学习中常用的两种归一化技术,它们主要用于解决训练过程中的内部协变量偏移问题,加速模型收敛和提高稳定性。 1. 为什么需要归一化 由于数据来源的不同,不同数据的特征分布是不一致的。模型在训练过程中学习了这个批次的特征分布,如果下一批次的特征分布截然不同,那么模型的参数就会

【model.backbone_2d.blocks.apply(set_bn_eval) 这个设置的作用会是什么了】

def set_bn_to_eval(model): def _set_bn_to_eval(m): if isinstance(m, nn.BatchNorm2d) or isinstance(m, nn.BatchNorm1d): # 或者其他BN层类型 m.eval() logger.info(f"{m} is set to eval") model.apply(_set_bn_

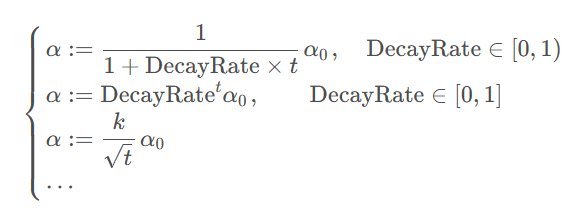

【深度学习】第二门课 改善深层神经网络 Week 2 3 优化算法、超参数调试和BN及其框架

🚀Write In Front🚀 📝个人主页:令夏二十三 🎁欢迎各位→点赞👍 + 收藏⭐️ + 留言📝 📣系列专栏:深度学习 💬总结:希望你看完之后,能对你有所帮助,不足请指正!共同学习交流 🖊 文章目录 目录 文章目录 2.1 优化算法分类 2.2 超参数调试和BN及框架 2.1 优化算法分类 深度学习中的优化算法主要包括以下几种: 批量梯度下降(B

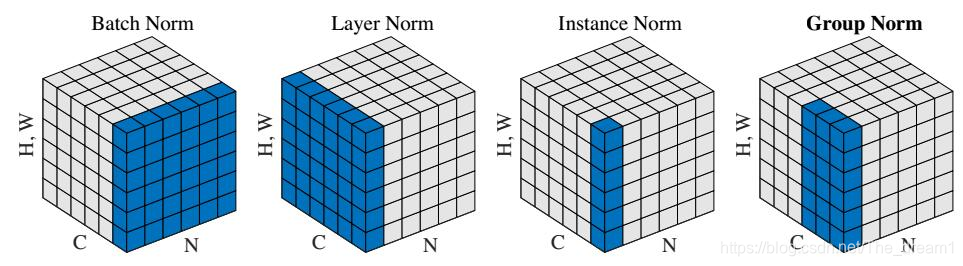

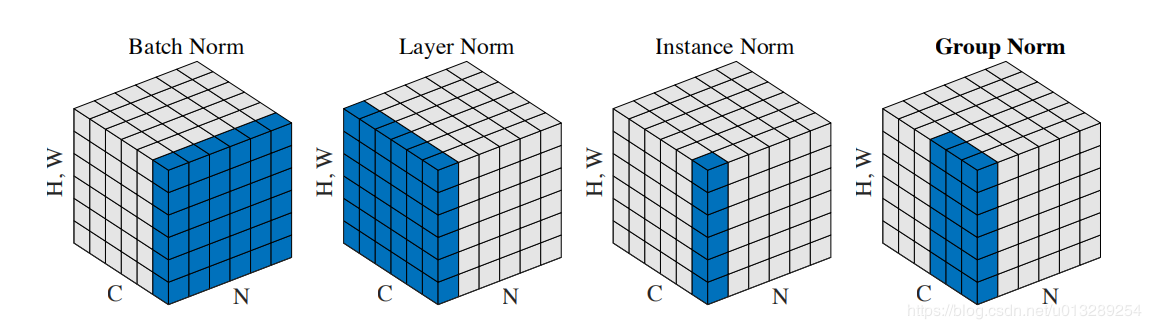

深度学习中的规范化(BN、LN等四种规范化)

这篇文章介绍深度学习四种主流的规范化, 分别是Batch Normalization(BN[9]), Layer Normalization(LN[7]), Instance Normalization(IN[8])以及Group Normalization(GN[2])。 1. 作用 为啥用Normalization? 这是因为训练深度神经网络会收敛很慢,很有可能发生梯度弥散或者梯度爆炸。用

一级市场STEPN(GMT)上线BN,GATE后40倍的增长逻辑

大家好,这里是一级市场的黑桃A社区,我们会不定期整理一级市场中优质的分享给大家,如果你感觉二级市场风险大,不妨尝试下一级市场。 STEPN是围绕大多数人的基本日常活动而构建的——四处走动。我们是第一个有效实现功能性移动和赚取概念的项目,在 Solana Ignition Hackathon 2021 上完成了 500 多个项目中的第 4 名。用户以 Sneakers 的形式为自己配备 NFT。通

Hadoop0.23.0初探3---HDFS NN,SNN,BN和HA

前言 保证HDFS高可用是Hadoop被推广以来很多技术人员一直关心的问题,通过搜索引擎搜索也可以得到很多的方案。恰逢HDFS Federation出炉,本文将一些涉及到有关NameNode、SecondaryNameNode、BackupNode的含义与区别,以及HDFS HA框架做一个总结。除此之外,文章的最后,将介绍Hadoop-0.23.0如何配置NameNode、SecondaryNam

[caffe]深度学习之图像分类模型Batch Normalization[BN-inception]解读

一、简介 如果将googlenet称之为google家的inception v1的话,其Batch Normalization(http://arxiv.org/pdf/1502.03167v3.pdf)文章讲的就是BN-inception v1。 它不是网络本身本质上的内容修改,而是为了将conv层的输出做normalization以使得下一层的更新能够更快,更准确。 二、网络

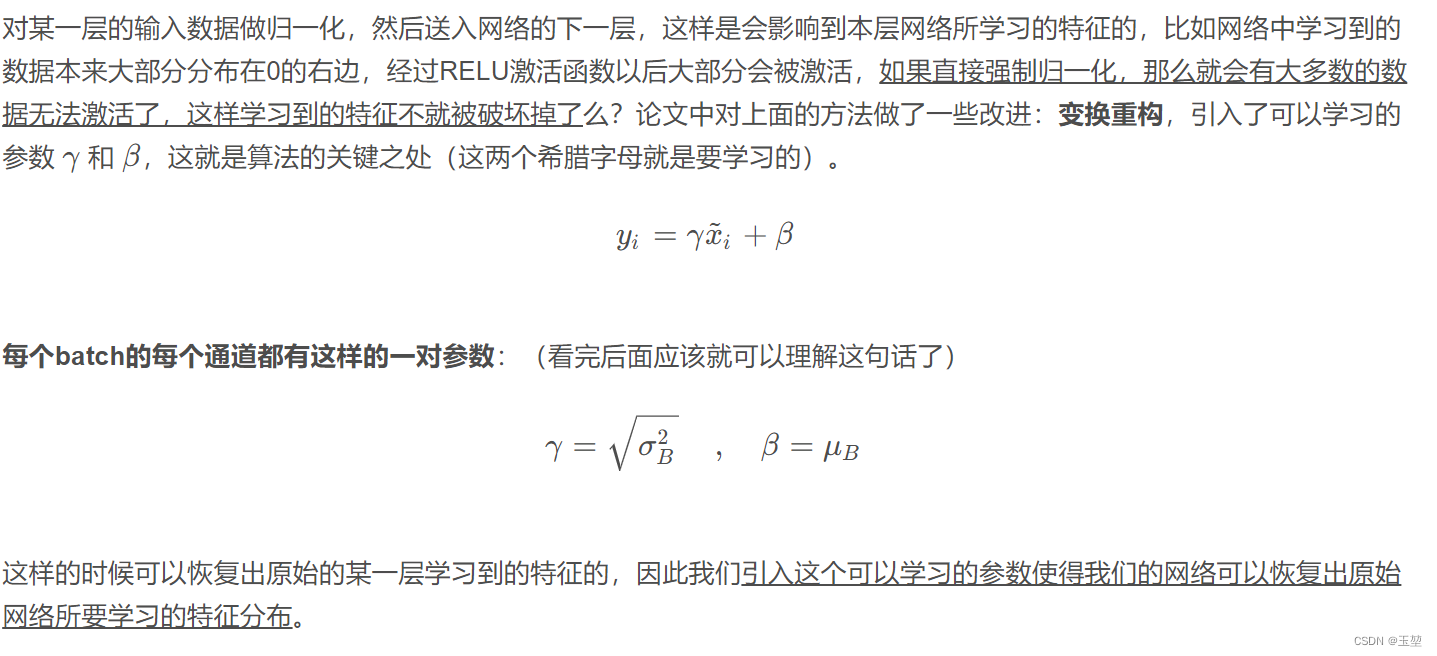

机器学习:BN层介绍及深入理解

前言:BN在深度网络训练过程中是非常好用的trick,在笔试中也很常考,而之前只是大概知道它的作用,很多细节并不清楚,因此希望用这篇文章彻底解决揭开BN的面纱。 BN层的由来与概念 讲解BN之前,我们需要了解BN是怎么被提出的。在机器学习领域,数据分布是很重要的概念。如果训练集和测试集的分布很不相同,那么在训练集上训练好的模型,在测试集上应该不奏效(比如用ImageNet训练的分类网络去在

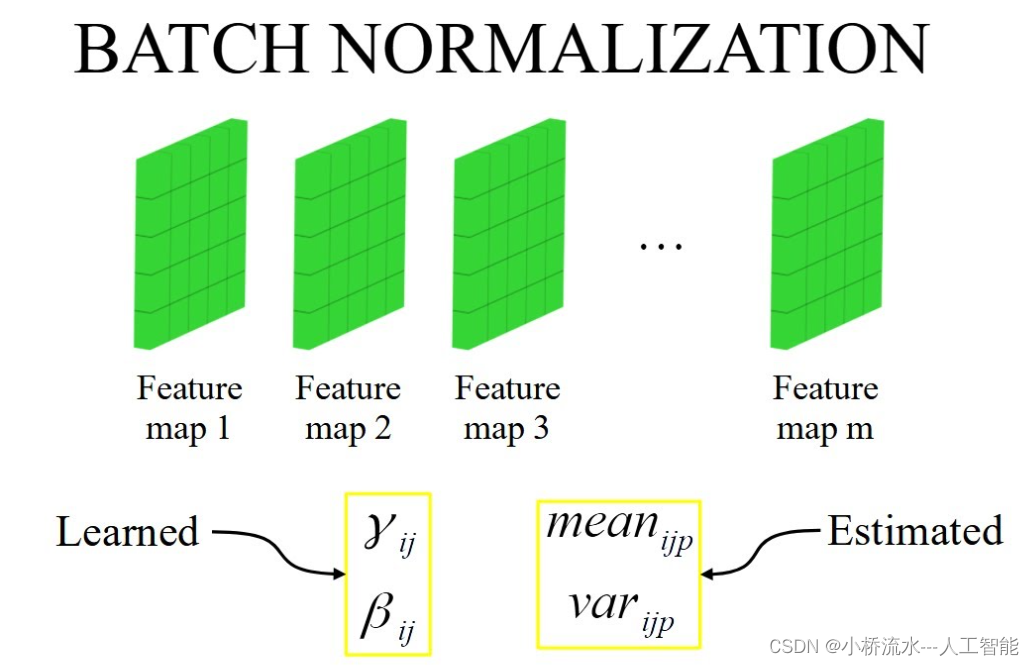

BatchNorm介绍:卷积神经网络中的BN

一、BN介绍 1.原理 在机器学习中让输入的数据之间相关性越少越好,最好输入的每个样本都是均值为0方差为1。在输入神经网络之前可以对数据进行处理让数据消除共线性,但是这样的话输入层的激活层看到的是一个分布良好的数据,但是较深的激活层看到的的分布就没那么完美了,分布将变化的很严重。这样会使得训练神经网络变得更加困难。所以添加BatchNorm层,在训练的时候BN层使用batch来估计数据的均值和

批归一化(Batch Normalization,简称BN)层的作用!!

批归一化(Batch Normalization,简称BN)层在卷积神经网络中的作用主要有以下几点: 规范化数据:批归一化可以对每一批数据进行归一化处理,使其均值接近0,方差接近1。这有助于解决内部协变量偏移(Internal Covariate Shift)问题,即网络训练过程中,由于每层的参数更新,导致后续层的输入分布发生变化。加速训练:通过规范化数据,批归一化可以使得网络更容易训练,因

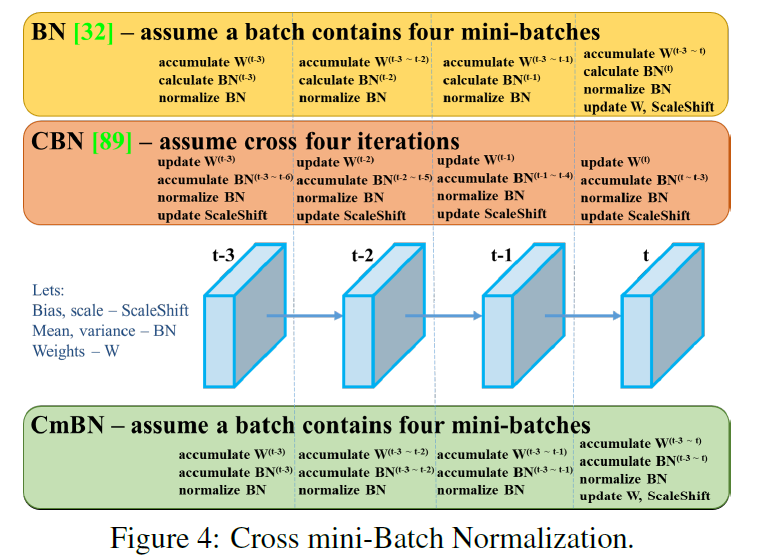

【YOLO系列】 YOLOv4之BN、CBN、CmBN(附代码)

一、BN 论文下载:Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift 1、背景 在神经网络训练过程中,输入的数据可能具有分布不平衡、相关性强等问题,同时随着前一层参数的变化,每一层输入的分布也会发生变化,这使得训练深度神经网络

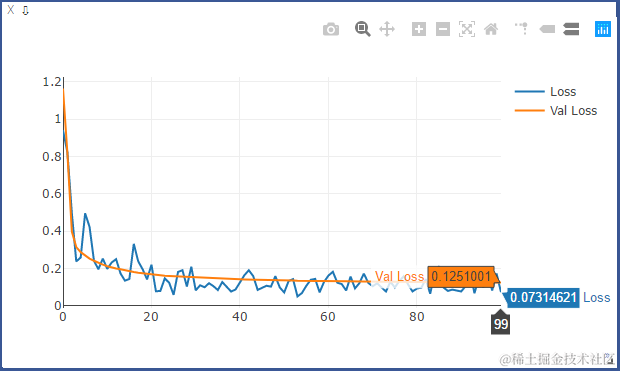

pytorch学习笔记 (visdom可视化、正则化、动量、学习率衰减、BN)

一、visdom可视化工具 安装: pip install visdom 启动: 命令行直接运行visdom 打开WEB: 在浏览器使用http://localhost:8097打开visdom界面 二、使用visdom # 导入Visdom类from visdom import Visdom# 定义一个env叫Mnist的board,如果不指定,则默认归于mainviz

CNN——NormLayer(BN、FRN)的学习笔记~

1 致谢 感谢网友wzy_zju提供的资料,链接如下: https://blog.csdn.net/wzy_zju/article/details/81262453 2 前言 今天在学习CNN~ 我之前一直对BN的作用还不是很明白,所以今天再来复习一下~ 首先我们来看看关于 norm layer 的经典示意图 3 BN:Batch Normalization 3.1 BN所解决的问题

cs 231 Batch Normalization 求导推导及代码复现(BN,LN)

cs 231 Batch Normalization 求导推导及代码复现: 作者论文公式:https://arxiv.org/abs/1502.03167 Batch Normalization 计算图: Batch Normalization 求导数学推导:

61、python - 手写卷积、bn、池化、全连接、激活、ResBlock

这篇算是一个总结,之前的原理部分在介绍各个算法时候,已经加入了每个算法的代码编写介绍。 给出的示例是用 python 语法来实现的,也是实现的最基础的版本,这也是我们手写算法的初衷:不调用其他的三方库,从最基础的手写算法开始,一步步完成算法实现和性能优化,这样可以更加深刻的理解算法。 当然这样第一步写出来的算法性能很差,但这不是重点,后续我们会在此基础上逐步优化性能优化。 下面整理一下之前手

50、实战 - 利用 conv + bn + relu + add 写一个残差结构

上一节介绍了残差结构,还不清楚的同学可以返回上一节继续阅读。 到了这里,一个残差结构需要的算法基本都介绍完了,至少在 Resnet 这种神经网络中的残差结构是这样的。 本节我们做一个实战,基于之前几节中手写的 conv / bn 算法,来搭建一个残差结构。其中,relu 的实现和 add 的实现很简单。 relu 算法的实现用 python 来写就一行: def ComputeReluLa

来聊聊批归一化BN(Batch Normalization)层

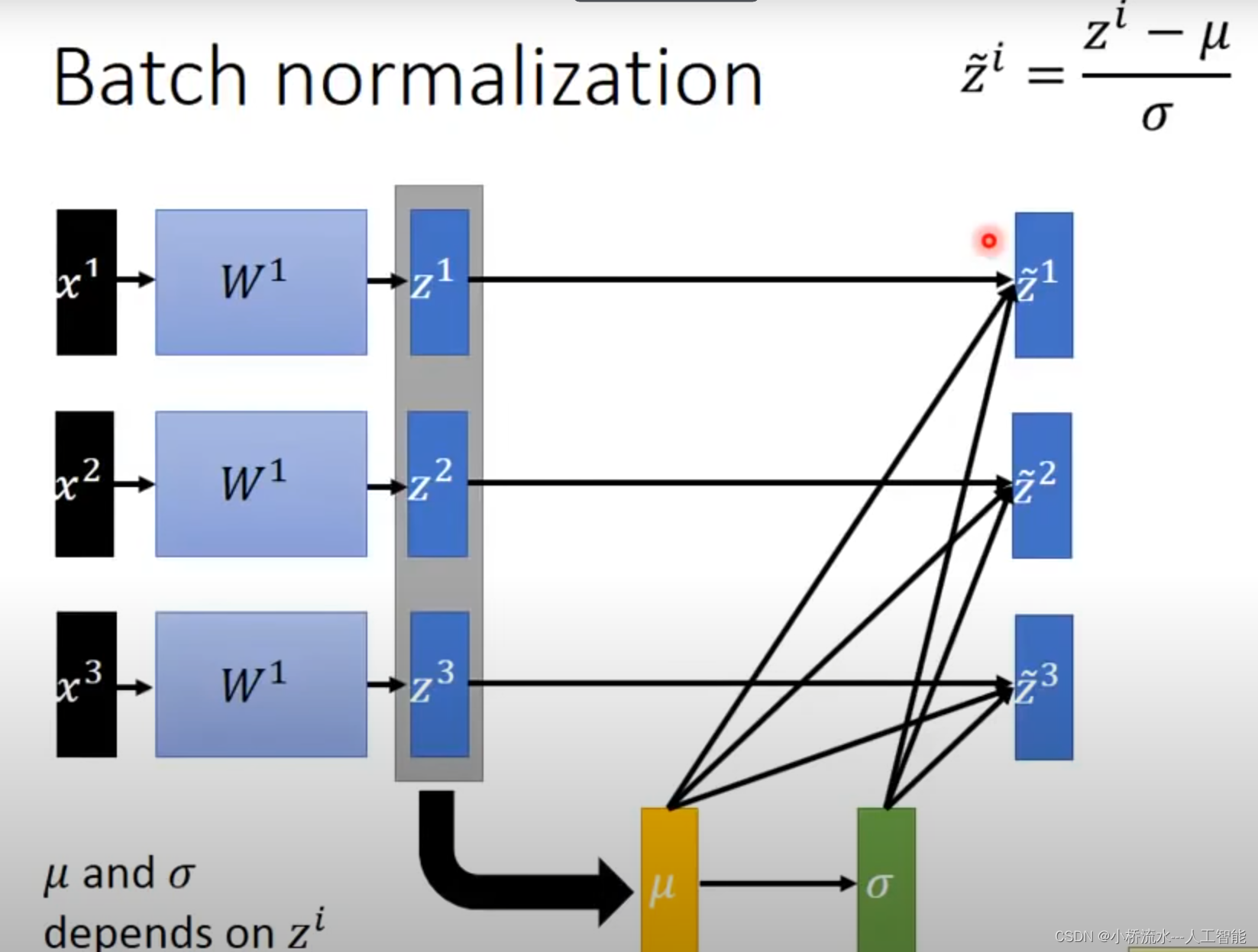

点击上方“AI算法修炼营”,选择加星标或“置顶” 标题以下,全是干货 一、Batch Normalization是什么? Batch Normalization (BN) 是最早出现的,也通常是效果最好的归一化方式。feature map: 包含 N 个样本,每个样本通道数为 C,高为 H,宽为 W。 对其求均值和方差时,将在 N、H、W上操作,而保留通道 C 的维度。具体来说,就是把第1个样

【手撕算法系列】BN

BN的计算公式 BN中均值与方差的计算 所以对于输入x: b,c,h,w则 mean: 1,c,1,1var: 1,c,1,1 代码 class BatchNorm(nn.Module):def __init__(self, num_features, num_dims):# num_features:完全连接层的输出数量或卷积层的输出通道数。# num_dims:2表示完全连

残差网络中的BN (Batch Normalization 批标准化层)的作用是什么?

文章目录 什么是BN (Batch Normalization 批标准化层)一、BN层对输入信号进行以下操作:二、BN 层有什么作用? 什么是BN (Batch Normalization 批标准化层) BN层的全称是Batch Normalization层,中文可以翻译为批标准化层。 BN层是2015年提出的一种新的层类型,它通过对每一层神经网络的输入信号进行标准化处

深度学习—BN的理解

0、问题 机器学习领域有个很重要的假设:IID独立同分布假设,就是假设训练数据和测试数据是满足相同分布的,这是通过训练数据获得的模型能够在测试集获得好的效果的一个基本保障。那BatchNorm的作用是什么呢?BatchNorm就是在深度神经网络训练过程中使得每一层神经网络的输入保持相同分布的。 思考一个问题:为什么传统的神经网络在训练开始之前,要对输入的数据做Normalization

BN的真正作用,How Does Batch Normalization Help Optimization?

与BN相关的两篇论文 Batch Normalization说BN的作用是因为解决了Internal Covariate Shift(ICS,内部输入分布变化)问题 MIT 的 NeurIPS18 How Does Batch Normalization Help Optimization?从数学推导以及实验方面证明了BN的真正作用 BN原论文的理解与分析 原始论文作者认为 BN 减小了所