bases专题

Large-Scale Relation Learning for Question Answering over Knowledge Bases with Pre-trained Langu论文笔记

文章目录 一. 简介1.知识库问答(KBQA)介绍2.知识库问答(KBQA)的主要挑战3.以往方案4.本文方法 二. 方法问题定义:BERT for KBQA关系学习(Relation Learning)的辅助任务 三. 实验1. 数据集2. Baselines3. Metrics4.Main Results 一. 简介 1.知识库问答(KBQA)介绍 知识库问答(KBQA

论文浅尝 | Leveraging Knowledge Bases in LSTMs

Yang, B., Mitchell, T., 2017. Leveraging Knowledge Bases in LSTMs for Improving Machine Reading. Association for Computational Linguistics, pp. 1436–1446. 链接:http://www.aclweb.org/anthology/P/P17

基于kbqa 的复旦大学论文解释 learning question answering over QA corpora and knowledge bases(二)

我们表示第i项其中,,所以,所以我们建立了QA与X的似然线性关系, (13) 最大似然估计QA就是等价最大似然估计X,(2)通过边际化联合概率,得到,基于总体的模板t和谓语p,似然如公式(14),我们阐述整个过程如图4,

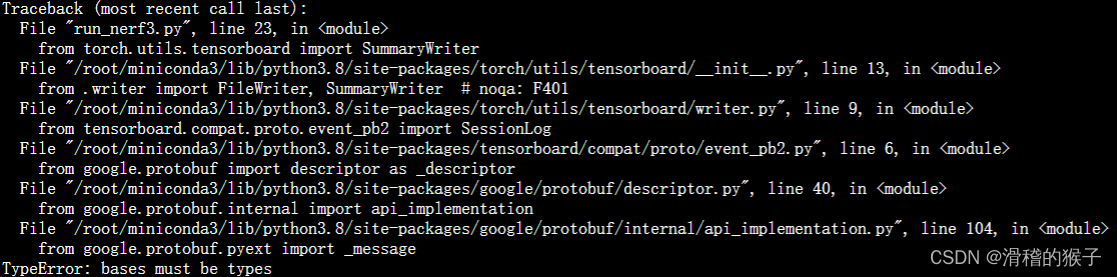

TypeError: bases must be types

错误:TypeError: bases must be types 原因:导入 torch.utils.tensorboard.SummaryWriter 时。因为 TensorBoard 或 protobuf 库版本与 PyTorch 版本不兼容。 解决: 确保使用的 PyTorch 版本与其他依赖库兼容。检查 PyTorch、TensorBoard 和 protobuf 的版本要求,并

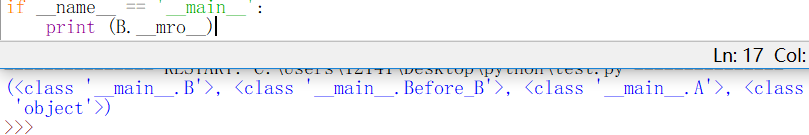

Python:python3中__bases__的使用(MRO)

注:尚未在pyhon2中测试 参考文档:https://fishc.com.cn/forum.php?mod=viewthread&tid=48888&extra=page%3D1%26filter%3Dtypeid%26typeid%3D403 · 错误示例 —————————————————————————————————— class A():def __init__(self):

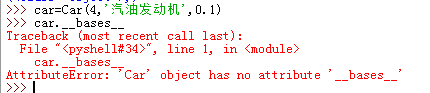

第8.9节 Python类中内置的查看直接父类的__bases__属性

终于介绍完了__init__方法和__new__方法,接下来轻松一下,本节介绍类中内置的__bases__属性。 一、 语法释义 Python 为所有类都提供了一个 bases 属性,通过该属性可以查看该类的所有直接父类,该属性返回所有直接父类组成的元组。注意是直接父类!!! 使用语法:类名.bases 二、 举例说明 举例:定义三个类Vehicle(车)、Automobile(汽车)、Car(小

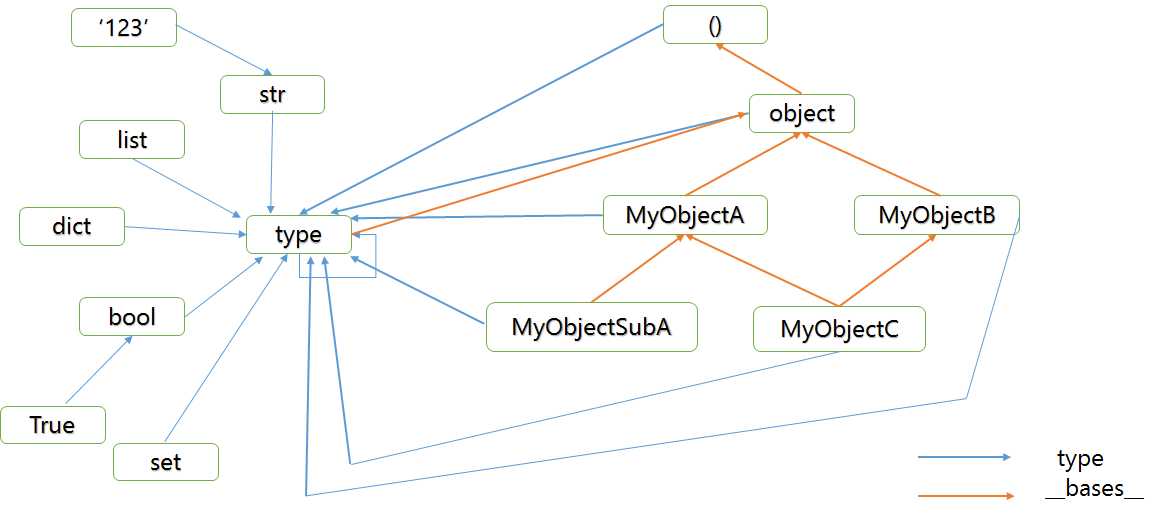

type在python是什么意思_Python type 与 __bases__

type 字面意思是类型,可以理解为模具,通过模具生成各种各样的实例。 Python中内置函数type()可以查看实例的具体类型。 什么样子的类型是type呢 ? 看看下面的例子。 >>> type(bool) >>> type(str)>>> type(int)>>> type(list)>>> type(dict)>>> type(set)>>> type(type) 可以发现,

MMdetection训练时报错KeyError: “Duplicate key is not allowed among bases.

MMdetection在训练时报错如下: 这是由于配置文件中继承文件出现重复导致,比如: 其实第一个继承文件里面已经包含了后面三个文件,所以删除后面3个即可

Leveraging Knowledge Bases in LSTMs for Improving Machine Reading

《Leveraging Knowledge Bases in LSTMs for Improving Machine Reading》 这篇文章是发表在2017年ACL上的,主要是聚焦于外部知识改善LSTM,运用在实体抽取和事件抽取任务。在ACE2005的数据集上得到了SOTA效果。 首先介绍这篇文章的两个知识库,一个是WordNet一个是NELL。 Word net是人工创造的一个词典,里

【自然语言处理】【Prompt】语言模型即知识库(Language Models as Knowledge Bases)

语言模型即知识库 Language Models as Knowledge Bases 相关博客 【自然语言处理】【可解释性】NKB:用于预训练Transformers的神经知识银行 【自然语言处理】【可解释性】自注意力归因:解释Transformer内部的信息交互 【深度学习】【积分梯度】深度网络的公理归因(Axiomatic Attribution for Deep Netw

pip 升级报错AttributeError: module ‘types‘ has no attribute ‘resolve_bases‘

尝试以下方式进行升级: 1、python -m pip install -U --force-reinstall pip 2、python -m pip install -U pip 3、easy_install -U pip 最后一句终于升级成功了,yyds

TypeError: Cannot create a consistent method resolution order (MRO) for bases WampTest, MusicTest

报错位置 MusicTest类继承VoiceTest类 VoiceTest继承WampTest 报错:TypeError: Cannot create a consistent method resolution order (MRO) for bases WampTest, MusicTest 在网上搜了一下,了解到python当中 新式类多重继承原则:广度优先,从左到右 当需要在继

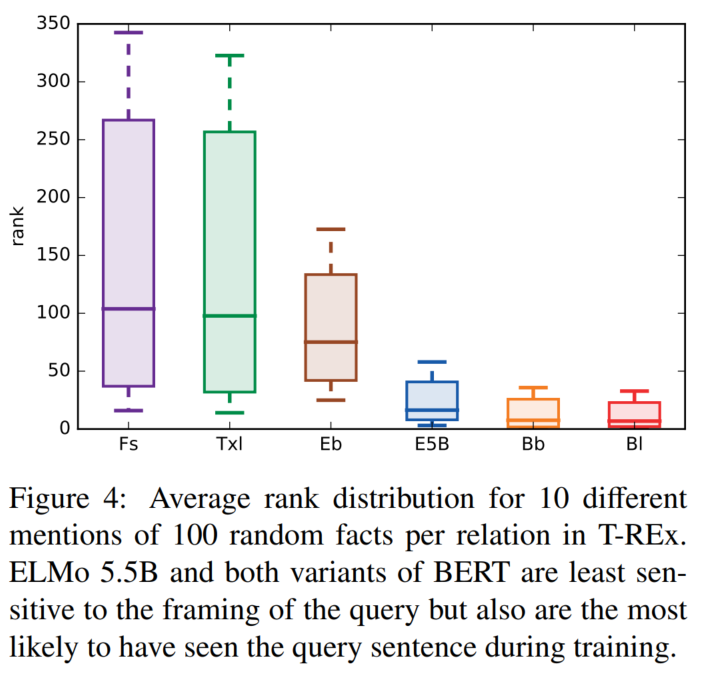

Re51:读论文 Language Models as Knowledge Bases?

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类 论文名称:Language Models as Knowledge Bases? ArXiv网址:https://arxiv.org/abs/1909.01066 官方GitHub项目:https://github.com/facebookresearch/LAMA 本文是2019年EMNLP论文,作者来自脸书和伦敦大学

PlonK Permutations over Lagrange-bases for Oecumenical Noninteractive arguments of Knowledge学习笔记-1

PLONK 课程笔记 最近在看plonk,直接看论文有些吃力,在哔哩哔哩上观看课程讲解,很细致https://www.bilibili.com/video/BV1XZ4y1A7bU?share_source=copy_web 1. plonk的基本原理 1.将数学运算化为多项式,之后再化为电路。 2.多项式承诺(手上的一堆多项式,满足一定的关系:证明方发送给验证者,承诺发出后,多项式不可