avro专题

RPC框架-Avro

引言 远程过程调用(RPC, Remote Procedure Call)是一种允许程序调用远程服务器上函数或方法的技术,应用广泛于分布式系统中。在RPC的众多实现中,Apache Avro作为一种数据序列化框架,以其紧凑、高效、跨语言等特性而受到广泛关注。Avro不仅支持数据序列化,还提供了一个简洁的RPC框架,特别适合与Hadoop生态系统集成。 本文将详细探讨Apache Avro框架的

Avro Schema格式

Avro Schema格式 Avro是一个数据序列化系统,主要用于支持大批量数据交换的应用。 特点: 支持二进制序列化方式,可以便捷、快速的处理大量数据;动态语言有好,Avro提供的机制使动态语言可以方便的处理Avro数据 1.Avro Schema结构 {"type":"record","name":"aaa","namespace":"bbb","fields":[{"name":"

大数据之数据交换和存储序列化利器 Avro

Avro(读音类似于[ævrə])是Hadoop的一个子项目,由Hadoop的创始人Doug Cutting(也是Lucene,Nutch等项目的创始人)牵头开发。Avro是一个基于二进制数据传输高性能的中间件。在Hadoop的其他项目中例如HBase(Ref)和Hive(Ref)的Client端与服务端的数据传输也采用了这个工具。Avro是一个数据序列化的系统。Avro可以将数据结构或对象转化

数据序列化机制-Avro

序列化主要是将内存缓冲区、数据结构或者对象中的数据转换为能够在网路上传输或者持久化存储(比如磁盘)中存储的二进制文件。 1.Avro的特性? 1)与语言无关 2)基于模式:Avro会序列化数据时会将模式写入其中,Avro序列化数据到一个压缩的二进制格式 3)使用类Json的格式来描述数据的结构,并且支持多种语言,像Java, C, C++, C#, Python, and Ruby。 4

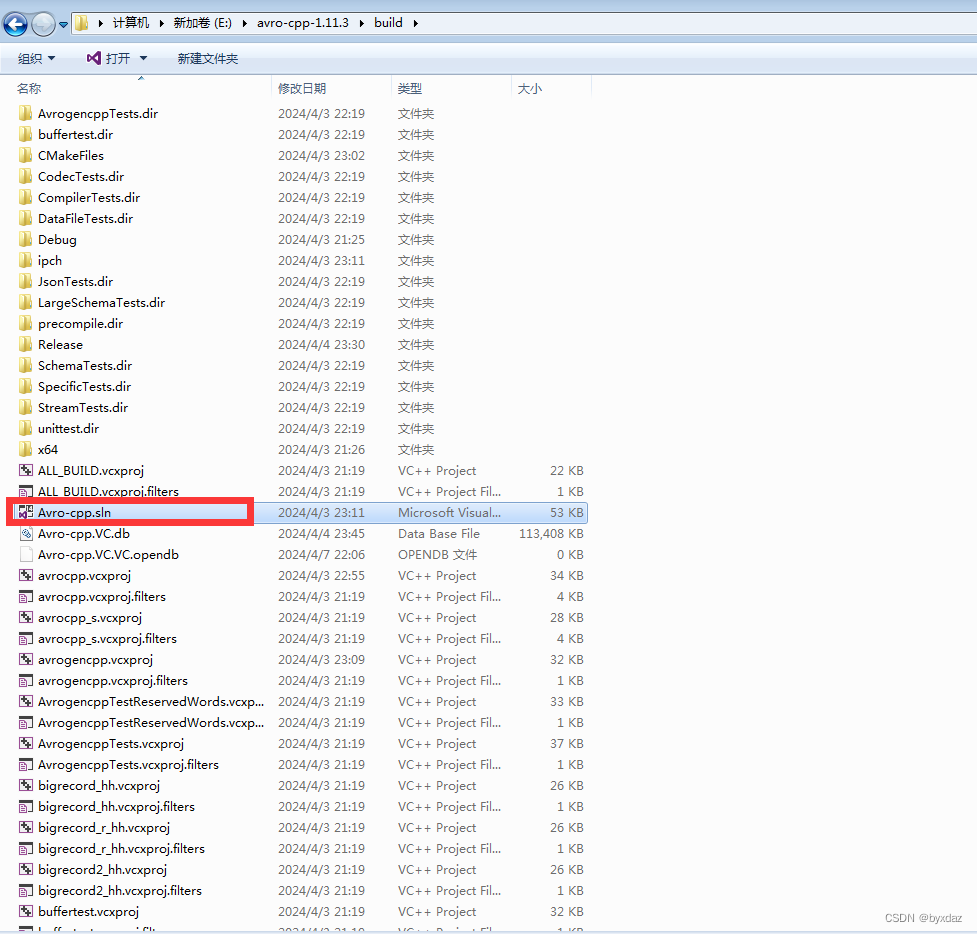

avro c++编译与使用

一、arvo介绍 Avro 是 Hadoop 中的一个子项目,也是一个数据序列化系统,其数据最终以二进制格式,采用行式存储的方式进行存储。 Avro提供了: 1)、丰富的数据结构。 2)、可压缩、快速的二进制数据格式。 3)、一个用来存储持久化数据的容器文件。 4)、远程过程调用。 5)、与动态语言的简单集成,代码生成不需要读取或写入数据文件,也不需要使用或实现 RPC 协议。代码生成是一种可选

待续 总结 - parquet 与 avro

paruet列存文件结构 可以跳过不符合条件的数据,只读取需要的数据,降低IO数据量 压缩编码可以降低磁盘存储空间 只读取需要的列,支持向量运算,能够获取更好的扫描性能 Schema :Parquet文件尾部存储了文件的元数据信息和统计信息,自描述的,方便解析 Parquet列式存储带来

kettle从入门到精通 第五十二课 ETL之kettle Avro output

1、上一节课我们学习了avro input,本节课我们一起学习下avro out步骤。 本节课通过json input 加载json文件,通过avro out 生成avro二进制文件,写日志步骤打印日志。将json input、avro output、写日志三个步骤拖到画布,然后连线,如下图所示: json input 步骤不在过多讲解,不了解的可以学习kettle从入门到精通 第八课 ket

flume之avro实践

flume接收端配置: a1.channels = c1a1.sources = r1a1.sinks = k1a1.channels.c1.type = memorya1.sources.r1.channels = c1a1.sources.r1.type = avroa1.sources.r1.bind = 0.0.0.0a1.sources.r1.port = 41414

【Java万花筒】选择最适合您的数据序列化格式:比较 Avro、Protocol Buffers、JSON、XML、MessagePack和BSON

选择最佳数据序列化格式:找到适合您的解决方案 前言 在当今数据驱动的世界中,高效地处理和传输数据变得至关重要。选择合适的数据序列化格式对于数据存储、通信和处理的性能至关重要。本文将介绍并比较几种常用的数据序列化格式,包括Apache Avro、Protocol Buffers、JSON、XML、MessagePack和BSON。通过了解它们的概述、特点、应用场景和示例代码,您将能够更好地选择适

CData Drivers for Avro v22

CData Drivers for Avro v22 从报告工具或数据库加入ApacheAvro。您还可以根据标准通过驱动程序连接到自定义应用程序。 与BI分析、报告、ETL工具和定制解决方案集成。 用于Avro的CData驱动程序功能强大: BI和分析 我们的驱动程序提供了将实时Avro数据连接到分析、BI、报告和数据可视化技术的最有效和最快速的方式。它们提供无与伦

Flink 集成 Debezium Confluent Avro ( format=debezium-avro-confluent )

博主历时三年精心创作的《大数据平台架构与原型实现:数据中台建设实战》一书现已由知名IT图书品牌电子工业出版社博文视点出版发行,点击《重磅推荐:建大数据平台太难了!给我发个工程原型吧!》了解图书详情,京东购书链接:https://item.jd.com/12677623.html,扫描左侧二维码进入京东手机购书页面。 本文介绍的场景是:使用 Kafka Connect 的 Debezium My

制作 MSK Connect 的 Confluent Avro Converter + Debezium MySQL Connector 插件包

MSK Connect 的插件包需要将各种插件的 Jar 包及其依赖包放到一起,打成 Zip 包,上传到 S3,然后在MSK Console 上创建插件时指定好 Zip 位置即可。为了便于维护,我们不建议将各种插件的 Jar 包混在一起放入同一个文件内,最好还是按插件原来的名称单独创建文件夹,单独放置各自的 Jar 包。我们以 Debezium MySQL Connector 和 Confluen

查看 Avro 格式的 Kafka 消息(启用了 Confluent Schema Registry )

使用 Avro 格式传递 Kafka 消息要比 Json 更加高效,因为它是二进制格式,在启用了 Confluent Schema Registry 的情况下,会进一步地提升传输效率,因为 Avro 中的 Schema 信息将不再出现在消息中,消息体积会进一步压缩,同时,还可以利用到 Schema Registry 的其他好处,例如 Schema Evolution 管理。 但是,由于 Avro

浅析avro序列化和反序列化源码及提供两种数据序列存储思路

以hadoop的avro实现原理做引子: varo的测试样例程序 #include <complex>#include "avro/Encoder.hh"#include "avro/Decoder.hh"#include "avro/Specific.hh"namespace avro {template<typename T>struct codec_traits<std::com

Kafka Avro序列化之三:使用Schema Register实现

为什么需要Schema Register 注册表 无论是使用传统的Avro API自定义序列化类和反序列化类 还是 使用Twitter的Bijection类库实现Avro的序列化与反序列化,这两种方法都有一个缺点:在每条Kafka记录里都嵌入了schema,这会让记录的大小成倍地增加。但是不管怎样,在读取记录时仍然需要用到整个 schema,所以要先找到 schema。有没有什么方法可以让数据

Kafka Avro序列化之二:使用Twitter的Bijection 类库实现

Kafka Avro序列化之一:使用自定义序列化 比较麻烦,需要根据 schema 生成实体类,需要调用 avro 的 API 实现 对象到 byte[]的序列化 和 byte[] 到对象的反序列化转化,而那些方法看上去比较繁琐,幸运的是,Twitter 开源的类库 Bijection 对传统的 Avro API 进行了封装了和优化,让我们可以方便的实现以上操作。 添加Maven依赖 添加ji

【大数据】详解 AVRO 格式

详解 AVRO 格式 1.Avro 介绍2.schema2.1 原始类型2.2 复杂类型2.2.1 Records2.2.2 Enums2.2.3 Arrays2.2.4 Maps2.2.5 Unions2.2.6 Fixed 3.Avro 的文件存储格式3.1 数据编码3.1.1 原始类型3.1.2 复杂类型 3.2 存储格式3.3 存储格式 4.小结 1.Avro 介绍

hadoop rpc机制 将avro引入hadoop rpc机制初探

转载:http://www.tbdata.org/archives/1413 1 RPC RPC(Remote Procedure Call)——远程过程调用,它是一种通过网络从远程计算机程序上请求服务,而不需要了解底层网络技术的协议。 2 hadoop.ipc 2.1 Server RPC Server实现了一种抽象的RPC服务,同时提供Call队列。 Ø RPC Server结

Apache Avro是什么?

写在前面 本文隶属于专栏《100个问题搞定大数据理论体系》,该专栏为笔者原创,引用请注明来源,不足和错误之处请在评论区帮忙指出,谢谢! 本专栏目录结构和文献引用请见100个问题搞定大数据理论体系 解答 Apache Avro(以下简称Avro)是一种与编程语言无关的序列化格式。 Avro是Hadoop生态系统中的序列化及RPC框架,设计之初的意图是为 Hadoop提供一个高效、灵活

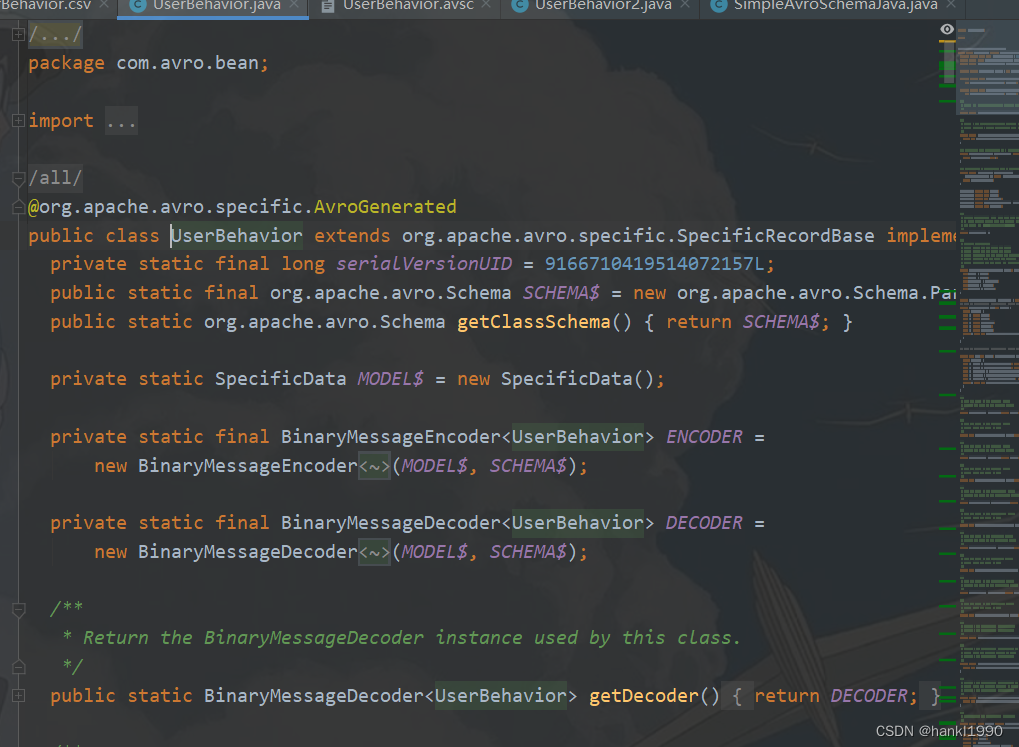

Avro 如何生成java Bean

作为一种很犀利的序列化的格式,avro在大数据量传输的时候很有优势。记录下。 1: .avsc 文件 {"namespace": "com.avro.bean","type": "record","name": "UserBehavior3","fields": [{"name": "userId", "type": "long"},{"name": "itemId", "type": "l

使用Apache Avro

Avro[1]是最近加入到Apache的Hadoop家族的项目之一。为支持数据密集型应用,它定义了一种数据格式并在多种编程语言中支持这种格式。 Avro提供的功能类似于其他编组系统,如Thrift、Protocol Buffers等。而Avro的主要不同之处在于[2]: “动态类型:Avro无需生成代码。数据总是伴以模式定义,这样就可以在不生成代码、静态数据类型的情况下对数据进行所有处理

Kafka Schema Registry | 学习Avro Schema

1.目标 在这个Kafka Schema Registry教程中,我们将了解Schema Registry是什么以及为什么我们应该将它与Apache Kafka一起使用。此外,我们将看到Avro架构演变的概念,并使用Kafka Avro Serializers设置和使用Schema Registry。此外,我们将学习使用Schema Registry的REST接口管理Avro Schemas。