本文主要是介绍GPT4o速测:约0.5秒延迟的多模态能力,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 1. 测评

- 2. Intro

- Reference

没有剪辑,约0.5秒延迟的多模态能力。

1. 测评

- 推理速度异常快,比之前快了大概两三倍,对产品端来说是个很好的事情,想用gpt4级别性能终于可以少讨论几句时延影响用户体验了

- 模型指令遵从能力变强,能够在较长的文本中保持指令的一致性,概括小说的效果变好了

- 模型懒惰的问题有很大改善,现在的模型愿意输出比较长的内容

- 措辞更加人格化,跟grok接近

- 好多功能还没有推送,目前只有模型权重是新的,实时多模态输入输出都没有打开,等下个版本测评了

2. Intro

GPT-4o,o 代表 Omnimodel(全能模型)。

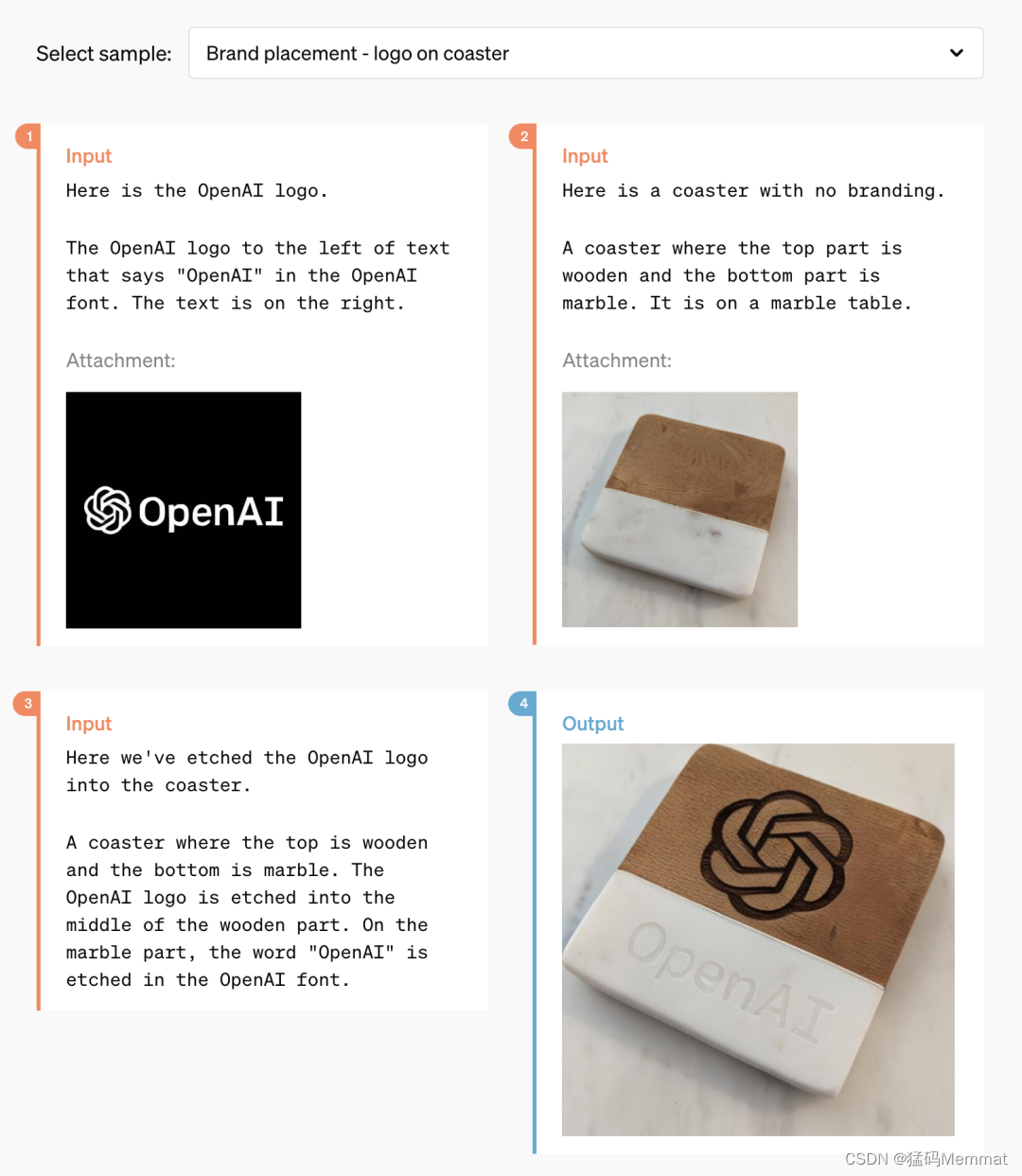

第一次,OpenAI 在一个模型中集成了所有模态,大幅提升了大模型的实用性。

第一,以后 OpenAI 做产品就是要免费优先,为的就是让更多的人能使用。

第二,因此 OpenAI 此次发布了桌面版本的程序和更新后的 UI,其使用起来更简单,也更自然。

第三,GPT-4 之后,新版本的大模型来了,名字叫 GPT-4o。GPT-4o 的特别之处在于它以极为自然的交互方式为每个人带来了 GPT-4 级别的智能,包括免费用户。

它最快可以在 232 毫秒的时间内响应音频输入,平均响应时长 320 毫秒,与人类相似。在 GPT-4o 发布之前,体验过 ChatGPT 语音对话能力的用户能够感知到 ChatGPT 的平均延迟为 2.8 秒 (GPT-3.5) 和 5.4 秒 (GPT-4)。

OpenAI 已经找到了一种方法,可以将音频直接映射到音频作为一级模态,并将视频实时传输到 transformer。这些需要对 token 化和架构进行一些新的研究,但总体来说是一个数据和系统优化问题(大多数事情都是如此)。 —— 英伟达科学家 Jim Fan 评论。

Reference

https://openai.com/index/hello-gpt-4o/

https://openai.com/index/gpt-4o-and-more-tools-to-chatgpt-free/

https://blog.samaltman.com/gpt-4o

https://www.businessinsider.com/openai-sam-altman-universal-basic-income-idea-compute-gpt-7-2024-5

https://mp.weixin.qq.com/s/PfWnlhXh3n3VDfZaMI-ifQ

这篇关于GPT4o速测:约0.5秒延迟的多模态能力的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!