本文主要是介绍LightGBM超参数优化-贝叶斯,网格,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

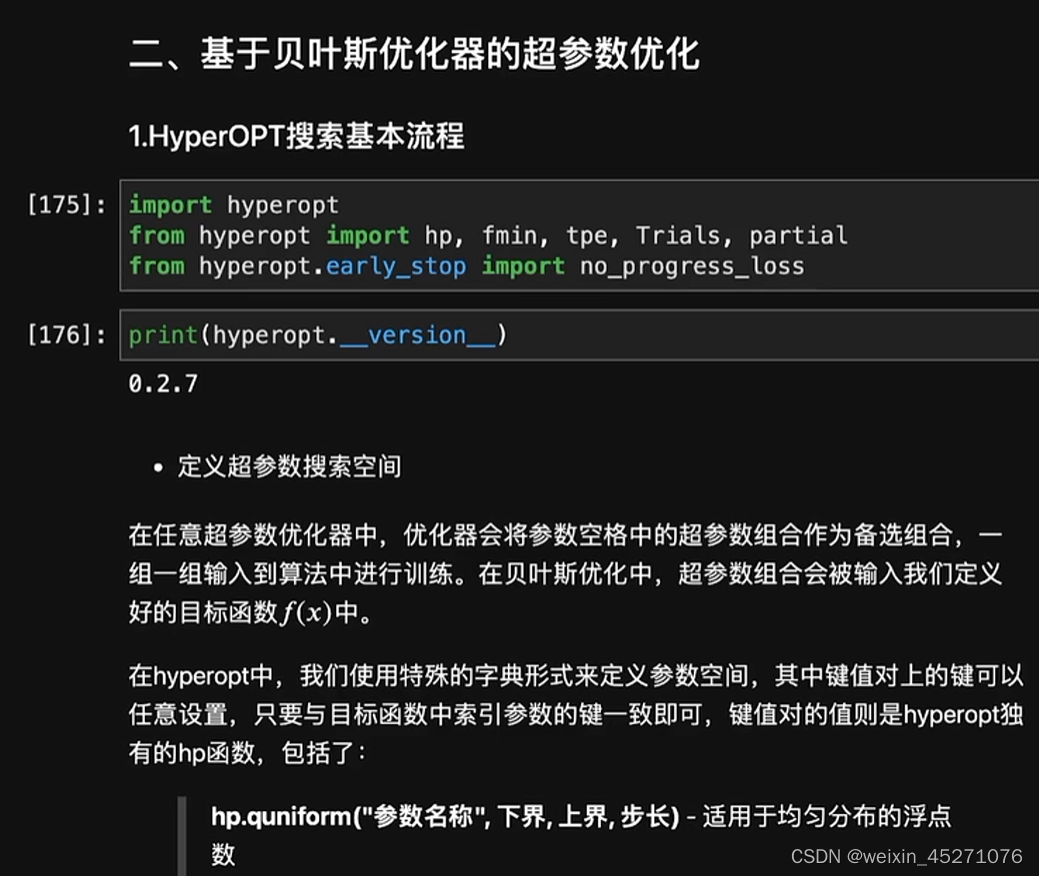

import hyperopt

from hyperopt import hp,fmin,tpe,Trials,partial

from hyperopt.early_stop import no_progress_loss

#参数的搜索空间

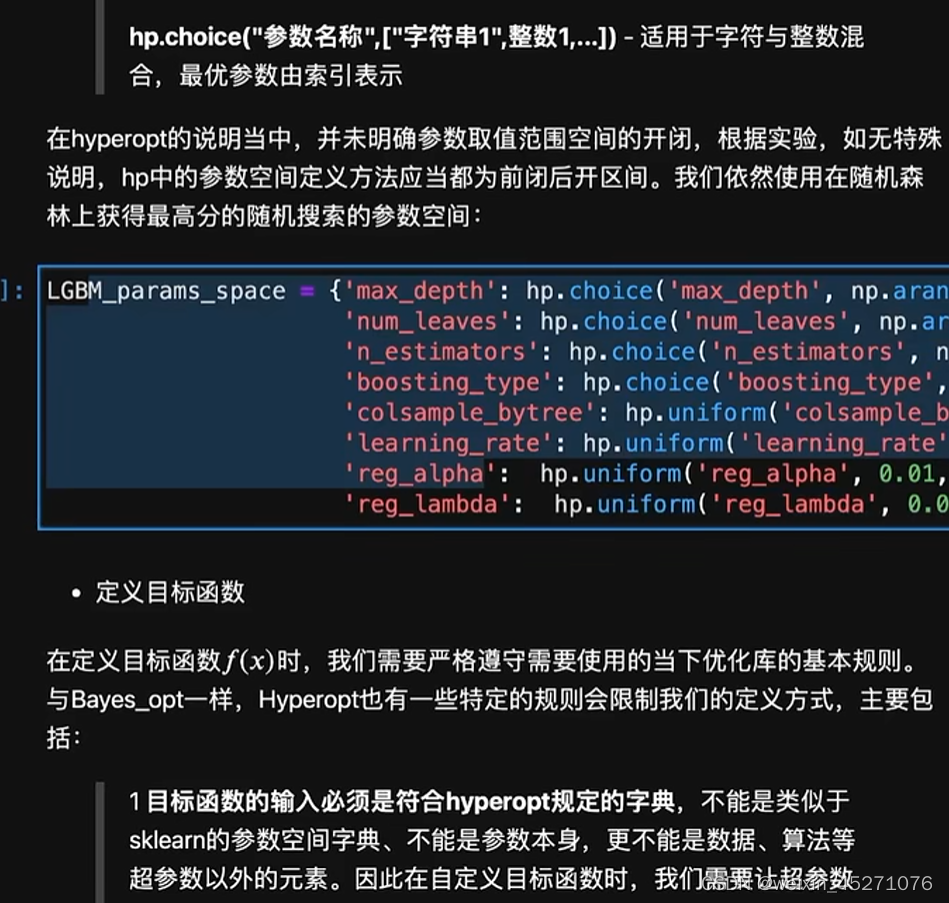

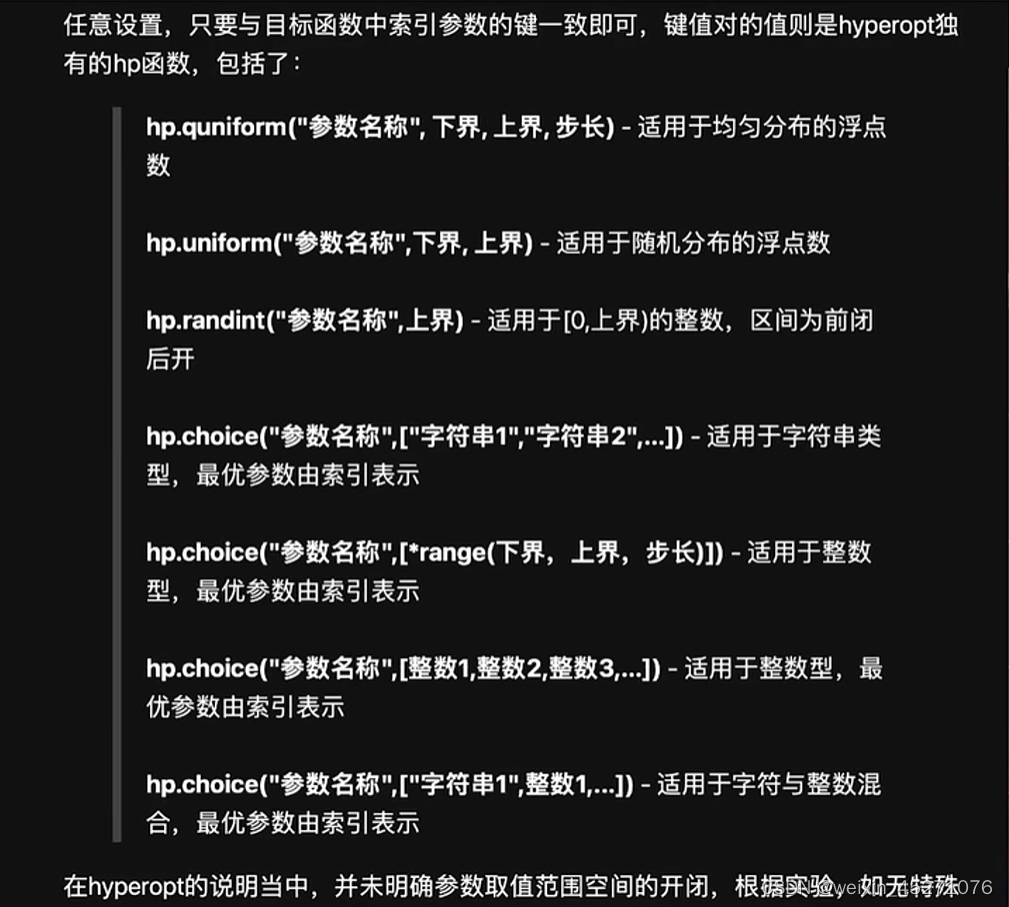

LGBM_params_space={'max_depth':hp.choice('max_depth',np.arange(10,50).tolist()),

'num_leaves':hp.choice('num_leaves',np.arange(10,50).tolist()),

'n_estimators':hp.choice('n_estimators',np.arange(10,100).tolist()),

'boosting_type':hp.choice('boosting_type',['gbdt','goss']),

'colsample_bytree':hp.uniform('colsample_bytree',0.2,1.0),#连续性的参数

'learning_rate':hp.uniform('learning_rate',0.001,0.5),

'reg_alpha':hp.uniform('reg_alpha',0.01,0.5),#L1

'reg_lambda':hp.uniform('reg_lambda',0.01,0.5)#l2

}

choice里的参数是独立的,如果用了randint模型会推测参数之间的大小,不太好对调参

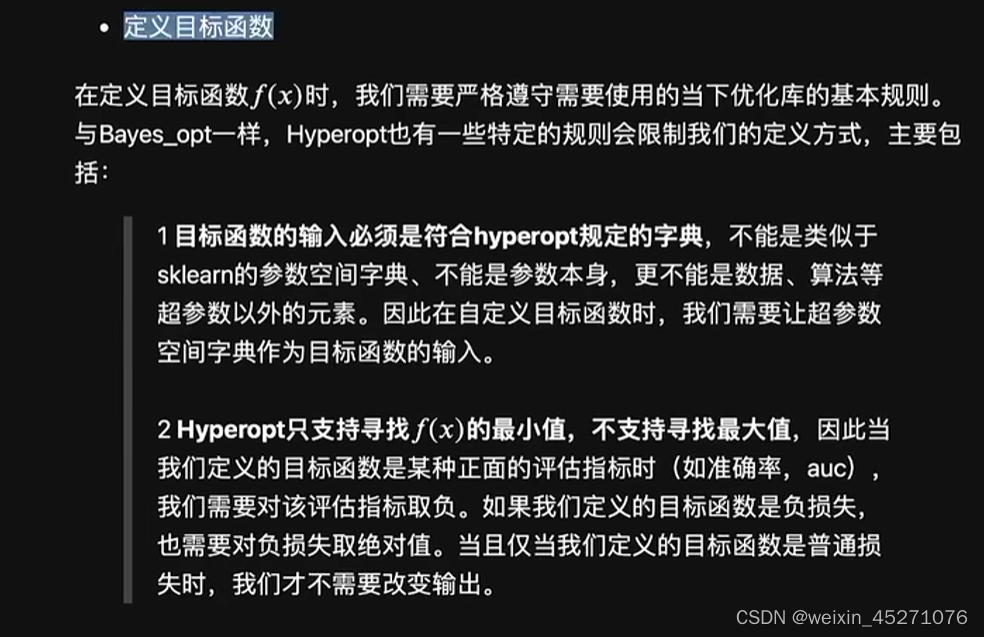

def hyperopt_lgbm(params):max_depth=params['max_depth']num_leaves=params['num_leaves']n_estimators=params['n_estimators']boosting_type=params['boosting_type']colsample_bytree=params['colsample_bytree']learning_rate=params['learning_rate']reg_alpha=params['reg_alpha']reg_lambda=params['reg_lambda']#会根据搜索出的子参数空间,赋值,并进行下列实例化#实例化模型lgbm=LGBMClassifier(random_state=12,max_depth=max_depth,num_leaves=num_leaves,n_estimators=n_estimators,boosting_type=boosting_type,colsample_bytree=colsample_bytree,learning_rate=learning_rate,reg_alpha=reg_alpha,reg_lambda=reg_lambda )#输出交叉验证的结果res=cross_val_score(lgbm,xtrain263,ytrain263).mean()return res#定义优化函数

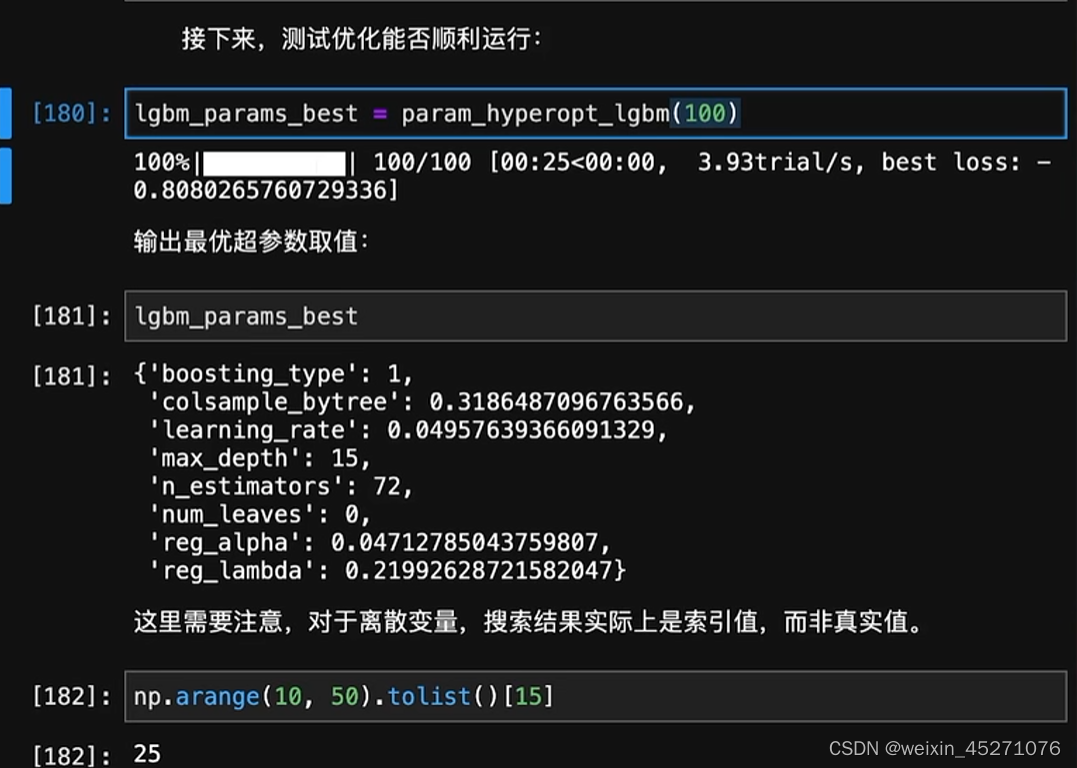

def param_hyperopt_lgbm(max_evals):params_best=fmin(fn=hyperopt_lgbm,#目标函数space=LGBM_params_space,algo=tpe.suggest,#算法max_evals=max_evals)#迭代次数return params_best

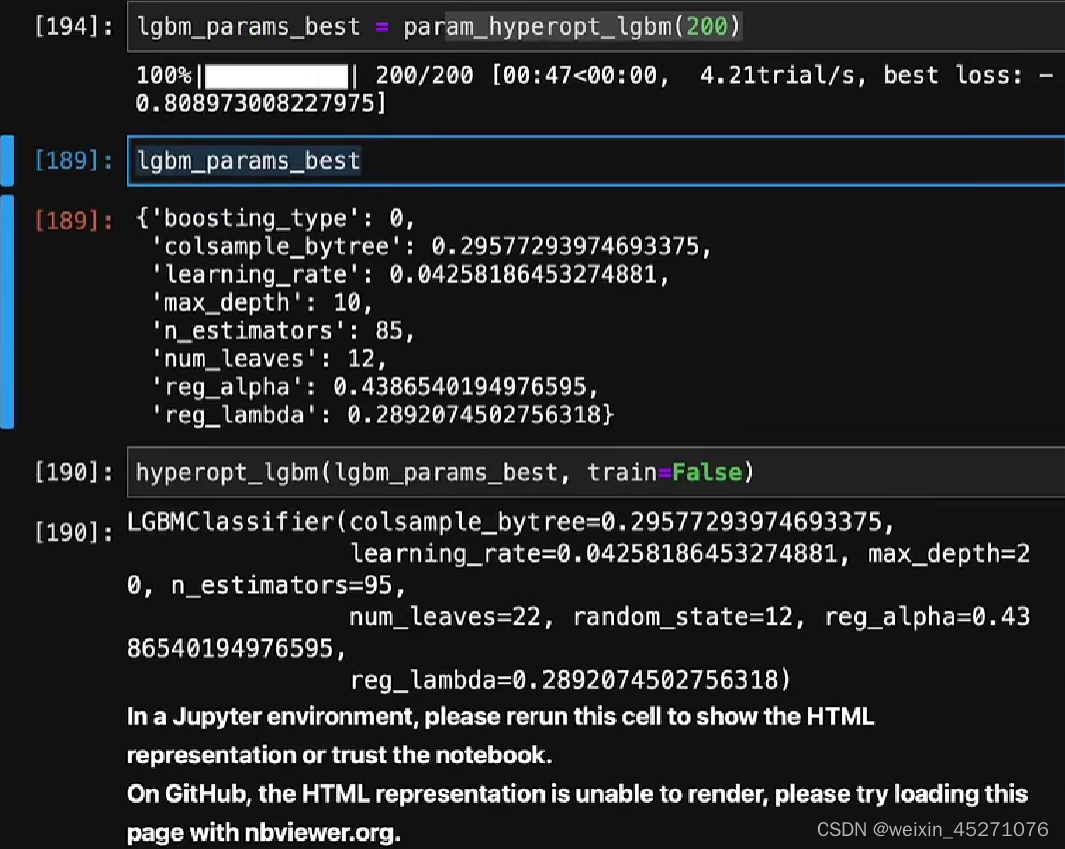

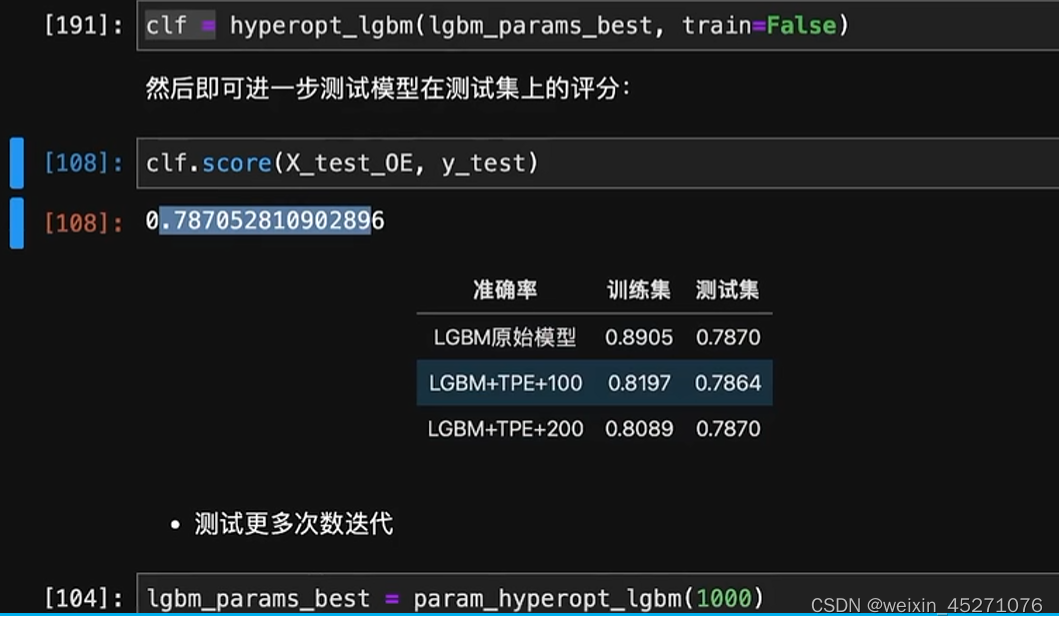

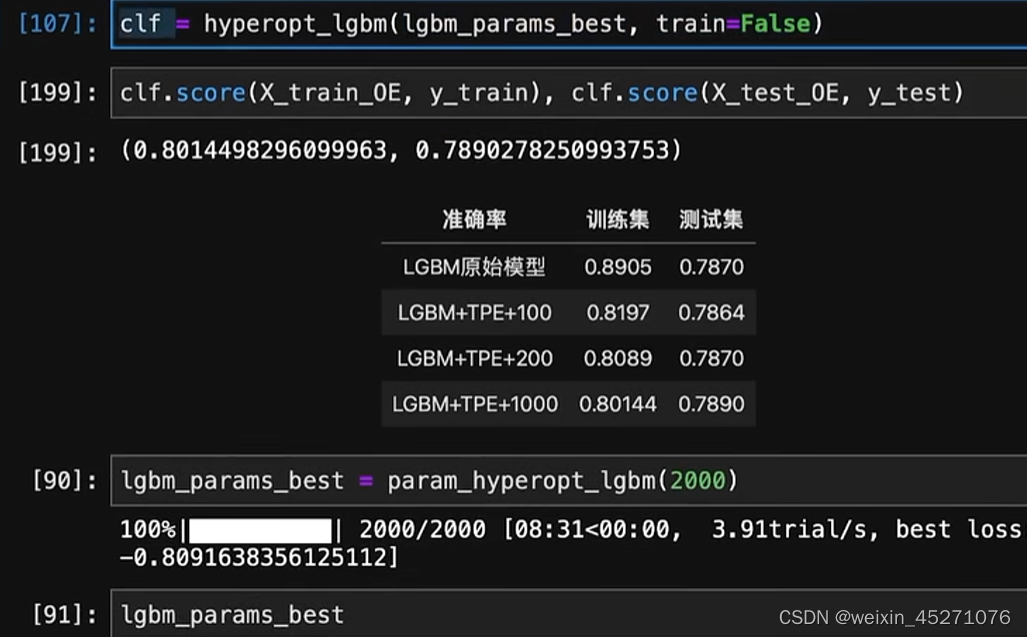

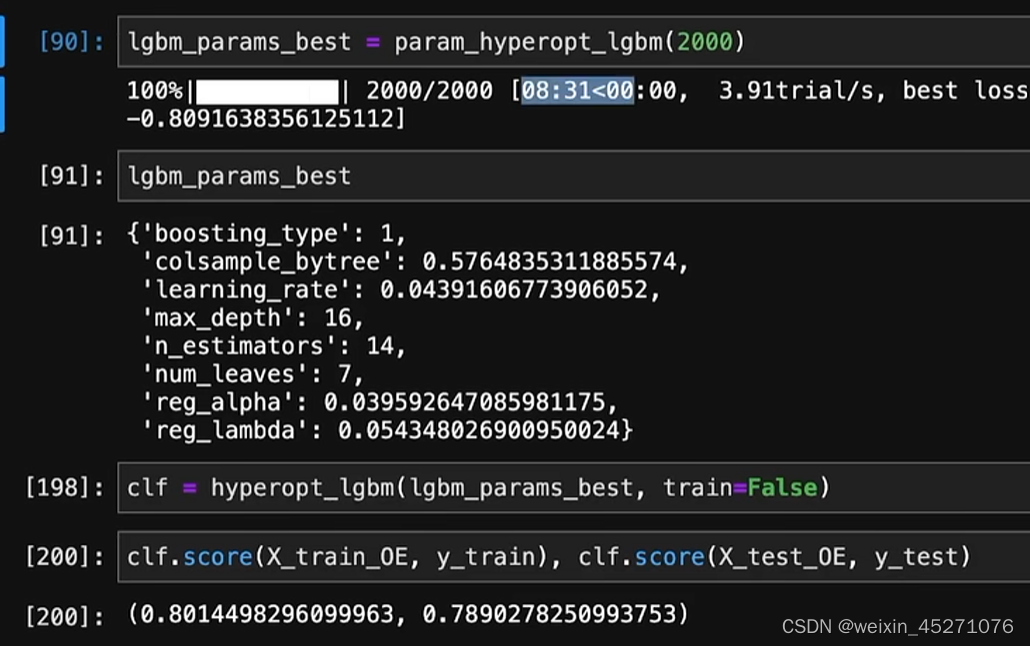

超参数结果不如原始模型,最好是迭代次数的增加

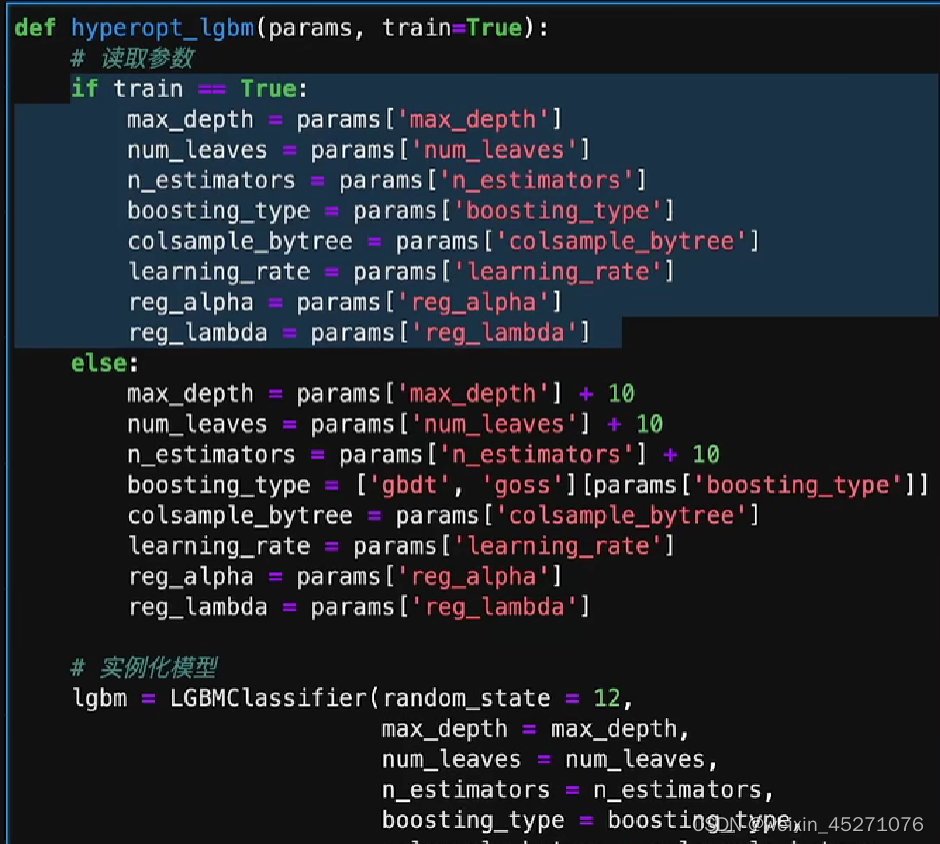

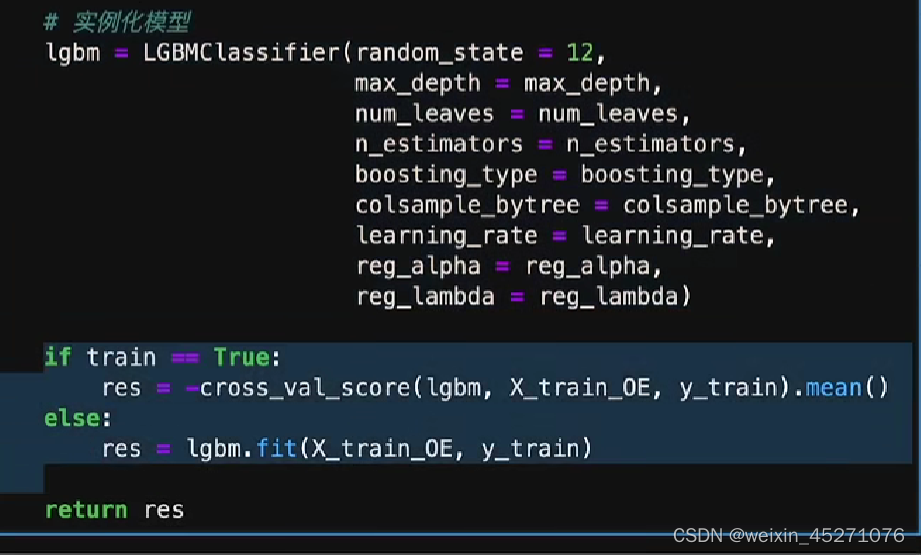

针对上面的升级改造:训练模式和测试模式两套放在一起,根据最优秀的参数来实例化一个模型

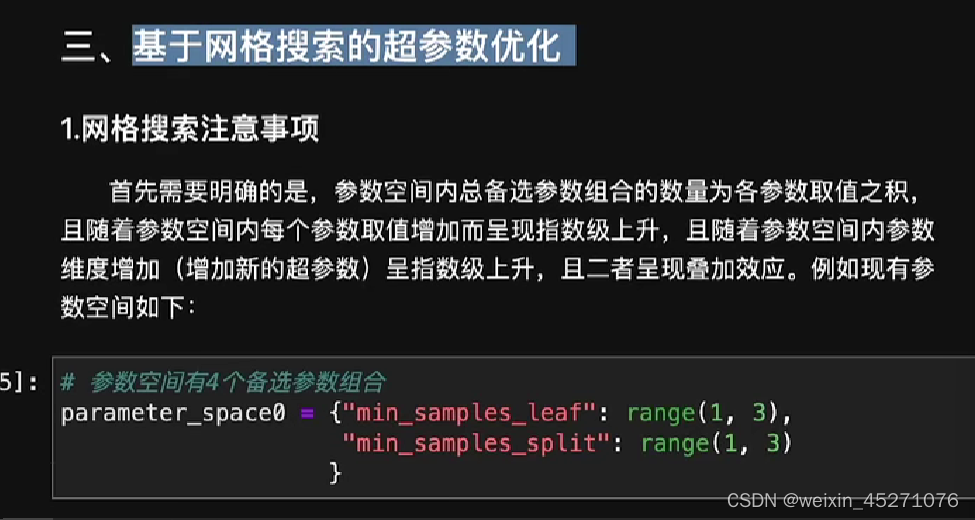

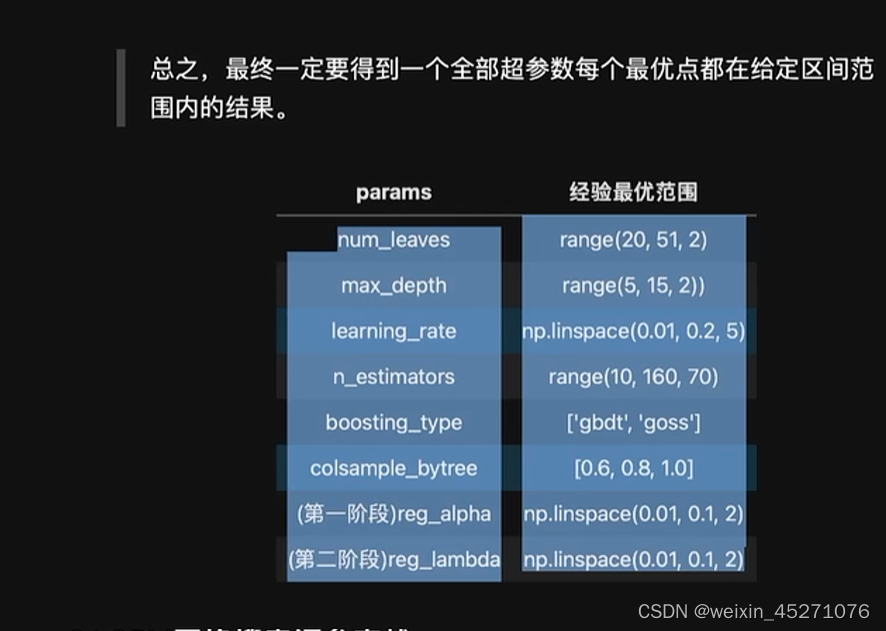

二、基于网格搜索的超参数优化—枚举原理,TPE是根据迭代次数猜的,不会穷尽参数

,需要人工辅助判断

从大区间逐步缩小区间范围

#设置超参数空间

parameter_space={'num_leaves':range(20,51,5),'max_depth':range(5,15,2),'learning_rate':list(np.linspace(0.01,0.2,5)),'n_estimators':range(10,160,70),'boosting_type':['gbdt','goss'],'colsamp_bytree':[0.6,0.8,1.0]

}

#实例化模型与评估器

lgbm_0=LGBMClassifier(random_state=120)

grid_lgbm0=GridSearchCV(lgbm_0,parameter_space)

#模型训练

grid_lgbm0.fit(xtrain263,ytrain263)

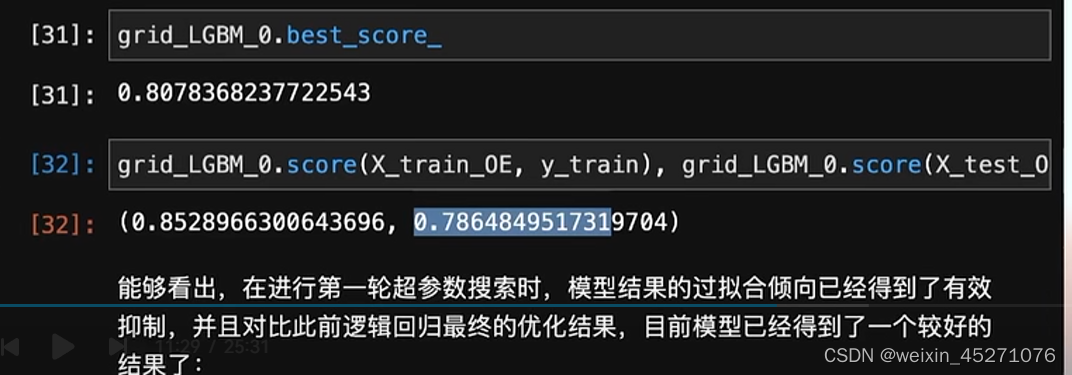

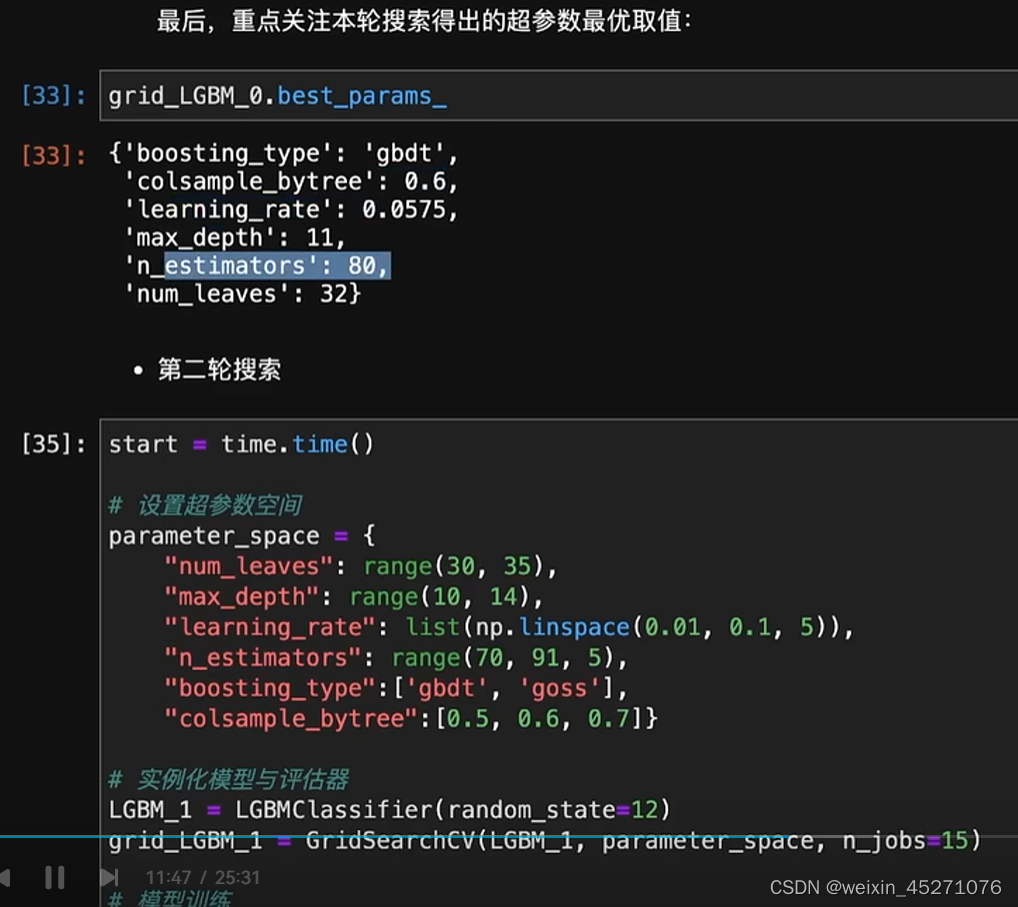

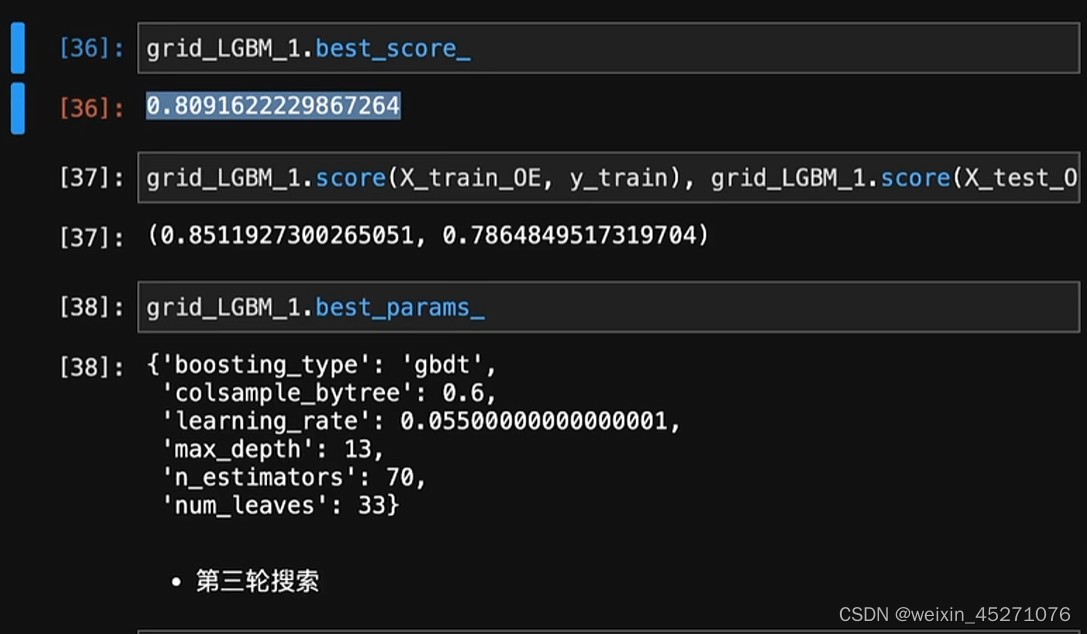

进行多轮探索

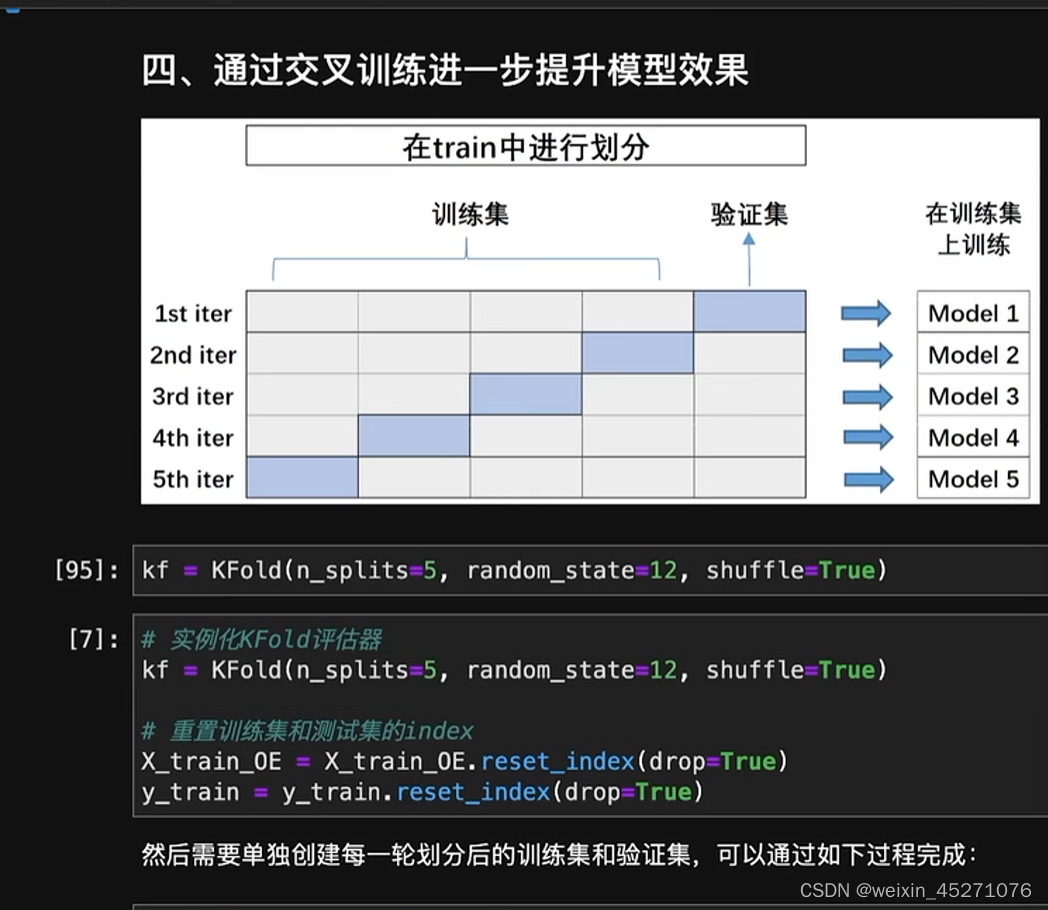

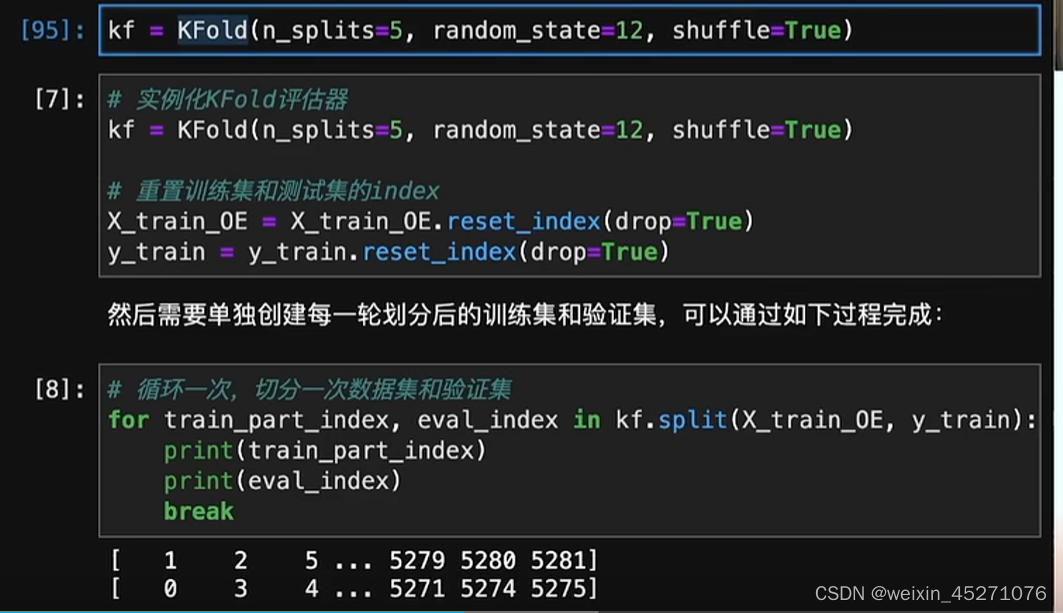

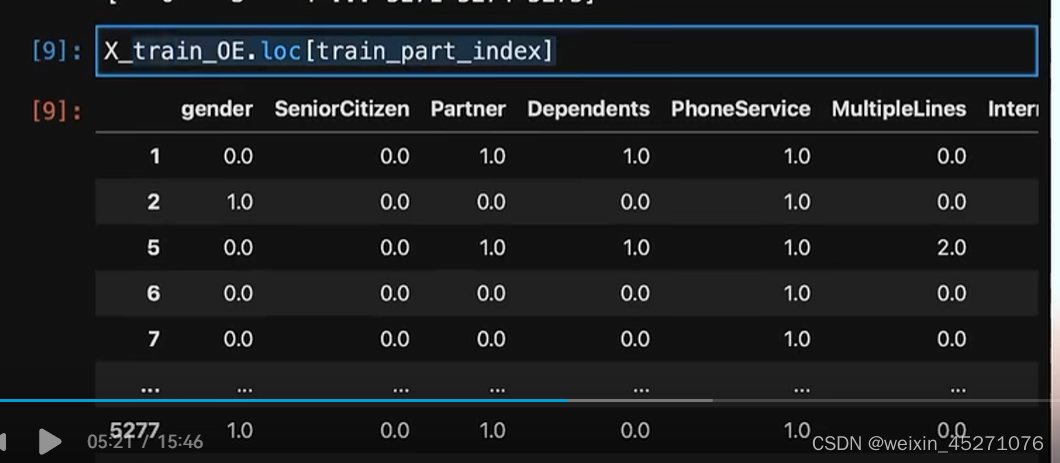

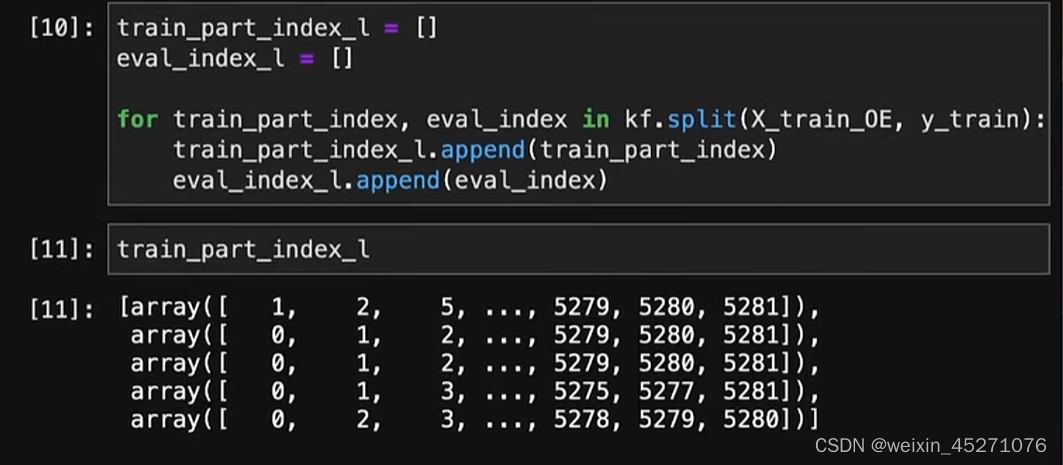

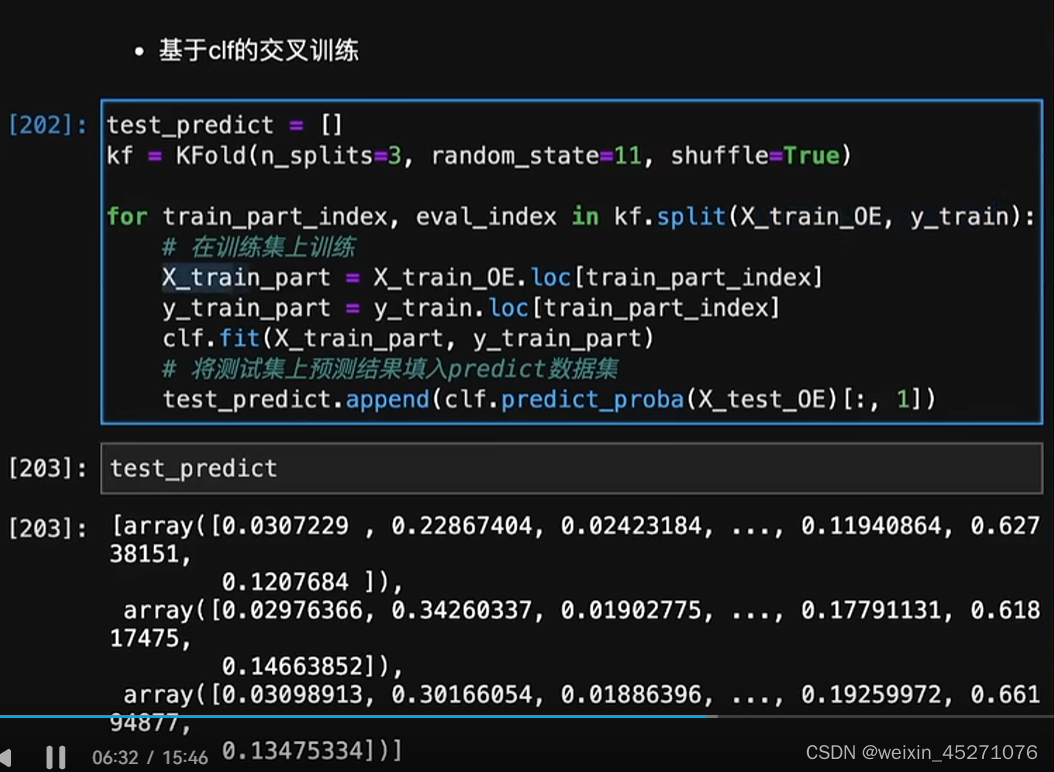

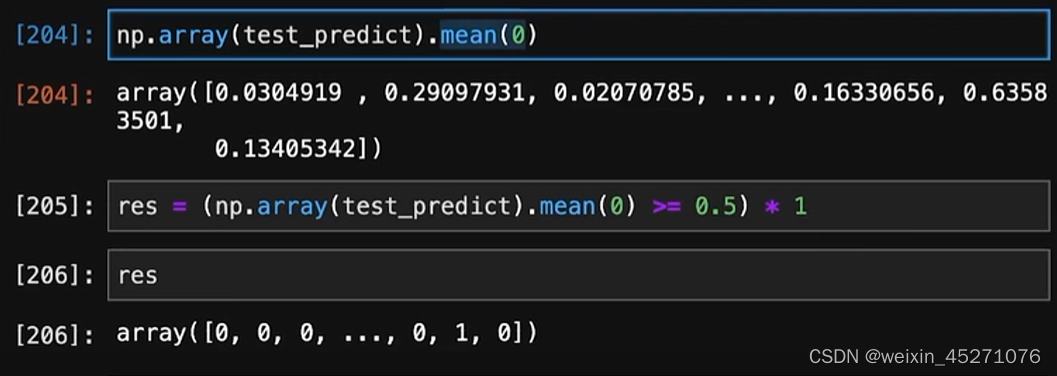

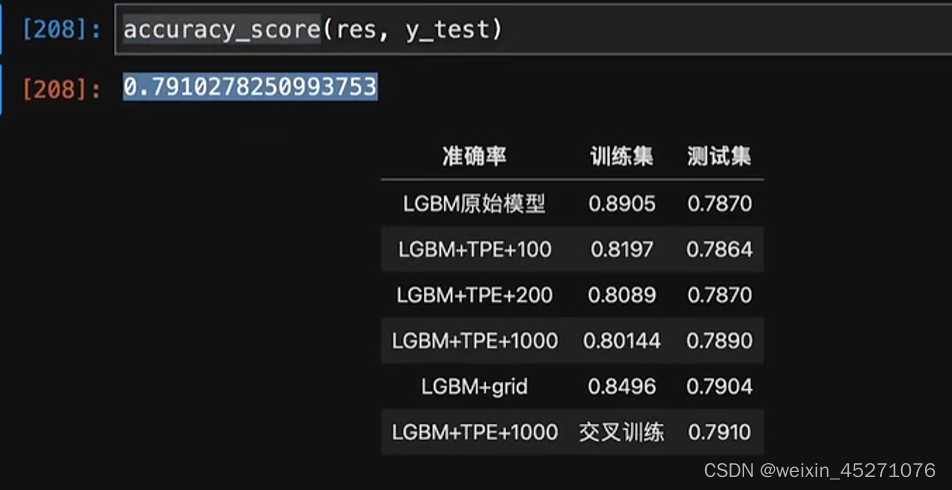

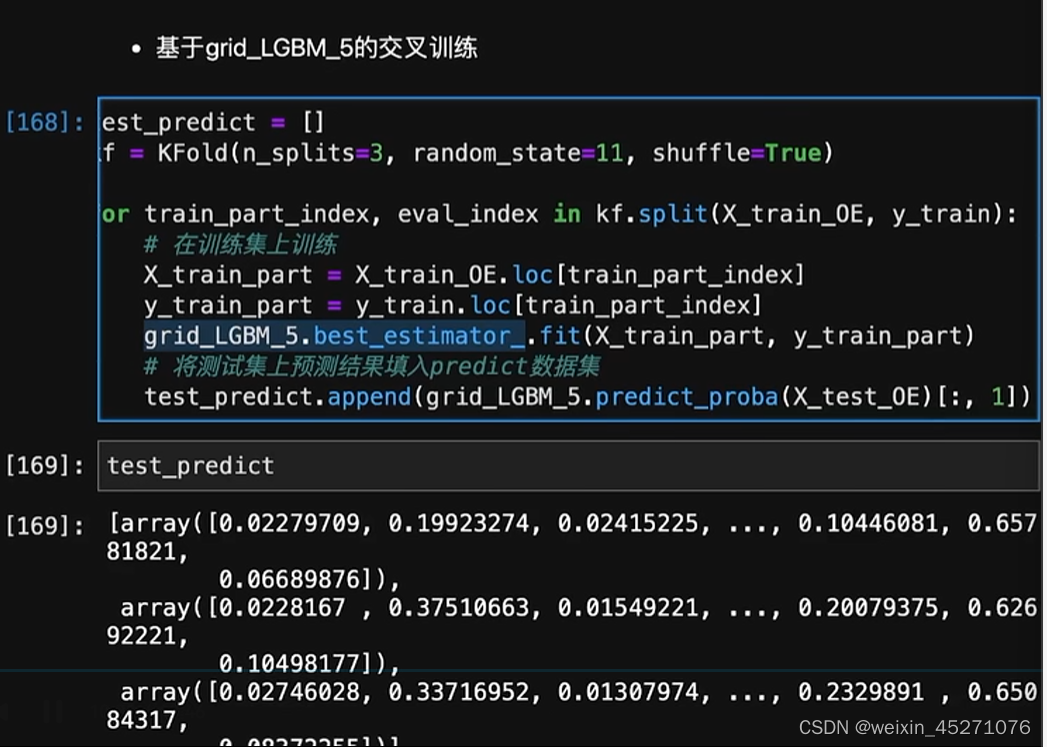

下面使用交叉训练:

超参数调完之后如何有更好的效果,–单独模型的交叉训练-非常有bagging的原理

取5次预测结果的均值作为最终的预测结果

–不一定有效果,但是可以试一下的

这篇关于LightGBM超参数优化-贝叶斯,网格的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!