本文主要是介绍指代消解类方法梳理,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

概念:

MLM:带遮罩的语言模型

NSP:单句预测,任务包括两个输入序列

SBO:分词边界目标

1.spanBERT,2019

spanBERT是对bert从分词到文本跨度的优化,主要有两方面的优化:(1)连续随机文本跨度Span的遮罩和预测;(2)通过文本跨度Span边缘前后的词语来预测Span的含义。

spanBERT是从Token到Span文本片段的优化,可以更好的预测Span并表达Span含义。

(1)span masking

文本跨度遮罩及预测任务Masked Language Modeling,MLM,将词序列中15%进行遮罩。首先确定采样文本跨度Span长度,平均为3.8,在确定遮罩文本长度后,随机选择某个起始位置进行遮罩,保证文本跨度的起始为一个单词的开头且被遮罩的文本跨度是完整的词。

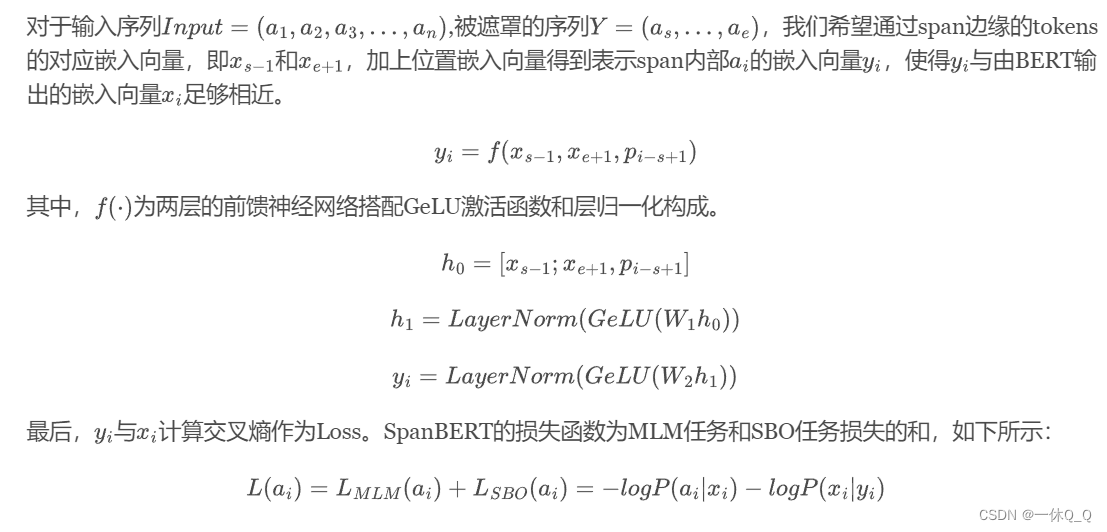

(2)span boundary objective

文本跨度边界预测任务Span-Boundary Objective ,SBO,让文本跨度Span的边缘词学习到文本跨度Span的内部信息。

2.corefBERT,2020

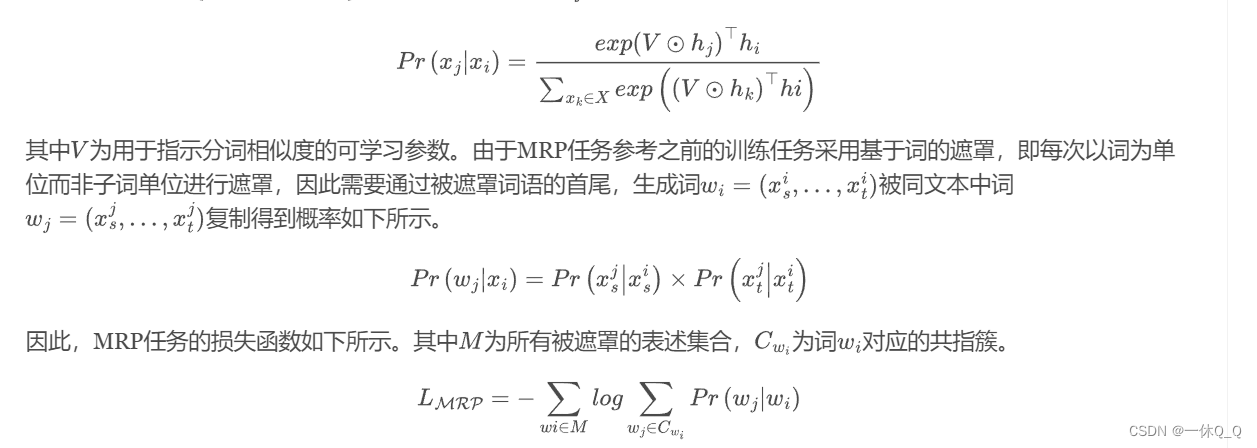

CorefBERT是清华大学团队发表的,继SpanBERT之后另一针对共指消解的BERT模型。提出表述指代预测任务(Mention Reference Prediction, MRP)并搭配原有的遮罩预测任务(Masked Language Modeling, MLM)完成了CorefBERT的训练。

MRP任务的目标是学习到文本中表述共指的信息,在假设文本中重复的名词或者名词短语共指的假设前提下,对文本中重复出现的名词或名词短语作为表述进行遮罩,并试图用上下文信息来对其进行预测。首先使用POS词性分析器将文本中所有的名词进行标注,接着,将完全相同的表述划分至相同的共指簇中。每次选取一个共指簇中的一个表述进行遮罩。对于遮罩表述的预测,作者采用基于复制的目标函数(Copy-based Training Objective),使模型可以正确预测文本中的与遮罩相同的分词部分。对于输入序列,通过多层Transformers可以得到其嵌入向量,分词可以被分词复制得到的概率计算如下所示。

3.cireference resolution without span representations

Kirstain et al., ACL IJCNLP 2021

torch repo Github: https://github.com/yuvalkirstain/s2e-coref

Paper: https://aclanthology.org/2021.acl-short.3.pdf

4.word-level coreference resolution

Vladimir Dobrovolskii, ACL EMNLP 2021

Github: https://github.com/vdobrovolskii/wl-coref

Paper: https://arxiv.org/pdf/2109.04127.pdf

两点好处:1. 减少计算的复杂度,从降低至;2. 原先Mention Dectection候选表述提取阶段会进行剪枝,从而会去除部分正确的Mention使其根本无法进入到共指消解阶段,而从word层面完成指代消解则不会面临这样的问题。

这篇关于指代消解类方法梳理的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!