本文主要是介绍Llama3 端侧部署:算丰 SG2300x 与爱芯元智 AX650N,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

美国当地时间4月18日,Meta 开源了 Llama3 大模型,包括一个 8B 模型和一个 70B 模型在测试基准中,Llama 3 模型的表现相当出色,在实用性和安全性评估中,与那些市面上流行的闭源模型不相上下。

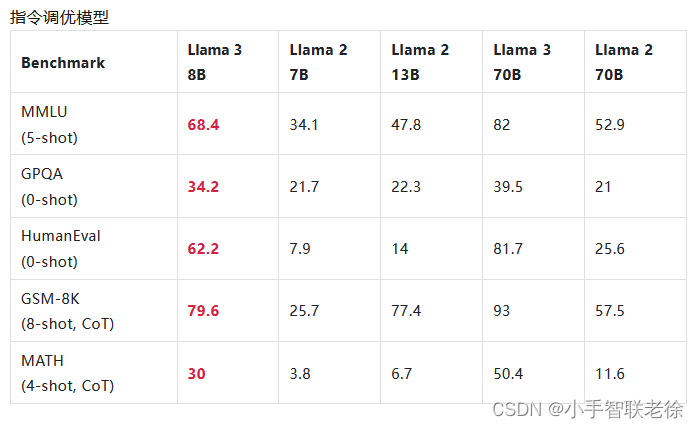

Llama3 性能指标:

相对于 LLama2,Llama3 的性能有了很大的提高:

Meta 表示,Llama 3 在多个关键基准测试中展现出卓越性能,超越了业内先进的同类模型。无论是在代码生成、复杂推理,还是在遵循指令和可视化想法方面,Llama 3 都实现了全面领先。该模型在以下五个基准测试中均表现出色:

-

MMLU(学科知识理解)

-

GPQA(一般问题解答)

-

HumanEval(代码能力)

-

GSM-8K(数学能力)

-

MATH(高难度数学问题)

根据 Meta 的测试结果,Llama 3 8B 模型在 MMLU、GPQA、HumanEval 等多项性能基准上均超过了 Gemma 7B 和 Mistral 7B Instruct,70B 模型则超越了名声在外的闭源模型 Claude 3 的中间版本 Sonnet,和谷歌的 Gemini Pro 1.5 相比三胜两负。

算丰 SG2300x:

4月20日,瑞莎宣称:面对 Llama 3 如此激动人心的性能,Airbox 团队积极响应,快速将 Llama3 8B 移植并成功在 Airbox 上运行。

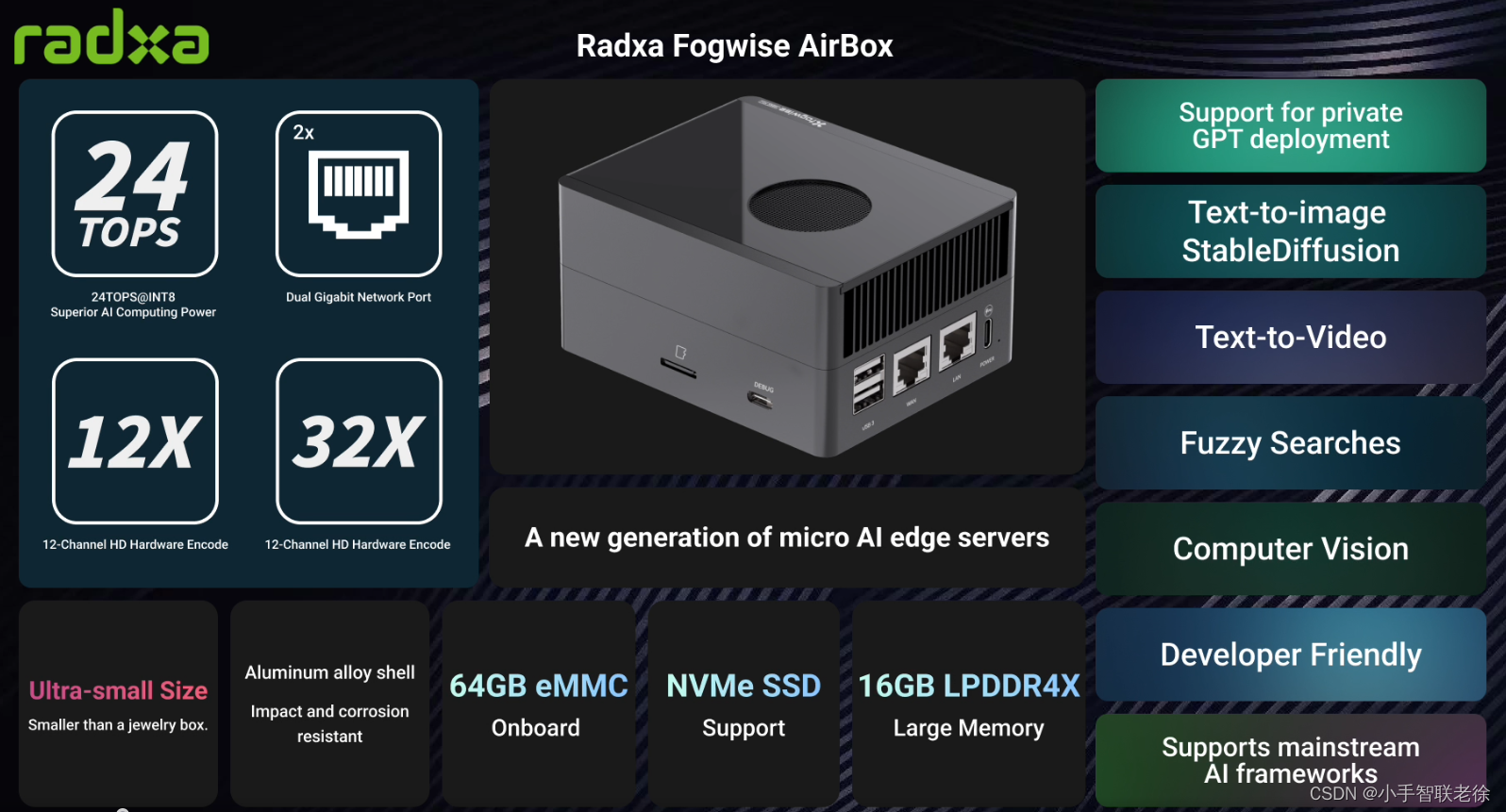

并推出 SOPHON SG2300X SoC 处理器的 Radxa Fogwise AirBox,来作端侧部署:

| Radxa Fogwise AirBox | |

| 形态尺寸 | 104mm x 84mm x 52mm |

| 处理器 | SOPHON SG2300X SoC,八核 Arm® Cortex®-A53(ARMv8)@ 2.3GHz |

| TPU | 张量处理单元,计算能力:最高达24TOPS(INT8),12TFLOPS(FP16/BF16)和2TFLOPS(FP32) 支持领先的深度学习框架,包括 TensorFlow、Caffe、PyTorch、Paddle、ONNX、MXNet、Tengine 和 DarkNet |

| 内存 | 16GB LPDDR4X |

| 存储 | 工业级 64GB eMMC 16MB SPI 闪存 提供高速SD卡的SD卡插槽 |

| 多媒体 | 支持解码32路H.265/H.264 1080p@25fps视频 完全处理32路高清1080P@25fps视频,涉及解码和AI分析 支持编码12路H.265/H.264 1080p@25fps视频 JPEG:1080P@600fps,支持最大32768 x 32768 支持视频后处理,包括图像CSC、调整大小、裁剪、填充、边框、字体、对比度和亮度调整。 |

| 连接 | 2x 千兆以太网端口(RJ45) 1x M.2 M Key(2230/2242)用于NVMe SSD 1x M.2 E Key用于WI-FI/BT |

| 工作温度 | 0°C 到 45°C |

| 外壳 | 耐腐蚀的铝合金外壳 |

| 散热器 | PWM调速风扇与定制散热片 |

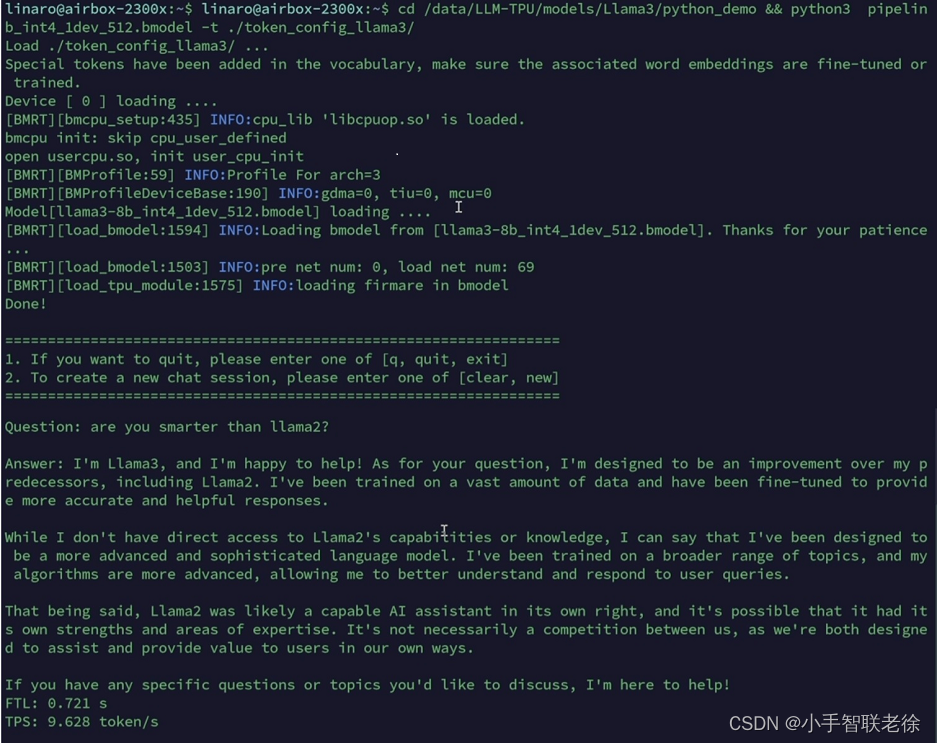

并以视频展示了 Llama3 8B 在 Airbox 上的运行情况:

可以看见,Llama 3 8B 在 Airbox 上的运行表现极为流畅,达到了 9.6 token/s 的处理速度。

爱芯元智 AX650N:

4月28日,AI 芯片公司爱芯元智宣布,公司 NPU 工具链团队已基于 AX650N 平台完成适配 Meta 发布的 Llama 3 8B 和 Microsoft 发布的 Phi-3-mini 模型。另外,爱芯元智已经完成了 Llama 2、TinyLlama、Phi-2、Qwen1.5、ChatGLM3等国内外主流的开源大语言模型适配,推动 AI 大模型技术应用普及。

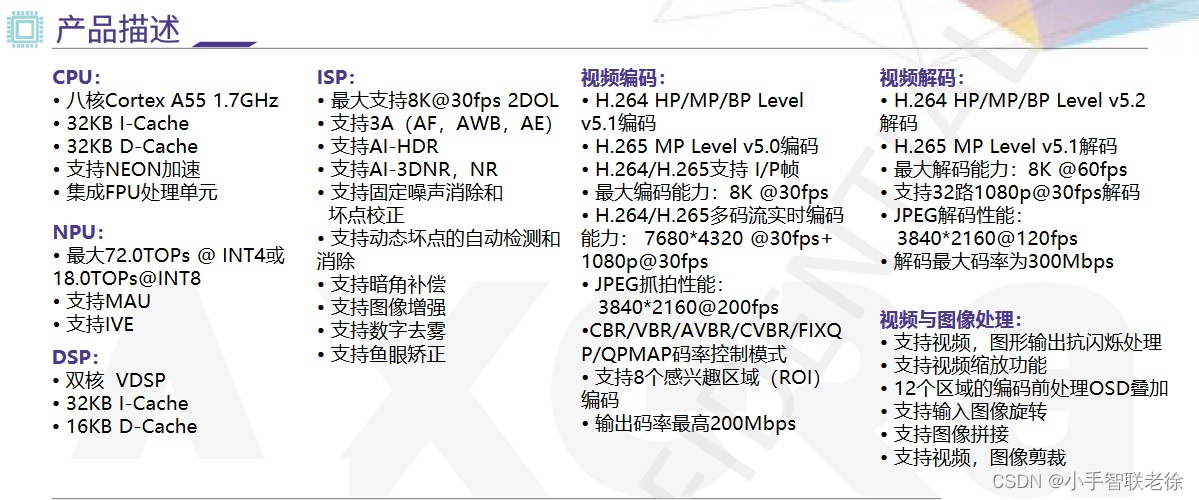

AX650N 是一款兼具高算力、高能效比和超强编解码性的 SoC 芯片,集成了八核 A55 CPU,72.0TOPs@INT4 或 18.0TOPs@INT8 高算力的 NPU,支持 8K 30fps 的 ISP,以及 H.264、H.265 编解码的 VPU。

随后我们估计可以在 AX-LLM 项目里找到相关的代码。

该项目由 爱芯元智 主导开发,用于探索业界常用 LLM(Large Language Model) 在已有芯片平台上落地的可行性和相关能力边界,方便社区开发者进行快速评估和二次开发自己的 LLM 应用。

目前支持:AX650A/AX650N 芯片。已支持模型:TinyLLaMa-1.1B 和 Qwen1.5-1.8B。

小结:

随着国内外大模型的飞速发展,大模型的性能和效果越来越好;国内 AI 芯片的处理能力也已经足够优秀,端侧部署也可以达到良好的体验,想必会有越来越多的硬件厂商陆续跟进。

我们拭目以待。

老徐,2024/4/29

这篇关于Llama3 端侧部署:算丰 SG2300x 与爱芯元智 AX650N的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!