本文主要是介绍大语言模型微调过程中的 RLHF 和 RLAIF 有什么区别?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

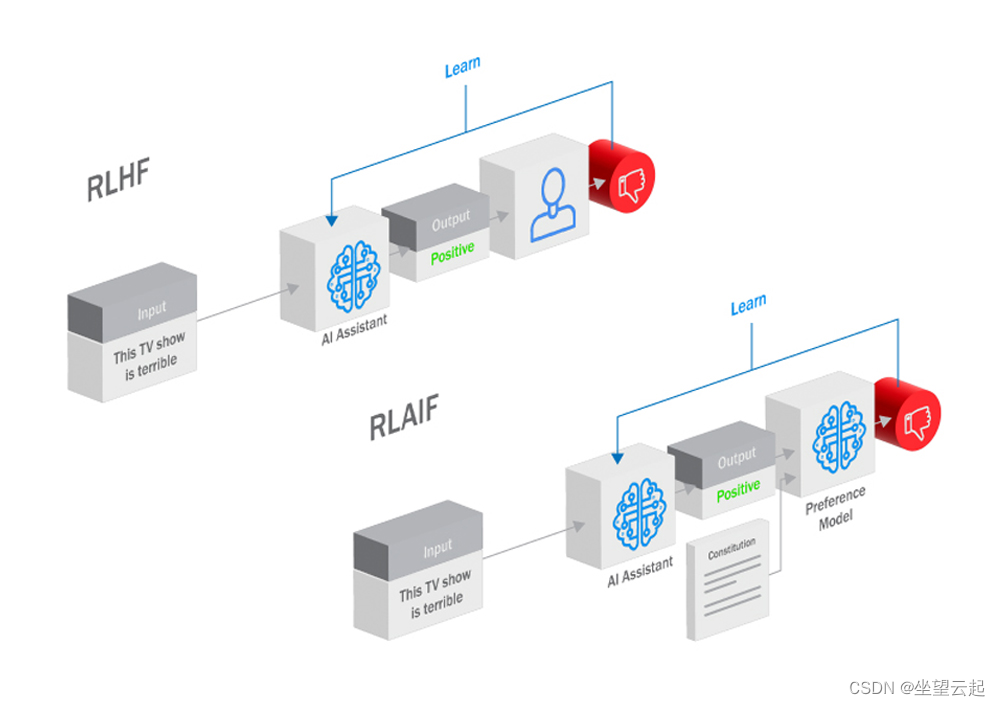

目前想要深入挖掘大型语言模型(LLM)的全部潜力需要模型与我们人类的目标和偏好保持一致。从而出现了两种方法:来自人类反馈的人力强化学习(RLHF)和来自人工智能反馈的人工智能驱动的强化学习(RLAIF)。两者都利用强化学习(RL)中的反馈循环来引导大语言模型接近并实现人类意图,但这两种方法的机制和含义却截然不同。

什么是 RLHF?

RLHF是一个弥合人工智能模型能力与人类愿望之间差距的过程。核心是反馈循环,过程中模型生成输出,人类评估这些输出,反馈给模型,这个迭代不断持续,是的模型的产出越来越符合人类的期望和价值观。 而来自提供专业领域知识的人类的反馈构成了“偏好模型”的支柱。该模型指导人工智能代理的强化学习过程。反馈可以采取多种形式,包括明确的指示、演示或对代理行为的评估反馈。通过奖励符合人类偏好的输出并惩罚那些偏离人类偏好的输出,人工智能代理逐渐学会相应地调整其行为。

RLHF 的主要优势之一是它能够利用人类的直觉和专业知识,特别是在难以定义明确奖励信号的复杂领域。 RLHF 加速了学习过程,使 AI 代理能够做出更明智的决策。

RLHF 允许用户直接影响模型的输出,确保其遵守特定的品牌准则、道德考虑或特定任务的要求。这对于需要高度准确性或敏感性的任务非常重要,例如撰写法律文件或生成医疗建议。人类反馈为模型的决策过程提供了清晰的视野,使其更容易理解和解决潜在的偏见或错误。这对于建立人类对模型的信任并确保负责任地使用它们非常重要。RLHF 在众多应用中取得了成功,比如提高新闻文章的事实准确性,或者是微调客户服务聊天机器人。

但是收集和注释大量人类(特别是专家)的反馈既昂贵又耗时,这一点阻碍了大语言模型项目的开发。另外人类反馈本质上可能是主观的和有偏见的,可能会扭曲模型的学习过程,并在其输出中引入不必要的偏见。RLHF 严重依赖人力专业知识和资源,而这些知识和资源可能并非所有企业都能轻易获得或负担得起,对于个人、小型企业、初创公司是一个难以跨越的天堑。

什么是 RLAIF?

虽然 RLHF 擅长利用人类专业知识,但其对人力资源的依赖存在巨大局限性。人工智能反馈强化学习 (RLAIF) 是一种通过利用另一个人工智能模型的功能来自动化反馈循环的方法。这种“偏好模型”充当人类评估者的代理人,根据对人类偏好和价值观的理解为人工智能代理提供指导。RLAIF 与 RLHF 训练方法非常相似,主要区别在于反馈来自人工智能模型而不是人类评估者。

想象一下您正在训练聊天机器人来回答客户查询的场景。使用 RLHF,您需要人工注释者来评估聊天机器人的响应并提供反馈。然而,RLAIF使您能够训练一个单独的 AI 模型,该模型可以分析客户满意度数据、社交媒体情绪和其他相关信号,以自动评估聊天机器人的性能并提供改进反馈。

RLAIF消除了人类反馈的瓶颈,使其成为大规模LLM开发和培训的理想选择。 通过依靠数据驱动的见解,RLAIF 可以减轻人为偏见,并带来更加客观和公正的输出。自动化反馈循环显着减少了对人力资源的需求,从而节省了模型开发和部署的成本。人工智能偏好模型可以不断学习和发展,适应人类偏好和价值观随时间的变化。

RLAIF 的有效性取决于另一个教练模型的质量以及与所需模型行为的一致性。而选择和培训合适的语言模型教练可能是另一项复杂的任务。另外有效训练人工智能偏好模型需要获得高质量的数据和强大的学习算法。并且人类不是特别容易理解教练模型生成的基于人工智能的反馈的内在逻辑,可能会阻碍调试、甚至导致项目失败。

总结

在 RLHF 和 RLAIF 之间进行选择时,不存在一刀切的解决方案。选择取决于各种因素,例如业务目标、目标受众人口统计、语言要求和预算限制。

如果主要目标是保持所有内容资产的一致性和质量,RLHF 可能是理想的选择。但是,如果您的目标是多元化的全球市场,并且需要使您的内容适应当地语言和文化,RLAIF 可以提供您所需的灵活性和定制功能。

考虑解决方案的可扩展性及其与现有内容管理系统和工作流程的兼容性。 RLHF可能更适合语言要求标准化的大规模内容运营,而RLAIF则在全球整合和多语言支持方面表现出色。

从初始投资、持续维护和资源分配方面评估每个解决方案的成本效益。虽然 RLHF 可能需要在技术和定制方面进行更高的前期投资,但 RLAIF 的即用即付模式和灵活的定价选项可能更适合预算有限的企业。

这篇关于大语言模型微调过程中的 RLHF 和 RLAIF 有什么区别?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!