本文主要是介绍Datawhale-爬虫-Task7(实战大项目),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

实战大项目

模拟登录丁香园,并抓取论坛所有的人员的基本信息与回复帖子的内容。

丁香园论坛:论坛登录链接

- 首先使用Selenium模拟登录丁香园论坛。这里模拟点击登录后若要使用账号密码登录还需要模拟点击返回电脑登录

登录代码如下:

def login_zhihu(browser):try:#点击登录browser.find_element_by_xpath('//div[@class="nav_account"]/a[1]').click()#点击返回电脑登录browser.find_element_by_xpath('//div[@class="login__tab_wp"]/a[2]/i').click()elem = browser.find_element_by_name("username")elem.clear() # 清空elem.send_keys("*******") # 自动填值#获取登录密码elem = browser.find_element_by_name("password")elem.clear()elem.send_keys("****")print("开始登陆...")browser.find_element_by_xpath("//button").click() #点击登录按钮登录except TimeoutException:print("Time Out")except NoSuchElementException:print("No Element")

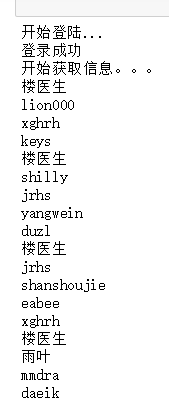

- 获取登陆后的论坛信息,这边我使用CSS选择器爬取相应的信息,很方便,但是爬取后暂时不知道该怎么将论坛发言人和他们的发帖内容对应输出,所以暂时先分开写了

爬取信息代码:

def get_information(browser):print("登录成功")time.sleep(10)print("开始获取信息。。。")elems = browser.find_elements_by_css_selector(".auth") #发帖人姓名

# conts = browser.find_elements_by_css_selector(".con") 发帖的信息for elem in elems:auth = elem.find_element_by_tag_name("a")print(auth.text)

# for con in conts:

# content = con.find_element_by_tag_name("td")

# print(content.text)

- 今天在学习的时候还学到了如何加载动态页面,即使用Selenium让进度条自动下拉到最底部实现JS的加载,代码如下:

def scroll_load(browser):#利用 execute_script() 方法将进度条下拉到最底部browser.execute_script("window.scrollTo(0, document.body.scrollHeight);")browser.implicitly_wait(2) # 隐式等待

作业完整代码:

from selenium import webdriver

import time

from selenium.webdriver.common.keys import Keys

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from selenium.common.exceptions import TimeoutException, NoSuchElementException# 声明浏览器对象

browser = webdriver.Chrome()

browser.get("http://www.dxy.cn/bbs/thread/626626#626626")def login_zhihu(browser):try:#点击登录browser.find_element_by_xpath('//div[@class="nav_account"]/a[1]').click()#点击返回电脑登录browser.find_element_by_xpath('//div[@class="login__tab_wp"]/a[2]/i').click()elem = browser.find_element_by_name("username")elem.clear() # 清空elem.send_keys("*****") # 填入你的账号#获取登录密码elem = browser.find_element_by_name("password")elem.clear()elem.send_keys("********") #填上你的密码print("开始登陆...")browser.find_element_by_xpath("//button").click() #点击登录按钮登录except TimeoutException:print("Time Out")except NoSuchElementException:print("No Element")def get_information(browser):print("登录成功")time.sleep(10)print("开始获取信息。。。")elems = browser.find_elements_by_css_selector(".auth") #发帖人姓名

# conts = browser.find_elements_by_css_selector(".con") 发帖的信息for elem in elems:auth = elem.find_element_by_tag_name("a")print(auth.text)

# for con in conts:

# content = con.find_element_by_tag_name("td")

# print(content.text)# 滚动加载

# def scroll_load(browser):

# #利用 execute_script() 方法将进度条下拉到最底部

# browser.execute_script("window.scrollTo(0, document.body.scrollHeight);")

# browser.implicitly_wait(2) # 隐式等待# 主函数

def main():login_zhihu(browser) # 登录函数#for i in range(2): #定义滚动次数get_information(browser) # 获取标题与链接#scroll_load(browser) # 滚动time.sleep(1) # 休眠# 函数入口调用

if __name__ == '__main__':main()input("按任意键退出-> ")browser.quit()运行结果(发帖人姓名部分):

这篇关于Datawhale-爬虫-Task7(实战大项目)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!