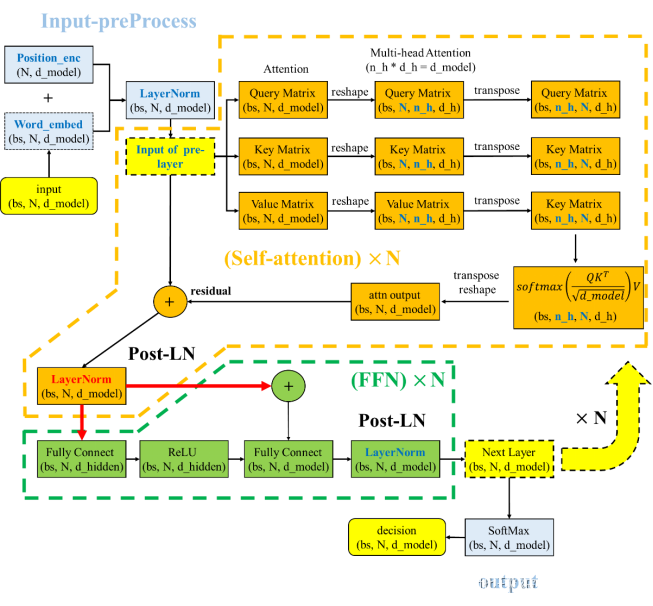

本文主要是介绍Transformer 中的 Pre-LN 与 Post-LN,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文献“On Layer Normalization in the Transformer Architecture”中提出了一种 pre-LN 的层标准化方法,即把 LN 加在残差连接residual之前,Transformer中原始的层标准化为post-LN,即把 LN 在残差连接residual之后,这样能够提升 Transformer 的稳定性。

Post-LN 的方式如下图所示。这也是Transformer的原始方式,Post-LN 是在每个子层的最后输出位置加上层标准化

Pre-LN 的方式如下图所示。Pre-LN 是将每个子层的结束位置的层标准化提前到了该层的开始位置。

这篇关于Transformer 中的 Pre-LN 与 Post-LN的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!