本文主要是介绍马斯克旗下xAI发布Grok-1.5,相比较开源的Grok-1,各项性能大幅提升,接近GPT-4!,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

本文原文来自DataLearnerAI官方网站:马斯克旗下xAI发布Grok-1.5,相比较开源的Grok-1,各项性能大幅提升,接近GPT-4! | 数据学习者官方网站(Datalearner)

继Grok-1开源之后,xAI宣布了Grok-1.5的内测消息,并预告即将全面商用,这一消息无疑为AI技术爱好者和开发者社区带来了新的兴奋点。

Grok-1.5的技术突破

Grok-1.5在性能上的提升是显著的。根据官方发布的数据,Grok-1.5在综合理解能力MMLU评测上达到了81.3分,超越了MistralAI的Mixtral Large模型。在数学推理能力GSM8K的评测中,Grok-1.5更是取得了90分的高分,与业界领先的GPT-4和Claude-3 Sonnet相差无几。

Grok-1.5在DataLearnerAI综合评测排行

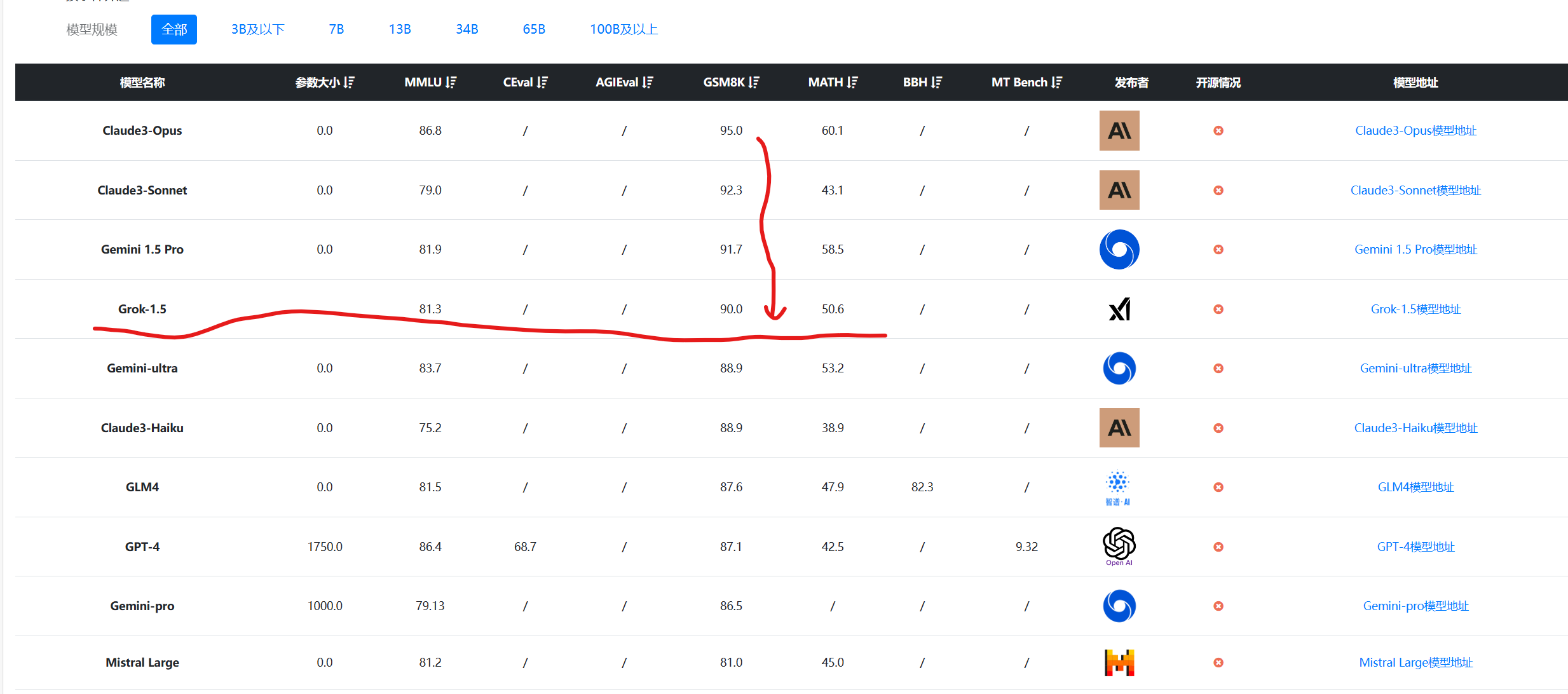

在DataLearnerAI收集的全球大模型综合评测数据上,Grok-1.5表现也非常好。按照GSM8K排序,结果如下:

数据来源:大模型综合评测对比 | 当前主流大模型在各评测数据集上的表现总榜单 | 数据学习 (DataLearner)

可以看到,GSM8K在目前的评测上,Grok-1.5已经是全球第四,最好的模型之一了。其它评测结果也是类似,说明Grok-1.5已经达到了第一梯队。而按照编程能力评测的结果,以Human Eval排序为例,结果如下:

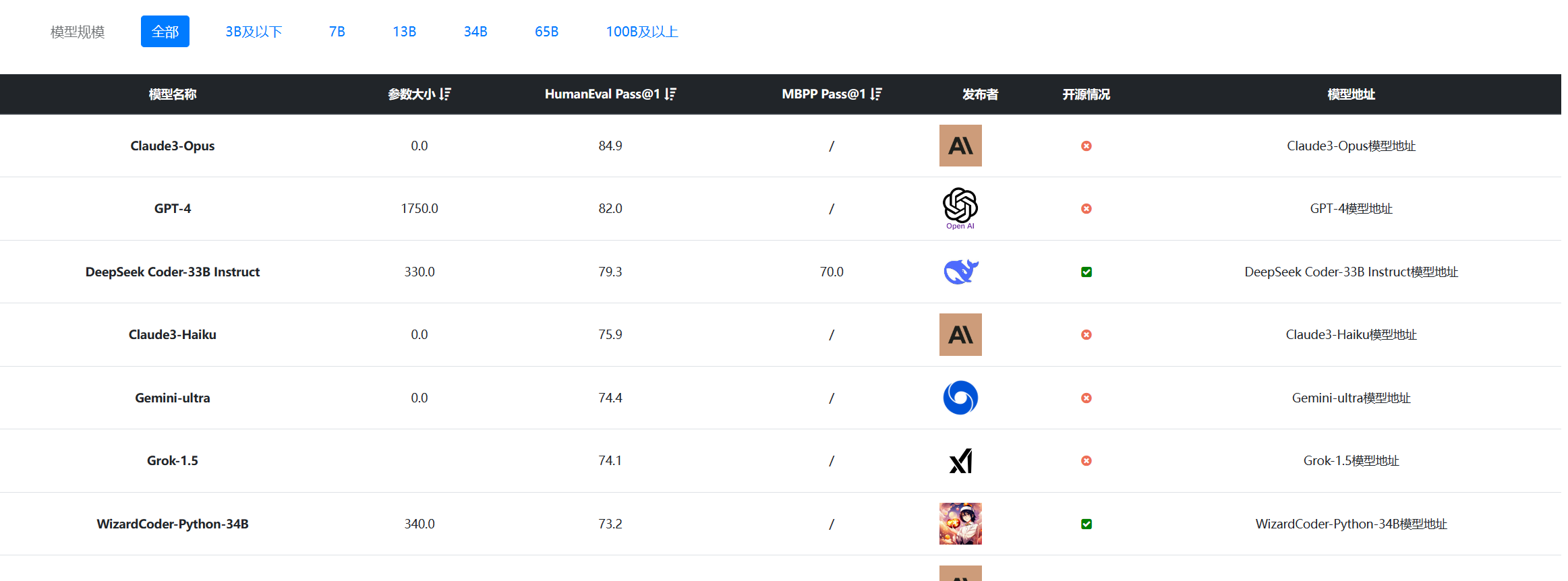

数据来源:大模型代码能力评测对比 | 当前主流大模型在代码能力上的表现总榜单 | 数据学习 (DataLearner)

可以看到,Grok-1.5依然排名很高,作为一个综合基础大模型,这样的成绩非常好。略超Claude3-Sonnet!

支持128K上下文长度

Grok-1.5的另一个亮点是支持最高128K的上下文长度,这是第一代Grok-1的8K上下文长度的显著提升。在大海捞针测试中,Grok-1.5表现出色,这一特性对于处理长文本和复杂对话场景具有重要意义。

关于Grok-1.5的详情参考DataLearnerAI原文:马斯克旗下xAI发布Grok-1.5,相比较开源的Grok-1,各项性能大幅提升,接近GPT-4! | 数据学习者官方网站(Datalearner)

这篇关于马斯克旗下xAI发布Grok-1.5,相比较开源的Grok-1,各项性能大幅提升,接近GPT-4!的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!