本文主要是介绍pickle数据序列化和反序列化,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

pickle

pickle 是 Python 中用于序列化和反序列化对象的标准模块。序列化是指将对象转换为字节流的过程,反序列化是指将字节流转换回对象的过程。pickle 提供了一种在 Python 对象和字节流之间相互转换的方式,可以用于将对象保存到文件或通过网络传输,并在需要时恢复原始对象。以下是 pickle 模块中常用的函数和方法:

pickle.dump(obj, file):将对象序列化并保存到文件中。

import pickle# 假设我们有一个字典对象

data = {'a': [1, 2.0, 3, 4 + 6j],'b': ('string', u'Unicode string'),'c': None}# 打开一个文件用于写入

with open('data.pickle', 'wb') as f:# 将字典对象序列化并保存到文件pickle.dump(data, f)

pickle.dumps(obj):将对象序列化并返回字节流。

import pickle# 假设我们有一个字典对象

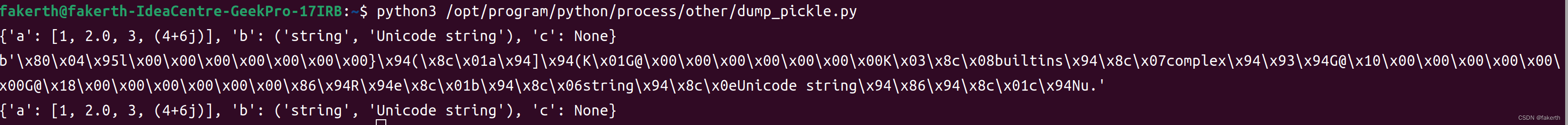

data = {'a': [1, 2.0, 3, 4 + 6j],'b': ('string', u'Unicode string'),'c': None}strr = pickle.dumps(data)

print(strr)

pickle.load(file):从文件中读取字节流并反序列化为对象。

import pickle# 读取

with open('data.pickle', 'rb') as f:# 将字典对象序列化并保存到文件data = pickle.load(f)print(data)

pickle.loads(bytes_obj):将字节流反序列化为对象。

import pickle# 假设我们有一个字典对象

data = {'a': [1, 2.0, 3, 4 + 6j],'b': ('string', u'Unicode string'),'c': None}print(data)strr = pickle.dumps(data)

print(strr)data = pickle.loads(strr)

print(data)

使用 pickle 可以序列化大多数 Python 对象,包括基本数据类型(如整数、浮点数、字符串)、列表、字典、函数、类实例等。但是,pickle 序列化的字节流只能在同一个 Python 版本之间兼容,不同版本之间的兼容性较差。

pickle的应用总结

本地序列化的情况,应用较少。一般来说,大多数应用场景在网络中,将数据序列化后通过网络传输到远程结点,远程服务器上的服务接受到数据后进行反序列化,就可以使用了。但是,需要注意的是,远端接受端反序列化时必须有对应的数据类型,否则就会报错,尤其是自定义类,必须远程存在。目前,大多数项目都不是单机,不是单服务,需要通过网络将数据传送到其他结点上,这就需要大量的序列化,反序列化。但是python程序之间还可以使用pickle解决序列化和反序列化。如果是跨平台,跨语言,跨协议,pickle就不适合了,就需要公共协议,如XML/Json /protocol Buffer等。每种协议都有自己的负载,其所使用的场景都不一样,二进制的操作不一定适用于所有的场景。但越是底层的协议,越需要二进制传输。

优点:

简单易用:pickle 提供了简单的接口来序列化和反序列化 Python 对象,使用起来非常方便。

支持大多数 Python 对象:pickle 能够序列化绝大部分的 Python 数据类型,包括基本数据类型、容器类型、函数、类实例等。

保持对象间关系:当序列化一个包含多个对象引用的复杂对象时,pickle 能够保持对象间的关系,反序列化后的对象依然能够保持原有的结构。

可扩展性:pickle 提供了一些高级选项,允许用户自定义序列化和反序列化的行为,以满足特定需求。

缺点:

版本兼容性:pickle 生成的序列化数据依赖于 Python 版本,并且不同版本之间的兼容性较差。这意味着,使用不同版本的 Python 解释器可能会导致反序列化失败。

不适用于跨语言:pickle 生成的序列化数据是 Python 特定的,不适用于跨语言的数据交换。如果需要与其他语言交互,应选择其他序列化格式,如 JSON、XML 等。

安全性:由于 pickle 可能会执行反序列化过程中包含的代码,因此在使用不可信源序列化的数据时存在安全风险。反序列化不信任的数据可能会导致代码执行漏洞。

性能:与一些其他序列化格式相比,pickle 的性能可能不够高效。在需要高性能的场景下,可能需要选择其他序列化方式。

获取lustre文件系统OSS的brw_stats参数

import datetime

import json

import requestsdef writef(response, current_time):formatted_json = json.dumps(response.json(), indent=4)json1 = json.loads(formatted_json)results = json1["data"]["result"]volumes = ['thfs3-OST0000', 'thfs3-OST0001', 'thfs3-OST0002', 'thfs3-OST0003', 'thfs3-OST0004', 'thfs3-OST0005','thfs3-OST0006', 'thfs3-OST0007', 'thfs3-OST0008', 'thfs3-OST0009', 'thfs3-OST000a', 'thfs3-OST000b','thfs3-OST000c', 'thfs3-OST000d', 'thfs3-OST000e', 'thfs3-OST000f', 'thfs3-OST0010', 'thfs3-OST0011','thfs3-OST0012', 'thfs3-OST0013', 'thfs3-OST0014', 'thfs3-OST0015', 'thfs3-OST0016', 'thfs3-OST0017','thfs3-OST0018', 'thfs3-OST0019', 'thfs3-OST001a', 'thfs3-OST001b', 'thfs3-OST001c', 'thfs3-OST001d','thfs3-OST001e', 'thfs3-OST001f', 'thfs3-OST0020', 'thfs3-OST0021', 'thfs3-OST0022', 'thfs3-OST0023','thfs3-OST0024', 'thfs3-OST0025', 'thfs3-OST0026', 'thfs3-OST0027', 'thfs3-OST0028', 'thfs3-OST0029','thfs3-OST002a', 'thfs3-OST002b', 'thfs3-OST002c', 'thfs3-OST002d', 'thfs3-OST002e', 'thfs3-OST002f','thfs3-OST0030', 'thfs3-OST0031', 'thfs3-OST0032', 'thfs3-OST0033', 'thfs3-OST0034', 'thfs3-OST0035','thfs3-OST0036', 'thfs3-OST0037', 'thfs3-OST0038', 'thfs3-OST0039', 'thfs3-OST003a', 'thfs3-OST003b','thfs3-OST003c', 'thfs3-OST003d', 'thfs3-OST003e', 'thfs3-OST003f', 'thfs3-OST0040', 'thfs3-OST0041','thfs3-OST0042', 'thfs3-OST0043', 'thfs3-OST0044', 'thfs3-OST0045', 'thfs3-OST0046', 'thfs3-OST0047','thfs3-OST0048', 'thfs3-OST0049', 'thfs3-OST004a', 'thfs3-OST004b', 'thfs3-OST004c', 'thfs3-OST004d','thfs3-OST004e', 'thfs3-OST004f', 'thfs3-OST0050', 'thfs3-OST0051', 'thfs3-OST0052', 'thfs3-OST0053','thfs3-OST0054', 'thfs3-OST0055', 'thfs3-OST0056', 'thfs3-OST0057', 'thfs3-OST0058', 'thfs3-OST0059','thfs3-OST005a', 'thfs3-OST005b', 'thfs3-OST005c', 'thfs3-OST005d', 'thfs3-OST005e', 'thfs3-OST005f','thfs3-OST0060', 'thfs3-OST0061', 'thfs3-OST0062', 'thfs3-OST0063', 'thfs3-OST0064', 'thfs3-OST0065','thfs3-OST0066', 'thfs3-OST0067', 'thfs3-OST0068', 'thfs3-OST0069', 'thfs3-OST006a', 'thfs3-OST006b','thfs3-OST006c', 'thfs3-OST006d', 'thfs3-OST006e', 'thfs3-OST006f', 'thfs3-OST0070', 'thfs3-OST0071','thfs3-OST0072', 'thfs3-OST0073', 'thfs3-OST0074', 'thfs3-OST0075', 'thfs3-OST0076', 'thfs3-OST0077']for volume in volumes:read_time = "read I/O time (1/1000s):"write_time = "write I/O time (1/1000s):"read_disk_size = "read disk I/O size:"write_disk_size = "write disk I/O size:"read_pages_per_bulk = "read pages per bulk r/w:"write_pages_per_bulk = "write pages per bulk r/w:"read_in_flight = "read disk I/Os in flight:"write_in_flight = "write disk I/Os in flight:"read_discontiguous_pages = "read discontiguous pages:"write_discontiguous_pages = "write discontiguous pages:"for result in results:if result["metric"]["volume"] == volume and result["metric"]["mode"] == "read":if result["metric"]["name"] == "I/O time (1/1000s)" and result["metric"]["metric"] == "ios":read_time = read_time + result["value"][1] + "\t"if result["metric"]["name"] == "disk I/O size" and result["metric"]["metric"] == "ios":read_disk_size = read_disk_size + result["value"][1] + "\t"if result["metric"]["name"] == "pages per bulk r/w" and result["metric"]["metric"] == "rpcs":read_pages_per_bulk = read_pages_per_bulk + result["value"][1] + "\t"if result["metric"]["name"] == "disk I/Os in flight" and result["metric"]["metric"] == "ios":read_in_flight = read_in_flight + result["value"][1] + "\t"if result["metric"]["name"] == "discontiguous pages" and result["metric"]["metric"] == "rpcs":read_discontiguous_pages = read_discontiguous_pages + result["value"][1] + "\t"if result["metric"]["volume"] == volume and result["metric"]["mode"] == "write":if result["metric"]["name"] == "I/O time (1/1000s)" and result["metric"]["metric"] == "ios":write_time = write_time + result["value"][1] + "\t"if result["metric"]["name"] == "disk I/O size" and result["metric"]["metric"] == "ios":write_disk_size = write_disk_size + result["value"][1] + "\t"if result["metric"]["name"] == "pages per bulk r/w" and result["metric"]["metric"] == "rpcs":write_pages_per_bulk = write_pages_per_bulk + result["value"][1] + "\t"if result["metric"]["name"] == "disk I/Os in flight" and result["metric"]["metric"] == "ios":write_in_flight = write_in_flight + result["value"][1] + "\t"if result["metric"]["name"] == "discontiguous pages" and result["metric"]["metric"] == "rpcs":write_discontiguous_pages = write_discontiguous_pages + result["value"][1] + "\t"file = open("/thfs3/home/brw_stats/" + volume, "a")file.write(current_time + "\n")file.write(read_time + "\n" + read_disk_size + "\n" + read_pages_per_bulk + "\n" + read_in_flight + "\n" + read_discontiguous_pages + "\n")file.write(write_time + "\n" + write_disk_size + "\n" + write_pages_per_bulk + "\n" + write_in_flight + "\n" + write_discontiguous_pages + "\n")file.close()if __name__ == '__main__':url = "http://xxxxxxxxxx:9090/api/v1/query"params = {"query": "lustre2_ost_brw_stats","dedup": "true","partial_response": "false",}try:current_time = datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S")response = requests.get(url, params=params, timeout=15)writef(response, current_time)except requests.Timeout:# 超时处理print("请求超时")except requests.RequestException as e:# 其他请求异常处理print("请求异常:", str(e))这篇关于pickle数据序列化和反序列化的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!